Автор: Денис Аветисян

В статье представлена концепция Adversarial Flow Models — инновационный подход к генерации данных, объединяющий преимущества состязательного обучения и потоковых моделей.

Adversarial Flow Models объединяют методы состязательного обучения и потокового моделирования для достижения стабильности обучения и высокого качества генерации изображений.

Несмотря на успехи генеративных состязательных сетей (GAN) и моделей потоков, достижение стабильного обучения и высокой эффективности генерации изображений остается сложной задачей. В данной работе представлена концепция ‘Adversarial Flow Models’, нового класса генеративных моделей, объединяющего преимущества состязательного и потокового подходов. Предложенная архитектура обеспечивает стабильное обучение и превосходит существующие методы по качеству генерируемых изображений, достигая нового значения FID — 2.38 на ImageNet-256px. Сможет ли данная парадигма стать основой для следующего поколения генеративных моделей, способных к еще более реалистичной и контролируемой генерации контента?

Вызовы стабильного генеративного моделирования

Генеративные состязательные сети (GAN) демонстрируют впечатляющую способность к синтезу данных, позволяя создавать реалистичные изображения, текст и другие типы контента. Однако, несмотря на свой потенциал, обучение GAN часто сопряжено со значительными трудностями, обусловленными их нестабильностью. Эта нестабильность проявляется в колебаниях процесса обучения, приводящих к непредсказуемым результатам и требующих тонкой настройки гиперпараметров. Суть проблемы заключается в состязательном характере обучения, где генератор и дискриминатор постоянно «борются» друг с другом, что может привести к расхождению процесса обучения и невозможности достижения стабильного равновесия. Из-за этого, даже при наличии достаточных вычислительных ресурсов и данных, получение качественных и разнообразных результатов с использованием GAN часто требует значительных усилий и экспериментов.

Стабилизация обучения генеративных моделей, таких как GAN, часто требует применения сложных техник, например, GradientPenalty, которые направлены на ограничение возможностей Дискриминатора. Данный подход, хотя и позволяет добиться некоторой устойчивости процесса, существенно ограничивает масштабируемость и гибкость модели. Ограничение Дискриминатора снижает его способность эффективно различать реальные и сгенерированные данные, что негативно сказывается на качестве получаемых образцов и усложняет адаптацию модели к новым задачам. В результате, разработчики сталкиваются с необходимостью компромисса между стабильностью обучения и способностью модели к обобщению и масштабированию, что создает значительные трудности в практическом применении генеративных моделей.

В процессе обучения генеративных состязательных сетей (GAN) часто возникает внутренняя борьба между генератором и дискриминатором, что может привести к ряду нежелательных последствий. Одной из ключевых проблем является «коллапс моды» — ситуация, когда генератор начинает производить лишь ограниченный набор образцов, игнорируя разнообразие исходных данных. Параллельно с этим, дискриминатор, становясь слишком эффективным, может приводить к исчезающим градиентам, затрудняя обучение генератора и препятствуя улучшению качества генерируемых данных. В результате, модель теряет способность создавать разнообразные и реалистичные образцы, ограничивая её практическую ценность и требуя разработки более устойчивых методов обучения, способных смягчить эту внутреннюю конкуренцию и обеспечить стабильный процесс генерации.

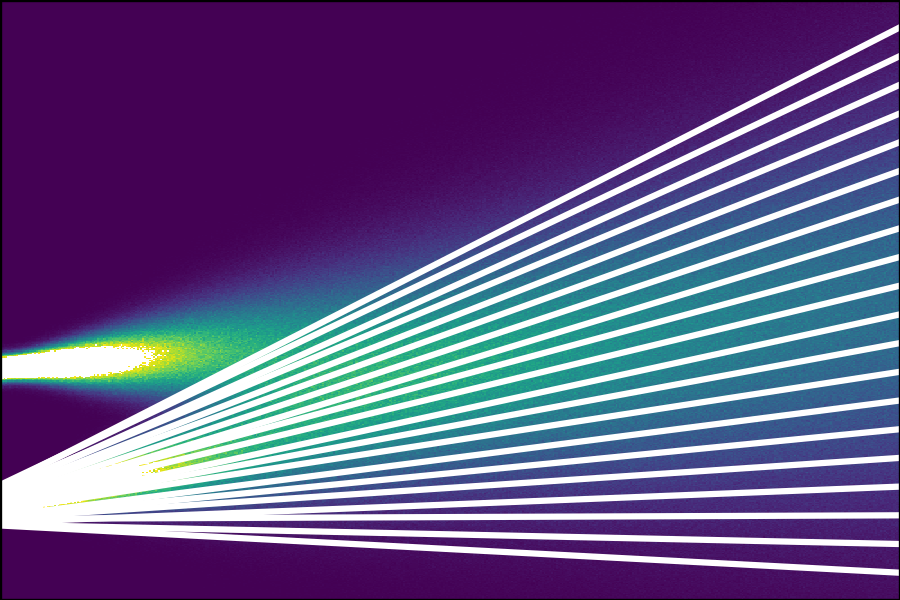

Детерминированный транспорт: Flow Matching и за его пределами

Метод Flow Matching представляет собой принципиально новый подход к генерации данных, формулируя задачу как проблему переноса (транспорта). Вместо традиционных генеративных моделей, Flow Matching рассматривает процесс создания данных как отображение образцов из априорного распределения ($p(x_0)$) на распределение данных ($p(x)$) посредством обучения градиентам. Это достигается путем определения векторного поля, которое направляет точки из простого априорного распределения (например, гауссовского шума) к сложной целевой плотности данных. Фактически, генерация сводится к решению задачи оптимального транспорта, где целью является нахождение наиболее эффективного способа «переноса» вероятности из априорного распределения в целевое.

Метод Flow Matching использует принципы оптимального транспорта для определения гладкой и стабильной целевой функции обучения. В отличие от генеративных состязательных сетей (GAN), где обучение происходит посредством конкуренции между генератором и дискриминатором, Flow Matching избегает этого “состязательного” процесса. Вместо этого, он формулирует задачу генерации как задачу транспортного отображения, минимизируя расстояние между распределением априорных данных и целевым распределением. Это достигается путем определения функции потерь, основанной на метриках оптимального транспорта, таких как расстояние Вассерштейна ($W_1$), что обеспечивает более стабильное и предсказуемое обучение без характерных для GAN проблем, таких как коллапс моды и нестабильность градиентов.

В основе Flow Matching лежит концепция Probability Flow, обеспечивающая непрерывное преобразование распределения вероятностей данных. В отличие от дискретных шагов диффузионных моделей, Probability Flow позволяет описывать процесс генерации как непрерывный поток, определяемый векторным полем. Это достигается путем определения скорости изменения распределения вероятностей во времени, что позволяет точно контролировать траекторию перехода от априорного распределения к целевому распределению данных. Непрерывность преобразования, обеспечиваемая Probability Flow, способствует повышению стабильности обучения и предсказуемости процесса генерации, снижая вероятность появления нежелательных артефактов или отклонений в сгенерированных образцах. Математически, это выражается через решение $ \frac{\partial p(x,t)}{\partial t} = — \nabla_x \cdot (p(x,t)v(x,t))$, где $v(x,t)$ — векторное поле, определяющее поток.

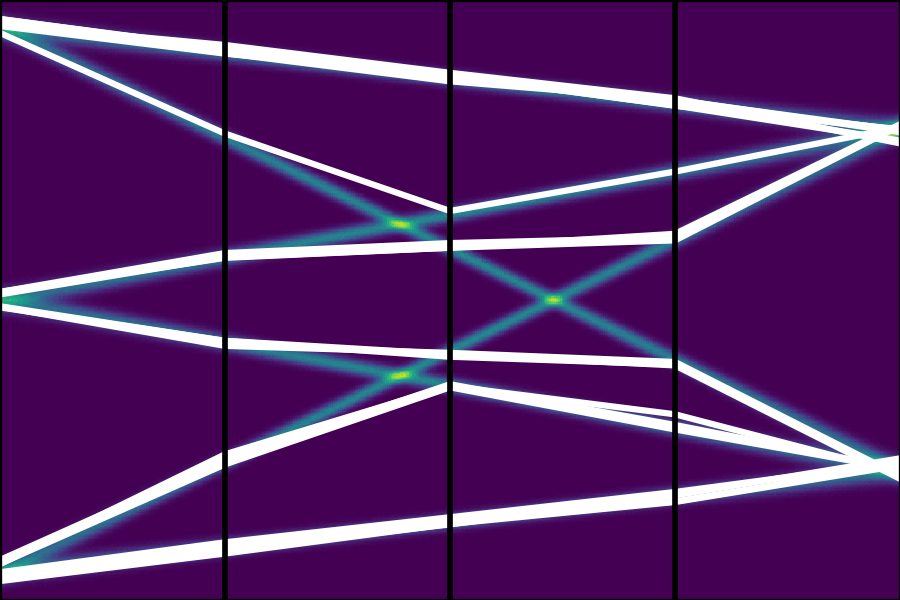

Состязательные потоковые модели: Унифицированный подход

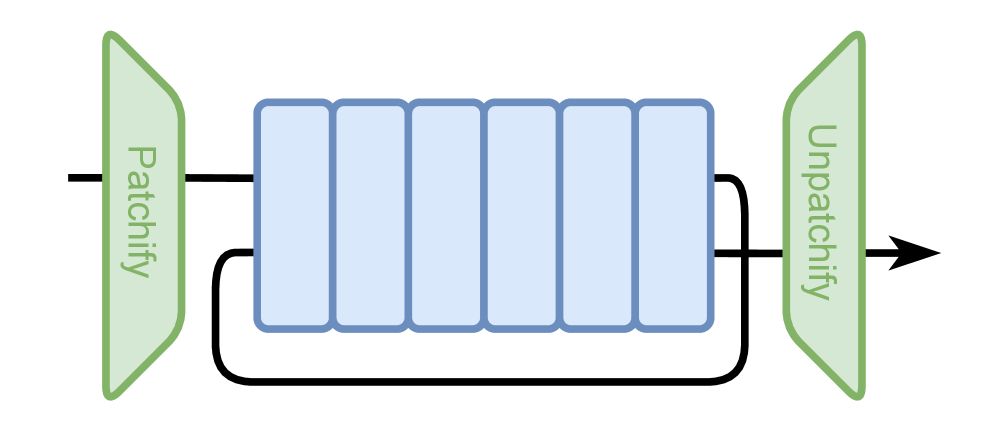

Адверсарные потоковые модели представляют собой унифицированный подход к генеративному моделированию, объединяя преимущества адверсарных генеративных сетей (GAN) и потоковых моделей. Данная архитектура позволяет осуществлять генерацию данных как в одношаговом режиме, характерном для GAN, так и в многошаговом, свойственном потоковым моделям. Это достигается за счет интеграции дискриминатора и генератора в детерминированный транспортный фреймворк, обеспечивая гибкость и возможность адаптации к различным задачам генерации данных. Использование данной модели позволяет объединить стабильность обучения, присущую потоковым моделям, с возможностью генерации высококачественных и разнообразных образцов, характерной для адверсарных сетей.

Модели Adversarial Flow объединяют дискриминатор и генератор в рамках детерминированного транспортного фреймворка, что позволяет достичь более высокой точности и разнообразия генерируемых образцов. В частности, при использовании настройки 1NFE (1 Normalized Flow Evaluation) на датасете ImageNet-256px, модели продемонстрировали наилучший на текущий момент показатель FID (Fidelity and Inception Distance) — 2.38. Этот показатель оценивает качество генерируемых изображений, где более низкое значение соответствует более реалистичным и разнообразным результатам.

В архитектуре Adversarial Flow Models используется DeepTransformer, что позволяет увеличить емкость модели и повысить ее производительность. Эксперименты показали, что модели, состоящие из 56 и 112 слоев Transformer, достигают показателей FID (Fidelity and Inception Distance) в 2.08 и 1.94 соответственно. Применение ClassifierGuidance в сочетании с данной архитектурой обеспечивает контролируемую генерацию и превосходит существующие модели, использующие 2NFE и 4NFE, по качеству генерируемых образцов.

По ту сторону состязательного обучения: Согласованность и самодистилляция

Модели согласованности представляют собой принципиально новый подход к обучению генеративных моделей, который обходится без необходимости использования состязательного обучения. В основе этого метода лежит принцип самосогласованности: модель обучается генерировать выходные данные, которые остаются стабильными и предсказуемыми даже при небольших изменениях входных данных или внутренних параметров. Вместо того, чтобы соревноваться с дискриминатором, как в генеративно-состязательных сетях (GAN), модель согласованности стремится к внутренней консистентности, что позволяет создавать высококачественные образцы, избегая проблем, связанных с нестабильностью и режимами схлопывания, часто встречающимися в состязательном обучении. Этот подход открывает новые возможности для генерации данных, обеспечивая более контролируемый и предсказуемый процесс обучения, а также потенциально улучшенное качество генерируемых образцов.

Метод ScoreDistillation представляет собой альтернативный подход к обучению генератора, основанный на согласовании его функции оценки с функцией оценки предварительно обученной модели. Этот процесс не просто копирует выходные данные, а стремится к соответствию в более глубоком смысле — в структуре вероятностного распределения, представленного функцией оценки. В результате, генератор учится создавать данные, которые не только выглядят реалистично, но и соответствуют внутренним закономерностям, усвоенным предварительно обученной моделью. Ключевым аспектом является уточнение латентного пространства, что позволяет генератору более эффективно исследовать и использовать возможности для создания разнообразных и качественных образцов. Такой подход позволяет избежать нестабильности, часто связанной с состязательным обучением, и способствует созданию более надежных и предсказуемых генеративных моделей.

Исследования показали, что стабильная и эффективная генерация изображений не обязательно требует сложных механизмов состязательного обучения. Новые подходы, такие как Adversarial Flow Models, превзошли существующие методы, основанные на принципе согласованности, например, AlphaFlow. В частности, Adversarial Flow Models достигли показателя FID (Fréchet Inception Distance) в 2.38, что свидетельствует о значительном улучшении качества генерируемых изображений и подтверждает возможность создания высокореалистичных результатов без использования традиционных генеративно-состязательных сетей. Данный результат указывает на перспективность альтернативных стратегий обучения, позволяющих упростить процесс генерации и повысить стабильность модели.

Исследование, представленное в статье, демонстрирует стремление к элегантности в генеративных моделях. Авторы предлагают Adversarial Flow модели, объединяющие сильные стороны состязательных и потоковых подходов. Это не просто техническое усовершенствование, а попытка создать систему, в которой каждое звено выполняет свою функцию, не создавая избыточности. Как однажды заметил Брайан Керниган: «Простота — это высшая степень совершенства». Эта фраза прекрасно иллюстрирует суть представленной работы: стремление к лаконичности и эффективности в процессе сопоставления распределений, что особенно заметно в контексте обучения моделей генерации изображений. Устранение ненужных сложностей позволяет добиться как высокого качества генерируемых образцов, так и стабильности процесса обучения.

Что дальше?

Представленные модели, объединяя принципы состязательности и потоков, кажутся шагом к упрощению ландшафта генеративных моделей. Однако, кажущееся совершенство — это лишь отражение текущих метрик. Истинное испытание — не в достижении более высокого значения FID, а в понимании, что эти метрики измеряют лишь поверхностное сходство, игнорируя глубинные характеристики распределений. Попытки “улучшить” генерацию, добавляя все новые слои “руководства”, лишь маскируют фундаментальную проблему: отсутствие ясного критерия “хорошей” генерации.

Более плодотворным представляется отказ от гонки вооружений в сложности. Вместо этого, необходимо сосредоточиться на разработке более строгих, менее подверженных манипуляциям метрик оценки. Или, что еще более радикально, признать, что сама задача “точного соответствия распределениям” может быть нерешаемой или даже бессмысленной. Возможно, истинная сила этих моделей заключается не в их способности имитировать данные, а в способности выявлять и усиливать скрытые закономерности, которые остаются незамеченными при традиционном анализе.

Будущие исследования должны быть направлены не на создание все более сложных архитектур, а на поиск принципиально новых способов взаимодействия с данными, которые позволят извлечь из них максимум информации, не усложняя при этом модель. Сложность — это всего лишь признак непонимания. Ясность — вот к чему следует стремиться.

Оригинал статьи: https://arxiv.org/pdf/2511.22475.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовый скачок: от лаборатории к рынку

2025-12-01 23:30