Автор: Денис Аветисян

Новый подход позволяет алгоритмам эффективно исследовать пространство решений, избегая зацикливания на оптимальных, но не самых разнообразных стратегиях.

В статье представлена концепция Distributional Creative Reasoning (DCR) — фреймворк, стимулирующий стратегическое разнообразие и предотвращающий его деградацию в задачах обучения с подкреплением.

Несмотря на успехи современных больших языковых моделей (LLM) в решении задач, их склонность к оптимизации точности часто подавляет креативность и разнообразие подходов. В работе ‘The Reasoning-Creativity Trade-off: Toward Creativity-Driven Problem Solving’ исследуется эта проблема и предлагается новый подход — Distributional Creative Reasoning (DCR), позволяющий находить баланс между исследованием и эксплуатацией, предотвращая коллапс семантического разнообразия. DCR представляет собой унифицированную вариационную задачу, рассматривающую обучение как градиентный поток по вероятностным мерам на путях решения, что обеспечивает стабильное и разнообразное поведение моделей. Сможет ли предложенная методика DCR открыть путь к созданию LLM, способных не только правильно отвечать на вопросы, но и находить нестандартные, творческие решения?

Распад Стратегий: Цена Единой Награды

В процессе обучения с подкреплением, когда агенты стремятся к максимизации единой числовой награды, часто наблюдается явление, известное как «Распад Стратегического Разнообразия». Это приводит к тому, что популяция агентов неизбежно сходится к единой, зачастую неоптимальной стратегии, игнорируя потенциально более эффективные, но менее «наградные» подходы. Вместо коллективного исследования пространства стратегий, агенты сосредотачиваются на одной, доминирующей, даже если она не обеспечивает наилучший результат в долгосрочной перспективе. Данный процесс ограничивает адаптивность системы и снижает её устойчивость к изменениям в окружающей среде, поскольку теряется способность к использованию альтернативных решений.

Потеря стратегического разнообразия в процессе обучения с подкреплением — это не просто снижение эффективности, а принципиальное ограничение в способности агентов исследовать и адаптироваться к сложным средам. Вместо того, чтобы развивать широкий спектр стратегий, агенты склонны сходиться к единственному, зачастую неоптимальному решению, игнорируя потенциально более выгодные, но менее очевидные подходы. Это сужает горизонты поиска и препятствует формированию устойчивых к изменениям систем, лишая их способности к творческому решению проблем и эффективной адаптации к новым вызовам. Такая тенденция демонстрирует фундаментальную проблему в существующих алгоритмах обучения, требующую переосмысления подходов к исследованию и поддержанию разнообразия стратегий.

Теорема упадка разнообразия формально описывает механизм, приводящий к коллапсу стратегий в процессе обучения с подкреплением. Данная теорема предсказывает возникновение специфических сценариев, в частности, ситуацию, когда одна стратегия доминирует над всеми остальными — так называемый эффект “победитель получает всё”. \text{lim}_{t \to \in fty} \text{Diversity}(t) = 0 — это математическое выражение отражает тенденцию к снижению разнообразия стратегий со временем. Исследование показывает, что при максимизации скалярной награды, агенты склонны к сходимости на одну, зачастую субоптимальную, стратегию, игнорируя потенциально более эффективные альтернативы, что подтверждает предсказания теоремы и демонстрирует фундаментальные ограничения в подходах к исследованию и адаптации в системах искусственного интеллекта.

Понимание механизмов коллапса стратегий, возникающих в процессе обучения с подкреплением, имеет первостепенное значение для создания действительно устойчивых и креативных интеллектуальных систем. Исследования показывают, что тенденция к упрощению и сходимости к единственной, хоть и неоптимальной стратегии, ограничивает адаптивность агентов в сложных и меняющихся средах. Разработка алгоритмов, способных предвидеть и предотвращать эти “режимы коллапса”, позволяет создавать системы, демонстрирующие большую гибкость, устойчивость к ошибкам и способность находить инновационные решения. Игнорирование этих закономерностей ведет к созданию хрупких систем, легко подвергающихся сбоям и неспособных эффективно функционировать в условиях неопределенности.

DCR: Переосмысление Обучения как Потока Градиента

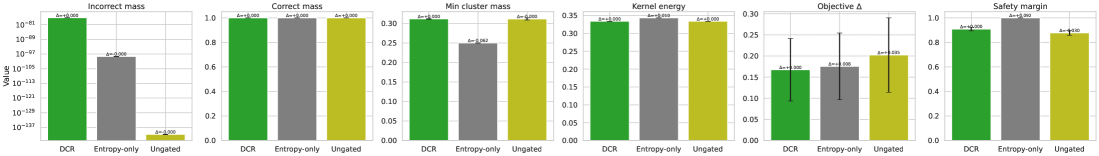

Метод Распределенного Креативного Рассуждения (DCR) представляет собой новый подход к обучению с подкреплением, который переосмысливает процесс обучения как поток градиента на Полиси-Симплексе. В отличие от традиционных методов, DCR напрямую направлен на противодействие проблеме угасания стратегического разнообразия. Полиси-Симплекс — это пространство вероятностей над всеми возможными действиями, и манипулирование градиентным потоком в этом пространстве позволяет поддерживать и даже увеличивать разнообразие стратегий, что критически важно для решения сложных задач и адаптации к меняющимся условиям. Результаты, представленные в данной работе, демонстрируют эффективность DCR в поддержании стратегического разнообразия в процессе обучения.

Подход DCR (Distributional Creative Reasoning) напрямую противодействует снижению стратегического разнообразия (strategic diversity decay) за счет стимулирования исследования всего пространства действий. В традиционном обучении с подкреплением, политики часто сходятся к ограниченному подмножеству действий, что приводит к потере потенциально полезных стратегий. DCR обеспечивает более полное покрытие пространства действий, побуждая агента исследовать и оценивать широкий спектр возможных стратегий. Это достигается за счет модификации процесса обучения, чтобы поощрять отклонения от текущей политики, тем самым предотвращая преждевременную сходимость и поддерживая стратегическое разнообразие на протяжении всего обучения. В результате, агент способен адаптироваться к различным ситуациям и использовать более широкий спектр доступных действий.

Метод Distributional Creative Reasoning (DCR) использует так называемое Ядро Креативности (Creativity Kernel) в качестве основного инструмента управления для тонкой настройки баланса между исследованием (exploration) и использованием (exploitation) в процессе обучения с подкреплением. Это ядро позволяет регулировать интенсивность и направление градиентного потока на Симплексе Политик (Policy Simplex), определяя, насколько агент склонен к исследованию новых стратегий или к использованию уже известных. Изменяя параметры ядра, можно контролировать степень диверсификации политики, предотвращая преждевременную сходимость к субоптимальным решениям и способствуя развитию стабильных, внутренних политик, охватывающих широкий спектр возможных действий. \mathcal{K}(p, q) — пример математического представления ядра креативности, где p и q — вероятностные распределения политик.

Метод DCR (Distributional Creative Reasoning) способствует формированию стабильных внутренних политик за счет манипулирования градиентным потоком на Policy Simplex. Вместо стремления к экстремальным стратегиям (например, полному игнорированию определенных действий), DCR направляет процесс обучения к политикам, которые используют весь диапазон доступных действий с умеренной вероятностью. Это достигается за счет изменения направления и величины градиента, что позволяет избегать сходимости к граничным решениям и обеспечивает устойчивость стратегии в долгосрочной перспективе. В результате формируются политики, находящиеся в «внутренней» области Policy Simplex, что обеспечивает более надежную и гибкую адаптацию к изменяющимся условиям среды.

Баланс Исследования и Использования: Тонкая Настройка DCR

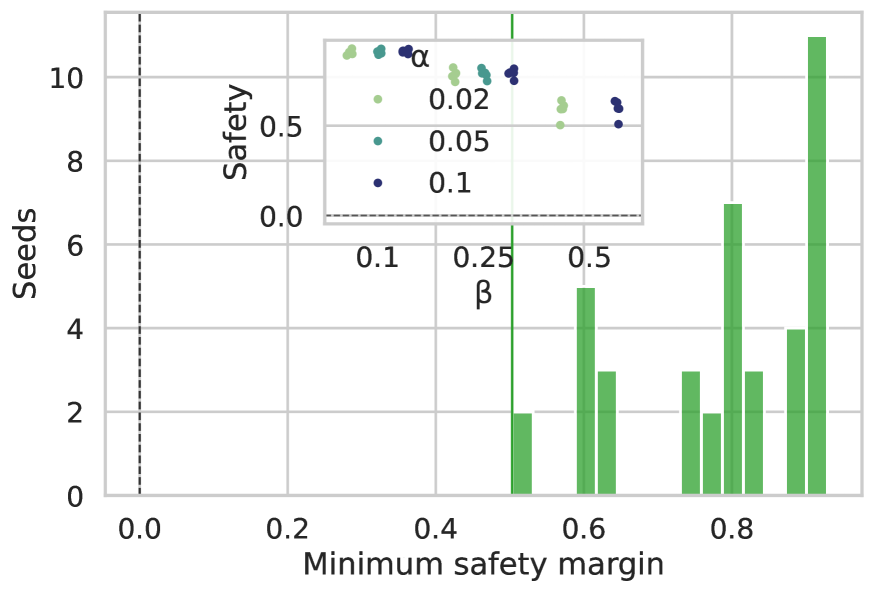

В алгоритме DCR (Diversity-promoting Curriculum Reinforcement Learning) параметры α и β используются для управления степенью влияния Функционала Энергии Разнообразия на процесс обучения. Параметр α регулирует вес, придаваемый разнообразию в общей функции потерь, определяя, насколько сильно алгоритм стремится поддерживать разнообразие политик. Параметр β контролирует скорость, с которой вклад разнообразия уменьшается по мере обучения, позволяя алгоритму постепенно смещаться от исследования к эксплуатации. Изменяя эти параметры, можно настроить баланс между поддержанием разнообразия и оптимизацией производительности, обеспечивая устойчивость и адаптивность стратегий обучения.

Функционал разнообразия D(π) является ключевым компонентом DCR, обеспечивая поддержание разнообразия политик и предотвращая преждевременную сходимость к субоптимальным решениям. Этот функционал оценивает степень отличия текущей политики от ранее исследованных, стимулируя алгоритм к исследованию новых стратегий. В процессе обучения, DCR минимизирует как функцию потерь, отражающую корректность политики, так и функционал разнообразия, что позволяет поддерживать баланс между эксплуатацией известных эффективных стратегий и исследованием новых, потенциально более выгодных. Отсутствие учета разнообразия может привести к ситуации, когда алгоритм застревает в локальном оптимуме, не исследуя более перспективные области пространства стратегий.

В алгоритме DCR, баланс между точностью и креативностью достигается посредством тонкой настройки параметров, влияющих на Diversity Energy Functional. Оптимизация этих параметров позволяет одновременно максимизировать производительность политики (точность) и поддерживать её разнообразие (креативность). Повышение веса параметра, отвечающего за разнообразие, способствует исследованию более широкого спектра стратегий, в то время как увеличение веса параметра, отвечающего за точность, усиливает эксплуатацию наиболее эффективных стратегий. Этот механизм позволяет DCR адаптироваться к различным задачам и обеспечивать устойчивое, робастное поведение, избегая преждевременной сходимости к локальному оптимуму.

Параметры α и β в DCR представляют собой мощный инструмент для формирования процесса обучения и стимулирования устойчивого стратегического поведения. Регулируя влияние этих параметров на Diversity Energy Functional, можно контролировать степень исследования (exploration) и использования (exploitation) различных стратегий. Более высокие значения α способствуют большему разнообразию политик, даже за счет некоторой потери в текущей производительности, в то время как увеличение β усиливает акцент на наиболее эффективных стратегиях. Точная настройка этих параметров позволяет DCR адаптироваться к различным средам и задачам, избегая преждевременной сходимости к субоптимальным решениям и обеспечивая надежность стратегии в долгосрочной перспективе.

Исследование демонстрирует, что стремление к творчеству в алгоритмах обучения с подкреплением — это не просто добавление случайности, а тонкий баланс между исследованием и эксплуатацией. Авторы предлагают механизм, препятствующий «вырождению» разнообразия стратегий, что, в сущности, лишь подтверждает старую истину: любая система, лишенная внутреннего разнообразия, обречена на стагнацию. Как однажды заметил Алан Тьюринг: «Мы можем только надеяться, что машины не станут слишком умными, прежде чем мы научимся их контролировать». В данном контексте, речь не о контроле, а о сохранении необходимого уровня «шума», чтобы алгоритм не зациклился на локальном оптимуме. В конечном итоге, все эти «cloud-native» решения и «креативные» алгоритмы — лишь инструменты, а истинная проблема — в поддержании баланса, прежде чем элегантная теория рухнет под натиском прагматичной реальности.

Что дальше?

Предложенный подход к «креативному рассуждению» несомненно элегантен. Однако, история учит, что любая «стратегическая диверсификация» рано или поздно столкнётся с неизбежным: производством. Продакшен всегда найдёт способ свести все эти красивые стратегии к одному, наиболее дешевому и надёжному решению. «Разложение диверсификации» — интересное наблюдение, но, вероятно, лишь симптом более глубокой проблемы: энтропия всегда побеждает, если ей не противодействовать конкретными, прагматичными мерами.

Очевидно, что текущая реализация, как и большинство, опирается на определённые упрощения. Вопрос в том, насколько хорошо предложенный «Policy Simplex» масштабируется на действительно сложные задачи. И, что более важно, как быстро эти «креативные» стратегии будут вытеснены более эффективными, но менее «разнообразными» алгоритмами? Если тесты зелёные — значит, они проверяют лишь соответствие реализации спецификации, но никак не устойчивость системы к реальным условиям.

В конечном счёте, вся эта область исследований напоминает попытку построить вечный двигатель. Не в смысле нарушения законов физики, конечно. Скорее, в смысле бесконечной оптимизации, которая рано или поздно упрётся в потолок, а все эти изящные теории окажутся лишь красивой обёрткой для старых, проверенных временем решений. Всё это уже было в 2012-м, только называлось иначе.

Оригинал статьи: https://arxiv.org/pdf/2601.00747.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Монте-Карло: Моделирование рождения электрон-позитронных пар

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Квантовый скачок из Андхра-Прадеш: что это значит?

- Виртуальная примерка без границ: EVTAR учится у образов

- Насколько важна полнота при оценке поиска?

- Переключение намагниченности в квантовых антиферромагнетиках: новые горизонты для терагерцовой спинтроники

- Геометрия на пределе: как алгоритмы оптимизации превосходят языковые модели

- Оптимизация партийных запросов: Метод имитации отжига против градиентных подходов

- Скрытая сложность: Необратимые преобразования в квантовых схемах

2026-01-05 20:01