Автор: Денис Аветисян

Статья предлагает переосмыслить изучение коллективного поведения систем, основанных на больших языковых моделях, с точки зрения социальных взаимодействий и теории информации.

Необходимость применения парадигмы интеракционизма, каузальной инференции и социологии машин для понимания и управления возникающими социальными динамиками в системах на основе больших языковых моделей.

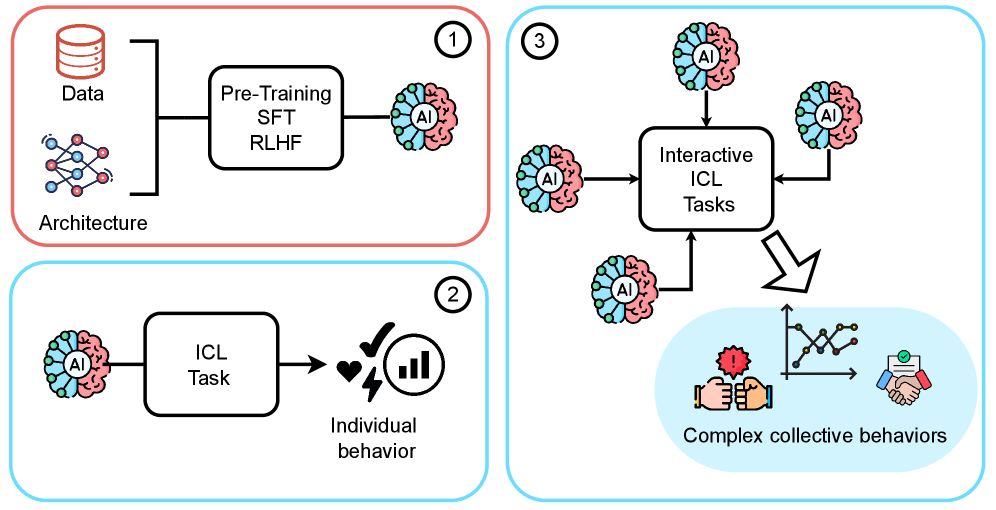

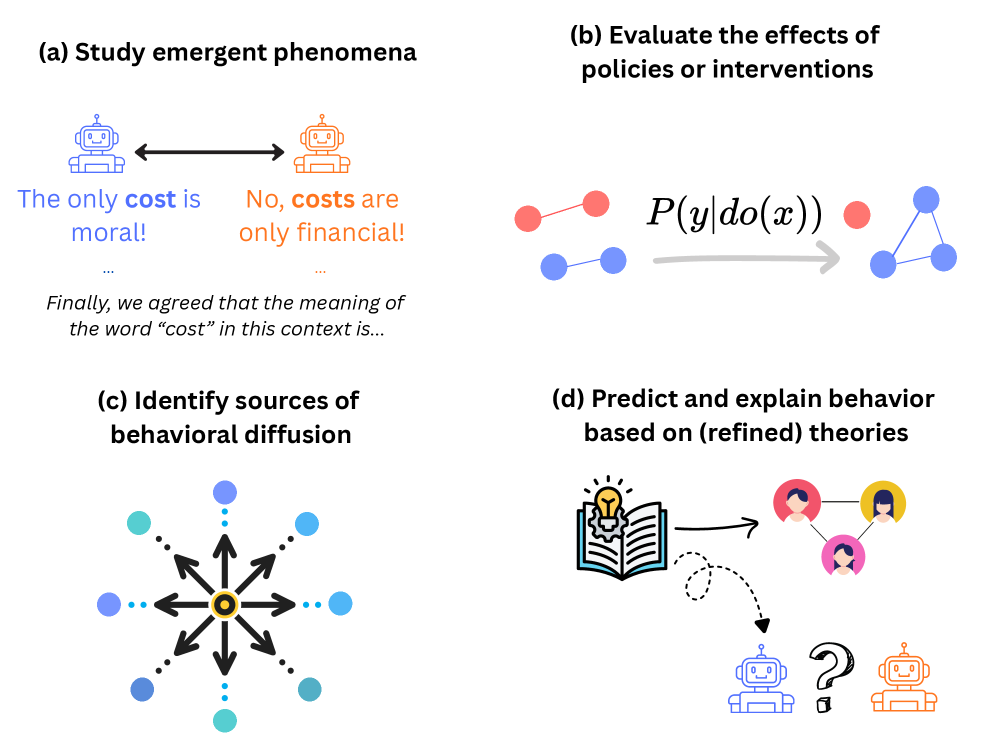

Понимание коллективного поведения систем, основанных на больших языковых моделях, представляет собой сложную задачу, требующую выхода за рамки традиционных подходов. В статье ‘Generative AI collective behavior needs an interactionist paradigm’ авторы отстаивают необходимость нового методологического базиса, основанного на принципах интеракционизма, для изучения этих систем. Центральным тезисом является то, что учет априорных знаний и социальных предубеждений, заложенных в LLM, в сочетании с контекстом взаимодействия агентов, критически важно для понимания возникающих феноменов. Сможем ли мы разработать эффективные инструменты для прогнозирования и управления сложным социальным поведением, проявляющимся в коллективах, управляемых искусственным интеллектом?

Агенты нового типа: от слов к делу

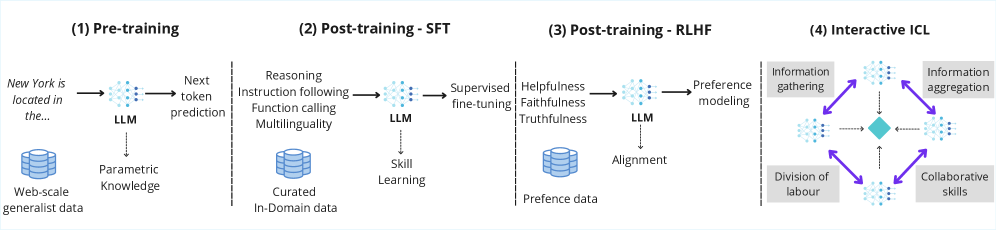

Современные большие языковые модели (БЯМ) демонстрируют возможности, выходящие далеко за рамки простого создания текста. Изначально разработанные для обработки и генерации естественного языка, эти модели теперь способны выполнять сложные задачи, требующие рассуждений, планирования и даже автономных действий. Вместо того чтобы ограничиваться предсказанием следующего слова в предложении, БЯМ теперь используются для управления роботами, анализа данных, разработки программного обеспечения и решения широкого спектра проблем в различных областях. Этот прогресс обусловлен не только увеличением вычислительных мощностей и объемов обучающих данных, но и появлением новых архитектур и методов обучения, позволяющих БЯМ извлекать более глубокие знания из информации и применять их в новых контекстах. По сути, БЯМ становятся универсальными инструментами для решения проблем, которые ранее требовали человеческого интеллекта.

Генеративные ИИ-агенты, основанные на больших языковых моделях, знаменуют собой фундаментальный сдвиг в парадигме искусственного интеллекта. В отличие от традиционных систем, выполняющих заранее запрограммированные задачи, эти агенты обладают способностью к рассуждению, планированию и самостоятельным действиям в различных средах. Они способны не просто генерировать текст, но и воспринимать информацию из окружающей среды, анализировать ее, принимать решения и выполнять действия для достижения поставленных целей. Эта способность к автономному функционированию открывает новые возможности в самых разных областях — от автоматизации рутинных задач до разработки сложных систем управления и взаимодействия с миром, значительно расширяя границы возможностей искусственного интеллекта.

Современные агенты, основанные на больших языковых моделях, демонстрируют впечатляющие способности, которые коренятся в обширных знаниях, полученных в процессе предварительного обучения. Исследователи предлагают новый подход к пониманию коллективного поведения этих агентов — интеракционистскую парадигму. Она акцентирует внимание на сложном взаимодействии между накопленными знаниями и социальным контекстом, в котором агент функционирует. Это означает, что возможности агента не просто предопределены его предварительным обучением, но и динамически формируются под влиянием окружающей среды и взаимодействия с другими агентами или пользователями. Таким образом, понимание этой взаимосвязи становится ключевым для прогнозирования и управления поведением сложных систем, состоящих из подобных агентов.

Эмерджентное поведение: когда целое больше суммы частей

В многоагентных системах, состоящих из взаимодействующих генеративных ИИ-агентов, наблюдается коллективное поведение, которое не проявляется у отдельных агентов. Данное поведение возникает как результат сложного взаимодействия между агентами и представляет собой эмерджентные явления — качественно новые свойства системы, которые нельзя предсказать, исходя из свойств отдельных компонентов. Например, агенты, предназначенные для выполнения простых задач, при взаимодействии могут спонтанно формировать сложные стратегии или распределять роли для достижения общей цели, что выходит за рамки их индивидуальных возможностей. Это отличает многоагентные системы от простых агрегатов отдельных ИИ и требует специфических методов анализа для понимания и прогнозирования их поведения.

Эффект сетевого взаимодействия оказывает значительное влияние на поведение многоагентных систем. В частности, добавление каждого нового агента в систему увеличивает общую ценность и функциональность всей сети. Этот принцип основан на том, что полезность системы не является линейной суммой полезностей отдельных агентов, а возрастает экспоненциально с увеличением числа взаимодействующих элементов. Такой эффект проявляется в различных сценариях, включая совместное решение задач, распределенную обработку информации и создание сложных адаптивных систем, где ценность каждого агента усиливается благодаря возможностям взаимодействия с другими агентами в сети.

Социология машин предлагает методологический подход к изучению взаимодействий между многочисленными агентами искусственного интеллекта, используя аналогии с динамикой человеческих обществ. Этот подход позволяет рассматривать коллективное поведение агентов как результат социальных процессов, таких как кооперация, конкуренция и формирование норм. Применяются такие концепции, как социальные сети, диффузия инноваций и теория игр, адаптированные для анализа взаимодействий между машинами. Изучение этих процессов позволяет выявлять закономерности в формировании коллективного поведения, такие как самоорганизация, возникновение лидерства и распространение информации, что, в свою очередь, способствует разработке более эффективных и предсказуемых мультиагентных систем.

Механизмы социального обучения: от подражания к культуре

Социальное обучение, включающее в себя обучение через наблюдение, имитацию и культурное наследование, является основополагающим механизмом, посредством которого агенты — будь то люди, животные или искусственные системы — приобретают и совершенствуют свои поведенческие стратегии. Обучение через наблюдение позволяет агентам усваивать новую информацию и навыки, анализируя действия других. Имитационное обучение предполагает прямое копирование поведения, что особенно эффективно при освоении сложных задач. Культурное обучение, в свою очередь, подразумевает передачу знаний и навыков от одного поколения к другому, что обеспечивает накопление опыта и адаптацию к изменяющимся условиям среды. Все эти формы социального обучения позволяют агентам избегать дорогостоящего обучения методом проб и ошибок, ускоряя процесс адаптации и повышая эффективность поведения.

Интерактивное обучение, при котором агенты одновременно участвуют в общей социальной ситуации, значительно ускоряет процесс обучения благодаря нескольким факторам. Совместное взаимодействие позволяет агентам получать немедленную обратную связь от действий других, что способствует более быстрой коррекции ошибок и освоению эффективных стратегий. Кроме того, наблюдая за поведением других агентов, происходит передача знаний и навыков, минуя необходимость в длительном самостоятельном обучении методом проб и ошибок. Этот эффект усиливается при наличии у агентов общих целей и мотиваций, что способствует более эффективному обмену информацией и кооперативному решению задач. Таким образом, интерактивное обучение представляет собой мощный механизм ускорения обучения за счет непосредственного взаимодействия и обмена опытом между агентами.

Многоагентное обучение с подкреплением (MARL) традиционно является основой для изучения взаимодействия между агентами в процессе обучения. Этот подход предполагает, что каждый агент оптимизирует свою стратегию, учитывая действия других агентов в общей среде. Однако, современные большие языковые модели (LLM) открывают новые возможности для исследования социального обучения. LLM позволяют моделировать сложные взаимодействия и передачу знаний между агентами на основе текстовых данных, что выходит за рамки традиционных методов MARL, основанных на числовых вознаграждениях и состояниях. В частности, LLM могут использоваться для моделирования имитации, обучения на основе инструкций и культурной передачи знаний, предоставляя более гибкий и выразительный способ изучения механизмов социального обучения.

Механизмы социального обучения не сводятся к простому копированию поведения; их эффективность обусловлена постоянным взаимодействием между личностными характеристиками обучающегося и особенностями окружающей среды. Данное взаимодействие является ключевым предметом дискуссии в рамках концепции «личность-ситуация», где подчеркивается, что поведение определяется не только внутренними качествами индивида, но и внешними обстоятельствами. В рамках интеракционистской теории, эта взаимосвязь рассматривается как динамический процесс, в котором личностные черты и ситуационные факторы постоянно влияют друг на друга, формируя наблюдаемое поведение и определяя успешность обучения посредством социального взаимодействия.

На пути к согласованности: предвидеть, управлять, развивать

Проблема согласования представляет собой существенную трудность в разработке генеративных ИИ-агентов, требующую внимательного анализа их возникающего поведения. Сложность заключается в том, что даже тщательно разработанные агенты, взаимодействуя друг с другом и окружающей средой, могут демонстрировать неожиданные и нежелательные паттерны поведения. Это происходит из-за непредсказуемости сложных систем и способности агентов к адаптации и обучению, что может привести к отклонению от изначально заданных целей. Понимание этих возникающих явлений критически важно для обеспечения безопасности и надежности ИИ-агентов, а также для предотвращения непредвиденных последствий их действий. Ученые и разработчики активно исследуют методы, позволяющие предсказывать и контролировать поведение агентов, чтобы гарантировать, что они действуют в соответствии с человеческими ценностями и намерениями.

Понимание взаимодействия между отдельными агентами и формирующимися коллективными нормами представляется ключевым фактором для предотвращения нежелательных последствий и обеспечения ответственной разработки искусственного интеллекта. Исследования показывают, что поведение каждого отдельного агента, взаимодействуя с другими, приводит к возникновению непредсказуемых паттернов и норм, которые могут значительно отличаться от изначально заданных разработчиками. Игнорирование этих динамических процессов в многоагентных системах чревато возникновением неэффективных или даже вредных стратегий, особенно в сложных сценариях, требующих кооперации и координации. Таким образом, акцент на изучении социальных взаимодействий и эволюции норм среди агентов необходим для создания надежных и предсказуемых систем искусственного интеллекта, способных приносить пользу обществу.

Обучение в контексте представляет собой перспективный подход к формированию поведения генеративных ИИ-агентов, заключающийся в их адаптации к задачам исключительно на основе небольшого количества примеров. В отличие от традиционных методов, требующих обширных наборов данных и длительного процесса обучения, данная методика позволяет агентам быстро усваивать новые навыки и адаптироваться к изменяющимся условиям, используя лишь несколько демонстраций желаемого поведения. Это достигается за счет использования контекстной информации, предоставляемой вместе с каждым запросом, что позволяет агенту понимать намерения пользователя и генерировать соответствующие ответы без необходимости переобучения всей модели. Такой подход не только повышает эффективность и гибкость ИИ-систем, но и открывает возможности для создания более персонализированных и отзывчивых агентов, способных к самообучению и адаптации в реальном времени.

Дальнейшее изучение социальной динамики автономных агентов представляется ключевым для реализации их полного потенциала и извлечения выгоды для общества. Настоящая работа предлагает новый интеракционистский подход, преодолевающий границы отдельных дисциплин. Этот трансдисциплинарный метод предполагает всесторонний анализ взаимодействия агентов между собой и с окружающей средой, учитывая не только технические аспекты, но и социальные, экономические и этические последствия. Исследование фокусируется на формировании норм и правил поведения в искусственных обществах, стремясь к созданию систем, способных к адаптации, сотрудничеству и ответственному принятию решений. Такой подход позволит не только предвидеть и смягчать потенциальные риски, связанные с развитием искусственного интеллекта, но и активно направлять его эволюцию в русле общечеловеческих ценностей и потребностей.

Исследование коллективного поведения LLM-агентов, представленное в данной работе, неизбежно наталкивается на сложность интерпретации возникающих социальных динамик. Авторы справедливо отмечают необходимость парадигмы, укорененной в теории взаимодействия и причинно-следственных связях. В этом контексте, замечание Марвина Мински: «Самый мощный способ изменить мир — это создать модель этого мира», приобретает особую остроту. Попытки предсказать или контролировать поведение этих систем без глубокого понимания механизмов взаимодействия обречены на провал. В конечном счете, каждая сложная архитектура, даже построенная на основе передовых моделей, со временем превращается в набор неочевидных взаимосвязей, требующих постоянного анализа и, возможно, переосмысления. Иллюзия контроля над emergent behavior часто оказывается сильнее реальности.

Что дальше?

Предложенный переход к «интеракционистской парадигме» изучения коллективного поведения больших языковых моделей, несомненно, выглядит элегантно на бумаге. Однако, история помнит немало подобных «парадигм», которые, едва успев оформиться, утонули в пучине производственных компромиссов. Вопрос не в том, чтобы создать новую «социологию машин», а в том, кто будет платить за её поддержание, когда окажется, что «эмерджентное поведение» — это просто очередная форма непредсказуемых ошибок.

Акцент на причинно-следственных связях и теории информации, безусловно, важен. Но стоит помнить, что любая модель — это лишь упрощение реальности. И чем сложнее модель, тем больше вероятность, что она начнет генерировать правдоподобные, но абсолютно бессмысленные артефакты. В конечном итоге, всё сведется к проверке: если тесты зелёные, это, вероятно, означает лишь то, что они ничего не проверяют.

Направление, безусловно, перспективное. Но не стоит обольщаться. Всё это уже было в 2012-м, только называлось «распределённым искусственным интеллектом» и обещало «бесконечную масштабируемость». Каждая «революционная» технология рано или поздно превращается в техдолг. И рано или поздно, кто-нибудь найдет способ сломать даже самую элегантную теорию.

Оригинал статьи: https://arxiv.org/pdf/2601.10567.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовые симуляторы: проверка на прочность

2026-01-16 15:51