Автор: Денис Аветисян

Новая система ML-Master 2.0 демонстрирует способность автономно решать сложные задачи машинного обучения, накапливая и эволюционируя знания в течение неограниченного времени.

Исследование представляет подход иерархического когнитивного кэширования для обеспечения автономности на ультрадлительных горизонтах в машинном обучении.

Несмотря на впечатляющие успехи в области искусственного интеллекта, создание автономных агентов, способных к долгосрочным научным исследованиям, остается сложной задачей. В работе ‘Toward Ultra-Long-Horizon Agentic Science: Cognitive Accumulation for Machine Learning Engineering’ представлена система ML-Master 2.0, использующая иерархическое когнитивное кэширование для эффективного управления знаниями и преодоления ограничений контекстных окон в задачах машинного обучения. Достигнут передовой результат в 56.44% медалей на бенчмарке OpenAI’s MLE-Bench, демонстрируя возможность масштабирования автономных исследований. Способны ли такие системы открыть новую эру в научных открытиях, превосходя возможности человека в решении сложных задач?

Вызов ультра-долгосрочного обучения

Традиционные агенты машинного обучения сталкиваются с существенными трудностями при решении задач, требующих поддержания стратегической последовательности на протяжении длительного времени. В отличие от людей, способных планировать и адаптироваться к изменяющимся обстоятельствам, эти системы часто демонстрируют снижение эффективности по мере увеличения горизонта планирования. Проблема заключается в том, что они, как правило, оптимизированы для немедленной выгоды, не учитывая долгосрочные последствия своих действий. Это приводит к тому, что они не способны эффективно координировать свои действия для достижения сложных, отсроченных целей, и их производительность резко падает, когда необходимо принимать решения, влияющие на будущее на протяжении многих шагов. В результате, даже относительно простые задачи, требующие последовательного планирования и адаптации, могут оказаться непосильными для этих систем.

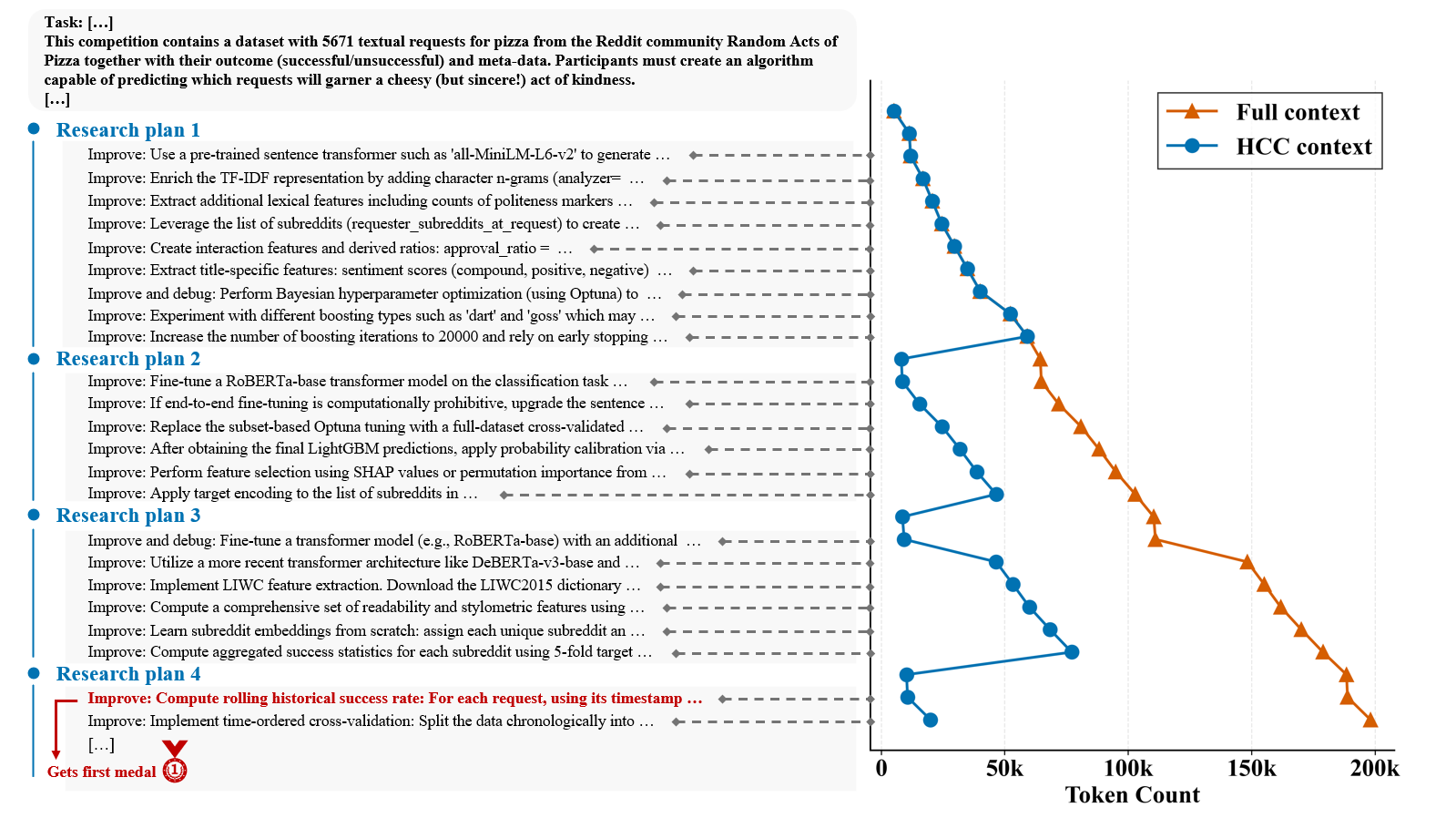

Традиционные модели машинного обучения, оперирующие фиксированным контекстом, сталкиваются с существенными ограничениями в процессе извлечения полезных знаний из накопленного опыта. Суть проблемы заключается в том, что эти модели, будучи обученными на ограниченном наборе данных или в рамках заранее определенных условий, не способны эффективно обобщать полученные знания и адаптироваться к новым, меняющимся обстоятельствам. В результате, даже обширные объемы информации могут оставаться невостребованными, поскольку модель не в состоянии выделить ключевые закономерности и установить причинно-следственные связи, необходимые для формирования практически применимых знаний. Это особенно критично в задачах, требующих долгосрочного планирования и принятия решений, где контекст постоянно меняется, и способность к адаптации является ключевым фактором успеха.

Возникает острая необходимость в создании агентов, способных к непрерывному обучению и адаптации, имитируя когнитивные способности человека. В отличие от традиционных систем, которые оперируют фиксированным объемом информации, такие агенты должны обладать механизмом аккумулирования опыта на протяжении длительного времени, извлекая из него ценные уроки и преобразуя их в эффективные стратегии действий. Эта способность к постоянному совершенствованию, подобно человеческой памяти и интуиции, позволяет им успешно справляться со сложными задачами, требующими долгосрочного планирования и прогнозирования, а также гибко реагировать на изменяющиеся условия окружающей среды. Разработка подобных систем представляет собой ключевой вызов для современного искусственного интеллекта, открывая перспективы для создания действительно автономных и интеллектуальных агентов, способных к самообучению и самосовершенствованию.

ML-Master 2.0: Иерархическая когнитивная архитектура

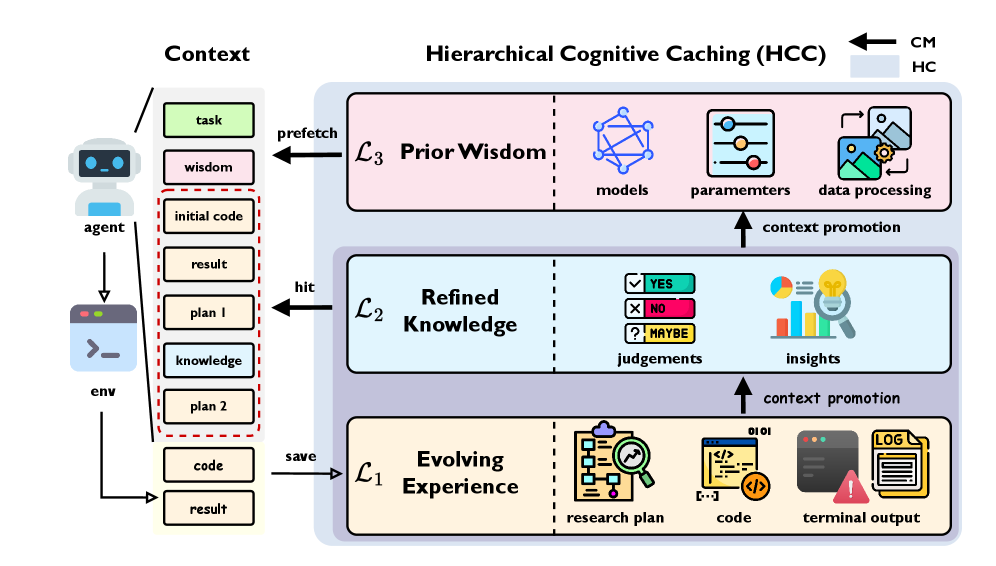

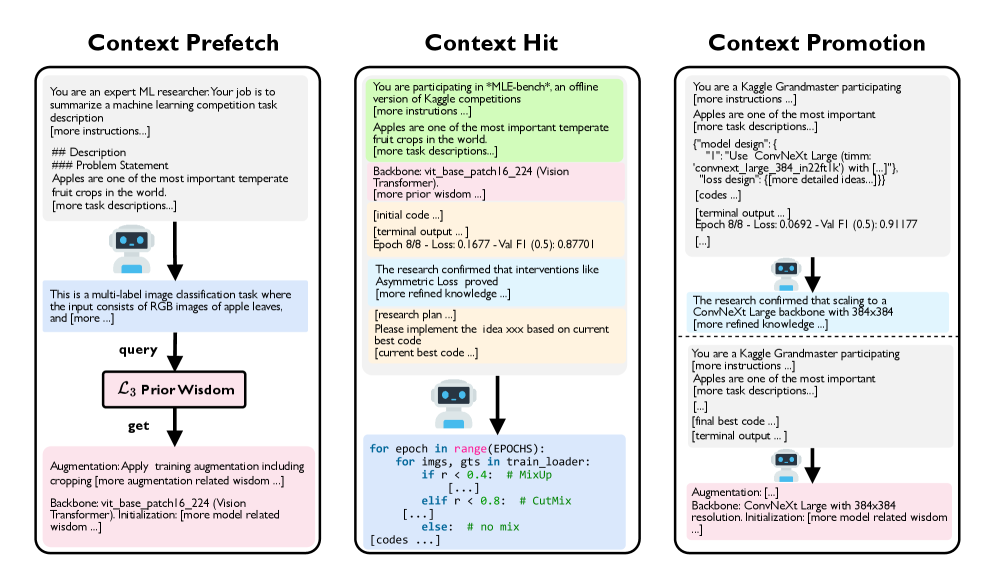

В архитектуре ML-Master 2.0 для управления контекстом на различных уровнях абстракции и временного разрешения используется иерархическое когнитивное кэширование (HCC). Эта система позволяет агенту динамически сохранять и использовать информацию, различаясь по степени детализации и продолжительности хранения. HCC позволяет разделять контекст на несколько уровней, обеспечивая быстрое извлечение наиболее актуальных данных для текущих задач, а также долгосрочное хранение обобщенных знаний и стратегий. Временное разрешение кэша варьируется от немедленного (для текущего рассуждения) до долгосрочного (для переноса опыта), что позволяет агенту адаптироваться к изменяющимся условиям и эффективно решать сложные задачи.

Иерархическое когнитивное кэширование (HCC) в ML-Master 2.0 состоит из трех основных кэшей, различающихся по назначению и временному горизонту хранения. Кэш Эволюционирующего Опыта (L1) предназначен для хранения информации, необходимой для немедленного рассуждения и принятия решений в текущий момент времени. Кэш Уточненных Знаний (L2) содержит стабилизированные знания и выводы, полученные в результате обработки информации из L1 и прошедшие проверку временем. Наконец, кэш Предварительной Мудрости (L3) хранит общие стратегии и принципы, которые могут быть перенесены и применены в различных ситуациях, обеспечивая долгосрочное обучение и адаптацию агента.

Многоуровневая система кэширования в ML-Master 2.0 обеспечивает динамическое определение приоритетов и удержание релевантной информации, что критически важно для обучения и адаптации агента в долгосрочной перспективе. Использование трех уровней кэша — оперативной памяти для текущего рассуждения, кэша стабилизированных знаний и кэша переносимых стратегий — позволяет агенту эффективно фильтровать поступающие данные, сохраняя наиболее важные аспекты опыта и знаний. Такой подход снижает потребность в постоянном переобучении, ускоряет процесс адаптации к новым ситуациям и повышает общую эффективность агента при решении сложных задач, требующих долгосрочного планирования и накопления опыта.

Управление контекстом: дистилляция опыта в мудрость

Миграция контекста внутри HCC (Hierarchical Context Core) организует поток информации между кэшами уровней L1, L2 и L3, обеспечивая эффективную передачу знаний. Этот процесс позволяет переносить информацию, полученную на нижних уровнях (L1), в более долгосрочные и обобщенные представления в кэшах L2 и L3. Передача осуществляется на основе приоритетов и релевантности данных, что минимизирует избыточность и обеспечивает доступ к наиболее важной информации. Эффективность миграции контекста напрямую влияет на скорость обучения и адаптации системы, поскольку позволяет избежать повторной обработки уже усвоенных знаний.

Механизм продвижения контекста (Context Promotion) является ключевым элементом в процессе дистилляции информации внутри HCC. Он выполняет консолидацию необработанных данных, поступающих из различных источников, в структурированные знания и пригодные для повторного использования формы представления опыта — “wisdom”. Этот процесс включает в себя фильтрацию, обобщение и категоризацию данных, что позволяет выделить наиболее значимые паттерны и закономерности. В результате формируется компактное и эффективное представление накопленного опыта, которое может быть использовано для принятия решений и оптимизации дальнейших действий.

Поэтапное продвижение контекста (Phase-Level Context Promotion) представляет собой конкретную реализацию механизма, оптимизирующую процесс дистилляции знаний в конце каждого этапа исследования. Данный механизм позволяет консолидировать собранные данные и преобразовывать их в структурированные знания и применимые решения. Оптимизация достигается за счет агрегации информации, полученной на текущем этапе, и ее интеграции в существующую базу знаний, что повышает эффективность последующих этапов исследования и снижает потребность в повторном анализе уже обработанных данных. В результате, поэтапное продвижение контекста способствует более быстрому и точному извлечению ценной информации из исследуемого пространства.

Результаты на MLE-Bench: подтверждение долгосрочных возможностей

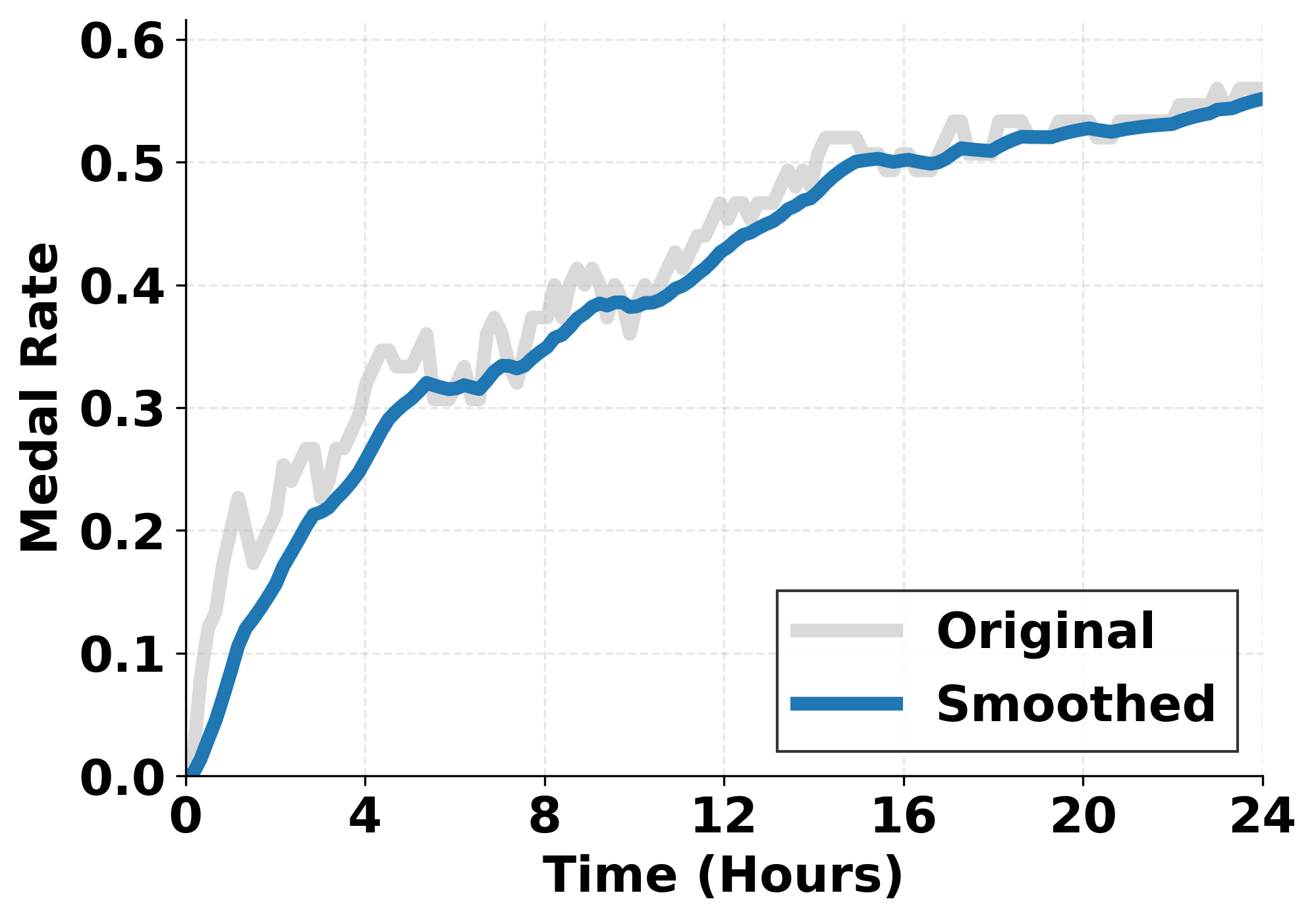

Для всесторонней оценки возможностей ML-Master 2.0 была использована платформа MLE-Bench, представляющая собой тщательно подобранный набор из 75 реальных соревнований по машинному обучению, взятых с популярной платформы Kaggle. Этот бенчмарк, охватывающий широкий спектр задач и наборов данных, позволил объективно измерить производительность агента в условиях, максимально приближенных к практическим сценариям. Использование реальных соревнований Kaggle гарантирует, что оценка не ограничена искусственно созданными условиями, а отражает способность агента решать сложные, нетривиальные задачи, с которыми сталкиваются специалисты в области машинного обучения.

Агент продемонстрировал значительное улучшение в долгосрочной эффективности и стратегической последовательности по сравнению с базовыми моделями, достигнув передового результата в 56.44% в среднем по количеству полученных медалей. Этот показатель свидетельствует о способности системы не просто решать отдельные задачи, но и поддерживать высокую производительность на протяжении всего периода соревнования, а также принимать обоснованные стратегические решения. Достигнутый уровень превосходит предыдущие результаты, подтверждая эффективность предложенных методов в области машинного обучения и открывая новые возможности для создания интеллектуальных систем, способных к адаптации и долгосрочному планированию.

Результаты тестирования продемонстрировали значительный прогресс в возможностях агента ML-Master 2.0 по сравнению с предшествующей версией. Зафиксировано относительное улучшение производительности на 92,7%, что позволило агенту занять лидирующие позиции во всех категориях сложности задач — от простых до наиболее комплексных. Этот результат свидетельствует о способности системы эффективно решать широкий спектр задач машинного обучения, демонстрируя стабильно высокие показатели независимо от уровня сложности, и подтверждает её потенциал для применения в реальных Kaggle-соревнованиях.

Агент ML-Master 2.0 продемонстрировал высокую надежность и эффективность в решении практических задач машинного обучения. Достигнутый уровень валидных отправок — 95,6% — соответствует показателям лучших существующих методов, что говорит о стабильности и корректности работы системы. Примечательно, что в 63,1% задач, ML-Master 2.0 превзошел результаты более чем половины участников-людей, что является самым высоким показателем среди всех протестированных систем и свидетельствует о значительном прогрессе в области автоматизированного машинного обучения и способности агента решать сложные задачи на уровне, сопоставимом с опытом квалифицированных специалистов.

К общему искусственному интеллекту: будущее когнитивного накопления

Когнитивное накопление, процесс эволюции контекста во времени, является ключевым элементом для достижения ультра-долгосрочной автономии. В отличие от традиционных систем искусственного интеллекта, которые часто работают в рамках фиксированного набора знаний, системы, способные к когнитивному накоплению, непрерывно адаптируются и совершенствуют свое понимание мира. Это достигается за счет сохранения и анализа предыдущего опыта, позволяя агенту выявлять закономерности, прогнозировать будущие события и принимать более обоснованные решения в сложных и динамичных условиях. По сути, когнитивное накопление позволяет искусственному интеллекту не просто «реагировать» на текущую ситуацию, а «учиться» на протяжении всего своего существования, что необходимо для решения задач, требующих долгосрочного планирования и адаптации к непредвиденным обстоятельствам.

Агенты, использующие иерархическое кодирование контекста (HCC) и надежное управление контекстом, способны к непрерывному совершенствованию своих знаний и адаптации к изменяющимся условиям. Этот подход позволяет им не просто накапливать информацию, но и структурировать её, выявляя взаимосвязи и зависимости, что критически важно для долгосрочной автономии. Благодаря HCC, система может эффективно хранить и извлекать релевантный контекст из прошлого опыта, используя его для принятия более обоснованных решений в настоящем и прогнозирования будущих событий. Такая способность к динамической адаптации позволяет агентам функционировать в сложных и непредсказуемых средах, постоянно улучшая свою производительность и расширяя границы своих возможностей, что является ключевым шагом на пути к созданию действительно интеллектуальных систем.

Разработка ML-Master 2.0 опирается на тщательно продуманный исследовательский план, который направляет процесс обучения и обеспечивает его целенаправленность. Этот план не просто задает последовательность задач, но и определяет критерии оценки прогресса и приоритеты в изучении сложных алгоритмов машинного обучения. Использование структурированного подхода позволяет агенту эффективно накапливать знания, избегая бесцельного перебора вариантов и фокусируясь на наиболее перспективных направлениях. В результате, ML-Master 2.0 демонстрирует повышенную способность к решению сложных задач, требующих не только глубокого понимания принципов машинного обучения, но и умения адаптироваться к новым, неизвестным ранее условиям и данным. Данный план является ключевым фактором, максимизирующим потенциал агента и приближающим его к достижению ультра-долгосрочной автономии.

Разработка ML-Master 2.0 демонстрирует стремление к созданию систем, способных к длительному и самостоятельному обучению. В этом контексте, слова Грейс Хоппер: «Самое лучшее, что можно сделать с временем — это его растратить.» — приобретают особый смысл. Ведь именно способность накапливать и эффективно использовать знания на протяжении длительных периодов, как это реализовано в иерархическом когнитивном кешировании, и есть истинная трата времени с пользой. Сложность, присущая ультра-долгосрочным задачам, требует не только вычислительной мощности, но и умения отсекать несущественное, оставляя лишь ядро необходимой информации. Ясность — это минимальная форма любви к процессу, и в данном случае — к долгосрочному обучению.

Куда Ведет Этот Путь?

Представленная работа, исследуя возможности когнитивного накопления для автономных агентов, лишь осторожно намекает на глубину нерешенных проблем. Эффективное управление когнитивным состоянием в задачах, требующих длительного планирования, — это не просто техническая задача, но и вопрос онтологический. Каким образом агент, лишенный субъективного опыта, может адекватно оценивать релевантность информации, накопленной за длительные периоды? Иллюзия компетентности, порожденная статистической корреляцией, не является истинным пониманием.

Ограничения текущих подходов очевидны. Иерархическое кэширование, как и любая форма упрощения, неизбежно приводит к потере информации. Более того, проблема «когнитивного дрейфа» — постепенной деградации знаний и навыков в отсутствие постоянной обратной связи — остается нерешенной. Вместо того, чтобы стремиться к созданию все более сложных моделей, возможно, стоит обратить внимание на принципы минимализма и элегантности, отбрасывая все избыточное.

Будущие исследования должны быть направлены на разработку методов, позволяющих агентам не только накапливать информацию, но и критически оценивать ее достоверность и релевантность. Необходимо найти способы преодолеть разрыв между статистическими моделями и истинным пониманием, между информацией и знанием. Возможно, истинный прогресс заключается не в увеличении вычислительной мощности, а в развитии более глубокого понимания природы интеллекта.

Оригинал статьи: https://arxiv.org/pdf/2601.10402.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовые нейросети на службе нефтегазовых месторождений

- Функциональные поля и модули Дринфельда: новый взгляд на арифметику

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовый скачок: от лаборатории к рынку

- Квантовые симуляторы: проверка на прочность

2026-01-17 11:28