Автор: Денис Аветисян

В статье рассматривается, как генеративные модели искусственного интеллекта меняют процессы разработки программного обеспечения для встраиваемых систем и с какими сложностями сталкиваются разработчики.

Анализ возникающих практик и вызовов, связанных с интеграцией генеративного ИИ в CI/CD пайплайны для встраиваемых систем, с акцентом на обеспечение надежности и отслеживаемости.

Несмотря на стремительное развитие генеративного искусственного интеллекта, его внедрение в критически важные и ресурсоограниченные системы встраиваемого программного обеспечения сопряжено с уникальными трудностями. В данной работе, ‘Agentic Pipelines in Embedded Software Engineering: Emerging Practices and Challenges’, представлен качественный анализ опыта десяти экспертов из четырех компаний, оценивающих возможности ИИ-аугментированной разработки. Выявлены одиннадцать перспективных практик и четырнадцать проблем, связанных с оркестровкой, ответственностью и устойчивым внедрением генеративных инструментов. Смогут ли команды разработчиков встраиваемого ПО успешно адаптировать свои рабочие процессы и инфраструктуру для создания надежных и отслеживаемых “агентных конвейеров” нового поколения?

Безопасность превыше всего: вызовы критически важных систем

В таких критически важных отраслях, как автомобилестроение и авиакосмическая промышленность, разработка программного обеспечения подчиняется строгим нормативным требованиям, таким как ISO-26262, DO-178C и IEC-61508. Эти стандарты направлены на обеспечение функциональной безопасности, то есть на предотвращение опасных отказов, которые могут привести к травмам или гибели людей. Они охватывают все этапы жизненного цикла программного обеспечения — от разработки требований и проектирования до реализации, тестирования и сопровождения. Строгое соблюдение этих стандартов требует документирования всех процессов, проведения тщательного анализа рисков и применения разнообразных методов верификации и валидации, что гарантирует надежность и предсказуемость программного обеспечения в условиях эксплуатации.

В сферах, где от безотказной работы программного обеспечения зависят жизни людей, таких как автомобильная промышленность и авиастроение, существующие стандарты безопасности, включая ISO-26262, DO-178C и IEC-61508, требуют чрезвычайно тщательного тестирования и верификации. Однако, с ростом объемов и сложности программного кода, этот процесс становится экспоненциально более трудоемким и дорогостоящим. Каждая новая функция, каждое изменение в коде требует повторной и всесторонней проверки, что приводит к увеличению временных затрат и финансовых ресурсов, необходимых для обеспечения безопасности. Более того, сложность современных систем означает, что тестирование не может охватить все возможные сценарии, создавая потенциальные риски и требуя постоянного совершенствования методик верификации.

Внедрение искусственного интеллекта (ИИ) в системы, критичные к безопасности, такие как автомобильные или авиационные, открывает возможности для автоматизации процессов разработки и повышения эффективности. Однако, традиционные методы верификации и подтверждения надежности, основанные на детерминированном поведении программного обеспечения, сталкиваются с серьезными трудностями применительно к ИИ. Алгоритмы машинного обучения, по своей природе вероятностные, часто демонстрируют непредсказуемое поведение в крайних или необычных ситуациях, что создает риски для безопасности. Обеспечение предсказуемости, детерминированности и возможности формальной верификации для систем на базе ИИ становится ключевой задачей, требующей разработки новых подходов и инструментов, способных гарантировать надежность и безопасность в критических сценариях эксплуатации.

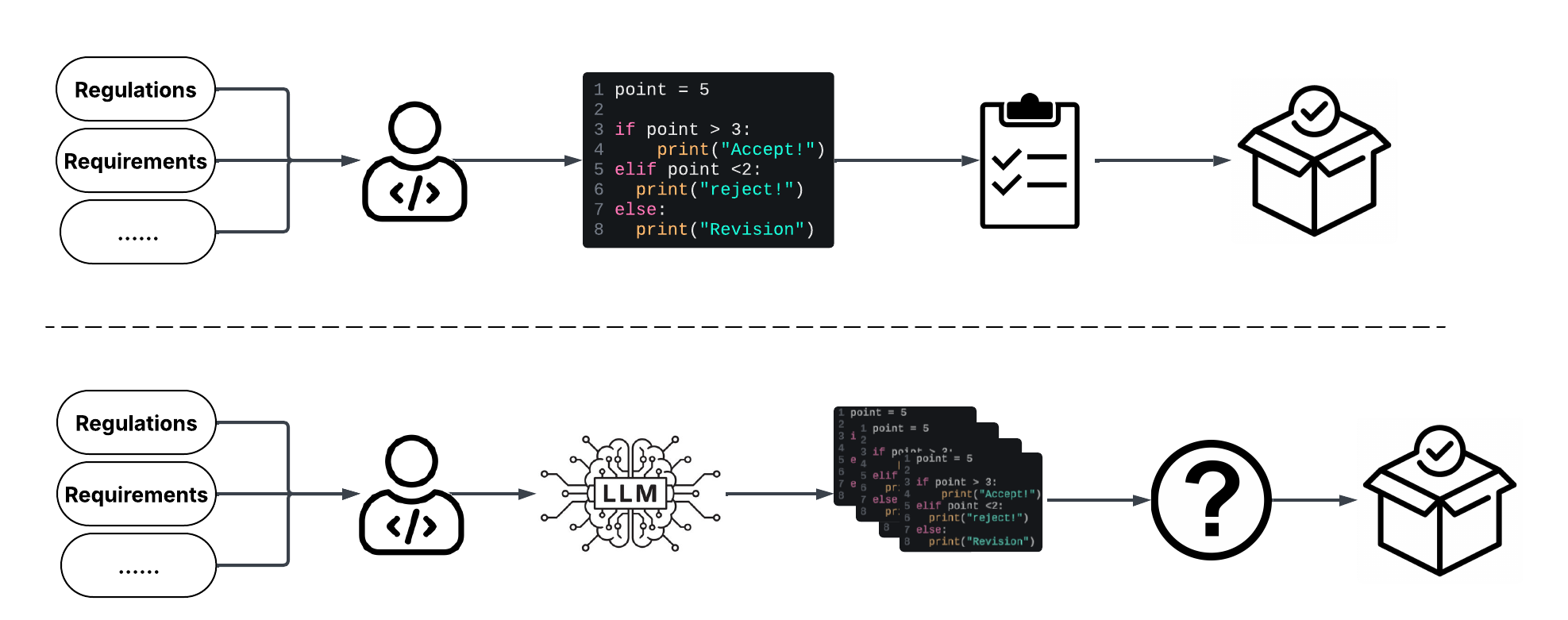

ИИ как инструмент: новая парадигма разработки

Генеративный искусственный интеллект, основанный на больших языковых моделях (LLM) таких как GPT-5, Claude 3, Gemini 2 и Sonnet 4.5, предоставляет возможности для автоматизации генерации кода и ускорения разработки программного обеспечения. Эти модели, обученные на огромных объемах данных, способны создавать фрагменты кода, целые функции и даже базовые структуры приложений на основе текстовых запросов или спецификаций. Автоматизация позволяет разработчикам сосредоточиться на более сложных задачах, таких как проектирование архитектуры и тестирование, что потенциально сокращает время выхода продукта на рынок и снижает затраты на разработку. Важно отметить, что сгенерированный код требует проверки и адаптации, однако LLM значительно повышают производительность в рутинных задачах кодирования.

Агентические системы разработки программного обеспечения, использующие многоагентные конвейеры CI/CD, позволяют оркестрировать сложные задачи и обеспечивают совместную работу над проектами. В рамках такой архитектуры, отдельные агенты, представляющие собой специализированные модули, отвечают за конкретные этапы разработки — от написания тестов и анализа кода до развертывания и мониторинга. Взаимодействие между агентами осуществляется посредством стандартизированных интерфейсов и протоколов обмена данными, что позволяет автоматизировать сложные рабочие процессы и повысить эффективность разработки. Многоагентные системы обеспечивают параллельное выполнение задач, динамическое распределение ресурсов и адаптацию к изменяющимся требованиям проекта, что существенно ускоряет процесс разработки и снижает вероятность ошибок.

Для полноценной реализации потенциала ИИ в разработке программного обеспечения необходимы надежные механизмы контроля и валидации генерируемого ИИ кода. Это включает в себя автоматизированные тесты, статический анализ и, возможно, ручную проверку критически важных участков. Существующие процессы разработки должны быть адаптированы для интеграции ИИ-инструментов, что подразумевает изменение подходов к планированию, тестированию и развертыванию. Важно учитывать, что ИИ-генерируемый код может содержать ошибки или уязвимости, поэтому необходима стратегия их обнаружения и устранения, а также пересмотр практик обеспечения качества.

Доверие к ИИ: верификация и контроль

Непосредственный контроль со стороны человека является критически важным этапом проверки кода, генерируемого искусственным интеллектом, и обеспечения его соответствия стандартам безопасности. Этот процесс предполагает, что квалифицированные разработчики анализируют и подтверждают правильность, эффективность и безопасность предложенного ИИ кода перед его интеграцией в производственную среду. Человеческий фактор необходим для выявления и исправления потенциальных ошибок, которые могут быть пропущены автоматизированными системами проверки, особенно в сложных сценариях или при работе с критически важным программным обеспечением. Такой контроль помогает гарантировать, что генерируемый код соответствует заданным требованиям, не содержит уязвимостей и функционирует предсказуемо в различных условиях эксплуатации.

Обратная связь от компилятора в процессе генерации кода искусственным интеллектом позволяет выявлять и корректировать потенциальные ошибки на ранних стадиях разработки. Данный подход предполагает интеграцию компилятора непосредственно в цикл генерации, где он анализирует сгенерированный код на предмет синтаксических, семантических и логических ошибок. В случае обнаружения несоответствий, компилятор предоставляет информацию об ошибке, которая используется для уточнения или перегенерации кода ИИ. Это позволяет значительно повысить качество и надежность сгенерированного кода, снизить количество ошибок, требующих ручного исправления, и ускорить процесс разработки. Автоматизированная проверка компилятором является особенно эффективной для выявления ошибок, связанных с типами данных, использованием памяти и соблюдением стандартов кодирования.

Управление запросами и протокол контекста модели предоставляют механизмы для контроля поведения больших языковых моделей (LLM) и обеспечения согласованности и предсказуемости их результатов. Это достигается посредством структурирования входных данных (запросов) таким образом, чтобы они однозначно определяли требуемый формат и содержание ответа. Протокол контекста модели включает в себя определение и передачу LLM релевантной информации о задаче, ограничениях и ожидаемых результатах, что позволяет снизить вероятность нежелательных или неточных ответов. В частности, использование четких инструкций, примеров и ограничений в запросах, а также предоставление LLM доступа к необходимой базе знаний, значительно повышает надежность и управляемость генерируемого контента.

Оптимизация структуры кода и документации для облегчения интерпретации языковыми моделями (LLM) повышает качество и надежность разработки с использованием ИИ. Такие “AI-friendly” артефакты включают использование четких, структурированных комментариев, единообразного форматирования кода, и подробной документации API. Специальная организация данных, например, использование JSON или YAML для конфигурационных файлов, упрощает извлечение информации LLM. Кроме того, разбиение сложных задач на более мелкие, модульные компоненты, с четко определенными интерфейсами, позволяет LLM более эффективно генерировать и понимать код. Использование стандартизированных шаблонов и соглашений о кодировании также способствует улучшению интерпретируемости и уменьшению количества ошибок.

Будущее безопасной разработки с ИИ

Необходимость программ переподготовки и повышения квалификации инженеров становится критически важной в связи с переходом к рабочим процессам, дополненным искусственным интеллектом. В условиях, когда инструменты автоматической генерации кода, такие как GitHub Copilot и Amazon CodeWhisperer, все шире внедряются в практику разработки, инженерам требуется освоить новые навыки, связанные с проверкой, валидацией и интеграцией сгенерированного ИИ-кода. Успешное применение этих технологий требует не просто знания языков программирования, но и понимания принципов работы моделей машинного обучения, а также способности эффективно взаимодействовать с ИИ-ассистентами для достижения оптимальных результатов. Вложения в обучение и развитие инженерного состава представляются не просто желательными, но и необходимыми для обеспечения безопасности, надежности и эффективности будущих систем, создаваемых с использованием искусственного интеллекта.

Автоматизированные инструменты генерации кода, такие как GitHub Copilot и Amazon CodeWhisperer, работающие на базе генеративных моделей искусственного интеллекта, становятся все более распространенными в современной разработке программного обеспечения. Эти системы способны предлагать фрагменты кода, завершать строки и даже генерировать целые функции на основе контекста и комментариев, что значительно ускоряет процесс кодирования. В перспективе, ожидается, что подобные инструменты не просто облегчат рутинные задачи, но и позволят разработчикам сосредоточиться на более сложных аспектах проектирования и тестирования, повышая общую производительность и качество программного обеспечения, особенно в областях, требующих высокой надежности и безопасности.

Переход к новым методам разработки, основанным на искусственном интеллекте, сулит значительное сокращение сроков создания программного обеспечения, используемого в критически важных системах. Автоматизация рутинных задач и генерация кода при помощи ИИ не только снижает затраты на разработку, но и потенциально повышает надежность и безопасность конечного продукта. Благодаря ИИ-инструментам, инженеры смогут сосредоточиться на более сложных аспектах проектирования и тестирования, что приведет к уменьшению количества ошибок и уязвимостей. В результате, системы, отвечающие за безопасность и функционирование критической инфраструктуры, смогут разрабатываться быстрее, дешевле и с более высоким уровнем доверия.

В будущем разработка критически важных систем с использованием искусственного интеллекта невозможна без центрального внимания к человеческому фактору. Подход, объединяющий сильные стороны ИИ — скорость и способность обрабатывать огромные объемы данных — с опытом и критическим мышлением инженеров, представляется ключевым для создания надежных и безопасных систем. Искусственный интеллект способен автоматизировать рутинные задачи и предлагать варианты решений, однако именно человек несет ответственность за проверку, валидацию и принятие окончательных решений, особенно в контексте безопасности. Такое сотрудничество позволит не только минимизировать риски, связанные с ошибками или непредвиденными ситуациями, но и обеспечит более глубокое понимание и контроль над сложными системами, гарантируя их соответствие высоким стандартам надежности и безопасности.

Исследование показывает, что внедрение генеративного ИИ в процессы разработки встраиваемого ПО, особенно в CI/CD пайплайны, неизбежно ведет к переосмыслению существующих подходов к обеспечению надежности и отслеживаемости. Авторы статьи справедливо отмечают, что традиционные методы контроля качества зачастую оказываются неэффективными в условиях динамично меняющегося кода, генерируемого ИИ. В этой связи, представляется уместным вспомнить слова Бертрана Рассела: «Страх — это следствие невежества». Подобно тому, как невежество порождает страх перед неизведанным, непонимание принципов работы генеративных моделей может привести к необоснованным опасениям относительно их надежности. Осознание ограничений и возможностей ИИ, а также разработка новых механизмов контроля качества, основанных на принципах «человек в цикле», представляются ключевыми задачами для успешной интеграции генеративного ИИ во встраиваемые системы.

Что дальше?

Предположим, что генеративные модели действительно интегрированы в конвейеры разработки встраиваемого программного обеспечения. Что произойдёт, если отказаться от строгой прослеживаемости? Если рассматривать артефакты, созданные искусственным интеллектом, как «чёрные ящики», полагаясь исключительно на тестирование, а не на понимание логики их работы? Вероятно, возникнет хрупкая система, способная демонстрировать впечатляющие результаты в идеальных условиях, но непредсказуемая в реальной эксплуатации. Потребуется переосмысление понятия «отладки» — не поиск ошибок в коде, а понимание логики принятия решений нейронной сетью, что само по себе является задачей, граничащей с искусством.

Внедрение протокола контекста модели — лишь первый шаг. Следующим этапом станет разработка механизмов, позволяющих искусственному интеллекту самостоятельно выявлять и устранять неоднозначности в требованиях. Что, если система, созданная искусственным интеллектом, начнет оспаривать спецификации, предлагая более эффективные или безопасные решения? Такой сценарий потребует не только технической реализации, но и изменения самой культуры разработки — готовности инженеров воспринимать критику от машины.

В конечном счете, вопрос заключается не в том, сможет ли искусственный интеллект автоматизировать разработку встраиваемого программного обеспечения, а в том, как изменится роль инженера в этом процессе. Переход от написания кода к управлению искусственным интеллектом, от отладки к валидации — это не просто смена инструментов, это переоценка ценностей, требующая нового подхода к обучению и профессиональному развитию. Иначе, рискуем создать систему, которую не сможем ни понять, ни контролировать.

Оригинал статьи: https://arxiv.org/pdf/2601.10220.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовый скачок: от лаборатории к рынку

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

2026-01-18 05:56