Автор: Денис Аветисян

Новое исследование показывает, что предоставление пользователям фактических доказательств вместе с объяснениями от систем искусственного интеллекта значительно повышает доверие к проверке фактов и точность оценок.

Оценка роли доказательств и понятных объяснений в системах проверки фактов, основанных на больших языковых моделях.

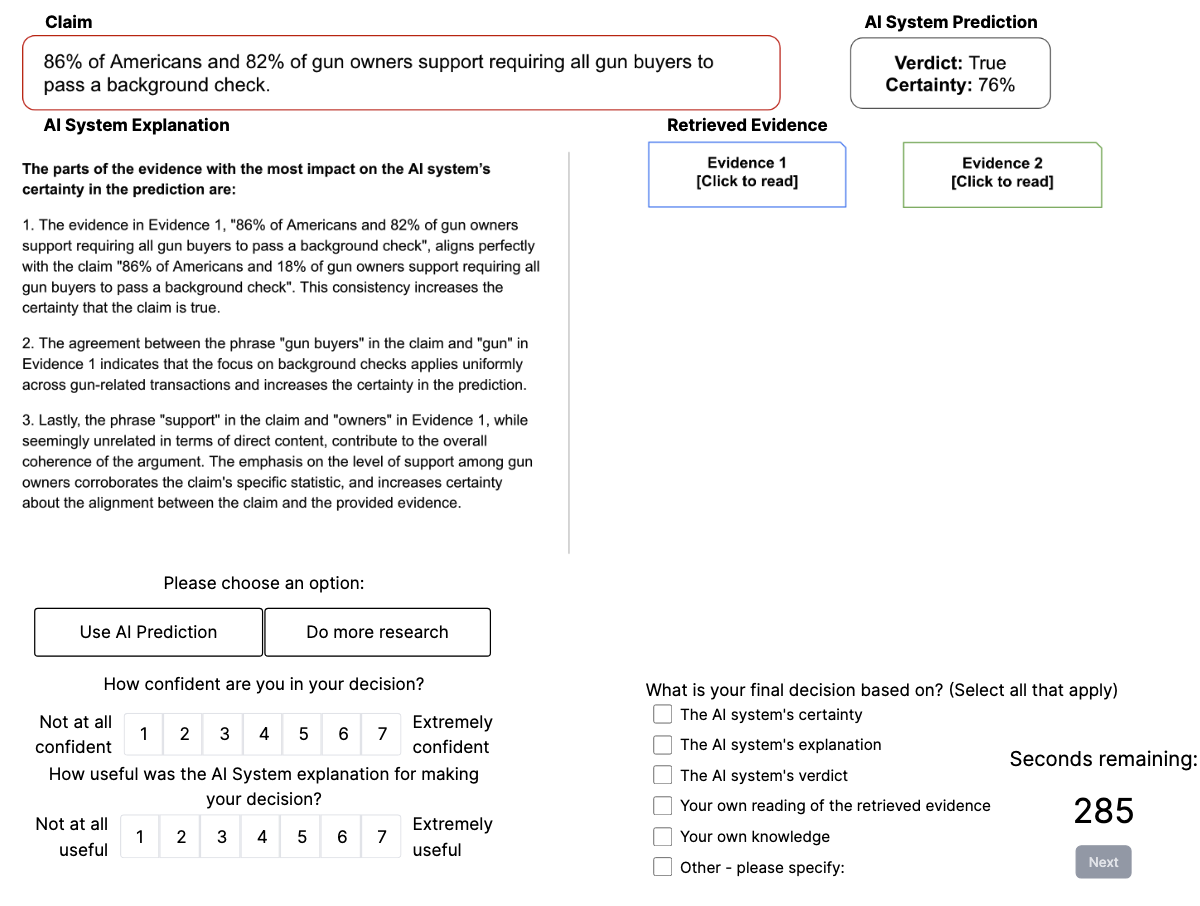

Несмотря на активное развитие систем искусственного интеллекта, поддерживающих проверку фактов, роль фактических доказательств в принятии решений пользователями остается недостаточно изученной. В своей работе ‘Show me the evidence: Evaluating the role of evidence and natural language explanations in AI-supported fact-checking’ исследователи систематически оценивали влияние типа объяснений ИИ, уверенности предсказаний и доступности доказательств на оценку достоверности утверждений неэкспертами. Полученные результаты показали, что участники последовательно полагались на доказательства для валидации утверждений ИИ, даже при наличии лингвистических объяснений, которые использовались реже или игнорировались при их недостаточной убедительности. Как оптимально представить доказательства и какие стратегии взаимодействия с ними наиболее эффективны для повышения доверия к системам ИИ?

Иллюзия Знания: Рост ИИ и Риск Бездумного Доверия

В последние годы наблюдается стремительный рост использования больших языковых моделей (БЯМ) в задачах проверки фактов и верификации информации. Эти модели, обладающие способностью анализировать огромные объемы данных с высокой скоростью, предоставляют беспрецедентные возможности для автоматизации процесса выявления недостоверных сведений. Скорость и масштабируемость БЯМ позволяют обрабатывать информацию, которая ранее требовала значительных временных и трудовых затрат, что делает их незаменимым инструментом для новостных агентств, социальных сетей и других организаций, стремящихся бороться с дезинформацией. В отличие от традиционных методов, основанных на ручной проверке, БЯМ способны выявлять закономерности и противоречия в текстах, а также сопоставлять информацию из различных источников практически мгновенно.

Растущая зависимость от искусственного интеллекта, особенно в таких областях, как проверка фактов и анализ данных, несёт в себе значительный риск — автоматическое принятие рекомендаций без должной критической оценки. Исследования показывают, что пользователи склонны доверять выводам, предоставленным алгоритмами, даже если эти выводы содержат ошибки или не учитывают все аспекты ситуации. Эта тенденция, известная как чрезмерная зависимость от ИИ, может привести к снижению способности к самостоятельному мышлению и принятию обоснованных решений, а также к распространению недостоверной информации. В результате, критически важные процессы, основанные на анализе данных, могут быть подвержены искажениям и неточностям, что требует разработки эффективных механизмов контроля и перепроверки.

Неконтролируемое усиление зависимости от искусственного интеллекта в процессе проверки фактов и принятия решений несет в себе риск подрыва доверия к информации в целом. Если рекомендации, генерируемые алгоритмами, принимаются без критической оценки и перепроверки, способность человека к независимому мышлению и анализу постепенно ослабевает. Это может привести к ситуации, когда общество становится уязвимым к дезинформации и манипуляциям, а процессы принятия решений — менее обоснованными и эффективными. Сохранение критического подхода к информации, даже той, что представлена как результат работы искусственного интеллекта, становится ключевым фактором для поддержания надежности информационного пространства и обеспечения ответственного использования новых технологий.

Оценивающий ИИ: От «Чёрного Ящика» к Прозрачности Доказательств

Оценивающий ИИ (Evaluative AI) представляет собой принципиально новый подход к предоставлению информации, смещающий акцент с простой выдачи заключений на демонстрацию доказательной базы и логики, лежащей в основе этих заключений. В отличие от традиционных систем, которые оперируют только результатами, оценивающий ИИ предоставляет пользователю возможность ознакомиться с исходными данными и процессом рассуждений, что позволяет самостоятельно оценить обоснованность и достоверность полученных выводов. Этот переход от «черного ящика» к прозрачной системе способствует повышению доверия к результатам работы ИИ и позволяет использовать его не как замену эксперту, а как инструмент для поддержки принятия решений.

В рамках подхода, основанного на оценочном ИИ, ключевым элементом является представление доказательств, позволяющее пользователям проводить независимую верификацию информации. Согласно проведенному исследованию, пользователи открывали документы-источники в 67% случаев, что демонстрирует выраженное предпочтение прямой проверки исходных материалов. Данный результат подтверждает важность предоставления доступа к доказательствам для повышения доверия к выводам, сделанным искусственным интеллектом, и позволяет пользователям самостоятельно оценить обоснованность представленных аргументов.

Критически важным аспектом работы ИИ является четкое указание на достоверность используемых источников информации. Вывод ИИ должен сопровождаться данными о надежности источников, включая, например, рейтинги авторитетности, дату публикации и тип источника (научная статья, новостное агентство, официальный документ и т.д.). Недостаточное внимание к этому вопросу может привести к распространению недостоверной информации и снижению доверия к системам ИИ. Прозрачность в отношении источников позволяет пользователям самостоятельно оценивать обоснованность выводов и принимать обоснованные решения на основе предоставленной информации.

Неуверенность как Инструмент: Коммуникация Ограничений ИИ

Простая демонстрация доказательств недостаточна для эффективного взаимодействия с ИИ; системы искусственного интеллекта должны также передавать степень своей уверенности посредством коммуникации неопределенности. Это необходимо для того, чтобы пользователи могли адекватно оценивать надежность предоставляемой информации и принимать обоснованные решения. Отсутствие информации об уровне уверенности может привести к чрезмерному доверию к ошибочным выводам ИИ или, наоборот, к необоснованному игнорированию полезных предложений. Эффективная коммуникация неопределенности позволяет пользователям учитывать риски и принимать решения, соответствующие их потребностям и контексту.

Для передачи уровня уверенности в своих выводах, системы искусственного интеллекта могут использовать количественную оценку неопределенности (Numerical_Uncertainty), представляя уверенность в виде числовых значений. В проведенных тестах диапазон этих значений составлял от 35% до 78%, в зависимости от конкретного утверждения. Дополнительно, для обеспечения прозрачности, необходимо предоставлять объяснения на естественном языке (Natural_Language_Explanations), содержащие четкие и понятные пользователю обоснования сделанных выводов. Сочетание численной оценки и текстового объяснения позволяет пользователям более адекватно оценивать надежность информации, предоставляемой системой.

Исследования показали, что использование метода когнитивного принуждения, заключающегося в предложении пользователям сформулировать собственные прогнозы до ознакомления с ответом ИИ, способствует более критическому взаимодействию с системой. Важно отметить, что тип предоставляемого объяснения — ориентированный на конечный результат или на степень неопределенности — не оказал существенного влияния на степень доверия к советам ИИ или на использование предоставленной информации. Полученные данные свидетельствуют о том, что стимулирование предварительной оценки информации пользователем является более эффективным фактором, чем способ представления объяснений ИИ.

Реальные Вызовы: Применение Доверенного ИИ в Сложных Вопросах

Применение искусственного интеллекта к острым социальным вопросам, таким как воздействие микропластика, экономическая нестабильность или права на аборт, требует особого подхода, основанного на принципах оценочного ИИ и прозрачной коммуникации. Важно не просто предоставлять результаты анализа, но и демонстрировать методологию, используемые данные и степень неопределенности, связанную с выводами. Прозрачность позволяет гражданам критически оценивать информацию, понимать ее ограничения и формировать собственное обоснованное мнение, а оценочный ИИ гарантирует, что алгоритмы и модели не усиливают предвзятости или искажения. Только при таком подходе искусственный интеллект может стать инструментом для конструктивного диалога и ответственного принятия решений в чувствительных сферах.

Исследования показывают, что предоставление чётких доказательств в сочетании с признанием неизбежной неопределённости способствует развитию критического мышления у людей. Вместо того, чтобы представлять информацию как абсолютную истину, важно указывать на ограничения данных и возможные альтернативные интерпретации. Такой подход позволяет индивидуумам самостоятельно оценивать представленные факты, сопоставлять их с собственным опытом и формировать обоснованные мнения. Прозрачное обозначение степени достоверности информации, а также указание на пробелы в знаниях, не только повышает доверие к источнику, но и стимулирует дальнейшее исследование и более глубокое понимание сложных вопросов. В конечном итоге, подобная стратегия способствует развитию ответственного принятия решений, основанного на критическом анализе, а не на слепом следовании авторитетам.

Приоритет прозрачности и возможности проверки данных позволяет искусственному интеллекту стать мощным инструментом для укрепления общественного доверия и содействия ответственному принятию решений. Когда алгоритмы и источники информации становятся доступными для изучения, пользователи могут самостоятельно оценивать достоверность результатов и понимать, как принимаются те или иные выводы. Такой подход особенно важен в областях, где решения могут иметь серьезные последствия, будь то оценка рисков для здоровья, финансовые прогнозы или социальные вопросы. Предоставление чёткой информации о принципах работы ИИ и ограничениях его возможностей позволяет избежать необоснованных ожиданий и способствует формированию критического мышления. В конечном итоге, прозрачность и верифицируемость не просто повышают надежность искусственного интеллекта, но и способствуют его более широкому и ответственному внедрению в различные сферы жизни.

Исследование демонстрирует, что доступность подтверждающих данных играет ключевую роль в формировании обоснованных суждений. Этот аспект перекликается с убеждением Тима Бернерса-Ли: «Данные — это новый нефть». В контексте проверки фактов, представленные доказательства служат не просто подтверждением, но и основой для критического осмысления информации. Отсутствие прозрачности в отношении источников и обоснований подрывает доверие к системам искусственного интеллекта, а доступ к первичным данным позволяет пользователям самостоятельно оценивать достоверность утверждений, что крайне важно для повышения точности и обоснованности принимаемых решений.

Что дальше?

Представленные данные, как и следовало ожидать, лишь обнажили глубинную проблему: недостаточно просто объяснить что-либо, необходимо предоставить возможность проверить это. Система, требующая инструкций по проверке, уже проиграла. Попытки заставить языковые модели «рассуждать» без опоры на проверяемые свидетельства — это, по сути, усложнение простоты, а это всегда — ошибка. Вместо гонки за все более изощренными алгоритмами, возможно, стоит сосредоточиться на радикальном упрощении: на представлении данных в наиболее доступной и недвусмысленной форме.

Очевидным направлением дальнейших исследований является изучение форматов представления доказательств. Не всякая «поддержка» одинаково ценна; необходимо понять, какие типы свидетельств наиболее эффективно повышают точность оценок и, что не менее важно, — снижают излишнюю уверенность в ложных утверждениях. Понятность — это вежливость, и в данном контексте — необходимость. Важно помнить, что цель — не убедить, а предоставить инструменты для самостоятельной оценки.

И, наконец, стоит задуматься о фундаментальном вопросе: какова истинная цель автоматической проверки фактов? Не в создании «всезнающего» алгоритма, а в развитии критического мышления у пользователей. Сложность — это тщеславие; ясность — милосердие. И, возможно, именно в этом парадоксе и кроется ключ к решению проблемы.

Оригинал статьи: https://arxiv.org/pdf/2601.11387.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Укрощение шума: как оптимизировать квантовые алгоритмы

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовая химия: моделирование сложных молекул на пороге реальности

- Квантовые симуляторы: проверка на прочность

2026-01-19 07:17