Автор: Денис Аветисян

Исследование показывает, как вдохновение из физики и экологии позволяет создавать более компактные и производительные нейронные сети.

Открытие нейро-символических активаций с использованием генетического программирования для повышения эффективности и переноса знаний между научными областями.

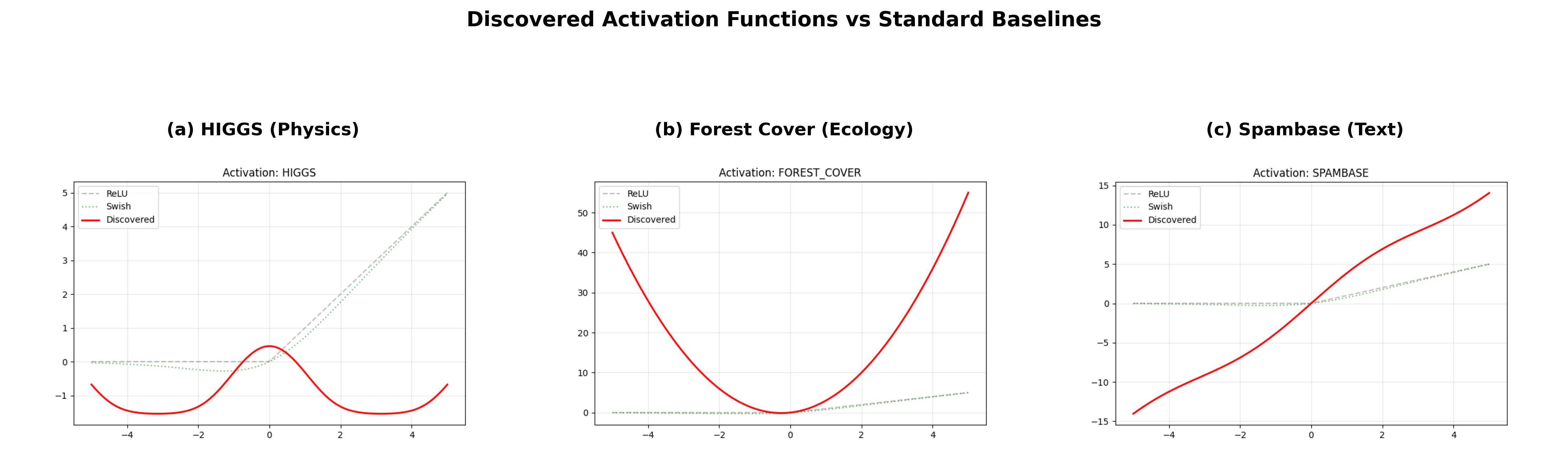

Современные нейронные сети, как правило, полагаются на универсальные функции активации, игнорируя при этом математическую структуру, присущую научным данным. В работе «Neuro-Symbolic Activation Discovery: Transferring Mathematical Structures from Physics to Ecology for Parameter-Efficient Neural Networks» предложен фреймворк, использующий генетическое программирование для извлечения интерпретируемых математических формул и внедрения их в качестве пользовательских функций активации. Ключевым результатом стало обнаружение феномена геометрического переноса: функции активации, обученные на данных физики частиц, успешно обобщаются для классификации экологических данных, превосходя стандартные активации по точности и эффективности параметров. Открывает ли это путь к созданию специализированных библиотек активаций для эффективного научного машинного обучения и сможет ли этот подход быть применен к другим, казалось бы, несвязанным областям науки?

За пределами «Черных Ящиков»: Ограничения Традиционных Функций Активации

Традиционные функции активации, такие как ReLU и GELU, несмотря на широкое распространение в нейронных сетях, зачастую демонстрируют ограниченную способность к моделированию сложных взаимосвязей, присущих разнообразным наборам данных. Эти функции, хотя и эффективны в определенных сценариях, могут упрощать нелинейности, что приводит к потере информации и снижению точности при работе с данными, обладающими высокой степенью сложности или неоднородности. Например, в задачах обработки изображений с большим количеством деталей или в задачах анализа естественного языка, где контекст играет ключевую роль, ограниченная выразительность этих функций может стать серьезным препятствием для достижения оптимальной производительности. В результате, нейронные сети, использующие ReLU или GELU, могут требовать больше параметров для достижения аналогичного уровня точности по сравнению с сетями, использующими более гибкие функции активации, что негативно сказывается на эффективности и масштабируемости моделей.

Ограниченная гибкость традиционных функций активации оказывает существенное влияние на эффективность переноса знаний между различными областями данных. Когда нейронная сеть обучается на одном наборе данных, а затем применяется к другому, отличающемуся распределением, неспособность функции активации адекватно адаптироваться к новым условиям приводит к снижению производительности. Более того, данная негибкость требует большего количества параметров для достижения аналогичного уровня точности, поскольку сеть вынуждена компенсировать недостаток выразительности функции активации за счет увеличения сложности модели. Это, в свою очередь, увеличивает вычислительные затраты и потребление памяти, ограничивая возможности создания компактных и эффективных нейронных сетей, способных к обобщению и адаптации к новым задачам.

Поиск более выразительных функций активации является ключевым фактором в создании надежных и адаптируемых архитектур нейронных сетей. Традиционные функции, такие как ReLU и GELU, зачастую демонстрируют ограниченность в способности моделировать сложные взаимосвязи в разнообразных наборах данных. Это препятствует эффективному переносу знаний между различными областями применения и ограничивает потенциал для повышения параметрической эффективности моделей. Разработка новых функций активации, способных к более тонкой настройке и моделированию нелинейностей, открывает путь к созданию искусственного интеллекта, способного к более гибкому обучению и адаптации к изменяющимся условиям, что особенно важно для решения сложных задач в областях, требующих высокой точности и надежности.

Нейро-Символическое Открытие Активаций: Новый Подход

Представлен фреймворк для открытия нейро-символических функций активации, использующий возможности генетического программирования для эволюции функций, специфичных для конкретной предметной области. Фреймворк автоматически генерирует и оптимизирует выражения, представляющие собой функции активации, посредством применения генетических алгоритмов к популяции символических выражений. Эти выражения могут включать в себя математические операции и переменные, определяемые входными данными нейронной сети. Процесс эволюции направлен на максимизацию производительности нейронной сети на заданном наборе данных, что позволяет создавать функции активации, адаптированные к особенностям решаемой задачи и превосходящие по эффективности традиционные, предопределенные функции.

Данный подход объединяет способность нейронных сетей к обучению с интерпретируемостью и выразительностью символьных выражений. Традиционные нейронные сети, хотя и эффективны в решении сложных задач, часто рассматриваются как «черные ящики» из-за сложности анализа их внутренних механизмов. Использование символьных выражений, напротив, позволяет представить логику работы сети в виде понятных, проверяемых правил. Комбинирование этих двух подходов позволяет получить модели, которые не только демонстрируют высокую производительность, но и предоставляют возможность анализа и верификации их работы, что особенно важно для критически важных приложений, где требуется прозрачность и надежность. f(x) = a*x + b — пример простого символьного выражения, которое может быть частью более сложной функции активации, генерируемой в рамках данной системы.

Автоматизация проектирования функций активации направлена на повышение производительности и обобщающей способности нейронных сетей. Традиционно, функции активации задаются вручную и являются фиксированными для всех слоев сети. Использование генетического программирования для эволюции функций активации позволяет адаптировать их к конкретным задачам и данным, что потенциально приводит к более эффективному обучению и улучшенной способности к обобщению на новых, ранее не встречавшихся данных. Такой подход позволяет исследовать пространство функций активации, выходящее за рамки стандартных вариантов, таких как ReLU или sigmoid, и находить оптимальные решения, улучшающие точность и скорость сходимости обучения.

Гибридная Архитектура для Повышенной Производительности

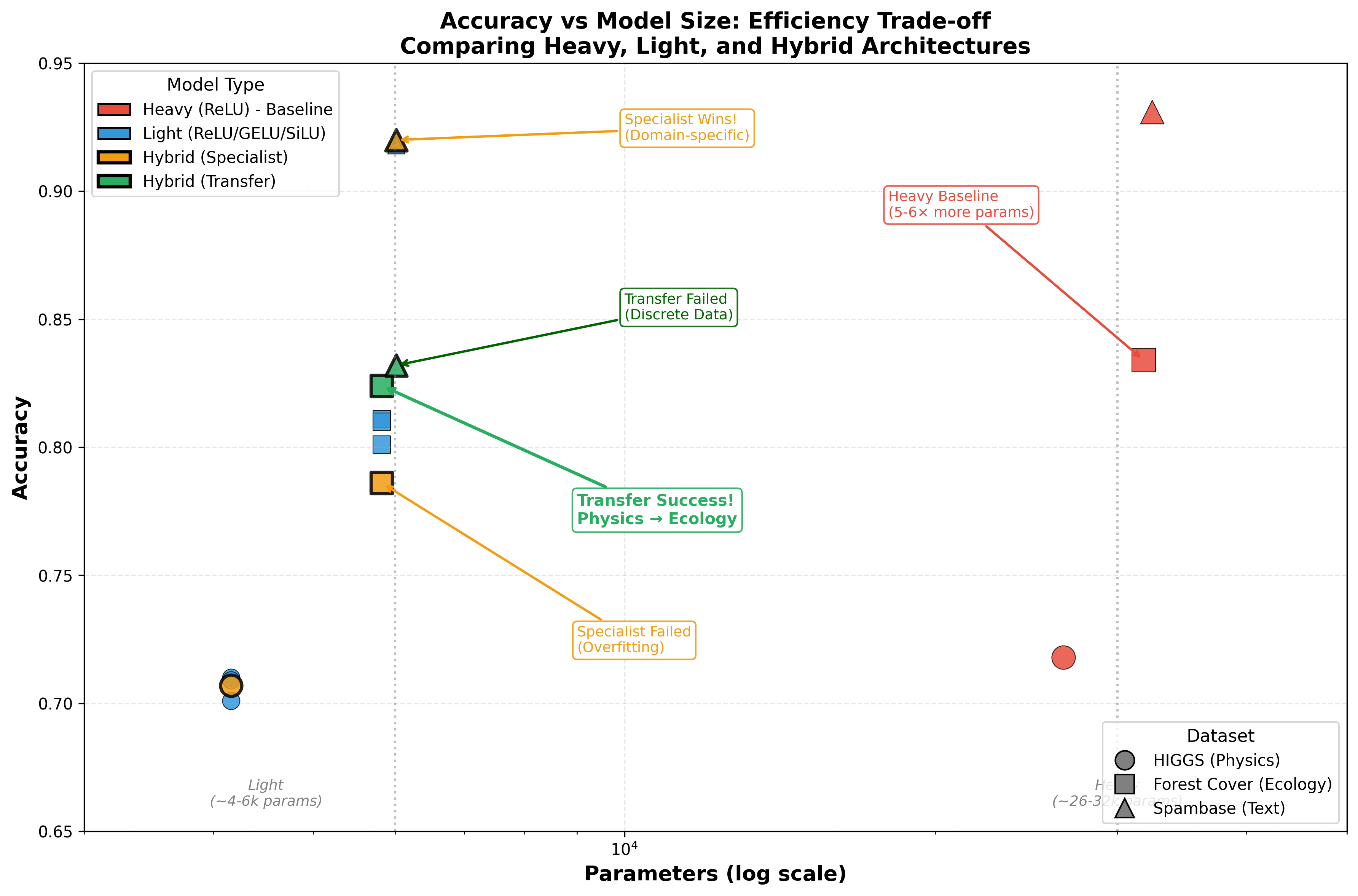

Экспериментальные исследования показали, что гибридная архитектура, включающая разработанные функции активации, демонстрирует стабильное превосходство над моделями, использующими стандартные функции активации. Результаты, полученные на различных наборах данных, включая данные из области физики частиц, данные о лесных массивах и базу данных спама, указывают на устойчивый прирост производительности. В частности, в задачах классификации данных о лесных массивах, применение данного подхода позволило достичь точности в 82.4%, превосходя показатели моделей, использующих ReLU (81.1%) и GELU (81.0%), при этом обеспечивая значительное сокращение количества параметров по сравнению с традиционными «тяжелыми» сетями.

В ходе экспериментов была зафиксирована значительная оптимизация параметрической эффективности предложенной архитектуры. По результатам тестирования, наблюдается увеличение эффективности использования параметров на 18-21% и снижение общего числа параметров в 5-6 раз по сравнению с традиционными, более «тяжелыми» нейронными сетями. Данное улучшение позволяет создавать более компактные модели, сохраняя или даже улучшая их производительность, что особенно важно для задач с ограниченными вычислительными ресурсами или требованиями к скорости работы.

Для подтверждения эффективности предложенной гибридной архитектуры проводились эксперименты на разнообразных наборах данных. В частности, использовались данные, полученные в области физики частиц, данные о лесных насаждениях, а также датасет Spambase. Использование различных типов данных позволило оценить общую применимость и устойчивость предложенного подхода к различным задачам и характеристикам данных, демонстрируя его универсальность и потенциал для широкого спектра приложений машинного обучения.

При применении подхода переноса обучения на наборе данных Forest Cover, разработанная гибридная архитектура продемонстрировала точность в 82.4%, превзойдя результаты, полученные с использованием ReLU (81.1%) и GELU (81.0%). При этом, количество параметров в предложенной модели оказалось в 5.5 раза меньше, чем у тяжелой модели, достигшей максимальной точности в 83.4%. Данные результаты подтверждают эффективность предложенной архитектуры в достижении высокой точности при значительном снижении вычислительных затрат.

Использование пакетной нормализации (Batch Normalization) в гибридной архитектуре обеспечивает стабилизацию процесса обучения за счет нормализации активаций на каждом слое. Это снижает внутреннее ковариационное смещение и позволяет использовать более высокие скорости обучения, ускоряя сходимость модели. В результате, пакетная нормализация не только улучшает стабильность обучения, но и повышает общую эффективность гибридной архитектуры, позволяя достичь лучших результатов при меньшем количестве параметров и более высокой скорости сходимости.

Геометрический Перенос и Перспективы Развития

Наблюдается явление, получившее название “геометрический перенос”, которое демонстрирует успешную адаптацию функций активации, разработанных для одного непрерывного набора данных, к совершенно другим непрерывным областям. Это открытие указывает на то, что существует некая базовая геометрическая структура, определяющая эффективность этих функций, и что их производительность не зависит исключительно от специфики конкретного набора данных. Данный феномен предполагает, что функции активации могут быть оптимизированы не для конкретной задачи, а для более общих геометрических свойств данных, что открывает перспективы для создания универсальных и эффективных нейронных сетей, способных к обобщению и адаптации в различных областях применения. По сути, это свидетельствует о том, что существует некая универсальная “геометрия” данных, которую эффективно используют развитые функции активации.

Полученные результаты ставят под сомнение устоявшееся представление о необходимости индивидуальной настройки функций активации для каждого конкретного набора данных. Традиционно считалось, что оптимальная производительность нейронной сети требует тщательной адаптации этих функций к особенностям распределения данных. Однако, обнаруженный феномен геометрического переноса демонстрирует, что функции активации, эволюционировавшие на одном непрерывном наборе данных, успешно обобщаются и на другие, принципиально отличающиеся непрерывные домены. Это указывает на существование базовой геометрической структуры, определяющей эффективность функций активации, и позволяет предположить, что универсальные решения, не зависящие от специфики данных, вполне возможны. Такой подход может существенно упростить процесс разработки и обучения нейронных сетей, снизив потребность в трудоемкой ручной настройке и открыв путь к созданию более адаптивных и эффективных архитектур.

Исследование открывает перспективные направления в автоматизированном проектировании функций активации, что может привести к созданию более эффективных и адаптируемых архитектур нейронных сетей. Традиционно, выбор функции активации требовал тщательной настройки для каждого конкретного набора данных, однако, обнаруженный феномен геометрического переноса позволяет предположить возможность разработки алгоритмов, самостоятельно генерирующих оптимальные функции активации, учитывающие общие геометрические свойства данных. Подобный подход обещает не только упростить процесс разработки нейронных сетей, но и повысить их производительность и обобщающую способность, особенно в задачах, где данные постоянно меняются или поступают из различных источников. Автоматизация проектирования функций активации представляется ключевым шагом к созданию самообучающихся и самооптимизирующихся нейронных сетей нового поколения.

Предстоящие исследования направлены на расширение возможностей обнаруженного геометрического переноса активационных функций и на применение данного подхода к более сложным архитектурам глубоких нейронных сетей. В то время как текущая работа продемонстрировала успешный перенос активаций, эволюционировавших на одном непрерывном наборе данных, к другим непрерывным областям в контексте неглубоких сетей, дальнейшее изучение потенциала в глубоких архитектурах представляется весьма перспективным. Ожидается, что применение принципов геометрического переноса позволит создавать более эффективные и адаптируемые глубокие сети, снижая потребность в специфической настройке активационных функций для каждого конкретного набора данных и, возможно, открывая новые пути к автоматизированному проектированию нейронных сетей.

«`html

Исследование демонстрирует, что применение генетического программирования для обнаружения и внедрения специфичных для предметной области функций активации в нейронные сети способно значительно повысить эффективность моделей. Подход, описанный в работе, успешно переносит математические структуры из физики в экологию, что подтверждает возможность знания между различными научными областями. Тим Бернерс-Ли однажды заметил: «Веб — это не просто набор технологий, а способ думать». Данное утверждение находит отражение в исследовании, поскольку оно показывает, как переосмысление существующих математических концепций и их применение в новой области может привести к инновационным решениям и более эффективным моделям. Успешный трансфер знаний, продемонстрированный в статье, подтверждает важность поиска универсальных принципов, лежащих в основе различных научных дисциплин.

Куда двигаться дальше?

Представленная работа демонстрирует любопытную, хотя и не всегда очевидную, взаимосвязь между, казалось бы, далекими областями знания — физикой и экологией. Успешный перенос математических структур через активационные функции, найденные с помощью генетического программирования, намекает на более глубокий принцип: хорошая архитектура незаметна, пока не ломается, и только тогда видна настоящая цена решений. Однако, текущие подходы ограничены рамками поиска в предопределенном пространстве активационных функций. Следующим шагом представляется разработка методов, позволяющих исследовать принципиально новые типы нелинейностей, возможно, вдохновленные не математикой, а самой структурой данных.

Очевидным вызовом остается масштабируемость предложенного подхода. Эффективный поиск оптимальных активационных функций требует значительных вычислительных ресурсов, особенно при работе с высокоразмерными данными. Необходимо разработать более эффективные алгоритмы оптимизации и, возможно, использовать принципы разреженности и модульности для снижения вычислительной сложности. Более того, вопрос обобщающей способности требует дальнейшего изучения: насколько хорошо перенесенные знания работают в принципиально новых областях, где исходные предположения о структуре данных не выполняются?

В конечном итоге, данное направление исследований указывает на необходимость переосмысления роли активационных функций в нейронных сетях. Вместо того, чтобы рассматривать их как фиксированные компоненты, следует воспринимать их как адаптивные элементы, способные отражать специфику решаемой задачи и, возможно, даже раскрывать скрытые закономерности в данных. В этом смысле, поиск оптимальных активационных функций — это не просто техническая задача, а философское исследование природы информации и знания.

Оригинал статьи: https://arxiv.org/pdf/2601.10740.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Укрощение шума: как оптимизировать квантовые алгоритмы

- Квантовый Борьба: Китай и США на Передовой

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

2026-01-19 10:37