Автор: Денис Аветисян

Новый гибридный квантово-классический алгоритм обеспечивает стабильность и эффективность обучения квантовых нейронных сетей для задач научной машинного обучения.

В статье представлена методика геометрической предварительной обработки и обучения по учебному плану для улучшения обучаемости квантовых регрессионных моделей и смягчения эффекта ‘пустошей’ (barren plateaus).

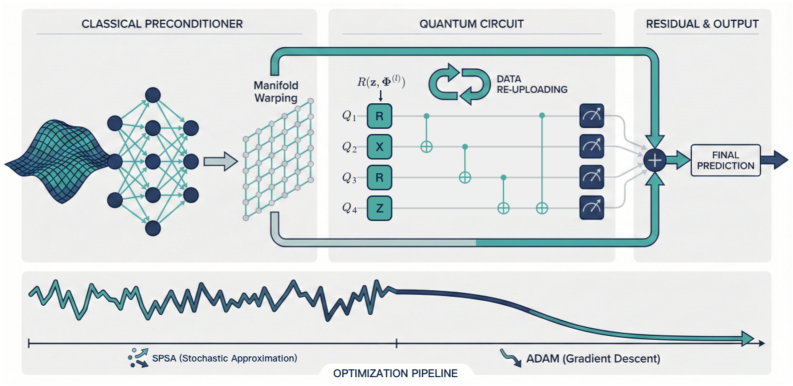

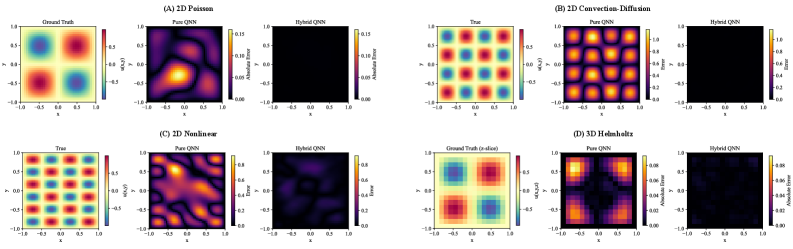

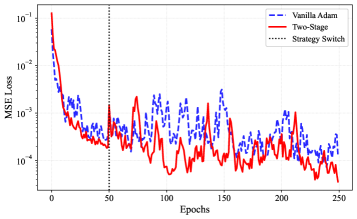

Несмотря на растущий интерес к квантовым нейронным сетям в машинном обучении, их применимость в задачах регрессии часто ограничена проблемами обучаемости, связанными с зашумленными градиентами и плохо обусловленностью оптимизации. В данной работе, ‘Trainability-Oriented Hybrid Quantum Regression via Geometric Preconditioning and Curriculum Optimization’, предложен гибридный квантово-классический алгоритм регрессии, использующий классическое предобусловливание входных данных и поэтапную оптимизацию для повышения стабильности обучения. Разработанная архитектура включает в себя классический слой предобработки, улучшающий обусловленность квантовой схемы, и протокол обучения, переходящий от стохастического исследования к точному градиентному спуску. Может ли комбинация геометрического предобусловливания и поэтапного обучения стать практичным подходом для стабилизации квантовой регрессии и расширения возможностей квантового машинного обучения в научных приложениях?

Вызов научной машинной обучаемости: Преодоление ограничений

Традиционные алгоритмы машинного обучения демонстрируют впечатляющие результаты в задачах распознавания образов, однако их эффективность существенно снижается при моделировании явлений, подчиняющихся фундаментальным физическим законам. В то время как эти алгоритмы превосходно выявляют статистические закономерности в данных, они испытывают трудности с экстраполяцией знаний за пределы наблюдаемых данных и с обеспечением физической согласованности решений. Например, при прогнозировании поведения жидкости или распространении тепла, требуется соблюдение законов сохранения энергии и массы, что выходит за рамки возможностей стандартных методов, ориентированных исключительно на корреляцию между входными и выходными данными. Это ограничение препятствует применению традиционного машинного обучения в областях, где точность и соответствие физическим принципам являются критически важными.

Решение сложных научных задач часто требует анализа непрерывных пространств и соблюдения ограничений, заданных частными дифференциальными уравнениями. Эти уравнения описывают фундаментальные законы природы, управляющие явлениями от распространения тепла и жидкости до электромагнитных волн и гравитации. В отличие от дискретных данных, с которыми эффективно справляются традиционные алгоритмы машинного обучения, научные задачи оперируют с функциями, меняющимися в непрерывном пространстве и времени. Игнорирование этих базовых принципов приводит к неточностям и проблемам с обобщением моделей, поскольку решения должны соответствовать не только наблюдаемым данным, но и физическим законам, описываемым уравнениями \frac{\partial u}{\partial t} = \nabla \cdot (k \nabla u), где u — искомая функция, а k — коэффициент, определяющий свойства среды. Поэтому, для успешного применения машинного обучения в науке, необходимо разрабатывать методы, способные учитывать эти непрерывные характеристики и интегрировать информацию, содержащуюся в частных дифференциальных уравнениях.

Традиционные методы машинного обучения, такие как многослойные персептроны, часто демонстрируют ограниченную эффективность при решении научных задач, поскольку им не хватает встроенных механизмов для учета фундаментальных физических законов. Эти модели, в первую очередь предназначенные для распознавания закономерностей в данных, не способны естественным образом интегрировать ограничения, задаваемые частными дифференциальными уравнениями \frac{\partial u}{\partial t} = \nabla \cdot (D \nabla u) . В результате, точность и обобщающая способность таких подходов существенно снижаются при экстраполяции за пределы тренировочного набора данных или при изменении условий, описываемых этими уравнениями. Неспособность учитывать физические принципы приводит к тому, что модели могут генерировать нереалистичные или физически невозможные решения, что делает их непригодными для надежного моделирования и прогнозирования в сложных научных областях.

Квантовые нейронные сети: Новый горизонт вычислений

Квантовые нейронные сети (КНС) представляют собой перспективную альтернативу классическим нейронным сетям, используя принципы квантовой механики для представления и обработки информации. В отличие от бинарных значений в классических вычислениях, КНС используют кубиты, которые могут находиться в суперпозиции состояний |\psi\rangle = \alpha|0\rangle + \beta|1\rangle, где α и β — комплексные амплитуды вероятности. Это позволяет КНС потенциально представлять и обрабатывать экспоненциально большее количество информации, чем классические сети при том же количестве вычислительных ресурсов. Кроме того, использование квантовой запутанности позволяет КНС эффективно выполнять параллельные вычисления, что может привести к значительному ускорению в определенных задачах машинного обучения, таких как распознавание образов и оптимизация.

В основе квантовых нейронных сетей (КНС) лежат вариационные квантовые схемы (ВКС) — обучаемые квантовые системы, предназначенные для аппроксимации сложных функций. ВКС состоят из параметризованных квантовых вентилей, параметры которых оптимизируются в процессе обучения с использованием классических алгоритмов. Это позволяет КНС адаптироваться к данным и находить приближенные решения сложных задач, где традиционные нейронные сети могут оказаться неэффективными. Конкретная структура ВКС и выбор квантовых вентилей определяются решаемой задачей и могут варьироваться в зависимости от требуемой точности и вычислительных ресурсов.

Техника повторной загрузки данных (Data Re-uploading) является ключевым элементом вариационных квантовых схем (VQC), обеспечивая эффективное кодирование классических данных в квантовые состояния. В отличие от однократной загрузки данных, повторная загрузка предполагает многократное применение квантовых операций, зависящих от входных данных, к квантовому состоянию. Это позволяет моделировать более сложные функции и улучшает способность сети к обучению. Процесс заключается в повторном применении квантовой цепи, параметризованной входными данными, к исходному квантовому состоянию, что увеличивает выразительность модели и ее способность к аппроксимации сложных зависимостей. Эффективность данной техники обусловлена ее способностью более полно использовать квантовые ресурсы для обработки информации.

Преодоление трудностей оптимизации в квантовом машинном обучении

Обучение квантовых нейронных сетей (QNN) часто затрудняется феноменом “Barren Plateau” (бесплодного плато), заключающимся в экспоненциальном затухании градиентов с увеличением глубины квантовой схемы. Это означает, что при увеличении числа квантовых операций в сети, сигналы, необходимые для обновления параметров в процессе обучения, становятся крайне малыми, приближаясь к нулю. В результате, алгоритмы оптимизации, такие как градиентный спуск, теряют способность эффективно корректировать веса сети, что приводит к замедлению или полной остановке обучения. Экспоненциальная зависимость затухания градиентов от глубины схемы делает проблему особенно острой для глубоких QNN, ограничивая их потенциальную выразительную способность и практическую применимость.

Проблема неблагоприятного ландшафта функции потерь заключается в том, что незначительные изменения параметров квантонной нейронной сети (QNN) могут приводить к существенным изменениям в значении функции потерь. Это создает трудности для алгоритмов оптимизации, поскольку даже небольшие шаги в направлении уменьшения потерь могут приводить к нестабильности и медленной сходимости. В таких условиях, градиентный спуск и подобные методы могут испытывать затруднения в поиске оптимальных параметров, что требует применения более устойчивых и эффективных методов оптимизации или модификации архитектуры QNN для смягчения этой проблемы. Неблагоприятный ландшафт потерь проявляется как высокая чувствительность функции потерь к изменениям параметров, что затрудняет точную настройку модели.

Для смягчения проблем оптимизации в квантовом машинном обучении применяются передовые методы, такие как Adam и SPSA. Adam использует адаптивные оценки шага обучения для каждого параметра, что позволяет ускорить сходимость и улучшить стабильность. SPSA (Simultaneous Perturbation Stochastic Approximation) — стохастический метод, эффективно работающий в высокоразмерных пространствах параметров. Однако, несмотря на эффективность этих методов, требуется дальнейшее совершенствование для повышения устойчивости обучения и улучшения производительности квантовых нейронных сетей, особенно при работе с глубокими схемами и сложными функциями потерь. Исследования направлены на разработку новых алгоритмов оптимизации и адаптацию существующих к специфике квантовых вычислений.

Гибридные подходы и усиленное обусловливание

Интеграция классических модулей, в частности геометрических пред-обусловливателей, оказывает существенное влияние на улучшение обусловленности целевой функции квантовой регрессии. Использование этих компонентов позволяет преобразовать входные данные таким образом, чтобы смягчить проблемы, связанные с плохо обусловленными поверхностями потерь. Геометрические пред-обусловливатели эффективно изменяют геометрию пространства признаков, приближая его к более оптимальной форме для обучения. Это, в свою очередь, ускоряет сходимость алгоритма и повышает его устойчивость к шумам и локальным минимумам. В результате, достигается более точная и надежная регрессия, что подтверждается результатами, полученными на наборе данных Yacht Hydrodynamics.

Использование классических компонентов для преобразования входных представлений позволяет эффективно смягчить проблемы, связанные с плохо обусловленными ландшафтами потерь. Неблагоприятная геометрия этих ландшафтов может существенно замедлить или даже остановить процесс обучения квантовых нейронных сетей. Преобразуя исходные данные, классические модули, такие как геометрические пре-кондиционеры, способствуют созданию более гладкой и управляемой поверхности потерь. Это, в свою очередь, облегчает поиск оптимальных параметров модели и повышает стабильность обучения, позволяя квантовой нейронной сети быстрее сходиться к решению и достигать более высокой точности предсказаний. Такой подход позволяет преодолеть ограничения, связанные с высокой чувствительностью квантовых моделей к структуре входных данных.

Постепенное увеличение глубины квантовой схемы посредством методики Layer-Wise Circuit Growth позволяет эффективно обходить проблему «барен-плато» — области, где градиенты затухают, препятствуя обучению. Предложенная гибридная архитектура, использующая данный подход, продемонстрировала значительное улучшение точности на наборе данных Yacht Hydrodynamics, достигнув среднеквадратичной ошибки RMSE = 0.46 \pm 0.05. Этот результат существенно превосходит показатели чистой квантовой нейронной сети, которая в тех же условиях дала значение RMSE = 1.31 \pm 0.42, что подтверждает эффективность предложенного подхода к стабилизации и ускорению процесса обучения квантовых моделей.

К физически обоснованным квантовым решениям

Сочетание квантовых нейронных сетей с сетями, информированными физикой (PINN), представляет собой перспективный подход к решению уравнений в частных производных. Данная методика объединяет способность квантовых вычислений к эффективной обработке сложных данных с возможностью PINN учитывать фундаментальные физические законы, закодированные непосредственно в архитектуре сети. В отличие от традиционных численных методов, требующих дискретизации области решения, PINN способны работать с непрерывными функциями, обеспечивая более точные и стабильные результаты. Интеграция с квантовыми нейронными сетями позволяет дополнительно ускорить процесс обучения и повысить точность решения, особенно в задачах, где классические алгоритмы сталкиваются с вычислительными ограничениями. Такой гибридный подход открывает новые возможности для моделирования широкого спектра физических явлений, от гидродинамики и теплопередачи до квантовой механики и электродинамики.

В рамках оптимизации квантовых схем предложен подход, использующий матрицу квантовой информации Фишера для уточнения алгоритма естественного градиента. Этот метод позволяет более эффективно настраивать параметры квантовых цепей, что особенно важно при решении сложных задач. Матрица Фишера, отражающая чувствительность вероятности к изменениям параметров, служит для адаптации метрики пространства параметров, обеспечивая более стабильное и быстрое схождение алгоритма. По сути, происходит масштабирование градиента в соответствии с кривизной функции потерь, что позволяет избежать осцилляций и ускорить процесс обучения. Такой подход демонстрирует повышение эффективности оптимизации по сравнению с традиционными методами, такими как Adam, и обеспечивает более сильный сигнал градиента, что способствует достижению лучших результатов в задачах машинного обучения и научных вычислениях.

Комбинирование квантового и классического машинного обучения открывает новые горизонты для научных исследований и инноваций, позволяя решать сложные задачи с большей точностью и эффективностью. В рамках разработанной схемы, применительно к набору данных об энергоэффективности, удалось достичь среднеквадратичной ошибки (RMSE) в 0.36 ± 0.04 — наименьшего значения среди протестированных моделей. При этом, использование квантового естественного градиента продемонстрировало повышенную дисперсию градиента по сравнению с оптимизатором Adam, что свидетельствует об усилении сигнала обучения и потенциально более быстрой сходимости к оптимальному решению. Данный результат подтверждает перспективность гибридных подходов для решения задач, требующих высокой точности и эффективности вычислений.

Исследование, представленное в данной работе, демонстрирует стремление к математической чистоте в алгоритмах машинного обучения. Авторы предлагают подход, сочетающий классическую предобработку и последовательное обучение, чтобы преодолеть проблему «плоских участков» (barren plateaus) в кванровых нейронных сетях. Этот метод направлен на повышение обучаемости и стабильности моделей, что особенно важно для задач научной машинного обучения. Как однажды заметил Карл Фридрих Гаусс: «Если бы я должен был выбирать между красотой и истиной, я бы выбрал истину». В контексте данного исследования, истина заключается в математической корректности и доказуемости алгоритма, а красота — в его эффективности и способности решать сложные задачи. Предобработка данных и оптимизация учебного плана, предложенные авторами, служат подтверждением этого принципа.

Что дальше?

Представленная работа, хотя и демонстрирует улучшение обучаемости гибридных квантово-классических моделей регрессии, не решает фундаментальной проблемы: компромисс между выразительностью и оптимизируемостью. Предобуславливание и обучение по учебному плану — это, по сути, эвристики, смягчающие последствия «пустошей барьеров», но не устраняющие их причины. Следующим шагом представляется не поиск более изощренных методов обхода проблем градиентного исчезновения, а разработка архитектур, изначально устойчивых к ним.

Следует признать, что стремление к «научному машинному обучению» часто приводит к увлечению сложными моделями, требующими огромных вычислительных ресурсов. В погоне за точностью необходимо задаться вопросом о целесообразности: не проще ли использовать хорошо отлаженные классические алгоритмы, если прирост производительности квантовой составляющей незначителен? Истинная элегантность заключается не в сложности, а в оптимальном соотношении точности и вычислительной эффективности.

В перспективе, представляется важным сместить фокус с разработки новых алгоритмов на формальную верификацию существующих. Необходимо доказать, что предложенные методы действительно обеспечивают устойчивую обучаемость в широком диапазоне задач, а не просто демонстрируют хорошие результаты на ограниченном наборе данных. Только строгий математический анализ может отделить истинный прогресс от временного везения.

Оригинал статьи: https://arxiv.org/pdf/2601.11942.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Виртуальная примерка без границ: EVTAR учится у образов

- Квантовый скачок: от лаборатории к рынку

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

- Восполняя пробелы в знаниях: Как языковые модели учатся делать выводы

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Точность фазовой оценки: адаптивный подход превосходит стандартный

- Автономный поисковик научных статей: новый подход

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

2026-01-22 04:25