Автор: Денис Аветисян

Обзор посвящен применению больших языковых моделей и интеллектуальных агентов для автоматической генерации и оптимизации вычислительных ядер, критически важных для ускорения задач искусственного интеллекта.

Исследование текущих подходов к автоматической генерации и оптимизации высокопроизводительных ядер с использованием LLM, обучения с подкреплением и оптимизации на основе агентов.

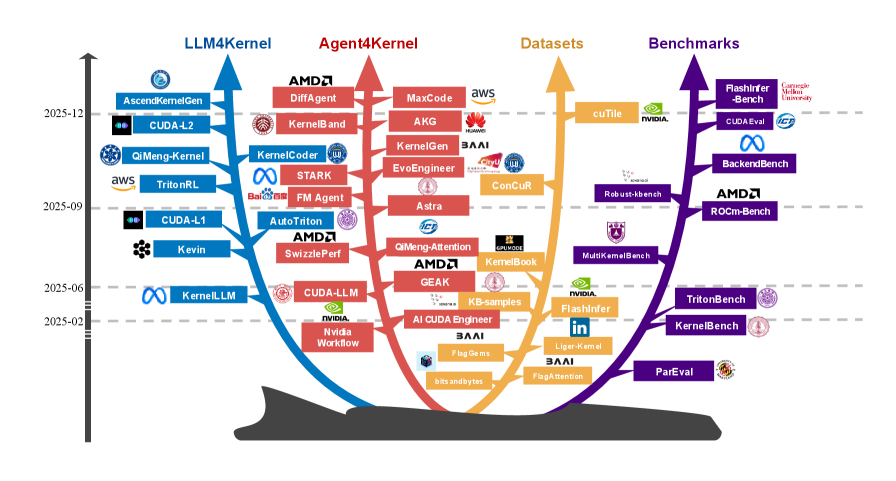

Производительность современных систем искусственного интеллекта фундаментально ограничена качеством лежащих в их основе ядер, переводящих высокоуровневые алгоритмы в низкоуровневые аппаратные операции. В работе ‘Towards Automated Kernel Generation in the Era of LLMs’ представлен обзор возможностей автоматизации генерации и оптимизации этих ядер с использованием больших языковых моделей (LLM) и интеллектуальных агентов. Обзор систематизирует существующие подходы, включая LLM-ориентированные методы и оптимизационные рабочие процессы на основе агентов, а также компилирует наборы данных и бенчмарки, используемые для обучения и оценки. Какие ключевые вызовы и направления исследований необходимо преодолеть для создания полностью автоматизированной системы оптимизации ядер, способной раскрыть весь потенциал аппаратного ускорения?

Фундаментальные ограничения современных языковых моделей

Современные большие языковые модели, несмотря на впечатляющие возможности, сталкиваются с фундаментальным ограничением, обусловленным огромными вычислительными затратами на операции матричного умножения и механизмы внимания. Эти операции, являющиеся основой обработки информации в моделях, требуют экспоненциально возрастающих ресурсов по мере увеличения размера модели и сложности задач. O(n^2) — сложность вычислений внимания, быстро становится препятствием для масштабирования, поскольку даже небольшое увеличение количества параметров приводит к значительному увеличению времени обучения и развертывания. Данное ограничение не позволяет в полной мере реализовать потенциал языковых моделей, сдерживая прогресс в области искусственного интеллекта и требуя поиска новых, более эффективных архитектур и алгоритмов.

Существующие оптимизированные вручную ядра, такие как представленные в CUTLASS, действительно обеспечивают прирост производительности для языковых моделей. Однако, их адаптация к постоянно меняющимся архитектурам моделей и новым поколениям аппаратного обеспечения представляет собой серьезную проблему. Разработка и точная настройка этих ядер требует значительных усилий и времени, и, как правило, они оптимизированы под конкретную конфигурацию. В результате, при появлении новых моделей или аппаратных платформ, эти ядра быстро устаревают, требуя повторной разработки. Такая негибкость становится все более заметным препятствием для дальнейшего развития больших языковых моделей, замедляя прогресс в области искусственного интеллекта и ограничивая потенциал этих мощных систем. Необходимость в автоматизированных методах генерации и оптимизации ядер становится очевидной, чтобы обеспечить быструю адаптацию к быстро меняющимся условиям.

Негибкость существующих оптимизированных ядер, разработанных вручную, создает критическое препятствие для дальнейшего развития больших языковых моделей. Несмотря на значительные успехи в области искусственного интеллекта, потенциал этих моделей остается нереализованным из-за трудностей в адаптации вычислительных блоков к постоянно меняющимся архитектурам и аппаратным требованиям. Эта неспособность оперативно реагировать на инновации приводит к замедлению прогресса в повышении производительности и эффективности, ограничивая возможности LLM в решении сложных задач и обработке больших объемов данных. В результате, несмотря на теоретический потенциал, практическая реализация передовых языковых моделей сталкивается с серьезными ограничениями, обусловленными вычислительной неэффективностью.

По мере усложнения и увеличения масштабов больших языковых моделей (LLM) возрастает потребность в высокоэффективных вычислительных ядрах. Традиционные, вручную оптимизированные ядра, такие как представленные в CUTLASS, испытывают трудности с адаптацией к постоянно меняющимся архитектурам моделей и аппаратным платформам. Это обуславливает необходимость автоматизированных методов генерации ядер, способных оперативно реагировать на инновации. Для обеспечения надежности и функциональности автоматически сгенерированного кода применяются метрики оценки, такие как pass@k, позволяющие определить процент успешно сгенерированных и корректно работающих ядер из общего числа попыток. Подобный подход к автоматизации и верификации является ключевым для дальнейшего развития производительности LLM и раскрытия их полного потенциала.

Автоматическая генерация ядра: парадигмальный сдвиг

Основная концепция автоматической генерации ядра заключается в использовании больших языковых моделей (LLM) для создания оптимизированных ядер, что представляет собой переход от ручной настройки к проектированию на основе искусственного интеллекта. Традиционно, разработка высокопроизводительных ядер требовала значительных усилий по ручной оптимизации и глубокого понимания аппаратной архитектуры. LLM позволяют автоматизировать этот процесс, генерируя код ядра непосредственно из описания требуемой вычислительной задачи. Этот подход потенциально сокращает время разработки и позволяет достичь более высокой производительности за счет использования LLM для исследования широкого спектра возможных оптимизаций, которые могли бы быть упущены при ручной настройке.

Процесс автоматической генерации ядра включает в себя обучение больших языковых моделей (LLM) на специализированном наборе данных — Kernel Dataset. Этот набор данных состоит из тщательно отобранных и оптимизированных реализаций ядер, представляющих собой высокопроизводительный код для различных вычислительных задач. Обучение LLM на Kernel Dataset позволяет модели изучить закономерности и принципы, лежащие в основе эффективной реализации ядер, а также установить связь между задачей и оптимальным кодом для ее решения. Объем и качество Kernel Dataset напрямую влияют на способность LLM генерировать новые, эффективные ядра для задач, не представленных в обучающем наборе.

Обучение с учителем (Supervised Fine-Tuning) позволяет моделям на основе больших языковых моделей (LLM) устанавливать соответствие между заявленной вычислительной задачей (computational intent) и эффективным кодом ядра (kernel code). В процессе обучения модели анализируют размеченный набор данных, состоящий из пар «задача-оптимизированный код», что позволяет им выявлять закономерности и принципы, лежащие в основе высокопроизводительных реализаций. В результате, модель приобретает способность генерировать код ядра, соответствующий заданным требованиям, формируя основу для автономной генерации и оптимизации кода, без необходимости ручной настройки и экспертных знаний.

Использование LLM-агентов позволяет реализовать сложные рабочие процессы автоматической генерации ядра. Эти агенты способны планировать последовательность действий, используя различные инструменты для создания кода ядра и последующей оценки его производительности. Процесс включает в себя не только генерацию кода, но и его верификацию, оптимизацию и тестирование. Оценка эффективности генерируемых ядер осуществляется с использованием метрик, таких как speedup@k, которая измеряет ускорение по сравнению с базовой реализацией при заданном уровне точности k. Такой подход позволяет автоматизировать процесс создания высокооптимизированных ядер, адаптированных к конкретным аппаратным платформам и задачам.

Валидация и оптимизация для разнородного оборудования

Сгенерированные ядра должны подвергаться строгому тестированию и валидации с использованием эталонных тестов (бенчмарков) для подтверждения корректности и производительности. Процесс включает в себя выполнение ядра на наборе стандартизированных входных данных и сравнение полученных результатов с ожидаемыми значениями. Валидация охватывает как функциональную корректность — обеспечение правильности вычислений — так и производительность, измеряемую в виде времени выполнения, пропускной способности и использования ресурсов. Автоматизированные системы тестирования, включающие в себя различные наборы данных и метрики, позволяют эффективно выявлять и устранять ошибки и узкие места в производительности до развертывания ядра на целевом оборудовании.

Аппаратный профилинг предоставляет важные данные о характеристиках целевого оборудования — GPU и NPU, — необходимые для обоснованной оптимизации. Этот процесс включает в себя измерение ключевых параметров, таких как тактовая частота, объем памяти, пропускная способность, латентность доступа к памяти и вычислительные возможности. Полученные данные позволяют выявить узкие места в архитектуре и адаптировать генерируемые ядра для эффективного использования ресурсов. Профилирование позволяет определить оптимальные размеры блоков данных, стратегии доступа к памяти и методы распараллеливания, что приводит к повышению производительности и снижению энергопотребления на конкретном оборудовании.

Оптимизация ядра, основанная на данных профилирования оборудования, включает в себя ряд техник, направленных на повышение эффективности сгенерированного кода для конкретных архитектур. Анализ данных профилирования, включающий метрики загрузки GPU и NPU, выявляет узкие места и области для улучшения. Применяются такие методы, как разворачивание циклов, переупорядочивание инструкций и оптимизация использования памяти, для максимизации пропускной способности и минимизации задержек. Данные профилирования позволяют точно настроить параметры компиляции и выбрать оптимальные алгоритмы для конкретного оборудования, что приводит к значительному повышению производительности и энергоэффективности.

Для итеративного улучшения производительности ядра возможно применение методов обучения с подкреплением, использующих циклы обратной связи на основе вознаграждения. В данном подходе, ядро исполняется, и метрика производительности, такая как efficiency@k (эффективность при обработке k элементов) и общая пропускная способность, используется в качестве сигнала вознаграждения. Алгоритм обучения с подкреплением, анализируя полученное вознаграждение, модифицирует параметры ядра или структуру кода, стремясь к максимизации эффективности и пропускной способности. Повторяющиеся циклы исполнения, оценки и модификации позволяют автоматически находить оптимальные конфигурации ядра для конкретной аппаратной архитектуры.

Перспективы: масштабирование и обобщение

Многоагентное управление позволяет разложить сложные задачи генерации ядра на управляемые подзадачи, решаемые специализированными агентами. Такой подход предполагает распределение ответственности между различными компонентами системы, где каждый агент фокусируется на конкретном аспекте генерации ядра — например, оптимизации производительности, снижении энергопотребления или адаптации к конкретной аппаратной архитектуре. Разделение сложной задачи на более мелкие, независимые части не только упрощает процесс разработки и отладки, но и значительно повышает эффективность за счет параллельного выполнения подзадач. Подобная архитектура обеспечивает гибкость и масштабируемость системы, позволяя легко добавлять новых агентов или модифицировать существующих для решения новых задач и адаптации к меняющимся требованиям. В результате, достигается более высокая производительность и качество генерируемых ядер по сравнению с традиционными подходами.

Интеграция методов, таких как Retrieval-Augmented Generation (RAG), значительно расширяет возможности агентов на основе больших языковых моделей (LLM). Вместо того, чтобы полагаться исключительно на собственные знания, полученные в процессе обучения, RAG позволяет этим агентам обращаться к внешним базам знаний в реальном времени. Этот подход позволяет им находить и использовать релевантную информацию для решения задач, повышая точность ответов и обеспечивая доступ к актуальным данным. По сути, RAG дополняет внутренние знания LLM внешним контекстом, что особенно важно при работе с быстро меняющимися областями знаний или при решении задач, требующих специализированных данных, недоступных в процессе предварительного обучения модели. Такая возможность делает агентов более гибкими, адаптивными и способными к эффективному решению широкого спектра задач.

Для преодоления проблемы недостатка данных и повышения способности моделей обобщать информацию на новые архитектуры, активно исследуется подход генерации синтетических данных. Этот метод предполагает создание искусственных образцов, имитирующих реальные данные, что позволяет значительно расширить обучающую выборку. Использование синтетических данных особенно актуально для задач, где сбор и аннотация реальных данных затруднены или требуют больших затрат. Благодаря этому, модели получают возможность изучать более широкий спектр сценариев и лучше адаптироваться к новым, ранее не встречавшимся структурам, что в конечном итоге приводит к повышению их производительности и надежности.

Автоматизированный подход, представленный в обзоре, открывает перспективы для значительного повышения производительности и масштабируемости больших языковых моделей (LLM). Благодаря декомпозиции сложных задач и использованию специализированных агентов, становится возможным преодолеть ограничения, связанные с вычислительными ресурсами и сложностью архитектур. Это, в свою очередь, способствует созданию более мощных и эффективных систем искусственного интеллекта, способных решать широкий спектр задач с повышенной точностью и скоростью. Достигнутые в ходе исследования результаты демонстрируют, что автоматизация процессов генерации и оптимизации ядра LLM является ключевым фактором для дальнейшего развития и внедрения передовых AI-технологий.

Исследование автоматической генерации ядра, представленное в данной работе, закономерно вызывает скепсис. Авторы описывают перспективные подходы с использованием больших языковых моделей и агентов, но забывают о фундаментальной истине: любое «революционное» решение неизбежно превратится в технический долг. Оптимизация производительности, особенно в контексте аппаратного ускорения, — это бесконечная гонка, где каждое улучшение порождает новые сложности. Как заметил Алан Тьюринг: «Мы можем только надеяться на то, что машины не станут слишком умными». В контексте автоматической генерации кода, это предостережение особенно актуально — ведь в погоне за автоматизацией легко создать системы, которые сложнее понимать и отлаживать, чем те, что написаны вручную. И как всегда, проджект-менеджеры будут требовать «ещё немного оптимизации» к следующему релизу.

Что дальше?

Автоматическая генерация ядер, управляемая большими языковыми моделями… Звучит, конечно, красиво. Но история учит, что каждая «революция» в области компиляции заканчивается новым уровнем абстракции, усложняющим отладку. И неважно, что обещали «самооптимизирующийся код» или «идеальную переносимость». В конечном итоге, всегда найдётся железо, которое заставит эти обещания выглядеть нелепо. А попытки обучить агентов, «оптимизирующих» ядра, напоминают попытки приручить кота Шрёдингера — пока не посмотрели, вроде бы работает, посмотрели — опять двадцать пять.

Наиболее вероятный сценарий — создание ещё более сложных инструментов, которые будут генерировать код, который невозможно понять и поддерживать. Будут новые метрики, новые бенчмарки, и, конечно, новые способы обмануть эти бенчмарки. И всё это ради небольшого прироста производительности, который, вероятно, будет нивелирован очередным обновлением драйвера. Впрочем, кто сказал, что инженерам нужна простота? Главное — чтобы было что оптимизировать.

В конечном счёте, всё новое — это просто старое с худшей документацией. И, скорее всего, через десять лет кто-нибудь с тоской вздохнёт, вспоминая времена, когда можно было просто написать код, который работал. А потом снова начнётся гонка за производительностью, и всё повторится сначала. И так всегда.

Оригинал статьи: https://arxiv.org/pdf/2601.15727.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Динамическая теория поля в реальном времени: путь к квантовым вычислениям

2026-01-23 12:19