Автор: Денис Аветисян

Исследователи представили OpenVision 3 — архитектуру, объединяющую возможности вариационных автоэнкодеров и трансформаторов для достижения передовых результатов в задачах визуального анализа и синтеза.

OpenVision 3 сочетает в себе VAE и ViT для обеспечения синергии между реконструкцией изображений и семантическим обучением.

Обычно задачи компьютерного зрения разделяются на понимание изображений и их генерацию, что требует отдельных моделей и подходов. В данной работе представлена архитектура ‘OpenVision 3: A Family of Unified Visual Encoder for Both Understanding and Generation’, предлагающая семейство унифицированных визуальных энкодеров, способных эффективно решать обе задачи одновременно. В основе лежит комбинация вариационных автоэнкодеров и трансформеров ViT, что позволяет энкодеру захватывать как генеративные, так и семантические особенности изображений в едином латентном пространстве. Способны ли подобные унифицированные модели стать основой для создания более гибких и эффективных систем мультимодального искусственного интеллекта?

Разрыв между Визуальным Восприятием и Описанием

Существующие мультимодальные модели зачастую сталкиваются с фундаментальным разрывом между тем, как они «видят» изображение, и тем, как они его описывают. Эта проблема возникает из-за различных способов обработки визуальной информации и текстовых данных, что приводит к несоответствию между представлением изображения в модели и его лингвистическим описанием. В результате, модели испытывают трудности с задачами, требующими глубокого понимания визуального контекста и точной генерации детальных описаний. Например, при попытке ответить на вопрос о конкретном объекте на изображении, модель может правильно идентифицировать объект, но не суметь объяснить его взаимодействие с другими элементами сцены. Эта неспособность к последовательному пониманию и генерации является серьезным ограничением для широкого применения мультимодальных систем в таких областях, как робототехника, автоматическое создание контента и интеллектуальный анализ изображений.

Несоответствие между тем, как модели воспринимают изображения, и тем, как они их описывают, существенно ограничивает их возможности в задачах, требующих тонкого визуального анализа и детализированной генерации контента. Это проявляется в сложностях при понимании сложных сцен, интерпретации неявных связей между объектами и создании реалистичных, последовательных описаний. Например, модель может распознать отдельные объекты на изображении, но не суметь правильно интерпретировать их взаимосвязь или контекст, что приводит к неточностям при создании текстовых описаний или генерации новых изображений, соответствующих заданным параметрам. Следовательно, способность к точному визуальному мышлению и генерации напрямую зависит от устранения этого разрыва между визуальным восприятием и лингвистическим выражением.

Единый подход к визуальной токенизации представляется ключевым для преодоления разрыва между восприятием и описанием изображений в современных мультимодальных моделях. Вместо раздельной обработки визуальной информации и текстовых данных, предлагается унифицированная система, преобразующая изображения в последовательность дискретных токенов, аналогичных тем, что используются в обработке естественного языка. Такой подход позволяет модели воспринимать визуальные элементы как своего рода «слова», облегчая установление соответствий между визуальными признаками и их текстовыми описаниями. Это, в свою очередь, значительно повышает эффективность обучения и позволяет создавать более точные и детализированные описания изображений, а также генерировать изображения, точно соответствующие заданным текстовым запросам. В результате, унифицированная токенизация открывает путь к созданию мультимодальных систем, способных к более глубокому пониманию и генерации визуального контента.

OpenVision 3: Единая Архитектура Токенизации

В OpenVision 3 используется VAE (Variational Autoencoder) энкодер для сжатия изображений в латентные представления. Этот процесс позволяет снизить размерность данных, сохраняя при этом ключевые визуальные характеристики. VAE энкодер преобразует входное изображение в вероятностное распределение в латентном пространстве, что позволяет эффективно кодировать и декодировать изображения, а также генерировать новые образцы, близкие к исходным данным. Сжатие изображения в латентное пространство позволяет снизить вычислительные затраты и повысить эффективность обработки изображений в последующих слоях архитектуры.

Пространство скрытых представлений, полученное после кодирования изображений VAE, обрабатывается ViT-энкодером (Vision Transformer). ViT-энкодер преобразует эти представления в унифицированный формат, пригодный для решения мультимодальных задач. Это достигается за счет применения механизма внимания (attention) к последовательности патчей изображения, что позволяет модели устанавливать зависимости между различными частями изображения и формировать контекстно-зависимые представления. В результате, ViT-энкодер извлекает признаки, которые могут быть использованы для широкого спектра задач, включая классификацию изображений, обнаружение объектов и генерацию подписей к изображениям, а также для объединения визуальной информации с другими модальностями данных, такими как текст или звук.

Архитектура OpenVision 3 включает в себя два отдельных декодера: декодер реконструкции и декодер понимания. Декодер реконструкции отвечает за генерацию изображений из латентного пространства, обеспечивая возможность восстановления исходного изображения на основе сжатого представления. Декодер понимания, напротив, предназначен для извлечения семантической информации и представления изображения в виде понятных признаков, пригодных для задач анализа и классификации. Такое разделение функциональности позволяет модели одновременно выполнять задачи генерации изображений и семантического анализа, используя общее латентное пространство для представления визуальной информации.

Усиление Семантического Контроля через Контрастное Обучение

В архитектуре OpenVision 3, модуль декодера понимания использует контрастивное обучение для усиления семантической связи между визуальными и текстовыми признаками. Этот процесс заключается в минимизации расстояния между соответствующими визуальными представлениями изображения и его текстовым описанием в векторном пространстве признаков. Контрастивное обучение позволяет модели научиться отличать соответствующие пары «изображение-текст» от некорректных, тем самым повышая точность сопоставления визуального контента с его семантическим значением и улучшая способность модели к обобщению и пониманию визуальных концепций.

В дополнение к контрастному обучению, декодер обучается предсказывать текстовые описания на основе визуальных представлений посредством целевой функции генерации подписей. Этот процесс позволяет модели не только различать семантически близкие и далекие представления, но и активно генерировать соответствующие текстовые описания для входных изображений. Обучение с использованием целевой функции генерации подписей значительно повышает производительность модели в задачах понимания изображений, поскольку требует от декодера более глубокого понимания визуального контента для точной генерации описаний.

Использование контрастивного обучения и целевой функции, основанной на генерации подписей к изображениям, позволяет OpenVision 3 формировать более устойчивое и связное представление визуальных концепций. Контрастивное обучение минимизирует расстояние между соответствующими визуальными и текстовыми признаками, укрепляя семантические связи. В сочетании с задачей генерации подписей, модель учится точно предсказывать текстовые описания на основе визуальных данных, что способствует повышению общей производительности и когерентности представления визуальной информации. Такой подход позволяет OpenVision 3 эффективно обобщать знания и обрабатывать новые, ранее не встречавшиеся визуальные сцены.

Влияние и Валидация на Различных Базовых Показателях

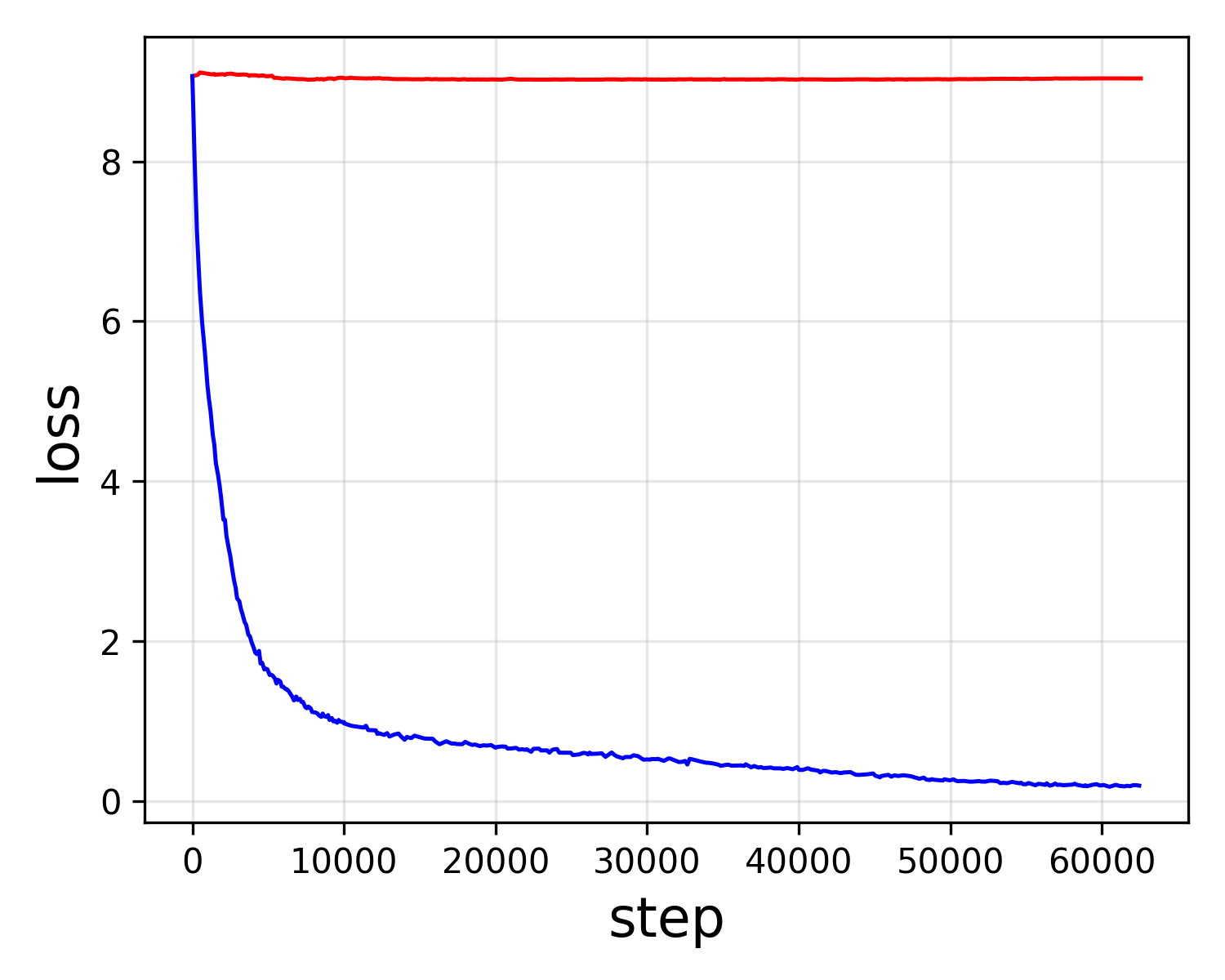

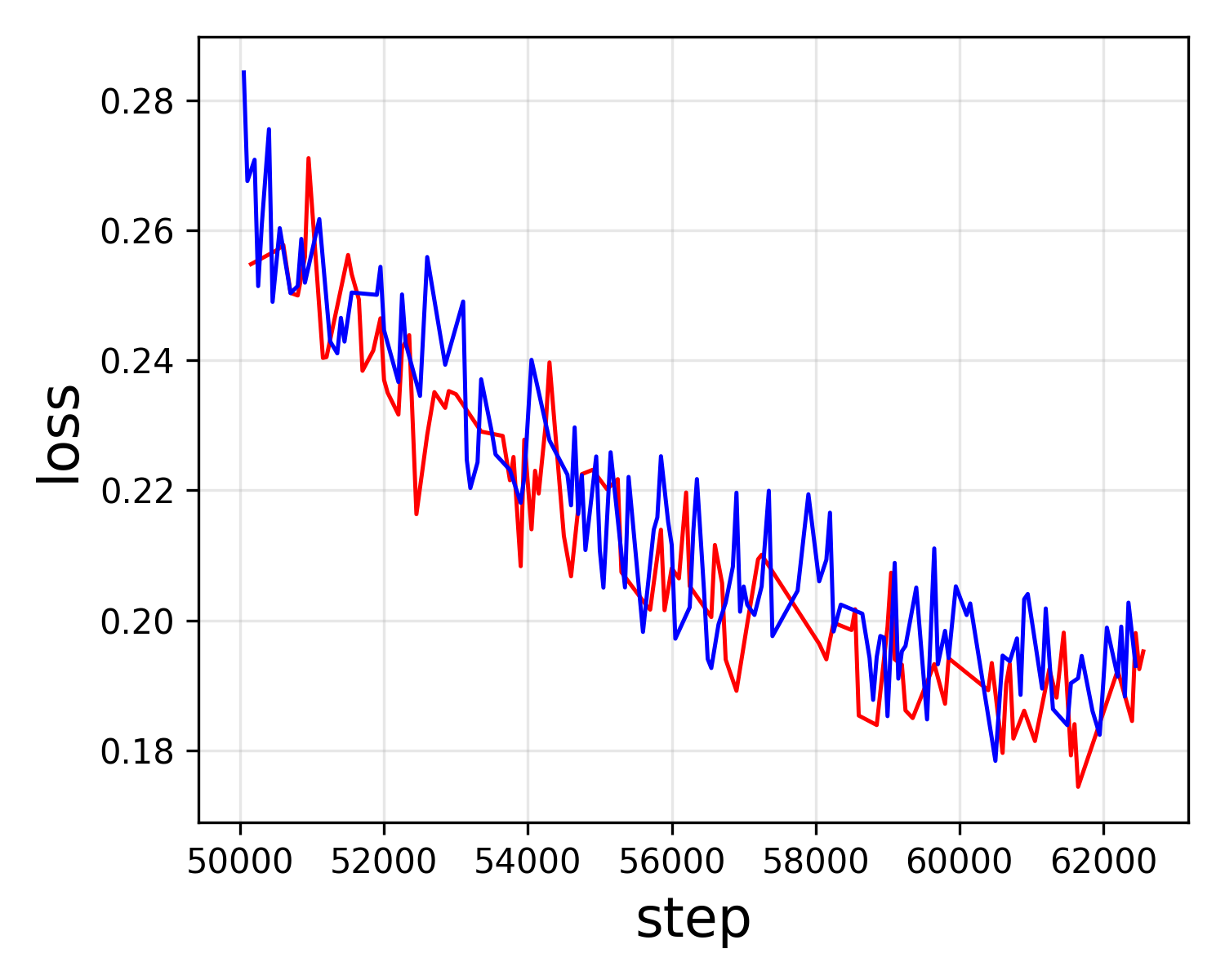

Токенизатор, разработанный в рамках OpenVision 3, продемонстрировал передовые результаты в области унифицированного мультимодального обучения, приблизившись по уровню понимания к модели CLIP. В ходе тестирования на SeedBench он достиг показателя 62.4, что незначительно превосходит результат CLIP (62.2). Кроме того, оценка POPE составила 83.7, сопоставимую с показателем CLIP (82.9). Эти результаты указывают на то, что токенизатор OpenVision 3 эффективно обрабатывает и сопоставляет информацию из различных модальностей, обеспечивая высокую точность и качество понимания данных.

Архитектура OpenVision 3 не ограничивается задачами понимания данных, но и успешно применяется в генеративном моделировании. Интеграция с RAE (Reconstruction, Analysis, and Editing) позволяет создавать изображения высокого качества, используя модели, такие как DiT (Differentiable Image Transformer) и SiT (Stacked Image Transformer). Данный подход демонстрирует способность системы не только анализировать визуальную информацию, но и воспроизводить её, открывая возможности для широкого спектра приложений, включая редактирование изображений и генерацию нового контента на их основе. Успешная реализация генеративного моделирования расширяет функциональность OpenVision 3 и подчеркивает её универсальность в обработке мультимодальных данных.

В ходе всесторонней оценки, включающей метрики gFID, IS, Pre и Rec, OpenVision 3 демонстрирует превосходное качество изображений и релевантность контента. В частности, модель достигает значения gFID, равного 1.89, что значительно превосходит результат CLIP (2.54). При реконструкции изображений ImageNet OpenVision 3 показывает PSNR в 30.33, опережая UniTok (25.34) и Vila-U (22.24). Дополнительно, значение LPIPS составляет 0.061, что также превосходит показатели UniTok (0.132), подтверждая способность модели создавать визуально более правдоподобные и семантически точные изображения.

Представленная работа демонстрирует стремление к созданию целостной системы кодирования визуальной информации. OpenVision 3, объединяя вариационные автоэнкодеры и трансформеры, находит синергию между реконструкцией и семантическим обучением. Эта архитектура подчеркивает, что сложность не всегда является путем к успеху. Как отмечал Альбер Камю: «Всё должно быть просто». Данный подход к унифицированному кодированию, где одна модель способна решать задачи как понимания, так и генерации изображений, отражает принцип, что хорошая архитектура незаметна, пока не ломается. Она строится на простоте и ясности, позволяя масштабироваться и адаптироваться к новым вызовам.

Куда же дальше?

Представленная работа, безусловно, демонстрирует элегантность объединения вариационных автоэнкодеров и трансформеров для визуального кодирования. Однако, кажущаяся универсальность подобной архитектуры не должна заслонять фундаментальный вопрос: действительно ли единый энкодер — это оптимальный путь, или же специализированные модели, тщательно заточенные под конкретные задачи, останутся более эффективными? Если система кажется слишком хороша, чтобы быть правдой, вероятно, упущено что-то важное в оценке вычислительных издержек и сложности обучения.

Дальнейшее развитие, вероятно, будет связано не столько с усложнением архитектуры, сколько с более глубоким пониманием взаимосвязи между реконструкцией изображения и семантическим обучением. Насколько действительно необходимо «воспроизводить» изображение, чтобы добиться хорошего семантического представления? Поиск компромисса между этими двумя целями — это искусство выбора того, чем пожертвовать. Простое увеличение масштаба модели не решит проблему, если не будет ясного понимания принципов, лежащих в ее основе.

В конечном итоге, истинный прогресс, скорее всего, будет достигнут за счет разработки более эффективных методов обучения и более глубокого понимания природы визуальной информации. Универсальность — заманчивая цель, но иногда более простые и специализированные решения оказываются более надежными и устойчивыми.

Оригинал статьи: https://arxiv.org/pdf/2601.15369.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

2026-01-24 05:04