Автор: Денис Аветисян

Новое исследование показывает, что структурированные подсказки значительно повышают эффективность нейронных систем, решающих математические задачи, даже при ограниченных вычислительных ресурсах.

В работе продемонстрировано, что использование тактических шаблонов в процессе вывода улучшает производительность систем автоматического доказательства теорем на базе больших языковых моделей.

Несмотря на впечатляющие успехи современных нейронных решателей теорем, основанных на больших языковых моделях и обученных с подкреплением, остается неясным, выигрывают ли они от простых структурных подсказок на этапе инференса. В работе ‘Structured Hints for Sample-Efficient Lean Theorem Proving’ исследуется влияние фиксированного расписания подсказок, основанного на 15 общих тактических схемах, на производительность системы в решении задач на бенчмарке miniF2F. Показано, что предложенный подход позволяет достичь 21.7% успешных решений при k=16 попытках, что на 43% выше, чем при стандартной выборке из той же модели. Действительно ли даже мощные системы, обученные с подкреплением, недостаточно используют структурные априорные знания, заложенные в тактическом языке, и может ли простое руководство на этапе инференса стать эффективным дополнением к существующим методам?

Вызов автоматического доказательства теорем

Автоматическое доказательство теорем играет ключевую роль в верификации сложных систем, от программного обеспечения критической важности до аппаратного обеспечения, требующего абсолютной надежности. Однако, несмотря на десятилетия исследований в области искусственного интеллекта, эта задача остается сложной. Суть проблемы заключается в том, что даже относительно простые математические утверждения могут потребовать огромного количества логических шагов для доказательства, приводя к «взрыву комбинаций». Современные алгоритмы часто не способны эффективно обрабатывать такое количество возможностей, что ограничивает их применимость в реальных задачах, требующих высокой степени автоматизации и надежности. Поэтому разработка более эффективных и масштабируемых методов автоматического доказательства теорем является одной из центральных задач современной науки об искусственном интеллекте.

Традиционные методы автоматического доказательства теорем сталкиваются с проблемой комбинаторного взрыва — экспоненциального роста числа возможных шагов доказательства. Эта сложность обусловлена тем, что даже для относительно простых теорем количество потенциальных путей к решению может быстро стать непомерно большим. В результате, алгоритмы часто оказываются неспособными эффективно исследовать все возможности в разумные сроки. Поэтому, для успешного завершения доказательства, требуется значительное вмешательство человека — эксперта, который направляет процесс, отсеивая неперспективные ветви и подсказывая наиболее вероятные пути решения. Эффективное преодоление этой проблемы является ключевой задачей в развитии полноценного искусственного интеллекта, способного самостоятельно решать сложные математические задачи и верифицировать критически важные системы.

Использование больших языковых моделей для генерации доказательств

Нейронное доказательство теорем (Neural Theorem Proving) представляет собой подход, объединяющий возможности больших языковых моделей (LLM) с формальными ассистентами доказательств, такими как Lean, для автоматизации процесса обнаружения и верификации математических доказательств. В основе метода лежит использование LLM для генерации тактических команд внутри среды Lean, позволяя модели исследовать пространство возможных доказательств и находить корректные последовательности шагов. Этот симбиоз позволяет преодолеть ограничения традиционных автоматических теоремщиков, используя LLM для интуитивного поиска, а формальный ассистент — для гарантии математической строгости и корректности полученных результатов. В результате, LLM выступает в роли помощника для исследователя, предлагая варианты доказательств, которые затем верифицируются системой Lean.

Ключевым элементом в процессе автоматического доказательства теорем является структурированный запрос (Structured Query), представляющий собой комбинацию формулировки теоремы и тактического скелета. Формулировка теоремы определяет утверждение, которое необходимо доказать, в то время как тактический скелет — это последовательность тактик, определяющая общую стратегию доказательства. Этот скелет служит направляющим контекстом для большой языковой модели, сужая пространство поиска возможных шагов доказательства и повышая вероятность успешного завершения доказательства в формальной системе, такой как Lean. \mathcal{S} = \{t_1, t_2, ..., t_n\} представляет собой тактический скелет, где t_i — i-я тактика.

Процесс генерации доказательств использует представленные входные данные — утверждение теоремы и схематичный тактический каркас — для автоматического завершения доказательства непосредственно в среде Lean. Ключевым преимуществом является интеграция с обширной математической библиотекой Mathlib, содержащей множество уже доказанных теорем и определений. Это позволяет модели использовать существующие результаты для построения новых доказательств, значительно ускоряя процесс и повышая вероятность успешного завершения. По сути, Mathlib выступает в качестве базы знаний, которую модель использует для поиска релевантных фактов и стратегий, необходимых для заполнения тактического каркаса и формирования полного, формально верифицируемого доказательства.

Оптимизация поиска доказательств с учетом ресурсов

Ограниченный бюджет на вычисления (Inferential Budget) представляет собой существенное препятствие при автоматизированном поиске доказательств. Доступные вычислительные ресурсы напрямую влияют на размер пространства поиска, которое может эффективно исследовать модель. Недостаточность ресурсов приводит к необходимости ограничения глубины и ширины поиска, что повышает риск упущения оптимальных или даже корректных доказательств. Это требует разработки стратегий, направленных на оптимизацию поиска в условиях ограниченных ресурсов, например, за счет приоритизации наиболее перспективных направлений и отказа от исследования заведомо неэффективных путей. Эффективное управление вычислительными ресурсами является ключевым фактором для достижения приемлемой производительности и масштабируемости систем автоматического доказательства теорем.

Промежуточное представление (IR) играет ключевую роль в оптимизации процесса генерации доказательств, предоставляя структурное руководство для модели. Вместо непосредственного поиска в пространстве всех возможных доказательств, IR позволяет модели оперировать с более компактным и структурированным представлением задачи. Это достигается за счет абстрагирования от деталей конкретной логической системы и представления доказательства в виде графа или дерева, где узлы соответствуют логическим шагам, а ребра — зависимостям между ними. Использование IR значительно сужает пространство поиска, позволяя модели эффективно исследовать наиболее перспективные пути к доказательству в условиях ограниченного вычислительного бюджета.

Для оптимизации поиска доказательств при ограниченных вычислительных ресурсах используется фиксированный график подсказок (Fixed Prompt Schedule). Данный подход предполагает применение разнообразных шаблонов тактик (Tactic Skeleton prompts) на каждом шаге генерации доказательства. Каждый шаблон тактики представляет собой предопределенную структуру, направляющую процесс поиска по определенному пути. Использование фиксированного графика позволяет систематически исследовать различные варианты доказательства, избегая случайного блуждания по пространству поиска и повышая эффективность генерации, несмотря на ограниченный бюджет на вычисления. Разнообразие шаблонов тактик обеспечивает исследование различных стратегий доказательства, в то время как фиксированный график гарантирует последовательное и контролируемое применение этих стратегий.

Оценка эффективности и анализ причин неудач

Для объективной оценки эффективности систем автоматического доказательства теорем, таких как нейронные решатели, необходима стандартизированная среда тестирования. В этом контексте был разработан ‘miniF2F Benchmark’ — набор формальных теорем, позволяющий сравнивать различные подходы к доказательству. Этот бенчмарк предоставляет унифицированный набор задач, исключая влияние специфических особенностей конкретных теорем на результаты оценки. Использование ‘miniF2F Benchmark’ гарантирует воспроизводимость экспериментов и позволяет исследователям достоверно оценивать прогресс в области автоматического доказательства теорем, что критически важно для дальнейшего развития нейронных решателей и их применения в верификации программного обеспечения и других областях.

В ходе тестирования на стандартизированном бенчмарке miniF2F, разработанная методика продемонстрировала успешность прохождения в 21.72% случаев. Это представляет собой значительное улучшение — на 43% относительно базового показателя в 15.16%. Достигнутое повышение свидетельствует об эффективности предложенного подхода к автоматическому доказательству теорем и его потенциале для решения более сложных задач в области формальной верификации и искусственного интеллекта. Результаты показывают, что новая методика способна находить доказательства там, где традиционные подходы оказываются неэффективными, открывая новые возможности для автоматизации процессов проверки корректности программного обеспечения и математических моделей.

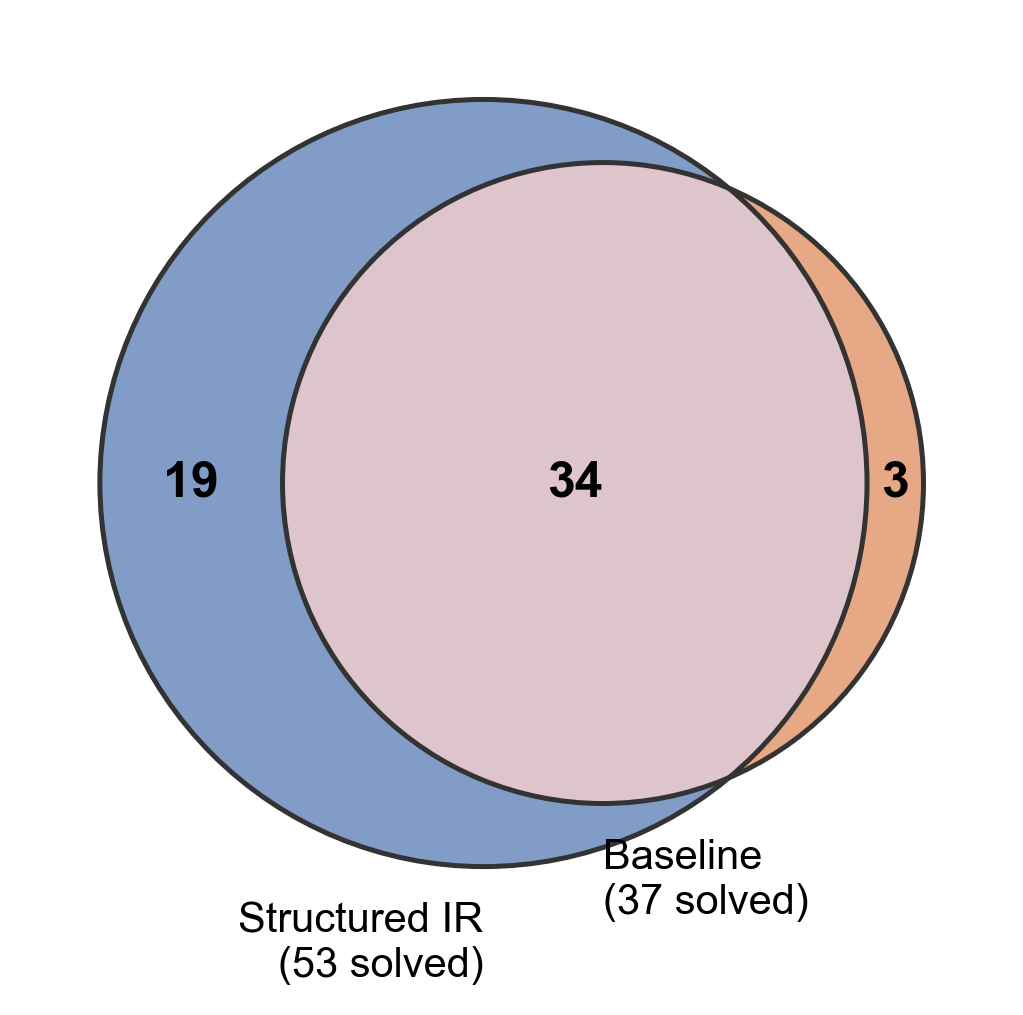

Исследование продемонстрировало значительное увеличение возможностей автоматического доказательства теорем благодаря использованию структурированного промежуточного представления (IR). В ходе экспериментов удалось доказать 19 уникальных теорем, что существенно превосходит результат, достигнутый базовой моделью, которая справилась лишь с 3 теоремами. Данный факт наглядно подтверждает эффективность предложенного подхода и его способность расширять границы автоматизированного рассуждения, позволяя решать более сложные задачи в области формальной верификации и искусственного интеллекта.

Для подтверждения достоверности полученного прироста в решении теорем был применен статистический тест МакНемара. Результаты теста показали статистическую значимость различий (p < 0.001 при двухстороннем тесте), что указывает на высокую вероятность того, что наблюдаемое улучшение производительности не является случайным. Это позволяет сделать вывод о том, что предложенный подход действительно обеспечивает более эффективное доказательство теорем по сравнению с базовым уровнем, и полученные результаты могут быть воспроизведены в аналогичных условиях с высокой степенью уверенности. Использование теста МакНемара, специально разработанного для сравнения результатов двух методов на одних и тех же данных, усиливает обоснованность сделанных выводов.

К нейро-символическому рассуждению и за его пределы

Данная работа закладывает основу для подхода, получившего название «Нейро-символическое рассуждение». Этот подход стремится объединить сильные стороны двух, казалось бы, несовместимых областей — формальной верификации и нейронных сетей. Традиционно, формальная верификация обеспечивает абсолютную точность и доказательство корректности решений, но требует четко определенных правил и ограничений, что делает ее негибкой в работе со сложными, неструктурированными данными. Нейронные сети, напротив, демонстрируют впечатляющую способность к обучению и адаптации к разнообразным входным данным, но часто лишены возможности предоставить формальное доказательство своей правоты. Нейро-символическое рассуждение направлено на преодоление этих ограничений путем интеграции преимуществ обоих подходов, создавая системы искусственного интеллекта, способные не только решать задачи, но и гарантировать достоверность полученных результатов, что критически важно для применения в областях, требующих высокой надежности и безопасности.

Дальнейшие исследования направлены на создание более эффективных алгоритмов поиска, способных ускорить процесс проверки математических доказательств и повысить производительность нейро-символических систем. Особое внимание уделяется расширению существующих математических библиотек и включению в них более широкого спектра теорем, аксиом и правил вывода. Это позволит искусственному интеллекту не только решать сложные задачи, но и формально доказывать корректность полученных решений, что критически важно для приложений, требующих высокой надежности, например, в области автоматизированной верификации программного обеспечения и критически важных систем. Разработка таких библиотек предполагает использование как существующих математических знаний, так и автоматическое извлечение новых фактов из научных публикаций и баз данных, что открывает перспективы для создания самообучающихся систем проверки.

В конечном счете, исследования направлены на создание искусственного интеллекта, способного не только находить решения задач, но и строго доказывать их корректность. Такой подход критически важен для обеспечения надёжности и доверия к системам ИИ, особенно в областях, где ошибки могут иметь серьёзные последствия, например, в медицине, финансах или автономном транспорте. Разработка методов формальной верификации решений, интегрированных с гибкостью нейронных сетей, позволит создавать ИИ, способный демонстрировать не просто успешность, но и обоснованность своих действий, что открывает путь к созданию действительно надёжных и заслуживающих доверия интеллектуальных систем. Такая возможность принципиально отличает будущие поколения ИИ от существующих, где верификация решений часто остаётся вне поля зрения.

Исследование демонстрирует, что навязывание структурных ограничений в процессе вывода значительно повышает эффективность систем, основанных на больших языковых моделях, даже при жестких вычислительных ограничениях. Это ставит под сомнение предположение о том, что масштаб является единственным фактором прогресса. Подобный подход к упрощению и направлению поиска решения перекликается с глубокой мыслью Анри Пуанкаре: «Самое сложное часто бывает самым ясным, если смотреть на него под правильным углом». В данном исследовании, “тактические скелеты” выступают как этот “правильный угол”, позволяя системе эффективно ориентироваться в сложном пространстве доказательств и избегать ненужных вычислений, что соответствует принципу достижения совершенства путем удаления избыточного.

Что дальше?

Представленные результаты, хотя и демонстрируют эффективность наложения структурных ограничений на процесс доказательства теорем, не снимают вопроса о фундаментальной природе формального мышления. Успех тактических каркасов намекает на то, что прогресс в области нейронных доказателей теорем не сводится исключительно к увеличению масштаба моделей. Скорее, необходимо глубже понимать, как структурировать поиск, чтобы он был более эффективным, а не просто более обширным. Неизбежно возникает вопрос: не является ли само стремление к универсальному решателю теорем иллюзией, а истинный прогресс заключается в разработке специализированных инструментов для конкретных областей знаний?

Ограничения, выявленные в ходе исследования, касаются прежде всего зависимости от качества исходных тактических шаблонов. Автоматическое генерирование или адаптация таких шаблонов, учитывающих особенности конкретной задачи, представляется перспективным направлением. Не менее важным является преодоление ограничений, связанных с вычислительными ресурсами. Более эффективные алгоритмы поиска и оптимизации, позволяющие обходить сложные участки доказательства, могут существенно повысить производительность.

В конечном счете, истинный критерий успеха нейронных доказателей теорем заключается не в их способности решать абстрактные задачи, а в их применимости к реальным проблемам верификации программного обеспечения и формализации математических знаний. Простое увеличение масштаба без учета этих практических потребностей рискует превратиться в бессмысленную гонку за цифрами.

Оригинал статьи: https://arxiv.org/pdf/2601.16172.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

2026-01-25 18:04