Автор: Денис Аветисян

В новой работе предложен эффективный подход к решению задач максимального апостериорного правдоподобия (MAP), сочетающий вероятностные схемы и методы, гарантирующие точность результата.

Представлен фреймворк для приближенного MAP-вывода, основанный на вероятностных схемах и принципах PAC-обучения, с теоретическими гарантиями качества решения и практическими улучшениями.

Поиск условного максимума распределения, известный как maximum\ a\ posteriori (MAP) оценка, остается сложной задачей вероятностного вывода. В работе ‘Probably Approximately Correct Maximum A Posteriori Inference’ представлен новый подход к решению MAP задач, использующий вероятностные схемы и методы PAC-обучения. Предложенные алгоритмы гарантированно находят оптимальные решения при заданных вычислительных ресурсах и характеризуются условиями применимости, оцениваемыми на основе выборочных данных. Могут ли эти методы существенно улучшить производительность существующих эвристик и открыть новые перспективы в области вероятностного вывода?

Вероятностное Моделирование: Основа Неопределённости

Многие задачи искусственного интеллекта требуют работы в условиях неопределенности, что обуславливает необходимость использования надежного вероятностного моделирования. В отличие от детерминированных систем, реальный мир часто предоставляет неполную или зашумленную информацию. Вероятностное моделирование позволяет представить знания о мире в виде вероятностных распределений, описывающих степень уверенности в различных исходах. Это особенно важно в таких областях, как распознавание речи, компьютерное зрение и медицинская диагностика, где входные данные подвержены естественным вариациям и ошибкам. Эффективное вероятностное моделирование позволяет алгоритмам не просто находить оптимальное решение, но и оценивать риски и принимать обоснованные решения даже при неполной информации, что делает их более надежными и адаптивными к изменяющимся условиям. P(A|B) = \frac{P(B|A)P(A)}{P(B)} — формула Байеса, являющаяся краеугольным камнем вероятностного подхода.

Процесс вероятностного вывода является ключевым для извлечения полезной информации из вероятностных моделей и оказывает существенное влияние на принятие решений. Этот процесс позволяет оценить вероятность различных исходов, учитывая имеющиеся данные и структуру модели. В основе вероятностного вывода лежит вычисление апостериорного распределения, которое отражает степень уверенности в гипотезах после учета наблюдаемых данных. P(H|E) = \frac{P(E|H)P(H)}{P(E)}, где P(H|E) — апостериорная вероятность гипотезы H при условии данных E, P(E|H) — правдоподобие данных при данной гипотезе, P(H) — априорная вероятность гипотезы, а P(E) — вероятность данных. Эффективные методы вероятностного вывода, такие как методы Монте-Карло или вариационные методы, позволяют решать сложные задачи в различных областях, включая машинное обучение, робототехнику и медицинскую диагностику, обеспечивая надежные и обоснованные решения даже в условиях неопределенности.

Пробабилистические графические модели представляют собой мощный инструмент для визуализации и анализа сложных взаимосвязей между переменными. Эти модели, использующие графы для отображения зависимостей, позволяют эффективно представлять вероятностные распределения и осуществлять логический вывод в условиях неопределённости. Благодаря своей структуре, они упрощают сложные расчеты, позволяя моделировать системы, в которых отдельные переменные оказывают влияние друг на друга. P(X,Y) = P(Y|X)P(X) — пример отображения условной вероятности в такой модели. Использование графов облегчает понимание и интерпретацию взаимосвязей, что особенно важно при решении задач в областях, таких как машинное обучение, искусственный интеллект и анализ данных, где требуется учитывать множество факторов и их влияние друг на друга.

Вероятностные Схемы: Компактное Представление Распределений

Пробабилистические схемы (Probabilistic Circuits) представляют собой направленные ациклические графы (DAG), используемые для компактного представления совместных распределений вероятностей. Вместо явного перечисления всех возможных комбинаций значений переменных, схема позволяет выразить совместное распределение P(X_1, ..., X_n) через локальные функции (такие как таблицы вероятностей или параметрические функции) на каждом узле графа. Эта структура позволяет эффективно вычислять вероятности, маргинализации и условные вероятности, поскольку вычисления могут быть выполнены посредством локальных операций на узлах и распространения информации по графу, избегая экспоненциальной сложности, связанной с полным перебором пространства состояний. Такое представление особенно полезно при работе с высокоразмерными данными, где явное представление совместного распределения становится непрактичным.

Различные структуры вероятностных схем, такие как Smooth PC, Decomposable PC и Deterministic PC, демонстрируют компромисс между выразительностью и вычислительной сложностью. Smooth PC обеспечивают высокую выразительность за счет использования гладких функций, что может привести к более сложным вычислениям. Decomposable PC, напротив, ограничивают структуру схемы, упрощая вычисления, но уменьшая способность представлять сложные зависимости. Deterministic PC представляют собой наиболее ограниченный тип, где каждый узел имеет детерминированную функцию, что приводит к минимальной вычислительной сложности, но также и к самому низкому уровню выразительности. Выбор конкретной структуры зависит от требований задачи и доступных вычислительных ресурсов; более выразительные схемы позволяют представлять более сложные распределения, но требуют больших затрат на вычисления.

Сети сумм-произведений (Sum-Product Networks, SPN) представляют собой специализированный тип вероятностных схем, получивших широкое распространение благодаря способности эффективно представлять сложные распределения вероятностей. В отличие от общих вероятностных схем, SPN характеризуются строгой структурой, состоящей из слоев суммирования и умножения. Суммирующие узлы объединяют вероятности независимых событий, а узлы умножения вычисляют совместную вероятность. Такая структура позволяет выполнять точный вывод вероятностей и упрощает вычисление P(x) для заданного набора переменных x. Преимущества SPN включают способность представлять распределения с высокой размерностью и эффективное вычисление маржинальных и условных вероятностей, что делает их полезными в задачах машинного обучения и искусственного интеллекта.

Гарантированная Производительность: PAC-MAP и За Его Пределами

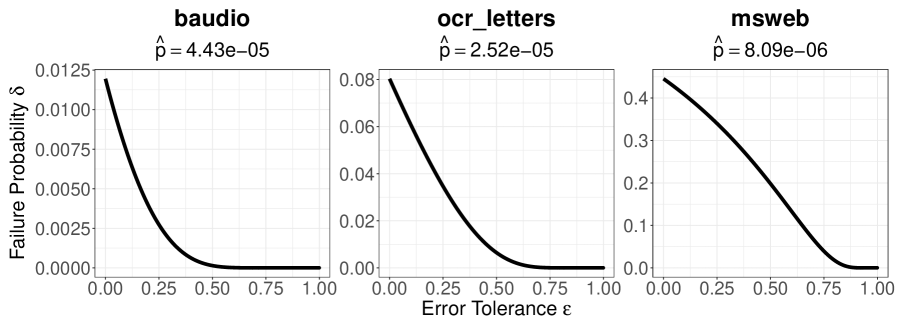

PAC-MAP (Probably Approximately Correct — Maximum a Posteriori) предоставляет теоретические гарантии нахождения решений в пределах заданной погрешности и с заданной вероятностью ошибки, что критически важно для надежного вывода. Эта гарантия выражается в виде вероятностной верхней границы на отклонение найденного решения от истинного максимума апостериорной вероятности. Формально, PAC-гарантия обеспечивает, что найденное решение находится в пределах коэффициента (1-ε) от истинного мода с вероятностью не менее (1-δ), где ε определяет допустимую погрешность, а δ — допустимый уровень вероятности ошибки. Наличие такой гарантии позволяет оценивать надежность полученных результатов и контролировать риски, связанные с принятием решений на основе этих результатов.

Гарантии, предоставляемые PAC-MAP, опираются на понятия минимальной энтропии (Min-Entropy) и парето-фронта для анализа пространства решений и компромиссов между производительностью и точностью. Минимальная энтропия, обозначаемая как h, характеризует сложность распределения вероятностей и влияет на вычислительную сложность поиска решений; для достижения полиномиальной вычислительной сложности требуется, чтобы h = O(log n), где n — размерность пространства. Парето-фронт, в свою очередь, представляет собой множество не доминируемых решений, позволяя оценить различные варианты с точки зрения их эффективности и точности, и выбирать оптимальные решения в зависимости от заданных критериев.

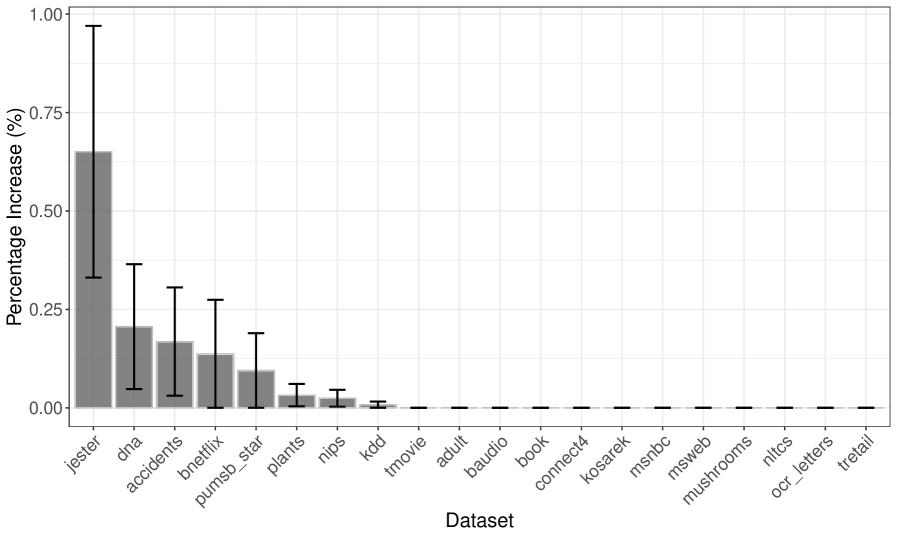

Метод Smooth PAC-MAP расширяет базовый PAC-MAP за счет использования методов выборки, таких как независимая выборка (Independent Sampling), для повышения качества решения и масштабируемости алгоритма. В отличие от базового подхода, Smooth PAC-MAP позволяет добиться вычислительной сложности, пропорциональной количеству выборок — O(M), где M — число использованных выборок. Это улучшение позволяет эффективно работать с более сложными задачами и большими объемами данных, сохраняя при этом теоретические гарантии нахождения решения в пределах заданной погрешности и вероятности отказа.

В рамках PAC-MAP предоставляется вероятностная гарантия (PAC-гарантия) на качество полученного решения. Эта гарантия утверждает, что найденное решение будет отличаться от истинного модального значения не более чем на фактор (1 - \epsilon) с вероятностью не менее (1 - \delta). Параметр ε определяет допустимую погрешность, а параметр δ — вероятность ошибки. Таким образом, PAC-гарантия обеспечивает верхнюю границу для отклонения решения от оптимального, что критически важно для приложений, требующих надежных и предсказуемых результатов.

Вычислительная сложность алгоритмов, основанных на PAC-MAP, напрямую зависит от минимальной энтропии (h) входных данных. Для обеспечения полиномиального времени работы алгоритма необходимо, чтобы минимальная энтропия удовлетворяла условию h = O(log n), где n — размерность пространства признаков. Если минимальная энтропия ниже указанного порога, время работы алгоритма может стать экспоненциальным, что делает его непрактичным для задач с высокой размерностью или низкой информативностью данных. Это ограничение связано с необходимостью эффективного исследования пространства решений и предотвращения переобучения.

Влияние и Перспективы Развития

Сочетание вероятностных схем и алгоритмов гарантированной логики открывает путь к созданию более надежных и устойчивых систем искусственного интеллекта. В отличие от традиционных подходов, полагающихся на статистические закономерности, данная методология позволяет не только оценивать вероятность различных исходов, но и формально доказывать корректность принимаемых решений. Это достигается за счет представления знаний в виде вероятностных цепей, где каждый узел отражает неопределённость, а алгоритмы гарантированной логики обеспечивают возможность проверки выводов на соответствие заданным критериям. Такой симбиоз позволяет существенно снизить риски, связанные с ошибками и непредсказуемым поведением ИИ, делая системы более прозрачными и заслуживающими доверия, особенно в критически важных областях, где надежность является первостепенной задачей.

Особую ценность предложенный подход демонстрирует в областях, где критически важны как высокая точность, так и прозрачность принимаемых решений. В медицинской диагностике, например, возможность не только выставить диагноз, но и предоставить чёткое обоснование, основанное на вероятностных вычислениях, существенно повышает доверие к системе и позволяет врачам принимать более обоснованные решения. Аналогично, в финансовом моделировании, где последствия ошибок могут быть значительными, гарантированная логическая основа и объяснимость алгоритма позволяют оценивать риски и прогнозировать изменения на рынке с большей уверенностью. Такой симбиоз надежности и прозрачности делает вероятностные схемы особенно перспективными для применения в сферах, требующих безошибочности и глубокого понимания процессов принятия решений.

Дальнейшие исследования направлены на расширение возможностей применения вероятностных схем и гарантированных алгоритмов вывода к моделям и наборам данных ещё большей сложности. Учёные планируют изучать новые архитектуры схем, стремясь к повышению эффективности и масштабируемости этих методов. Особое внимание будет уделено разработке схем, способных обрабатывать многомерные данные и учитывать сложные зависимости между переменными. Это позволит создавать более надёжные и точные системы искусственного интеллекта, применимые в различных областях, от обработки естественного языка до анализа больших данных, открывая новые перспективы для развития интеллектуальных технологий.

В этой работе, как и во многих других, авторы пытаются обуздать неукротимую сложность вероятностного вывода. Идея о приближенных решениях MAP-задач с использованием вероятностных схем и техник PAC-обучения, конечно, элегантна. Но, как показывает практика, любая «гарантия» качества решения — лишь иллюзия, пока код не встретит реальный мир. Вспоминается высказывание Эдсгера Дейкстры: «Программирование — это не столько искусство, сколько ремесло». Здесь же, авторы, словно искусные ремесленники, пытаются выточить инструмент, способный справиться с непредсказуемостью данных. И пусть теоретические гарантии не всегда совпадают с реальностью, стремление к точности, даже приблизительной, заслуживает уважения. Ведь, в конечном счете, именно этот компромисс между теорией и практикой позволяет системам продолжать работать, несмотря на все понедельники.

Что дальше?

Представленная работа, безусловно, элегантна. Теоретические гарантии качества решения для задачи Maximum a Posteriori, подкреплённые методами PAC-обучения и вероятностными схемами, — это, конечно, приятно. Однако, как показывает опыт, любая абстракция умирает от продакшена. Неизбежно возникнет вопрос о масштабируемости: как эта изящная конструкция поведет себя при действительно больших графах и сложностях? И сколько ресурсов потребуется для достижения этих «вероятностных» гарантий в реальном времени?

Вполне вероятно, что следующая волна исследований будет посвящена компромиссам между точностью и вычислительной сложностью. Попытки упростить вероятностные схемы, разработать более эффективные алгоритмы приближённого вывода или, возможно, найти способы «ограничить» пространство поиска, чтобы хоть как-то удержать эту красоту в пределах разумного. Всё, что можно задеплоить — однажды упадёт, но умирает ли оно красиво — вопрос, требующий дальнейшего изучения.

Не стоит забывать и о практической стороне. Каждое новое решение порождает новый техдолг. И когда первые энтузиасты уйдут, а поддержание системы ляжет на плечи тех, кто не видел идеальных диаграмм, неизбежно возникнут вопросы совместимости, интеграции и, конечно же, стоимости. Это не критика, а констатация факта: всё хорошее когда-нибудь заканчивается.

Оригинал статьи: https://arxiv.org/pdf/2601.16083.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

2026-01-25 23:22