Автор: Денис Аветисян

Исследование объединяет дифференцируемое программирование и теорию двойственности для создания эффективного и масштабируемого фреймворка решения оптимизационных задач.

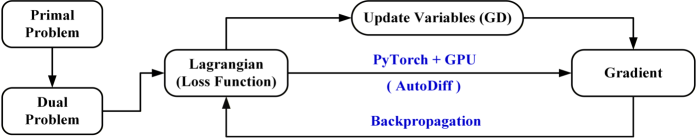

Автоматическое дифференцирование и методы примитивно-дуального типа для решения конических программ с использованием PyTorch.

Решение крупномасштабных задач оптимизации традиционно требует масштабируемых методов первого порядка с минимальными затратами на итерацию. В работе ‘Learning to Optimize by Differentiable Programming’ рассматривается новый подход: использование дифференцируемого программирования не только для реализации алгоритмов, но и для их проектирования. Современные фреймворки, такие как PyTorch и TensorFlow, позволяют обучать и адаптировать итерационные схемы, основанные на дуальности Фенхеля-Рокафеляра, что улучшает сходимость и качество решений. Возможно ли создание универсальной платформы для оптимизации, сочетающей преимущества дифференцируемого программирования и теории дуальности, и какие новые горизонты она откроет для решения сложных вычислительных задач?

За гранью традиционной оптимизации: новый взгляд на сложность

Многие задачи, возникающие в реальном мире — от управления логистическими цепочками до разработки новых материалов и оптимизации финансовых портфелей — требуют нахождения наилучшего решения при наличии сложной системы ограничений. Простые методы оптимизации, такие как градиентный спуск, часто оказываются неэффективными в подобных случаях, поскольку не способны учитывать взаимосвязи между переменными и сложность этих ограничений. Например, при проектировании самолета необходимо учитывать множество факторов — аэродинамику, прочность, вес, стоимость — и соблюдать жесткие ограничения по безопасности и производительности. Попытка решить такую задачу стандартными алгоритмами может привести к застреванию в локальных оптимумах или к нереалистичным решениям, не удовлетворяющим всем требованиям. Поэтому для успешного решения подобных задач требуется разработка и применение более совершенных методов оптимизации, способных эффективно работать в условиях высокой сложности и нелинейности.

Традиционные методы оптимизации, несмотря на свою эффективность в простых задачах, часто сталкиваются с серьезными трудностями при работе с высокоразмерными пространствами данных. По мере увеличения числа переменных и ограничений, вычислительная сложность алгоритмов экспоненциально возрастает, что приводит к замедлению работы и снижению точности. В таких условиях, даже незначительные изменения во входных данных могут приводить к существенным отклонениям в решении, что свидетельствует о низкой устойчивости. Например, при оптимизации сложной логистической сети или моделировании финансовых рынков, стандартные подходы могут оказаться непрактичными из-за огромного числа параметров и необходимости обработки больших объемов информации. Это требует разработки новых алгоритмов, способных эффективно масштабироваться и сохранять надежность даже в самых сложных условиях.

Переход к алгоритмам, использующим принципы двойственности и структуры «первичной-двойственной» задачи, представляется ключевым для преодоления сложностей современной оптимизации. Вместо поиска решения непосредственно в исходном пространстве, эти методы оперируют с двойственной задачей, которая часто оказывается более удобной для анализа и решения. max_{x} f(x) и min_{y} g(y) — примеры исходной и двойственной задач, где решение одной позволяет получить информацию о решении другой. Такой подход обеспечивает не только повышение эффективности алгоритмов в задачах с большим количеством переменных и ограничений, но и улучшает их устойчивость к шумам и погрешностям данных. Использование примитивно-двойственных алгоритмов позволяет находить оптимальные решения, удовлетворяющие всем заданным ограничениям, и открывает новые возможности для решения сложных практических задач в различных областях науки и техники.

Дифференцируемое программирование: взлом градиентной оптимизации

Дифференцируемое программирование рассматривает дифференцирование как фундаментальную операцию, позволяющую осуществлять оптимизацию на основе градиентов через сложные вычислительные графы. В отличие от традиционного программирования, где дифференцирование реализуется вручную или с использованием символьных вычислений, дифференцируемое программирование позволяет автоматически вычислять производные любой функции, представленной в виде вычислительного графа. Этот подход позволяет эффективно находить оптимальные значения параметров в сложных системах, таких как нейронные сети, путем вычисления градиента функции потерь по отношению к этим параметрам. \nabla L — градиент функции потерь L. Вычислительный граф представляет собой структуру данных, которая явно определяет порядок операций, необходимых для вычисления выходного значения, что необходимо для эффективного вычисления градиентов с использованием алгоритма обратного распространения ошибки.

Фреймворки, такие как PyTorch, предоставляют инструменты для автоматического вычисления производных, что существенно упрощает реализацию алгоритмов оптимизации. Вместо ручного вывода аналитических выражений для градиентов, PyTorch использует механизм автоматического дифференцирования (automatic differentiation), отслеживая операции, выполненные над тензорами, и строя вычислительный граф. Этот граф позволяет эффективно вычислять градиенты с использованием обратного распространения ошибки (backpropagation), избавляя разработчика от необходимости вручную реализовывать производные. В результате, алгоритмы оптимизации, такие как градиентный спуск \nabla J(w) , могут быть легко применены к сложным моделям и функциям потерь, ускоряя процесс обучения и разработки.

Использование автоматического дифференцирования и графов вычислений позволяет эффективно и точно оптимизировать сложные системы. Автоматическое дифференцирование, реализованное в таких фреймворках, как PyTorch и TensorFlow, позволяет вычислять градиенты функций, даже если они включают в себя недифференцируемые операции или сложные вложенные структуры. Графы вычислений представляют собой структурированное представление вычислений, что позволяет эффективно отслеживать зависимости между переменными и вычислять градиенты с использованием обратного распространения ошибки. Это особенно полезно для оптимизации моделей машинного обучения, где необходимо минимизировать функцию потерь путем настройки параметров модели. \frac{dF}{dx} — пример вычисления производной функции F по переменной x, которое автоматизируется посредством данной технологии.

Примально-дуальные методы и коническое программирование: синергия возможностей

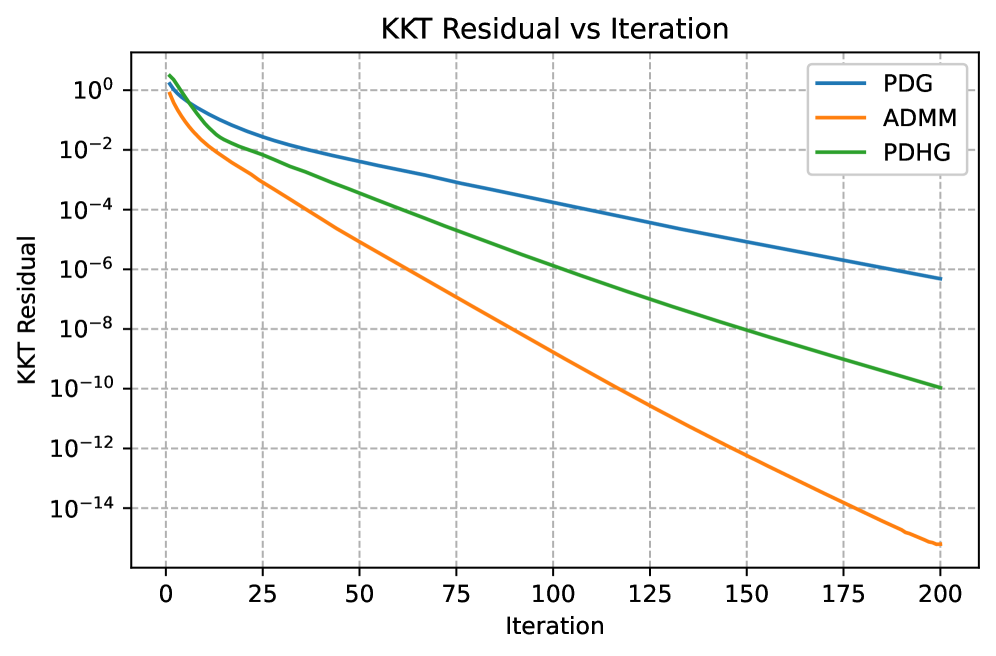

Алгоритмы семейства «Примально-Дуальный» (включая варианты, такие как ADMM и PDHG) эффективно решают задачи оптимизации с ограничениями за счет одновременного обновления как примальных, так и дуальных переменных. Такой подход позволяет напрямую работать с ограничениями задачи, вводя дуальные переменные, соответствующие каждому ограничению. В процессе итераций алгоритм минимизирует функцию Лагранжа, корректируя примальные переменные для улучшения выполнения ограничений и дуальные переменные для учета нарушений ограничений. Одновременное обновление обеспечивает более быструю сходимость и стабильность по сравнению с последовательными методами, особенно в задачах больших размеров и сложности. L(x, \lambda) = f(x) + \sum_{i} \lambda_i g_i(x) , где x — примальные переменные, λ — дуальные переменные, f(x) — целевая функция, а g_i(x) — ограничения.

Коническое программирование представляет собой обобщенный подход к решению широкого класса задач оптимизации. В рамках этой парадигмы, линейное программирование, программирование второго порядка конуса и полунеопределенное программирование рассматриваются как частные случаи, определяемые конкретным типом конуса, используемого для ограничения пространства допустимых решений. В частности, линейное программирование использует полиэдральные конусы, программирование второго порядка конуса — конусы второго порядка, а полунеопределенное программирование — конус неотрицательной определенности. Это позволяет разрабатывать единые алгоритмы и программные инструменты, применимые ко всем перечисленным типам задач, что значительно упрощает их решение и анализ. Математически, общая форма конической программы выглядит следующим образом: минимизировать f(x) при условии Ax = b и g_i(x) \in K_i , где K_i — замкнутые конусы.

Сочетание примально-дуальных методов и конического программирования представляет собой надежный и эффективный подход к решению сложных задач оптимизации. Данный подход успешно применяется в задачах высокой размерности, таких как оптимальное управление потоками мощности в энергосистемах и верификация нейронных сетей. Эффективность обусловлена способностью примально-дуальных алгоритмов эффективно обрабатывать ограничения, а коническое программирование позволяет унифицировать различные типы задач, включая линейное, квадратичное и программирование второго порядка, что значительно упрощает разработку и реализацию алгоритмов. В задачах оптимального управления потоками мощности, коническое программирование позволяет моделировать нелинейные характеристики энергосистемы в виде набора линейных ограничений, а примально-дуальные методы обеспечивают быструю сходимость к оптимальному решению. Аналогично, в задачах верификации нейронных сетей, данный подход позволяет эффективно проверять свойства сети, такие как робастность к возмущениям, за счет решения задачи конического программирования с использованием примально-дуального алгоритма.

Применение и перспективы: за горизонтом возможностей

Сочетание дифференцируемого программирования с примально-дуальными методами и коническим программированием открывает широкие возможности для решения задач в различных областях. В энергетике это позволяет оптимизировать потоки мощности, обеспечивая стабильность и эффективность энергосистем. В сфере машинного обучения, данный подход находит применение в верификации нейронных сетей, гарантируя их надежность и предсказуемость. Кроме того, методика эффективно справляется с задачей неотрицательной наименьших квадратов, актуальной в обработке сигналов и статистическом анализе. Интеграция этих инструментов позволяет создавать масштабируемые и гибкие решения для сложных оптимизационных задач, преодолевая ограничения традиционных методов.

В рамках разработанного подхода, методы лапласианской регуляризации легко интегрируются в оптимизационные алгоритмы, значительно повышая их устойчивость и эффективность. Лапласианская регуляризация, по сути, накладывает ограничение на гладкость решения, что особенно ценно в задачах, где шум или неполнота данных могут привести к нестабильным результатам. Интеграция происходит за счет включения лапласиана в целевую функцию, что позволяет алгоритму находить решения, которые не только минимизируют ошибку, но и обладают свойством сглаживания. Это приводит к улучшению обобщающей способности модели, особенно в условиях ограниченных данных, и повышает надежность получаемых результатов. В итоге, применение лапласианской регуляризации в сочетании с дифференцируемым программированием и примально-дуальными методами открывает новые возможности для решения сложных оптимизационных задач в различных областях, включая машинное обучение и управление системами.

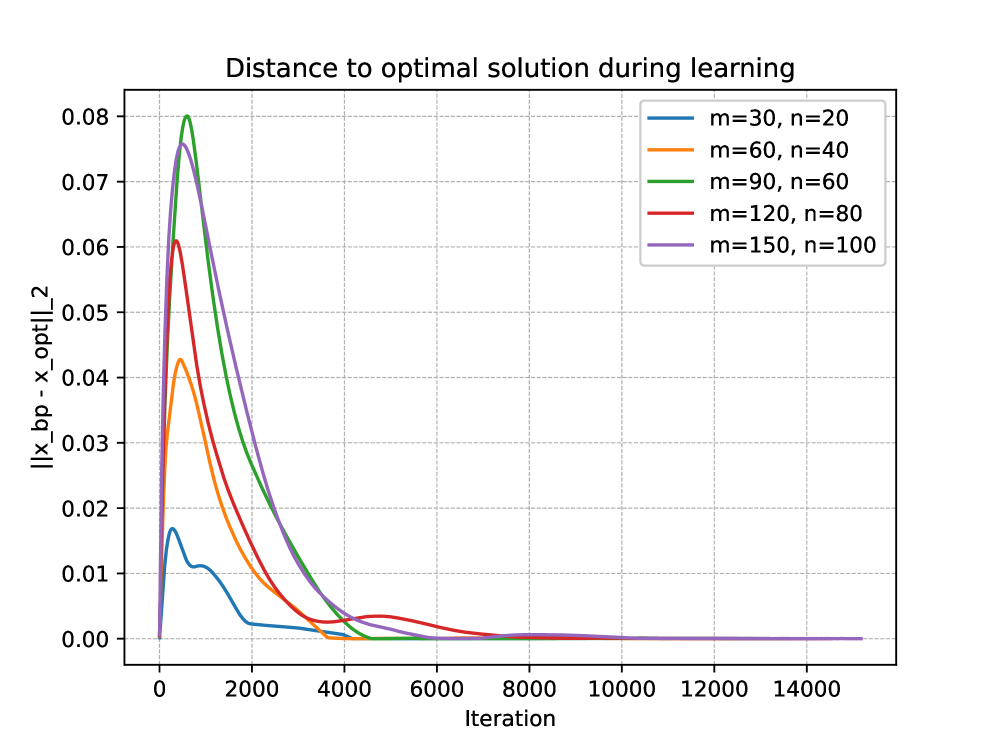

Предложенный унифицированный подход к оптимизации, объединяющий дифференцируемое программирование, теорию двойственности и методы первого порядка, открывает новые возможности для решения сложных задач. Данная методология позволяет создавать сквозные обучаемые решения, демонстрируя превосходную масштабируемость и более быструю сходимость по сравнению с традиционными алгоритмами. Особенностью является использование теории двойственности не только для оптимизации, но и для получения проверяемых сертификатов оптимальности, что позволяет оценивать качество полученных решений и обеспечивать надежность результатов. max_{x} f(x) Такой подход особенно актуален в задачах, требующих высокой точности и надежности, например, в системах управления, машинном обучении и анализе данных.

Исследование демонстрирует, что применение дифференцируемого программирования к задачам оптимизации, в частности, к коническим программам, открывает новые горизонты в эффективности и масштабируемости. Авторы подчеркивают важность автоматического дифференцирования и использования таких инструментов, как PyTorch, для реализации примально-дуальных методов. Как метко заметил Джон Маккарти: «Искусственный интеллект — это не создание машин, думающих как люди, а создание машин, которые делают то, что люди не могут.» Эта фраза отражает суть подхода, описанного в статье: преодоление ограничений традиционных методов оптимизации посредством инновационных вычислительных стратегий и возможности автоматизации, что позволяет решать задачи, недоступные для человека из-за их сложности или объема.

Что Дальше?

Представленная работа, несомненно, открывает новые пути для решения задач оптимизации, однако иллюзия полной автоматизации требует критического осмысления. Возможность дифференцировать оптимизационные процедуры — это лишь один инструмент, и его эффективность напрямую зависит от корректной постановки задачи и адекватности выбранной модели. Утверждение о масштабируемости, хоть и подкреплено практическими результатами, нуждается в дальнейшей проверке на задачах, радикально отличающихся от рассмотренных в статье — особенно в контексте негладких оптимизационных ландшафтов и задач с высокой размерностью.

Истинная безопасность и надежность подобных систем, как показывает опыт, заключаются не в их непрозрачности, а в возможности детального анализа и контроля. Автоматическое дифференцирование — это мощный механизм, но он не освобождает от необходимости понимать, что именно оптимизируется и какие скрытые предположения лежат в основе алгоритма. В будущем, вероятно, потребуется разработка инструментов для верификации и отладки дифференцируемых оптимизаторов, позволяющих выявлять и устранять потенциальные ошибки и уязвимости.

В конечном итоге, дифференцируемое программирование — это не замена традиционным методам, а расширение арсенала инструментов. Задача исследователей — не просто автоматизировать оптимизацию, а создать систему, позволяющую человеку эффективно взаимодействовать с ней, контролировать процесс и получать надежные результаты. И тогда, возможно, удастся взломать не только оптимизационную задачу, но и саму природу вычислений.

Оригинал статьи: https://arxiv.org/pdf/2601.16510.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

2026-01-26 19:41