Автор: Денис Аветисян

Исследование показывает, могут ли узкие нейронные сети, обученные предсказывать операции в конечных группах, выявить абстрактные алгебраические концепции, такие как коммутативность и подгрупповая структура.

Работа посвящена изучению групповых структур, выученных узкими нейронными сетями при обучении на операциях в конечных группах.

В то время как современные исследования в области искусственного интеллекта часто ориентированы на решение конкретных задач, процесс математического открытия обычно носит более открытый характер. В работе, озаглавленной ‘Can Neural Networks Learn Small Algebraic Worlds? An Investigation Into the Group-theoretic Structures Learned By Narrow Models Trained To Predict Group Operations’, авторы исследуют способность узких нейронных сетей, обученных предсказывать операции в конечных группах, к извлечению абстрактных алгебраических свойств, таких как коммутативность и структура подгрупп. Полученные результаты свидетельствуют о том, что модели способны усваивать определенные группотеоретические понятия, хотя и не всегда надежно. Возможно ли, что даже небольшие нейронные сети способны «дистиллировать» интересные абстрактные структуры из новых математических объектов, открывая новые пути для применения ИИ в математических исследованиях?

Математическая Элегантность: Абстрактная Алгебра в Вычислительных Задачах

Многие вычислительные задачи, кажущиеся сложными и громоздкими, обретают изящное и лаконичное решение при взгляде сквозь призму абстрактной алгебры, в частности, теории групп. Этот подход позволяет выявить скрытые симметрии и закономерности в данных, что существенно упрощает процесс вычислений. Вместо непосредственного манипулирования числами или объектами, задача формулируется в терминах групп — математических структур, описывающих операции, сохраняющие определенные свойства. Например, преобразования изображений, криптографические алгоритмы и даже задачи оптимизации могут быть элегантно представлены как операции над элементами группы G, где \star — групповая операция, а существует нейтральный элемент e такой, что a \star e = e \star a = a для любого a \in G. Использование теории групп позволяет применять мощный математический аппарат для анализа и решения этих задач, часто приводя к более эффективным и элегантным алгоритмам.

Абстрактные алгебраические понятия, такие как операция группы, нейтральный элемент и коммутативность, предоставляют мощный инструментарий для анализа симметрии и взаимосвязей в различных областях науки. Операция группы определяет способ объединения элементов, нейтральный элемент не изменяет результат при объединении с любым другим элементом, а коммутативность указывает на то, что порядок объединения не имеет значения. Эти, казалось бы, простые правила позволяют математически описывать и изучать симметрии, встречающиеся в геометрии, физике и химии, а также сложные взаимосвязи в дискретных структурах. Например, симметрия вращения объекта может быть представлена группой, где операция — это вращение, а элементы — различные углы вращения. Понимание этих фундаментальных принципов открывает возможности для решения сложных задач, лежащих в основе многих современных технологий и научных исследований, позволяя выявлять скрытые закономерности и строить эффективные математические модели.

Соединяя Алгебру и Нейронные Сети: Групповые Операции в Глубоком Обучении

Современные архитектуры глубокого обучения, такие как Transformers и MLPs, можно рассматривать как реализации операций группы над данными. В математическом смысле, операции внутри этих сетей — линейные преобразования, перемешивания и комбинирования данных — соответствуют элементам группы. Например, веса в слоях нейронной сети представляют собой параметры этих преобразований. Последовательное применение слоев эквивалентно последовательному применению операций группы, позволяя сети преобразовывать входные данные в желаемый выход. G — группа преобразований, \textbf{x} — входные данные, \textbf{y} = f(\textbf{x}) — выход, где f представляет собой функцию, реализованную нейронной сетью.

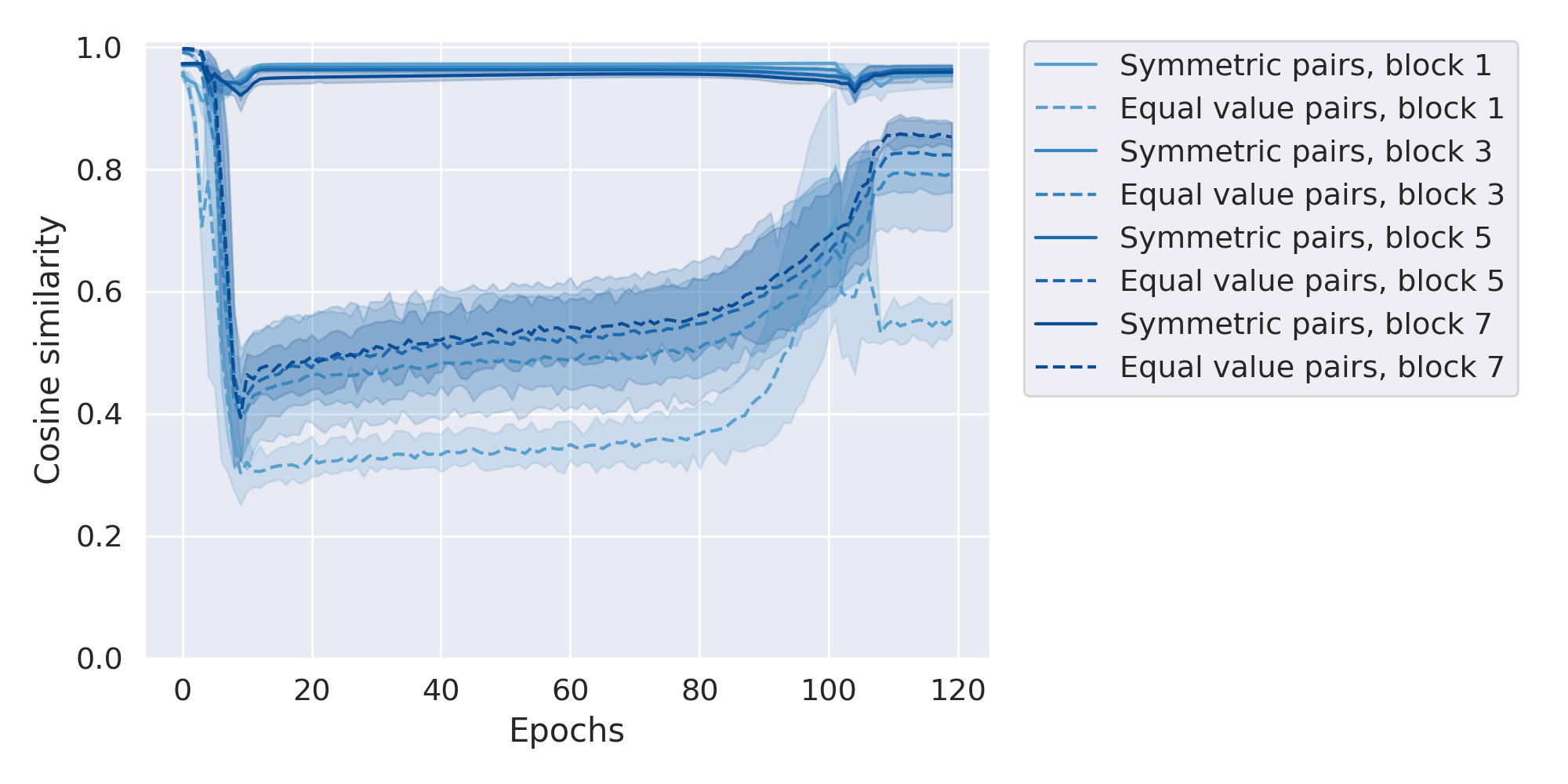

Нейронные сети, такие как Трансформеры и Многослойные Персептроны, в процессе обучения неявно исследуют симметрии, присутствующие в данных. Это означает, что сеть автоматически адаптируется к различным преобразованиям данных, сохраняющим определенные свойства, например, инвариантность к сдвигам или поворотам. Однако, данный процесс происходит без явного контроля со стороны разработчика над тем, какие именно симметрии сеть использует и как она их применяет. Отсутствие явного контроля может приводить к неэффективному использованию данных и снижению обобщающей способности модели, поскольку сеть может «забывать» или игнорировать важные симметрии, которые могли бы улучшить ее производительность.

Функция потерь в нейронных сетях играет ключевую роль в приближении к группово-теоретическим соотношениям, не требуя их явного кодирования. В процессе обучения, функция потерь оценивает отклонение выходных данных сети от целевых значений, и на основе этой оценки корректирует веса сети. Таким образом, сеть не «знает» о существовании каких-либо групп или симметрий в данных, но, минимизируя функцию потерь, она неявно учится представлять и использовать эти отношения. Например, инвариантность к сдвигу или вращению может быть достигнута за счет соответствующего выбора архитектуры сети и функции потерь, даже если эти свойства не были явно запрограммированы. Эффективность этого подхода зависит от выбора подходящей функции потерь, способной «направить» процесс обучения к желаемым групповым свойствам, и от способности сети к представлению этих свойств.

Исследование Подгрупповой Структуры для Обучения Представлений

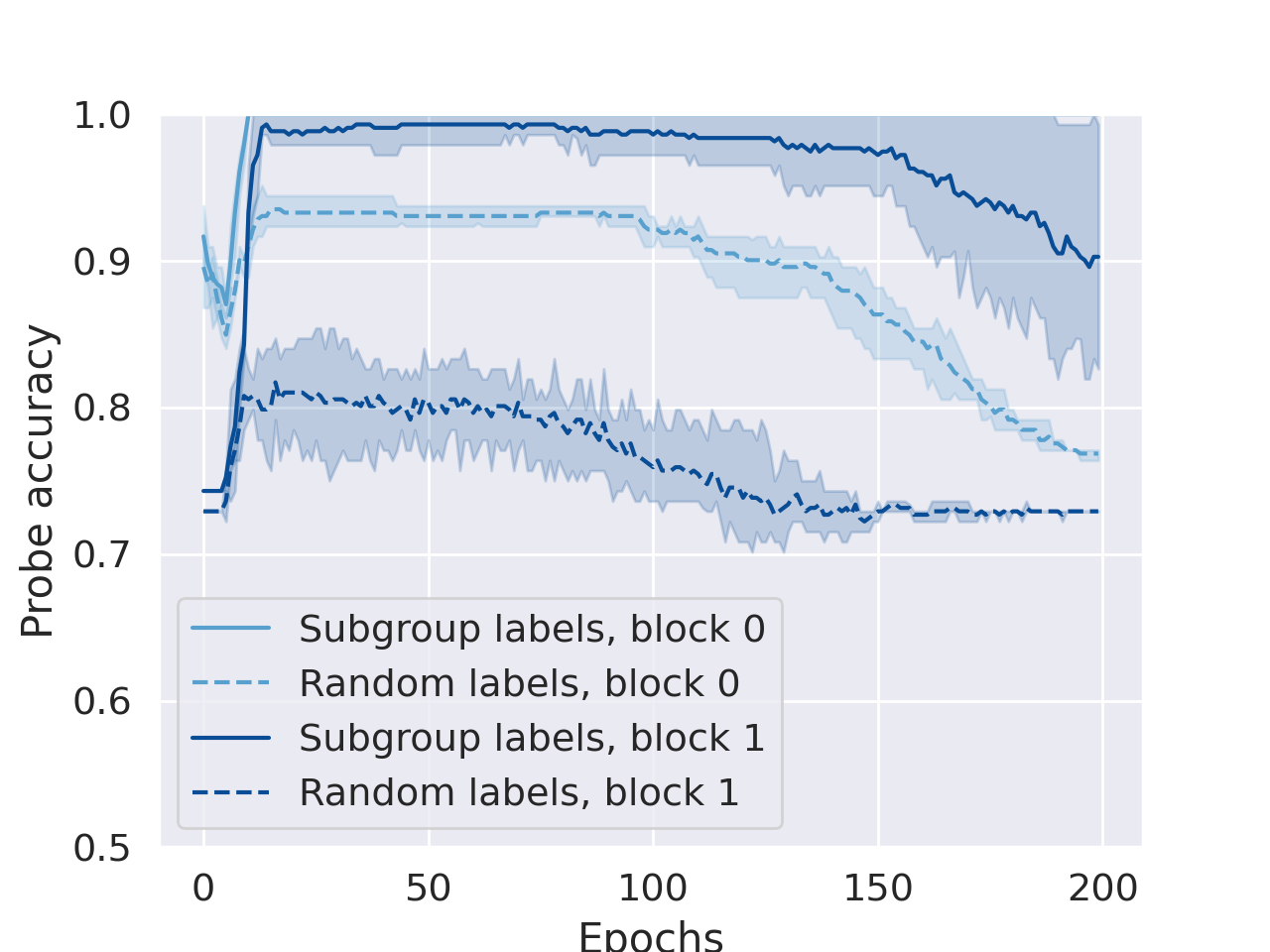

Анализ схожести представлений, полученных нейронными сетями, с помощью линейного классификатора (Linear Probe) демонстрирует, что сети неявно исследуют структуры подгрупп. Высокая точность линейного классификатора, превышающая уровень случайного угадывания, указывает на то, что нейронные сети способны различать различные подгруппы данных. Этот результат свидетельствует о том, что обучение сети приводит к формированию представлений, которые отражают лежащие в основе алгебраические свойства данных, даже если эти свойства не были явно заданы в процессе обучения. Метод Linear Probe позволяет оценить качество этих неявных представлений и подтвердить, что сеть действительно изучает значимые структуры данных.

Концепции циклических групп, симметрических групп и диэдральных групп могут быть использованы в качестве шаблонов для проектирования более эффективных архитектур нейронных сетей. Применение принципов групповой теории позволяет создавать структуры, оптимизированные для определенных типов преобразований данных. Например, симметричные группы S_n описывают все возможные перестановки n элементов, что может быть полезно при обработке данных, не зависящих от порядка. Диэдральные группы D_n описывают симметрии правильных n-угольников и могут быть применены к задачам, связанным с геометрическими преобразованиями или вращательной инвариантностью. Использование этих групп в качестве основы для проектирования сетей позволяет снизить количество параметров, повысить обобщающую способность и улучшить производительность, особенно в задачах, где присутствует симметрия или определенные преобразования данных являются важными.

Динамика обучения нейронных сетей может рассматриваться как поиск оптимальных представлений в рамках групповых теоретических пространств. Эксперименты показали, что точность линейного зонда (linear probe) увеличивается с увеличением длительности обучения (более 100 эпох) на подгруппах, таких как чередующаяся группа (S5). Это свидетельствует о необходимости достаточно продолжительного обучения для эффективного захвата и использования специфических алгебраических структур, представленных в данных и, как следствие, для формирования более качественных представлений. Более длительное обучение позволяет сети более полно исследовать пространство возможных представлений и выявить закономерности, соответствующие свойствам исследуемой группы.

Повышение Обобщающей Способности через Групповую Эквивариантность

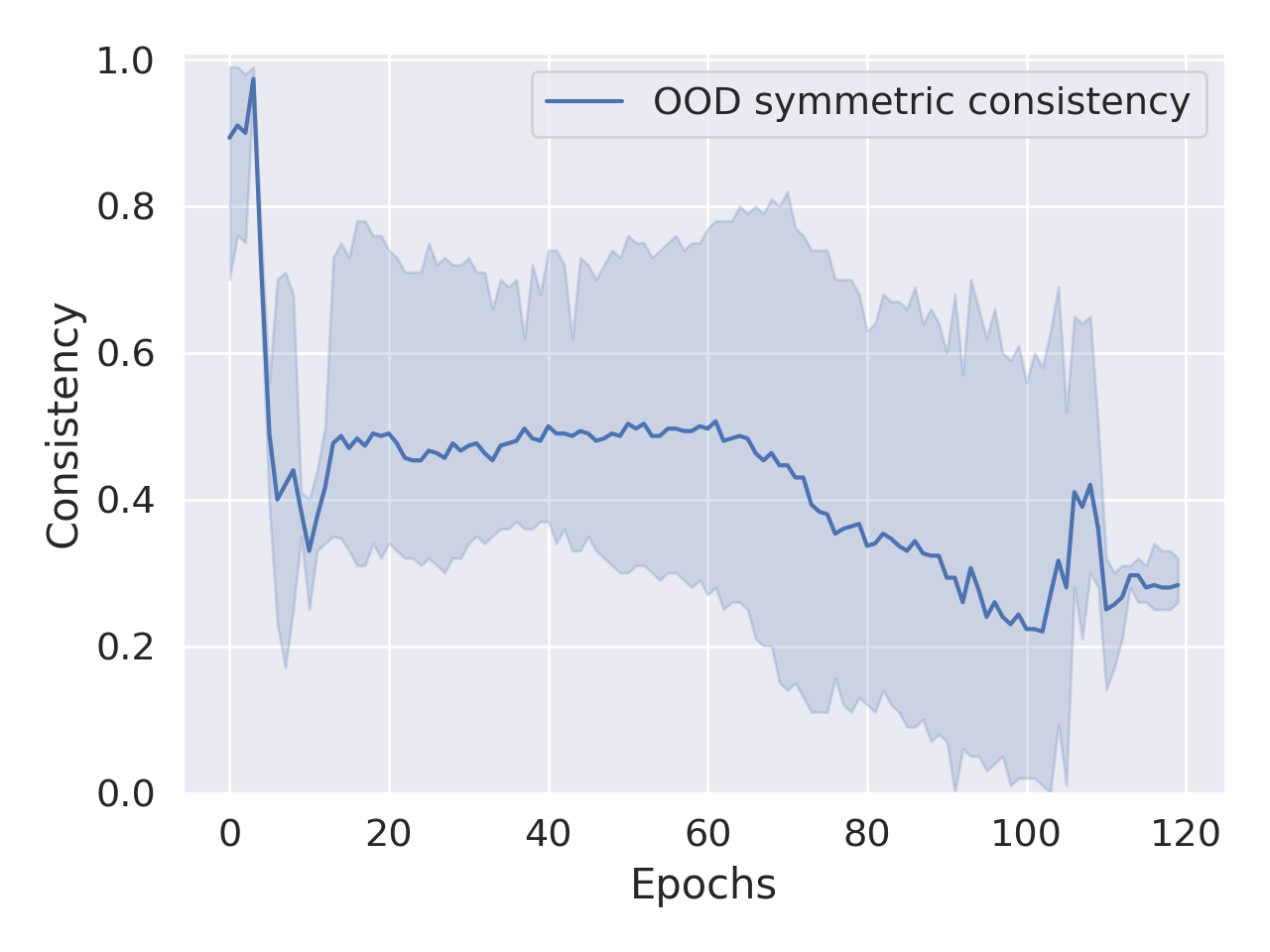

Исследования показывают, что явное обеспечение групповой эквивариантности в нейронных сетях, даже в рамках так называемых «узких моделей», существенно улучшает способность к обобщению на новых, ранее не виденных данных. Этот подход заключается в том, чтобы гарантировать, что представления, формируемые сетью, преобразуются согласованно при воздействии операций группы, таких как вращения или отражения. В результате, сети, построенные с учетом принципов эквивариантности, демонстрируют повышенную устойчивость к изменениям во входных данных и требуют меньше обучающих примеров для достижения высокой точности. Фактически, эквивариантность позволяет сети «понимать» фундаментальные симметрии данных, что способствует более эффективному обучению и лучшему обобщению, даже при ограниченном объеме данных.

Исследования показывают, что согласованное преобразование представлений нейронной сети при воздействии операций группы позволяет значительно снизить потребность в огромных объемах данных для обучения. Если сеть спроектирована таким образом, чтобы её выходные данные изменялись предсказуемо и осмысленно при определенных преобразованиях входных данных (например, при повороте изображения или изменении освещения), она способна обобщать информацию, используя гораздо меньше примеров. Это связано с тем, что сеть не просто запоминает конкретные пиксели или признаки, а изучает инвариантные характеристики, которые остаются неизменными при этих преобразованиях. Таким образом, достигается более эффективное использование данных и повышается устойчивость модели к новым, ранее не встречавшимся ситуациям, что особенно важно в задачах, где сбор больших размеченных данных затруднен или невозможен.

Обеспечение устойчивости и эффективности машинного обучения становится возможным благодаря подходу, ориентированному на снижение потребности в огромных объемах данных. Исследования показывают, что системы, построенные на принципах групповой эквивариантности, демонстрируют повышенную надежность и способность к обобщению на незнакомых данных. Вместо слепого увеличения размера обучающей выборки, данный метод позволяет создавать модели, которые более эффективно используют имеющуюся информацию, что особенно важно в задачах, где сбор данных затруднен или дорогостоящ. Это открывает перспективы для разработки интеллектуальных систем, способных адаптироваться к новым условиям и функционировать с высокой точностью даже при ограниченном количестве примеров.

Исследование демонстрирует, что даже узкие нейронные сети способны улавливать абстрактные алгебраические структуры, такие как коммутативность и структура подгрупп, хотя и не всегда с надежностью, необходимой для формального доказательства. Как отмечал Брайан Керниган: «Простота — это, как правило, лучший ответ». Это особенно верно в контексте данной работы, где авторы стремятся к минималистичным моделям, способным к обучению фундаментальных групповых операций. Попытка выявить эти структуры в нейронных сетях подчеркивает стремление к элегантности и математической чистоте, где корректность алгоритма является первостепенной задачей, а не просто успешное прохождение тестов.

Что Дальше?

Представленная работа, хотя и демонстрирует способность узких нейронных сетей к усвоению основ алгебраических структур, оставляет ряд вопросов без ответа. Наблюдаемая способность к предсказанию операций в конечных группах не эквивалентна пониманию лежащих в основе принципов. Сеть успешно эмулирует групповые свойства, но не доказывает их. Это напоминает о вечной дилемме: достаточно ли корректного поведения для признания интеллекта, или требуется доказательство внутренней модели?

Дальнейшие исследования должны сосредоточиться на разработке методов, позволяющих верифицировать внутреннее представление групповых структур нейронной сетью. Недостаточно просто наблюдать признаки коммутативности или подгрупповой структуры; необходимо продемонстрировать, что сеть способна обосновать эти свойства, используя логические правила. Попытки расширить область исследований за пределы конечных групп, к более сложным алгебраическим объектам, представляются неизбежными, но сопряжены с рисками усложнения без существенного прироста понимания.

В конечном итоге, задача состоит не в том, чтобы научить нейронные сети решать алгебраические задачи, а в том, чтобы понять, что вообще значит «понимать» в контексте искусственного интеллекта. Истинная элегантность алгоритма проявится тогда, когда он сможет не просто работать, но и доказывать свою корректность. Это — вызов, который выходит далеко за рамки прикладной математики.

Оригинал статьи: https://arxiv.org/pdf/2601.21150.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Сердце музыки: открытые модели для создания композиций

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Игры в коалиции: где стабильность распадается на части.

- Доказательство устойчивости веб-агента: проактивное свертывание контекста для задач с горизонтом в бесконечность.

- Доказательства просят: Как искусственный интеллект помогает отличать правду от вымысла

- Интеллектуальный поиск научных статей: новый подход к исследованию литературы

- Голос в переводе: как нейросети учатся понимать речь

- Игры без модели: новый подход к управлению в условиях неопределенности

- Цифровые двойники: первый опыт обучения

2026-01-30 14:17