Автор: Денис Аветисян

Новая работа предлагает переосмыслить управление ответственностью в сфере ИИ, рассматривая его не как поиск компромиссов, а как управление неизбежными противоречиями.

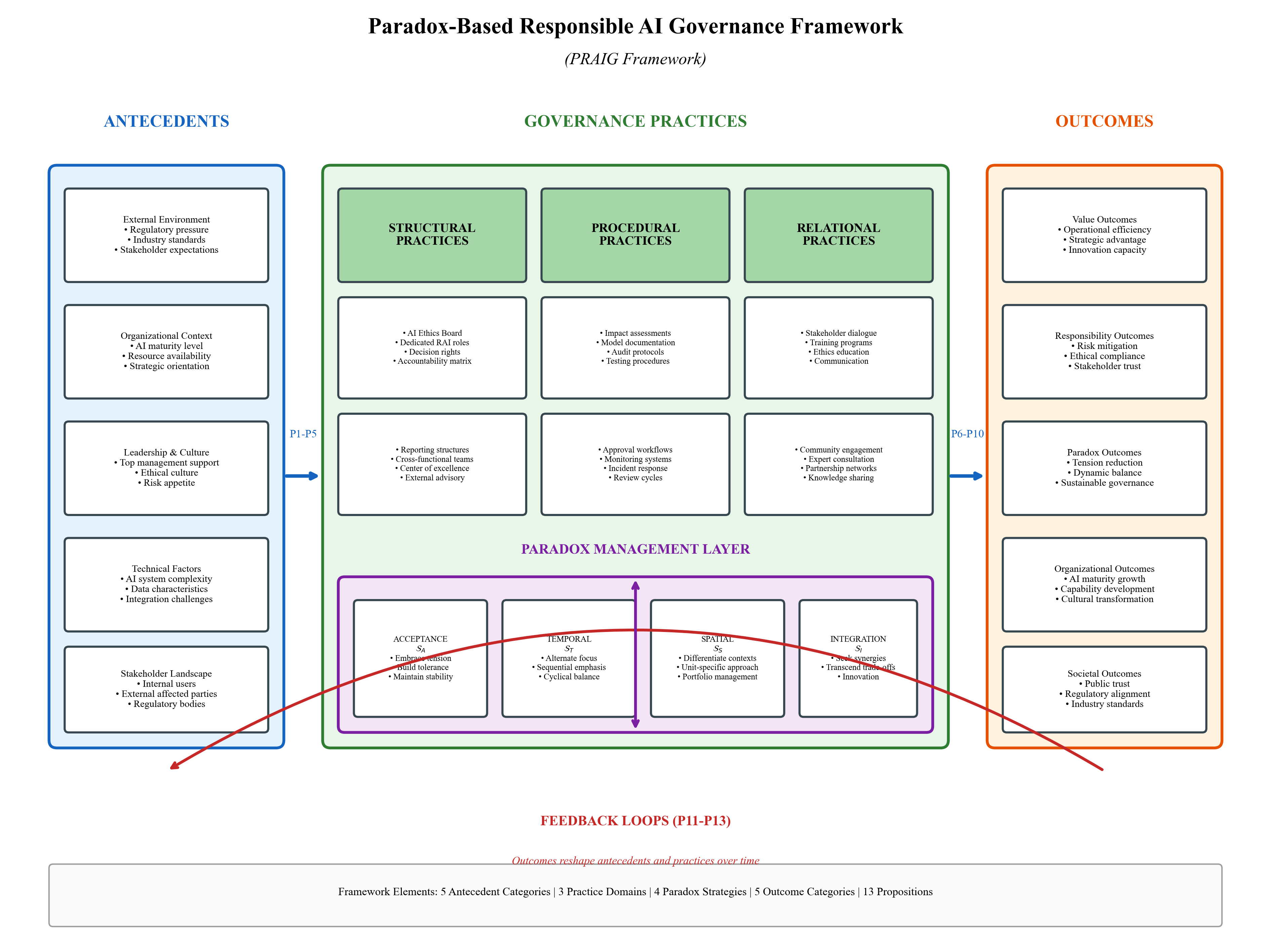

В статье представлена концепция PRAIG — фреймворк для организаций, стремящихся сбалансировать преимущества и риски искусственного интеллекта.

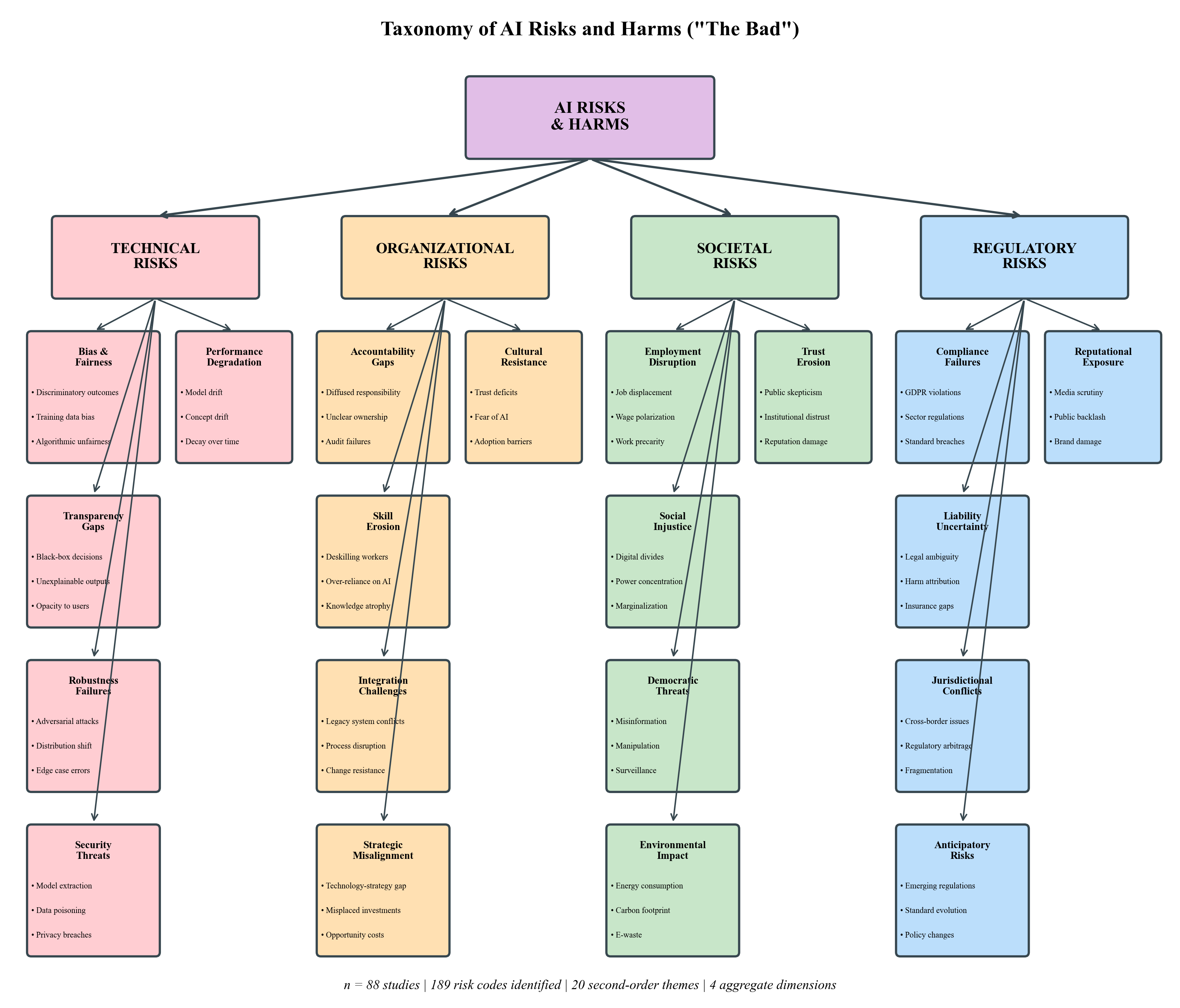

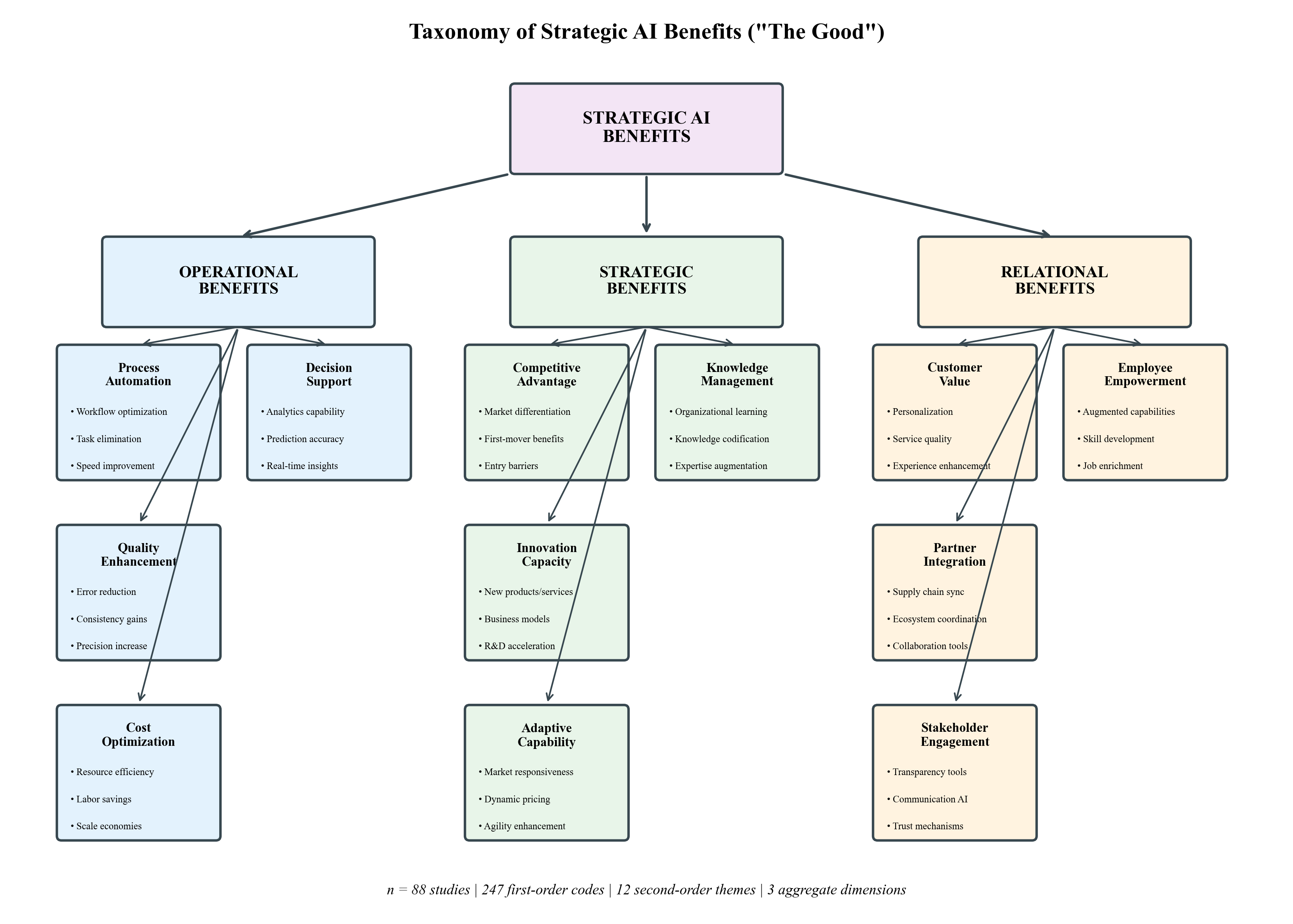

Быстрое распространение искусственного интеллекта одновременно открывает значительные стратегические возможности и порождает этические и операционные риски, однако существующие исследования зачастую рассматривают эти аспекты изолированно. В данной работе, ‘Responsible AI: The Good, The Bad, The AI’, предложена комплексная концептуализация ответственного управления ИИ, основанная на теории парадоксов, и разработан фреймворк PRAIG, позволяющий организациям эффективно управлять противоречиями между реализацией преимуществ и смягчением рисков. Мы доказываем, что попытки оптимизации компромиссов лишь усиливают эти противоречия, и предлагаем таксономию стратегий управления парадоксами с учетом конкретных условий. Как обеспечить устойчивое развитие ИИ, максимизируя его потенциал и одновременно минимизируя негативные последствия?

Искусственный интеллект: между стратегическими преимуществами и этическими дилеммами

Искусственный интеллект предоставляет стратегические преимущества в различных секторах, от здравоохранения до финансов, однако бесконтрольное внедрение сопряжено со значительными рисками. Особенно ярко это проявляется на примере систем распознавания лиц, где зафиксирована тревожная тенденция: вероятность ошибки в 34 раза выше для женщин с темным цветом кожи. Данный дисбаланс не просто техническая погрешность, а отражение предвзятости, заложенной в обучающих данных и алгоритмах, что может приводить к серьезным последствиям, включая ошибочные обвинения и дискриминацию. Подобные случаи подчеркивают необходимость тщательного тестирования и аудита систем искусственного интеллекта на предмет справедливости и беспристрастности, а также разработки этических норм, регулирующих их использование.

Традиционные подходы к управлению, основанные на логике компромиссов и взвешивания выгод и рисков, оказываются недостаточными при решении сложных задач, связанных с искусственным интеллектом. Привычная схема “уменьшение одного риска ведет к увеличению другого” не работает эффективно, поскольку многие проблемы, возникающие в сфере ИИ, не сводятся к простому обмену. Например, повышение точности алгоритма распознавания лиц может одновременно привести к усилению предвзятости и дискриминации определенных групп населения. Иными словами, в контексте ИИ часто возникает необходимость одновременно минимизировать несколько взаимосвязанных рисков, что требует принципиально новых подходов к управлению, учитывающих системный характер проблем и взаимозависимость различных факторов. Вместо поиска оптимального компромисса необходимо разрабатывать стратегии, позволяющие одновременно решать несколько задач и избегать нежелательных последствий.

Ограниченность существующих подходов к регулированию искусственного интеллекта обуславливает необходимость разработки принципиально новых рамок, способных учитывать и разрешать внутренние противоречия, присущие этим системам. Искусственный интеллект не является нейтральным инструментом; он отражает ценности и предубеждения, заложенные в процессе его создания и обучения. Поэтому эффективное управление требует не просто минимизации рисков, но и активного выявления и разрешения конфликтующих целей, таких как точность и справедливость, инновации и конфиденциальность. Новые рамки должны быть гибкими и адаптивными, способными реагировать на быстро меняющийся ландшафт технологий и учитывать многообразие социальных и этических аспектов, связанных с применением искусственного интеллекта. В конечном итоге, успех регулирования будет зависеть от способности находить баланс между стимулированием инноваций и защитой фундаментальных прав и свобод.

Управление парадоксами: ключ к устойчивому развитию ИИ

Теория парадоксов представляет собой мощный аналитический инструмент для понимания устойчивых организационных противоречий, в том числе возникающих в контексте управления искусственным интеллектом. Данная теория предполагает, что в организациях неизбежно возникают противоположные, но взаимосвязанные требования и цели, которые нельзя разрешить путем поиска компромисса или оптимизации. Вместо этого, необходимо признать и управлять этими противоречиями как нормальной частью организационной жизни. Ключевым аспектом является понимание, что попытки устранить одно противоречие часто приводят к усилению другого, поэтому эффективное управление требует постоянного балансирования и адаптации к меняющимся обстоятельствам. Это особенно актуально для управления ИИ, где, например, стремление к инновациям может противоречить требованиям безопасности и этичности.

Эффективное управление искусственным интеллектом (ИИ) предполагает признание и управление неизбежными противоречиями, а не попытки их устранения. Практика показывает, что стремление к полному разрешению конфликтующих требований, таких как инновации и безопасность, или конфиденциальность и прозрачность, часто приводит к параличу принятия решений и снижению адаптивности системы. Вместо этого, акцент смещается на выработку механизмов, позволяющих балансировать между противоположностями, поддерживать динамическое равновесие и оперативно реагировать на изменяющиеся обстоятельства. Такой подход позволяет организациям извлекать максимальную выгоду из возможностей ИИ, минимизируя при этом потенциальные риски и обеспечивая устойчивое развитие.

Традиционный подход к управлению, ориентированный на поиск оптимальных решений, часто оказывается неэффективным в контексте искусственного интеллекта. Переход к парадигме, акцентирующей внимание на управлении сложными компромиссами и адаптивных стратегиях, предполагает признание неизбежности противоречий. Вместо стремления к идеальному результату, приоритет отдается разработке гибких механизмов, позволяющих балансировать конкурирующие цели и оперативно реагировать на изменяющиеся условия. Это требует от организаций готовности к постоянной корректировке стратегий и принятию решений в условиях неопределенности, а также к использованию итеративных подходов к разработке и внедрению систем ИИ.

Фреймворк PRAIG: практическая реализация ответственного управления ИИ

Фреймворк PRAIG (Paradox-based Responsible AI Governance — управление ответственными ИИ на основе парадоксов) структурирует развертывание ответственного ИИ посредством интеграции четырех ключевых компонентов: антецедентов (предварительных условий и контекста), практик (конкретных действий и процедур), результатов (измеримых последствий внедрения ИИ) и циклов обратной связи (механизмов мониторинга и корректировки). Данная интеграция позволяет не просто внедрять ИИ-системы, но и обеспечить их соответствие этическим нормам, требованиям регуляторов и ожиданиям заинтересованных сторон, создавая замкнутый цикл постоянного улучшения и адаптации к меняющимся условиям.

В рамках методологии PRAIG, сбор различных точек зрения заинтересованных сторон осуществляется посредством целенаправленных диалогов, направленных на формирование эффективных стратегий управления. Параллельно, для обеспечения прозрачности процессов и результатов, активно используются методы объяснимого искусственного интеллекта (XAI). Это позволяет не только учитывать широкий спектр мнений при разработке и внедрении ИИ-систем, но и предоставлять понятные объяснения принимаемых решений, что способствует повышению доверия и ответственности.

В основе PRAIG-фреймворка лежит управление парадоксами, возникающими при внедрении ИИ, посредством четырех стратегий: принятие (acceptance), пространственное разделение (spatial separation), временное разделение (temporal separation) и интеграция. Эти стратегии позволяют нивелировать внутренние противоречия, возникающие, например, между инновациями и соблюдением нормативных требований, или между автоматизацией и необходимостью сохранения человеческого контроля. Внедрение данных стратегий в пилотных проектах позволило зафиксировать повышение производительности в диапазоне от 15 до 40 процентов, что подтверждает практическую эффективность подхода PRAIG к управлению рисками и оптимизации процессов.

Валидация фреймворка PRAIG: научный подход

Разработка фреймворка PRAIG основывалась на систематическом обзоре литературы, обеспечивающем соответствие текущим исследованиям в области ответственного искусственного интеллекта. В процессе отбора публикаций применялись строгие критерии качества, с минимальным порогом оценки в 3.0 балла по 5-балльной шкале. Данный подход позволил учесть наиболее релевантные и надежные научные данные, что обеспечило теоретическую обоснованность и практическую применимость разработанного фреймворка. Обзор охватил широкий спектр публикаций, включая научные статьи, отчеты и отраслевые стандарты, что позволило выявить лучшие практики и современные тенденции в области этичного ИИ.

В процессе валидации PRAIG Framework был применен подход Design Science Research, предполагающий итеративную разработку, внедрение и оценку эффективности. Для обеспечения надежности результатов, этап первичного отбора публикаций (анализ заголовков и аннотаций) проводился с использованием оценки согласованности между оценщиками, которая составила 0.81 по статистике Каппа. Данный показатель свидетельствует о высокой степени согласованности между разными экспертами при определении релевантности материалов, что подтверждает объективность и надежность отбора источников для дальнейшего анализа и разработки фреймворка.

В рамках PRAIG признается критическая важность проактивного подхода к выявлению и смягчению алгоритмических предубеждений (bias). В частности, подчеркивается необходимость внедрения механизмов для оценки и корректировки данных, используемых для обучения моделей, а также регулярного аудита алгоритмов на предмет дискриминационных результатов. Ключевым элементом управления в данной области является создание советов по этике ИИ (AI ethics boards), наделенных полномочиями по разработке и контролю за соблюдением этических норм и принципов при разработке и внедрении систем искусственного интеллекта. Эти советы должны включать в себя представителей различных заинтересованных сторон, включая разработчиков, юристов, экспертов по этике и представителей сообществ, на которые могут повлиять решения ИИ.

К адаптивному и ответственному будущему искусственного интеллекта

В основе адаптивности и устойчивости искусственного интеллекта будущего лежит концепция непрерывного обучения и самосовершенствования, реализованная в рамках PRAIG Framework. Данный подход предполагает создание замкнутых циклов обратной связи, позволяющих системам ИИ не просто реагировать на изменения внешней среды, но и активно учиться на собственном опыте, корректируя алгоритмы и стратегии. Эти циклы включают в себя сбор данных о производительности, анализ выявленных ошибок и неточностей, внесение соответствующих изменений в модель и повторное тестирование. Благодаря постоянному обновлению и адаптации к новым условиям, системы ИИ, построенные на основе PRAIG Framework, способны поддерживать высокую эффективность и надежность даже в динамично меняющемся мире, а также эффективно решать задачи, для которых изначально не были запрограммированы.

Предложенный подход способствует формированию упреждающей и ответственной экосистемы искусственного интеллекта, направленной на смягчение потенциальных рисков и максимизацию преимуществ. Исследования демонстрируют, что внедрение данной методологии позволяет добиться существенного снижения количества ошибок — в диапазоне от 25 до 50% — и сокращения издержек в практических приложениях на 10-30%. Это достигается за счет постоянного мониторинга, анализа и адаптации систем искусственного интеллекта, что позволяет оперативно выявлять и устранять проблемные области, повышая надежность и эффективность принимаемых решений.

Исследования показывают, что признание и конструктивное разрешение внутренних противоречий, возникающих при разработке и внедрении искусственного интеллекта, является ключевым фактором для раскрытия его полного потенциала и одновременного обеспечения соответствия общественным ценностям. Такой подход позволяет не просто избегать потенциальных рисков, но и активно использовать возникающие напряжения для улучшения качества принимаемых решений. Согласно данным, применение данной стратегии способствует повышению эффективности решений на 20-35%, что связано с более глубоким анализом проблем и поиском инновационных решений, учитывающих как технические, так и этические аспекты. Успешное разрешение этих внутренних противоречий создает основу для разработки более надежных и ответственных систем искусственного интеллекта, способных приносить пользу обществу.

Данное исследование, рассматривая ответственное использование искусственного интеллекта не как проблему оптимизации, а как управление парадоксами, подчеркивает сложность достижения баланса между потенциальными выгодами и рисками. Подобный подход требует от организаций не просто разработки этических принципов, но и выработки стратегий для навигации в неизбежных противоречиях. Тим Бернерс-Ли однажды заметил: «Веб — это не просто набор документов, а система для организации знаний». Эта фраза отражает суть PRAIG-фреймворка, предложенного в работе — структурирование хаоса данных и алгоритмов для достижения осмысленного и ответственного результата, где логика и доказуемость превалируют над эвристическими решениями.

Куда двигаться дальше?

Представленная работа, смело постулируя ответственное управление искусственным интеллектом как задачу разрешения парадоксов, открывает, скорее, поле для дальнейших, болезненных уточнений, чем даёт окончательные ответы. Рассмотренный фреймворк PRAIG, будучи логически стройным, требует строгой верификации в условиях реальной эксплуатации. Недостаточно продемонстрировать его работоспособность на смоделированных данных; истинная проверка — в воспроизводимости результатов и предсказуемости поведения системы в условиях неопределенности.

Критически важным представляется исследование динамики возникающих парадоксов. Предложенная классификация — лишь первый шаг. Необходимо установить, как эти парадоксы взаимодействуют между собой, усиливают или ослабляют друг друга, и как их эволюция влияет на долгосрочную устойчивость системы. Особое внимание следует уделить разработке метрик, позволяющих количественно оценить степень разрешения парадокса — иначе все рассуждения останутся в плоскости философских абстракций.

В конечном счете, успех подобного подхода зависит от способности выйти за рамки поиска “оптимальных” решений. Истинная элегантность не в достижении компромисса, а в полном устранении противоречия. Если результат нельзя воспроизвести, он недостоверен. Игнорирование этого принципа обрекает любые начинания в области ответственного ИИ на повторение тех же ошибок, что и в прошлом.

Оригинал статьи: https://arxiv.org/pdf/2601.21095.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Голос в переводе: как нейросети учатся понимать речь

- Игры без модели: новый подход к управлению в условиях неопределенности

- Нейросети на грани: как перевести ИИ в логику для умных устройств

- Цифровые двойники: первый опыт обучения

- Ищем закономерности: Новый пакет TSQCA для R

- Эффективная память для больших языковых моделей: новый подход LOOKAT

- Эволюция под контролем: эксперименты с обучением с подкреплением в генетическом программировании

2026-01-31 17:11