Автор: Денис Аветисян

Новое исследование демонстрирует, как генеративные модели можно использовать для автоматического создания JSON-представлений моделей предметной области, значительно упрощая процесс разработки.

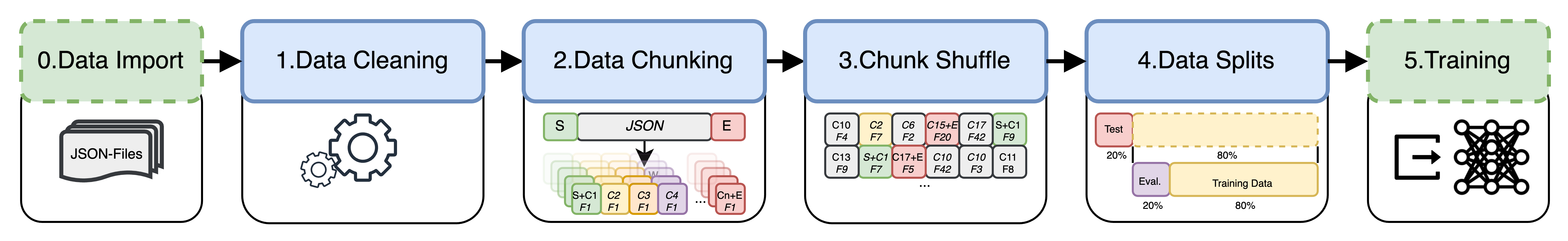

В статье показана успешная настройка открытой языковой модели Code Llama для генерации синтаксически корректных JSON-объектов, описывающих модели предметно-ориентированного проектирования, даже при ограниченных вычислительных ресурсах.

Разработка программного обеспечения, ориентированного на потребности заказчика, требует точного моделирования предметной области, что часто связано с трудоемким созданием метамоделей. В данной работе, ‘Leveraging Generative AI for Enhancing Domain-Driven Software Design’, исследуется возможность частичной автоматизации генерации этих метамоделей с использованием генеративного искусственного интеллекта, в частности, для создания JSON-объектов, описывающих предметную область. Показано, что путем тонкой настройки открытой языковой модели Code Llama на данных реальных проектов, можно генерировать синтаксически корректные JSON-объекты, используя простые запросы, даже при ограниченных аппаратных ресурсах. Открывает ли это путь к более эффективным и экономичным методам разработки программного обеспечения, основанным на принципах Domain-Driven Design?

Автоматизация Доменной Экспертизы с Помощью Генеративного ИИ

Многие бизнес-процессы опираются на сложные структурированные данные, представленные в виде доменных моделей. Однако, создание и поддержка этих моделей традиционно требует значительных ручных усилий, что делает процесс трудоемким и подверженным ошибкам. Неточности в структуре данных могут приводить к сбоям в работе систем, неверным результатам анализа и, как следствие, к финансовым потерям. В условиях постоянно меняющихся требований бизнеса, необходимость оперативного обновления доменных моделей становится критически важной, а ручное внесение изменений — непозволительно медленным и ресурсоемким. Поэтому автоматизация этого процесса представляет собой важную задачу для повышения эффективности и надежности бизнес-операций.

Генеративные модели искусственного интеллекта представляют собой эффективное решение для автоматизации создания доменных моделей, основываясь непосредственно на формулировках бизнес-требований. Этот подход позволяет существенно сократить время и затраты на разработку, устраняя необходимость в ручном моделировании и снижая вероятность ошибок. Особенностью является способность генерировать синтаксически корректные JSON-объекты, что гарантирует совместимость и упрощает интеграцию с существующими системами. Благодаря четким и понятным запросам, искусственный интеллект способен автоматически формировать структурированные данные, отражающие логику и взаимосвязи в бизнес-процессах, предоставляя возможность быстрого прототипирования и адаптации к изменяющимся условиям.

В Основе: Использование Больших Языковых Моделей для Генерации JSON

Модель Code Llama обеспечивает надежную основу для генерации JSON, широко используемого формата для представления структурированных данных и обеспечения обмена данными между различными системами. JSON, основанный на подмножестве JavaScript, отличается простотой и удобочитаемостью, что делает его популярным выбором для веб-сервисов, API и конфигурационных файлов. Code Llama, будучи большой языковой моделью, обученной на обширном корпусе кода, демонстрирует высокую способность генерировать синтаксически корректные и семантически осмысленные JSON-структуры, что позволяет автоматизировать задачи, связанные с созданием и обработкой структурированных данных.

Библиотека Hugging Face Transformers значительно упрощает процесс внедрения и обучения больших языковых моделей, необходимых для генерации JSON. Она предоставляет готовые реализации моделей, оптимизированные для различных задач, а также инструменты для тонкой настройки на специфических наборах данных. В частности, Transformers включает в себя классы для загрузки предварительно обученных моделей, токенизаторы для преобразования текста в числовые представления, и функции для обучения и оценки моделей с использованием различных аппаратных ускорителей, включая GPU и TPU. Кроме того, библиотека поддерживает интеграцию с популярными фреймворками машинного обучения, такими как PyTorch и TensorFlow, что позволяет разработчикам использовать знакомые инструменты и методы.

В основе генерации JSON с использованием больших языковых моделей лежит механизм предсказания следующего токена (Next Token Prediction). Модель анализирует последовательность токенов, представляющих собой частичные данные JSON, и на основе этой информации вычисляет вероятность появления каждого возможного следующего токена. Выбирая токен с наибольшей вероятностью или используя стратегии семплирования, модель последовательно генерирует JSON, обеспечивая соответствие синтаксическим правилам и формирование корректных структур данных. Этот процесс повторяется до тех пор, пока не будет сгенерирован полный и валидный JSON-объект или массив.

Повышение Эффективности: Методы Параметрически-Эффективной Тонкой Настройки

Метод адаптации с низким рангом (LoRA) представляет собой эффективный подход к настройке Code Llama для генерации JSON, позволяющий значительно снизить вычислительные затраты и объем используемой памяти. Вместо обновления всех параметров предобученной модели, LoRA вводит небольшое количество обучаемых параметров низкого ранга, которые добавляются к существующим весам. Это позволяет адаптировать модель к конкретной задаче, не требуя обучения миллионов или миллиардов параметров, что существенно экономит ресурсы и время. Эффективность LoRA обусловлена тем, что большая часть информации о задаче может быть захвачена в небольшом подпространстве параметров, что позволяет достичь сравнимой производительности с полной настройкой, используя лишь малую часть обучаемых параметров.

Квантованная адаптация с низким рангом (QLoRA) представляет собой метод оптимизации, объединяющий адаптацию с низким рангом (LoRA) и 4-битную квантизацию. В процессе квантизации веса модели преобразуются из стандартных 16- или 32-битных чисел с плавающей точкой в 4-битные целые числа, что существенно снижает объем памяти, необходимый для хранения модели. Сочетание с LoRA, которая обучает лишь небольшое количество дополнительных параметров, позволяет добиться значительного уменьшения размера модели — до 75% и более — без существенной потери в производительности, что особенно важно для развертывания моделей в условиях ограниченных вычислительных ресурсов и памяти.

Методы адаптации с эффективным использованием параметров, такие как LoRA и квантизация, критически важны для развертывания модели Code Llama в средах с ограниченными ресурсами. Ограничения по вычислительной мощности, объему оперативной памяти и хранилища часто встречаются на периферийных устройствах, в мобильных приложениях и в облачных инфраструктурах с жесткими бюджетными ограничениями. Уменьшение количества обучаемых параметров и снижение разрядности весов модели, достигаемые с помощью этих техник, позволяют значительно снизить требования к ресурсам без существенной потери производительности, обеспечивая возможность использования мощных языковых моделей даже в условиях ограниченной инфраструктуры. Это особенно важно для приложений, требующих локальной обработки данных или высокой скорости отклика.

Оценка Производительности и Оптимизация Гиперпараметров

Оценка качества генерируемого JSON осуществлялась с использованием метрики BLEU Score, которая измеряет степень схожести между сгенерированным и ожидаемым выходными данными. В процессе подбора гиперпараметров была достигнута приблизительная оценка в 0.062. Данный показатель, хотя и не является высоким, отражает текущую способность модели к точному воспроизведению целевого формата, а также служит ориентиром для дальнейшей оптимизации и улучшения алгоритмов генерации. Анализ BLEU Score позволяет количественно оценить эффективность модели и выявить области, требующие более тщательной проработки для повышения качества генерируемого JSON.

Оптимизация гиперпараметров играет ключевую роль в достижении максимальной производительности модели. Для выявления наиболее влиятельных параметров использовался алгоритм Random Forest Regressor в сочетании с анализом Permutation Importance. Данный подход позволяет оценить, насколько уменьшение предсказательной силы модели происходит при случайном перемешивании значений каждого гиперпараметра. В результате, наиболее значимые параметры, оказывающие наибольшее влияние на качество генерируемого JSON, могут быть идентифицированы и соответствующим образом настроены, что существенно повышает общую эффективность системы и обеспечивает более точные и качественные результаты.

Предварительная обработка данных является неотъемлемой частью обеспечения высокого качества входной модели предметной области и, как следствие, эффективного обучения системы. Тщательная очистка и форматирование данных позволяют значительно повысить точность и надежность генерируемых результатов. В ходе проведенных исследований, после обработки всех сгенерированных выборок, удалось достичь 81%-ного процента успешного разбора данных, что свидетельствует о значительной роли этапа предварительной обработки в повышении общей производительности системы и её способности корректно интерпретировать входные данные.

![Оценка важности параметров модели, выполненная с использованием перестановочной важности и регрессора случайного леса [18], позволяет определить наиболее влиятельные факторы для различных целевых метрик.](https://arxiv.org/html/2601.20909v1/pictures/ParameterImportanceforMultipleObjectives_800_400_5.png)

Исследование демонстрирует, что даже при ограниченных вычислительных ресурсах возможно достижение значимых результатов в области автоматизации проектирования программного обеспечения. Авторы успешно адаптировали большую языковую модель для генерации корректных JSON-объектов, представляющих модели предметной области, что является ключевым аспектом Domain-Driven Design. Этот подход позволяет упростить и ускорить процесс создания сложных систем. Как отмечал Андрей Колмогоров: «Математика — это искусство невозможного». Подобно этому, данная работа демонстрирует, что даже сложные задачи автоматизации проектирования могут быть успешно решены при грамотном применении современных инструментов и методов, таких как Low-Rank Adaptation и точная настройка гиперпараметров.

Что дальше?

Представленная работа демонстрирует возможность генерации синтаксически корректных JSON-объектов, представляющих модели предметной области, при помощи дообученной языковой модели. Однако, следует признать, что синтаксическая корректность — лишь первая ступень. Истинная ценность предметно-ориентированного проектирования заключается не в формальном описании, а в отражении сложной логики и взаимосвязей. Оценка качества сгенерированных моделей при помощи BLEU-оценки — удобный, но поверхностный показатель.

Будущие исследования должны сосредоточиться на метриках, отражающих семантическую корректность и соответствие бизнес-требованиям. Автоматическая проверка согласованности сгенерированных моделей с существующей кодовой базой представляется особенно важной задачей. Более того, необходимо преодолеть зависимость от ручной настройки гиперпараметров — совершенство достигается не в искусном подборе, а в автоматизации и самообучении.

В конечном итоге, цель состоит не в создании генератора JSON, а в создании инструмента, способного облегчить процесс проектирования, позволить разработчикам сосредоточиться на сути, а не на формальностях. И, возможно, в конце этого пути, исчезнет и сам автор инструмента — признак истинного совершенства.

Оригинал статьи: https://arxiv.org/pdf/2601.20909.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Сердце музыки: открытые модели для создания композиций

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Эффективная память для больших языковых моделей: новый подход LOOKAT

- Игры в коалиции: где стабильность распадается на части.

- Эволюция под контролем: эксперименты с обучением с подкреплением в генетическом программировании

- Доказательство устойчивости веб-агента: проактивное свертывание контекста для задач с горизонтом в бесконечность.

- Доказательства просят: Как искусственный интеллект помогает отличать правду от вымысла

- Интеллектуальный поиск научных статей: новый подход к исследованию литературы

- Голос в переводе: как нейросети учатся понимать речь

2026-02-01 03:39