Автор: Денис Аветисян

В новой работе представлена практическая структура для создания надежных и безопасных систем искусственного интеллекта, адаптированная к специфике этой быстроразвивающейся области.

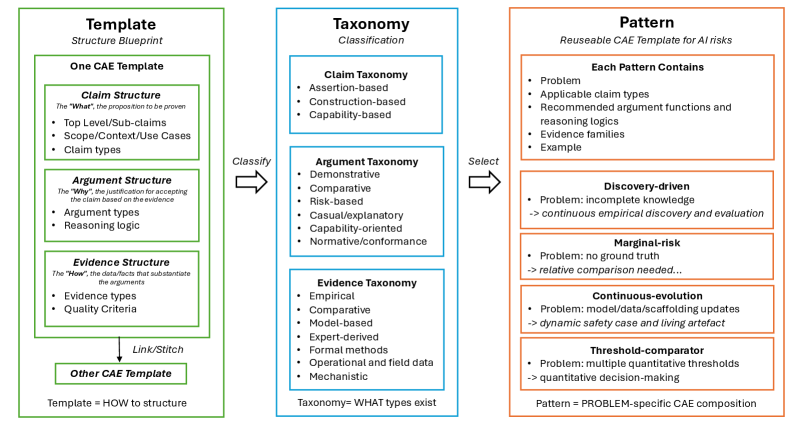

Предлагается многоразовый шаблонный каркас для построения аргументированных обоснований безопасности (safety cases) систем искусственного интеллекта, включающий таксономии и проверенные модели оценки рисков.

Традиционные подходы к обеспечению безопасности, разработанные для систем с четко определенными границами и предсказуемым поведением, оказываются неэффективными в отношении современных систем искусственного интеллекта. В работе ‘Constructing Safety Cases for AI Systems: A Reusable Template Framework’ предложен ре reusable framework для создания safety case, включающий типовые шаблоны, таксономии и паттерны, адаптированные к динамичной природе ИИ. Этот framework позволяет систематически оценивать и подтверждать безопасность ИИ-систем, учитывая их непредсказуемость и способность к самообучению. Сможет ли предложенный подход стать основой для разработки надежных и проверяемых систем ИИ, способных соответствовать требованиям все более строгих регуляторных норм?

Обеспечение Безопасности ИИ: Фундамент Надежности

По мере все более широкого распространения систем искусственного интеллекта, демонстрация их безопасности становится первостепенной задачей, требующей применения строгой и структурированной методологии. Увеличение сложности и автономности этих систем обуславливает необходимость не просто тестирования, но и всестороннего анализа потенциальных рисков и уязвимостей на всех этапах разработки и эксплуатации. Отсутствие надлежащего контроля может привести к непредсказуемым последствиям, поэтому разработка и внедрение надежных процедур оценки безопасности, включающих формальную верификацию, робастное тестирование и постоянный мониторинг, является критически важной для обеспечения надежной и безопасной работы искусственного интеллекта в различных сферах применения. Такой подход позволяет минимизировать вероятность возникновения нежелательных ситуаций и гарантировать соответствие систем заданным требованиям и стандартам безопасности.

Концепция «Аргумента в пользу безопасности ИИ» представляет собой структурированный подход к демонстрации надежности и предсказуемости искусственного интеллекта. Это не просто декларация о безопасности, а убедительное обоснование, подкрепленное всесторонними доказательствами и анализом, которое подтверждает, что система ИИ функционирует приемлемо и безопасно для конкретной, четко определенной цели. Такой подход предполагает тщательную оценку потенциальных рисков, верификацию ключевых компонентов и предоставление убедительных данных, подтверждающих, что система соответствует установленным критериям безопасности и не представляет неприемлемой угрозы для пользователей или окружающей среды. В конечном итоге, аргумент в пользу безопасности ИИ служит основой для ответственного внедрения и широкого применения технологий искусственного интеллекта, гарантируя, что инновации сопряжены с надежностью и предсказуемостью.

Построение Аргумента Безопасности: Методология и Подходы

В основе построения и оценки обоснований безопасности искусственного интеллекта лежит фреймворк CAE (Claims, Arguments, Evidence) — “Утверждения, Аргументы, Доказательства”. Этот подход структурирует процесс, определяя конкретные утверждения о безопасности системы, аргументы, подтверждающие эти утверждения, и доказательства, подкрепляющие аргументы. Использование CAE обеспечивает прозрачность процесса обоснования безопасности, поскольку каждая претензия может быть прослежена до соответствующих аргументов и доказательств, что необходимо для аудита и проверки. Такая структура позволяет четко документировать и анализировать риски, связанные с ИИ, и демонстрировать соответствие системы определенным требованиям безопасности.

Для подкрепления утверждений в рамках аргумента безопасности применяются методы эмпирической оценки, сравнительного анализа и формальной верификации. Эмпирическая оценка включает в себя тестирование системы в различных условиях и сбор данных о ее производительности и надежности. Сравнительный анализ предполагает оценку системы относительно других, уже проверенных систем или установленных стандартов безопасности. Формальная верификация использует математические методы для доказательства корректности системы и отсутствия в ней критических ошибок. Комбинация этих методов позволяет предоставить объективные данные и логические обоснования, подтверждающие безопасность и надежность разрабатываемой системы искусственного интеллекта.

Для ускорения создания последовательной и всесторонней документации по безопасности используются методы с применением искусственного интеллекта, такие как LLM_Safety_Case_Generation и Template_Based_Safety. Эти методы позволяют автоматизировать процесс формирования аргументов безопасности и обеспечивают унификацию представленных данных. В рамках данной разработки определены 4 повторно используемых шаблона аргументов безопасности, предназначенных для стандартизации подходов к оценке рисков и упрощения процесса верификации систем искусственного интеллекта.

Динамический Кейс Безопасности: Адаптация к Изменениям

Динамический кейс безопасности отличается от традиционного подхода своей способностью к непрерывному развитию параллельно с развитием системы искусственного интеллекта. Вместо статического документа, он интегрирует данные, поступающие в режиме реального времени, и адаптируется к изменениям в поведении ИИ. Это означает, что оценка безопасности не является однократным мероприятием, а представляет собой постоянный процесс обновления и корректировки, основанный на фактической производительности системы в реальных условиях эксплуатации. Данный подход позволяет оперативно выявлять и учитывать отклонения от ожидаемого поведения, обеспечивая актуальность и надежность оценки безопасности на протяжении всего жизненного цикла ИИ.

Непрерывный мониторинг посредством AgentOps является ключевым элементом поддержания актуальности динамического обоснования безопасности. AgentOps обеспечивает сбор и анализ данных о работе ИИ-системы в реальных условиях, позволяя выявлять отклонения от ожидаемого поведения и потенциальные риски. Полученные данные используются для регулярного обновления обоснования безопасности, отражая текущую производительность и адаптируясь к изменениям в поведении системы. Этот процесс включает в себя отслеживание ключевых показателей, анализ журналов событий и проведение автоматизированных тестов для подтверждения соответствия системы установленным требованиям безопасности и предотвращения возникновения нежелательных последствий.

Динамический подход к обоснованию безопасности неразрывно связан с эволюцией ИИ-системы, поскольку признает, что безопасность — это не статичное свойство, а непрерывный процесс. Традиционные методы обоснования безопасности, основанные на фиксированных спецификациях, становятся неэффективными в условиях постоянного обучения и адаптации ИИ. Поэтому, обоснование безопасности должно постоянно обновляться и пересматриваться в соответствии с изменениями в поведении системы, учитывая данные, полученные в процессе эксплуатации, и новые версии алгоритмов. Данная концепция подразумевает интеграцию процессов разработки и мониторинга безопасности, обеспечивая постоянную актуальность и надежность системы на протяжении всего жизненного цикла.

Оценка Рисков в Реальных Условиях: Стратегии и Подходы

Оценка предельного риска (Marginal Risk Assessment) является критически важной в ситуациях, когда достоверные эталонные данные (ground truth) недоступны. Вместо абсолютной оценки точности, такой подход фокусируется на демонстрации того, что производительность системы искусственного интеллекта не уступает производительности заранее определенной базовой системы или метода. Это достигается путем сравнения показателей новой системы с показателями базовой, что позволяет установить минимальный уровень приемлемой производительности и оценить потенциальные риски, связанные с использованием ИИ в отсутствие абсолютных критериев оценки. Такой подход особенно актуален для систем, принимающих решения в критически важных областях, где невозможно получить полные и достоверные данные для обучения и оценки.

Управление рисками в системах искусственного интеллекта (ИИ) представляет собой комплексный процесс, охватывающий все этапы жизненного цикла ИИ-системы — от проектирования и разработки до развертывания и эксплуатации. Данный подход включает в себя идентификацию потенциальных рисков, связанных с использованием ИИ, оценку вероятности их возникновения и степени влияния на ключевые показатели, а также разработку и внедрение мер по смягчению или устранению этих рисков. Это включает в себя технические решения, такие как проверка и валидация моделей, а также организационные меры, например, разработку политик и процедур, обеспечивающих ответственное использование ИИ и соблюдение этических норм. Эффективное управление рисками позволяет минимизировать негативные последствия, связанные с ошибками, предвзятостью или непредсказуемым поведением ИИ-систем.

В сценариях, подобных системе оценки тендеров на базе искусственного интеллекта (AI_Tender_Evaluation_System), применение методов оценки рисков имеет решающее значение для обеспечения справедливости и надежности принимаемых решений. Автоматизированная оценка предложений требует тщательного анализа потенциальных предвзятостей в данных и алгоритмах, поскольку ошибки могут привести к несправедливому отбору поставщиков и финансовым потерям. Внедрение процедур контроля и валидации, а также мониторинг производительности системы в реальном времени, позволяет выявлять и устранять риски, гарантируя соответствие системы установленным стандартам и требованиям законодательства.

Будущее Безопасности ИИ: Непрерывная Валидация и Развитие

Для обеспечения безопасного и надежного функционирования систем искусственного интеллекта необходима интеграция динамических обоснований безопасности, передовых стратегий оценки рисков и инструментов автоматизированной документации. Традиционные подходы к безопасности, основанные на статичных проверках, оказываются недостаточными в условиях быстрого развития технологий. Динамические обоснования безопасности подразумевают непрерывный мониторинг и адаптацию системы защиты в ответ на изменения в алгоритмах и окружении. Продвинутые методы оценки рисков позволяют выявлять и смягчать потенциальные угрозы, учитывая сложные взаимосвязи между компонентами ИИ. Использование инструментов автоматизированной документации облегчает отслеживание изменений, обеспечивает прозрачность и ускоряет процесс проверки соответствия установленным стандартам. В совокупности эти элементы формируют гибкую и эффективную систему, способную обеспечить безопасность ИИ на протяжении всего жизненного цикла.

Соблюдение установленных стандартов безопасности искусственного интеллекта является важнейшей отправной точкой, однако в условиях стремительно меняющегося технологического ландшафта, непрерывной валидации и адаптации уделяется первостепенное значение. Изначальные критерии оценки и протоколы тестирования, хоть и обеспечивают необходимый базовый уровень защиты, могут оказаться недостаточными для новых, более сложных систем. Поэтому, необходимо внедрение динамических механизмов оценки, способных отслеживать и учитывать эволюцию алгоритмов и их взаимодействие с окружающей средой. Постоянная проверка, переоценка рисков и оперативное внесение корректировок в системы безопасности — это не просто желательная практика, а абсолютная необходимость для поддержания надежности и предотвращения непредсказуемых последствий при развертывании систем искусственного интеллекта.

Разработанная структура включает в себя детальную таксономию типов утверждений и функций аргументации, что позволяет систематизировать процесс оценки безопасности искусственного интеллекта. В дополнение к этому, выделены семь семейств доказательств, охватывающих различные аспекты функционирования системы — от формальных спецификаций и результатов тестирования до данных, полученных в процессе мониторинга и анализа поведения. Такой подход обеспечивает не только всестороннюю проверку, но и гибкость в адаптации к новым угрозам и изменениям в архитектуре ИИ. Композируемость этой системы позволяет собирать убедительные аргументы в пользу безопасности, используя различные типы доказательств и логических связей, что значительно повышает надежность и прозрачность оценки.

«`html

Представленная работа акцентирует внимание на необходимости целостного подхода к обеспечению безопасности систем искусственного интеллекта. Она подчеркивает, что масштабируемость не определяется серверной мощностью, а ясностью идей и структурой, лежащей в основе системы. В этом контексте особенно перекликается высказывание Блеза Паскаля: «Всякое зло есть отсутствие блага». Подобно тому, как недостаток ясности в структуре может привести к уязвимостям в системе, отсутствие блага в любой области создает потенциал для негативных последствий. Данная структура шаблонов безопасности стремится к созданию целостной и прозрачной системы, где каждая часть взаимодействует с целым, обеспечивая надежность и предсказуемость поведения ИИ.

Что дальше?

Представленная работа, стремясь к созданию шаблонов для обоснования безопасности искусственного интеллекта, неизбежно сталкивается с фундаментальным вопросом: как измерить то, что по своей природе динамично и непредсказуемо? Шаблоны — это лишь застывшие снимки, а системы ИИ — текучие, эволюционирующие организмы. Попытка формализовать безопасность, не учитывая эту изменчивость, рискует создать иллюзию контроля, маскирующую реальные уязвимости. Каждое упрощение в шаблоне имеет свою цену, каждое добавление детали — свои риски.

Перспективы дальнейших исследований лежат не столько в создании всё более детализированных шаблонов, сколько в разработке методов динамической оценки безопасности. Необходимо отойти от статических проверок и перейти к непрерывному мониторингу, адаптивным метрикам и системам раннего предупреждения. Понимание структуры, определяющей поведение системы, требует не только анализа кода, но и глубокого изучения данных, на которых она обучается, и контекста, в котором она функционирует.

В конечном счёте, задача обеспечения безопасности ИИ — это не техническая проблема, а философская. Это поиск баланса между инновациями и ответственностью, между стремлением к прогрессу и необходимостью защиты от непредвиденных последствий. Элегантность решения не в сложности, а в простоте и ясности принципов, лежащих в его основе.

Оригинал статьи: https://arxiv.org/pdf/2601.22773.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Сердце музыки: открытые модели для создания композиций

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Квантовая геометрия: новые пути к пониманию пространства-времени

- Нейросети на грани: как перевести ИИ в логику для умных устройств

2026-02-02 13:06