Автор: Денис Аветисян

Новая работа предлагает переосмыслить подход к созданию надежных систем искусственного интеллекта, рассматривая доверие не как техническую задачу, а как основу для долгосрочного сотрудничества и взаимопонимания.

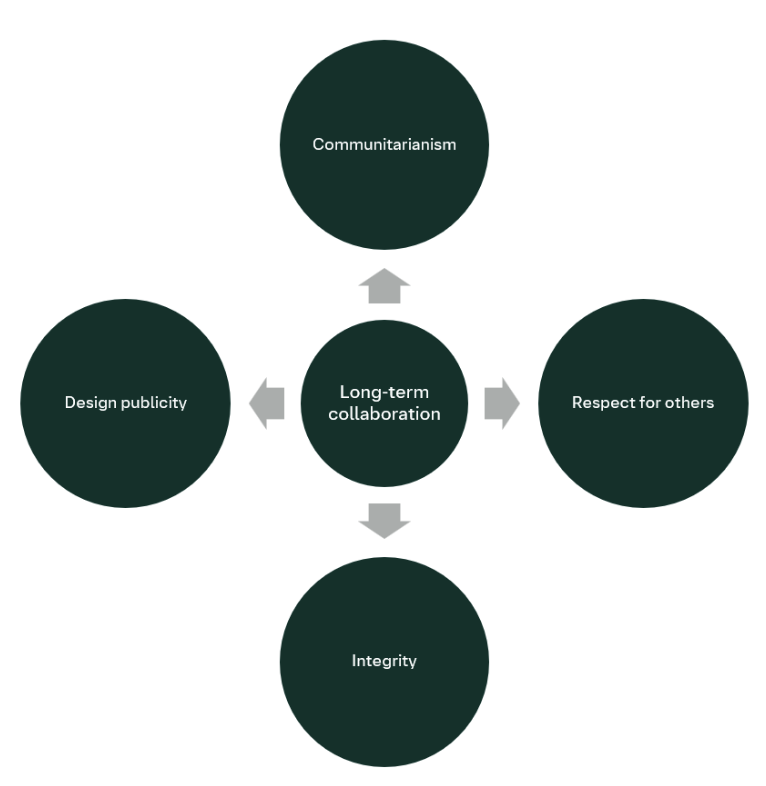

В статье представлена концепция построения доверия к ИИ на принципах реляционной этики и африканской философии убунту, с акцентом на ценности общности, уважения, честности и открытости проектирования.

Несмотря на растущий интерес к разработке «надежного» искусственного интеллекта, существующие подходы зачастую рассматривают доверие как свойство, поддающееся формализации и контролю. В данной статье, ‘Beyond Abstract Compliance: Operationalising trust in AI as a moral relationship’, предложена иная перспектива, основанная на принципах реляционной этики и африканской философии убунту. Авторы утверждают, что доверие следует понимать как динамичные, основанные на взаимном уважении отношения, формирующиеся в процессе долгосрочного сотрудничества с сообществами. Возможно ли, таким образом, перейти от формального соответствия требованиям к созданию действительно этичных и социально ответственных систем искусственного интеллекта?

Хрупкость доверия к искусственному интеллекту

Несмотря на значительные успехи в области искусственного интеллекта, общественное доверие к нему остается хрупким и неустойчивым. Эта прекарность обусловлена прежде всего опасениями, связанными с непрозрачностью алгоритмов и потенциальной предвзятостью, заложенной в процессе обучения. Многие системы ИИ функционируют как «черные ящики», что затрудняет понимание логики принятия решений и выявление возможных ошибок или дискриминации. Отсутствие объяснимости порождает обоснованное беспокойство у пользователей, опасающихся несправедливого или необъективного отношения. Подобная ситуация подрывает потенциал ИИ для решения важных социальных задач и требует разработки методов обеспечения прозрачности и справедливости в алгоритмах, чтобы завоевать и удержать доверие общества.

Современные подходы к разработке искусственного интеллекта зачастую концентрируются на достижении максимальной производительности и точности, отодвигая на второй план этические аспекты и вопросы справедливости. Это приводит к формированию фундаментального дефицита доверия со стороны общества, поскольку системы, оптимизированные исключительно для эффективности, могут демонстрировать предвзятость, непрозрачность и непредсказуемость в своих решениях. В результате, даже при впечатляющих технических достижениях, потенциальные выгоды от внедрения ИИ остаются недоступными, а опасения относительно его влияния на различные сферы жизни — от трудоустройства до правосудия — только усиливаются. Такая ситуация подчеркивает необходимость пересмотра приоритетов в разработке ИИ, с акцентом на создание систем, которые не только эффективны, но и надежны, справедливы и понятны для людей.

Недостаток доверия к искусственному интеллекту существенно ограничивает возможности его полезного применения в различных сферах жизни. По мере того, как системы ИИ внедряются в критически важные области, такие как здравоохранение, финансы и правосудие, отсутствие уверенности в их справедливости и надежности вызывает обоснованные опасения у общества. Эти опасения, в свою очередь, могут привести к неприятию инноваций, замедлению прогресса и усилению социальной напряженности. Например, если люди не доверяют алгоритмам, принимающим решения о кредитах или медицинских диагнозах, они могут отказаться от использования этих систем, тем самым лишая себя потенциальных выгод. Подобное недоверие не только препятствует развитию ИИ, но и может привести к формированию негативного общественного мнения, подрывая поддержку дальнейших исследований и разработок в этой области.

Неустойчивость доверия к искусственному интеллекту требует кардинального изменения подхода к его разработке. Данное исследование подчеркивает необходимость перехода от приоритета производительности к созданию систем, которые изначально заслуживают доверия. Ключевым элементом этого перехода является долгосрочное сотрудничество и активное вовлечение широкого сообщества в процесс разработки. Такой подход позволяет учитывать разнообразные этические соображения и ценности, а также обеспечивает прозрачность и подотчетность алгоритмов. В результате, формируется не просто эффективный, но и социально ответственный искусственный интеллект, способный преодолеть существующий дефицит доверия и раскрыть весь свой потенциал для решения сложных задач.

Проектирование доверия: Новый этический каркас

Методология “Доверие по замыслу” (Trust by Design) предполагает интеграцию этических принципов непосредственно в каждый этап жизненного цикла разработки искусственного интеллекта. Это включает в себя не только оценку рисков и смягчение потенциального вреда, но и проактивное проектирование систем с учетом человеческих ценностей и социальных последствий. Внедрение этических соображений на ранних стадиях разработки, таких как определение требований и проектирование архитектуры, позволяет избежать дорогостоящих изменений и переработок на более поздних этапах. Практическая реализация предполагает использование этических контрольных списков, проведение этических оценок воздействия и регулярный мониторинг систем на предмет соответствия этическим нормам.

Методология “Trust by Design” опирается на принципы реляционной этики, что подразумевает отказ от одностороннего доверия к искусственному интеллекту в пользу взаимообменного доверия и разделенной ответственности во взаимодействии с ним. В рамках этого подхода, доверие рассматривается не как присущее свойство системы, а как результат постоянного процесса взаимной оценки и адаптации между пользователем и ИИ. Акцент делается на установлении чётких механизмов обратной связи и подотчётности, обеспечивающих возможность корректировки поведения ИИ в соответствии с ожиданиями и ценностями пользователей, а также признание ответственности разработчиков за последствия работы системы.

Философия Убунту, подчеркивающая взаимосвязанность и гармонию в обществе, служит основополагающим принципом при разработке справедливых систем искусственного интеллекта. В контексте ИИ, Убунту предполагает, что ценность системы определяется не только ее функциональностью, но и ее способностью способствовать благополучию всех заинтересованных сторон. Это требует от разработчиков учитывать социальные последствия своих решений, обеспечивать справедливое распределение выгод и минимизировать потенциальный вред, рассматривая ИИ не как изолированный инструмент, а как часть сложной социальной системы, где благополучие каждого зависит от благополучия всех.

Методология “Доверие по замыслу” (Trust by Design) стремится к созданию систем искусственного интеллекта, соответствующих человеческим ценностям, посредством приоритезации уважения к личности и обеспечения прозрачности. Данный подход основывается на принципах реляционной этики, подчеркивая взаимную ответственность в процессе взаимодействия человека и ИИ. Обеспечение прозрачности включает в себя понятную объяснимость принимаемых ИИ решений и доступность информации о принципах его работы. Долгосрочное сотрудничество подразумевает постоянный мониторинг и адаптацию систем ИИ к меняющимся потребностям и ценностям общества, что позволяет поддерживать доверие и обеспечивать этичное использование технологий.

Практические инструменты для построения доверительного ИИ

Итеративная разработка, основанная на принципах Agile, позволяет встраивать этические соображения непосредственно в процесс создания систем искусственного интеллекта. Вместо последовательного подхода, при котором этические аспекты рассматриваются лишь на заключительном этапе, Agile предполагает частые циклы разработки, тестирования и получения обратной связи. Это дает возможность выявлять и устранять потенциальные предвзятости или нежелательные последствия на ранних стадиях, когда внесение изменений наименее затратно. Непрерывная интеграция этической экспертизы в каждый спринт обеспечивает более гибкую и адаптивную систему, способную учитывать меняющиеся нормы и требования к ответственному ИИ.

Управление данными является критически важным аспектом при разработке и обучении моделей искусственного интеллекта. Оно включает в себя определение и реализацию политик и процедур, обеспечивающих целостность, достоверность, доступность и безопасность данных. Это подразумевает контроль качества данных на всех этапах — от сбора и хранения до обработки и использования. Недостаточная проверка данных может привести к предвзятости моделей, неточным прогнозам и, как следствие, к ошибочным решениям. Эффективное управление данными также включает в себя соблюдение нормативных требований к защите персональных данных и конфиденциальности информации, а также обеспечение возможности отслеживания происхождения данных (data lineage) для аудита и анализа.

Красная команда (Red Teaming) представляет собой метод проактивной оценки безопасности и надежности систем искусственного интеллекта. В рамках этого процесса, группа специалистов имитирует действия злоумышленников или выявляет непреднамеренные последствия работы ИИ, подвергая систему целенаправленным атакам и стресс-тестам. Основная цель — обнаружить уязвимости в алгоритмах, предвзятости в данных, а также потенциальные ошибки в логике работы системы до ее внедрения в эксплуатацию. Результаты Red Teaming позволяют разработчикам вовремя устранить выявленные недостатки и минимизировать риски, связанные с некорректной или предвзятой работой ИИ, повышая общую надежность и безопасность системы.

Рамки управления искусственным интеллектом (ИИ) предоставляют структурированный подход к надзору и контролю над разработкой и применением ИИ-систем. Эти рамки включают в себя определение ролей и обязанностей, установление политик и процедур, а также механизмы мониторинга и оценки. Ключевые компоненты включают в себя принципы этичного ИИ, требования к прозрачности и объяснимости моделей, а также процессы управления рисками и обеспечения соответствия нормативным требованиям. Эффективные рамки управления ИИ позволяют организациям демонстрировать ответственность и надежность своих ИИ-систем, минимизируя потенциальные негативные последствия и способствуя доверию со стороны пользователей и заинтересованных сторон.

ИИ для общего блага: Расширение влияния

Концепция коммунитаризма в контексте развития искусственного интеллекта предполагает, что системы ИИ должны быть ориентированы на благополучие всего общества, а не только узкой группы пользователей или заинтересованных сторон. Это означает, что при проектировании и внедрении ИИ необходимо учитывать потребности и интересы различных социальных групп, обеспечивая равный доступ к преимуществам, которые эти технологии могут предложить. Вместо максимизации прибыли или эффективности для отдельных организаций, приоритет отдается созданию ИИ, способствующего социальной справедливости, уменьшению неравенства и улучшению качества жизни для всех членов общества. Такой подход требует от разработчиков и политиков активного участия общественности в процессе принятия решений, а также постоянного мониторинга и оценки воздействия ИИ на различные социальные группы, чтобы своевременно выявлять и устранять потенциальные негативные последствия.

Концепция «дизайнерской прозрачности» предполагает, что цели, логика работы и мотивация, лежащая в основе систем искусственного интеллекта, должны быть чётко определены и доступны для понимания. Это не просто техническая документация, а сознательное проектирование систем таким образом, чтобы их внутренние процессы были объяснимы и понятны не только специалистам, но и широкой общественности. Такой подход позволяет повысить ответственность разработчиков и операторов, поскольку становится возможным отследить, как принимаются решения, и оценить их соответствие этическим нормам и общественным ценностям. Прозрачность в проектировании способствует формированию доверия к системам ИИ, поскольку пользователи могут лучше понять, как они работают, и какие факторы влияют на их результаты, что критически важно для широкого внедрения и принятия этих технологий.

Целостность, как основополагающая ценность в разработке и внедрении искусственного интеллекта, требует последовательности, честности и этической непротиворечивости на всех этапах. Это означает, что системы ИИ должны функционировать предсказуемо и надежно, избегая скрытых предубеждений или манипулятивных алгоритмов. Необходима прозрачность в отношении данных, используемых для обучения, и логики, лежащей в основе принимаемых решений. Постоянство в соблюдении этических принципов — от проектирования до развертывания — гарантирует, что ИИ будет служить общественным интересам, а не преследовать узкие или корыстные цели. В конечном счете, приверженность целостности формирует доверие к технологиям ИИ и способствует их ответственному использованию.

Применение принципов общности, прозрачности и добропорядочности открывает возможности для реализации полного потенциала искусственного интеллекта в решении насущных социальных проблем и улучшении качества жизни. Данное исследование подчеркивает, что подлинное доверие к системам ИИ выходит за рамки простой технической эффективности и требует ясного понимания целей, логики и мотиваций, лежащих в основе их работы. Вместо слепой веры в алгоритмы, необходимо стремиться к созданию ИИ, который не только решает конкретные задачи, но и способствует всеобщему благополучию, обеспечивая справедливость и доступность для всех членов общества. Такой подход позволит не просто автоматизировать процессы, но и укрепить социальную сплоченность и повысить уровень доверия к технологиям в целом.

Предлагаемая работа акцентирует внимание на необходимости формирования доверия к искусственному интеллекту не просто как соответствия абстрактным нормам, но и как моральных отношений, основанных на принципах взаимности и общности. Это перекликается с идеями Анри Пуанкаре: «Наука не состоит из ряда случайных открытий, а представляет собой взаимосвязанное целое». Действительно, как отмечает исследование, система искусственного интеллекта должна рассматриваться как живой организм, где поведение определяется структурой и взаимодействием с сообществом. Подход, основанный на философии Убунту и принципах коммунитаризма, подчеркивает важность долгосрочного сотрудничества и уважения к ценностям сообщества, что позволяет создать действительно надежные и этичные системы ИИ. Документация фиксирует структуру, но не передаёт поведение — оно рождается во взаимодействии.

Что дальше?

Предложенный подход к доверию к искусственному интеллекту, опирающийся на принципы взаимоотношений и философию Убунту, обнажает сложность самой концепции доверия. Слишком часто доверие рассматривается как простое соответствие техническим требованиям, а не как динамичный процесс, требующий постоянного участия и взаимной ответственности. Будущие исследования должны сосредоточиться не на создании «доверительного» ИИ, а на разработке систем, способных поддерживать и укреплять доверие в долгосрочной перспективе, учитывая контекст и ценности конкретных сообществ.

Особое внимание следует уделить практической реализации принципа «дизайна публичности». Прозрачность, хотя и необходима, недостаточна. Система должна быть не просто понятной, но и восприимчивой к критике и адаптации на основе обратной связи от заинтересованных сторон. Крайне важно понять, что «хорошая архитектура незаметна, пока не ломается, и только тогда видна настоящая цена решений». Оценка эффективности такого подхода потребует новых метрик, выходящих за рамки традиционных показателей точности и эффективности.

В конечном итоге, настоящий вызов заключается в преодолении техноцентричного взгляда на доверие. Искусственный интеллект — это инструмент, и его ценность определяется не его возможностями, а тем, как он используется для достижения общих целей. Будущие исследования должны сосредоточиться на создании систем, которые не просто «доверяют», но и способствуют развитию более справедливого и гуманного общества.

Оригинал статьи: https://arxiv.org/pdf/2601.22769.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Сердце музыки: открытые модели для создания композиций

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Ищем закономерности: Новый пакет TSQCA для R

- Эффективная память для больших языковых моделей: новый подход LOOKAT

2026-02-03 04:11