Автор: Денис Аветисян

Исследователи представили BayeSQP — инновационный метод байесовской оптимизации, способный эффективно решать сложные задачи в многомерных пространствах.

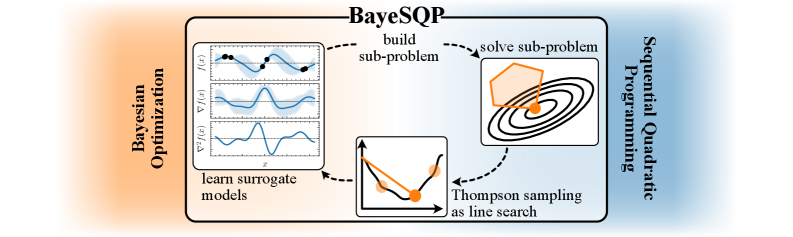

BayeSQP объединяет последовательное квадратичное программирование и гауссовские процессы для оптимизации с ограничениями в задачах высокой размерности.

Эффективная оптимизация в высокоразмерных пространствах часто осложняется необходимостью баланса между исследованием и использованием информации. В данной работе представлена методика ‘BayeSQP: Bayesian Optimization through Sequential Quadratic Programming’ — новый алгоритм байесовской оптимизации, объединяющий принципы последовательного квадратичного программирования с гауссовскими процессами. Алгоритм использует оценки второго порядка для моделирования как целевой функции, так и ограничений, позволяя находить решения с учетом неопределенности модели. Позволит ли данный подход преодолеть ограничения существующих методов и открыть новые возможности для оптимизации сложных систем?

Вызов Многомерной Оптимизации

Многие задачи, возникающие в реальном мире — от проектирования сложных молекул и оптимизации финансовых портфелей до управления робототехникой и машинным обучением — требуют нахождения оптимальных решений для функций, зависящих от огромного количества переменных. Такая многомерность представляет собой серьезные вычислительные трудности, поскольку пространство поиска растет экспоненциально с увеличением числа измерений. Это означает, что даже для относительно простых функций, при большом количестве параметров, полный перебор всех возможных вариантов становится практически невозможным. Поиск оптимального решения в таком пространстве требует не только значительных вычислительных ресурсов, но и разработки специальных алгоритмов, способных эффективно справляться с «проклятием размерности» и избегать застревания в локальных оптимумах, которые могут быть далеки от глобального максимума или минимума искомой функции.

Традиционные методы оптимизации, разработанные для задач с небольшим числом переменных, сталкиваются с серьезными трудностями в высокоразмерных пространствах. Это связано с так называемым «проклятием размерности», когда объем пространства поиска растет экспоненциально с увеличением числа переменных. В результате, алгоритмы становятся значительно медленнее, требуя огромных вычислительных ресурсов для достижения приемлемого решения. Кроме того, возрастает вероятность попадания в локальные оптимумы — точки, где функция достигает минимального или максимального значения лишь в ограниченной окрестности, препятствуя поиску глобального оптимума. Таким образом, эффективное решение задач оптимизации в высокоразмерных пространствах требует разработки новых подходов, способных преодолеть эти ограничения и обеспечить быстрый и надежный поиск оптимальных решений.

Для успешного решения задач оптимизации в многомерных пространствах необходим тщательный баланс между исследованием и использованием имеющейся информации. Исследование подразумевает поиск новых, потенциально более выгодных областей в пространстве параметров, даже если это связано с риском временных потерь. Использование, напротив, фокусируется на улучшении решения в уже известных, перспективных областях. Эффективные стратегии оптимизации, такие как генетические алгоритмы или методы роя частиц, именно этот баланс и обеспечивают, позволяя избегать застревания в локальных оптимумах и находить глобально оптимальные решения даже в чрезвычайно сложных ландшафтах. Недостаток в исследовании может привести к преждевременной сходимости к субоптимальному результату, в то время как избыточное исследование может замедлить процесс и снизить эффективность.

Байесовская Оптимизация: Вероятностный Подход

Байесовская оптимизация представляет собой эффективный подход к оптимизации “черных ящиков” — функций, для которых аналитическое выражение отсутствует или вычисление затруднено. В основе метода лежит использование вероятностных суррогатных моделей, таких как Гауссовские процессы GP(x), которые аппроксимируют целевую функцию. Гауссовский процесс позволяет не только предсказывать значение функции в заданной точке x, но и оценивать неопределенность этого предсказания, выраженную дисперсией. Использование вероятностной модели позволяет алгоритму эффективно исследовать пространство параметров, фокусируясь на областях с наибольшей потенциальной выгодой и учитывая уровень неопределенности в оценках.

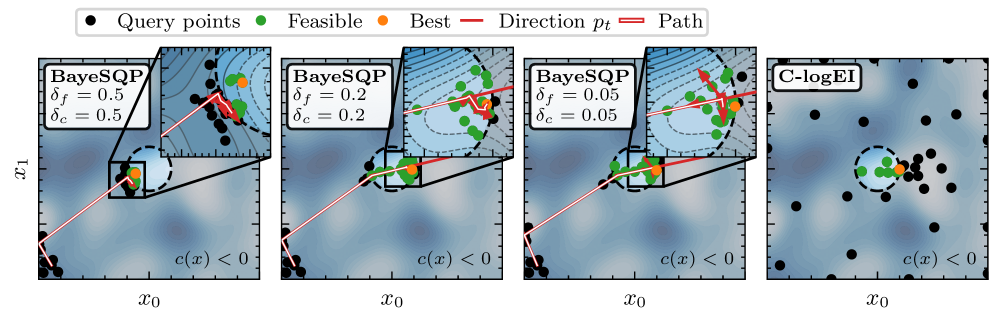

Байесовская оптимизация использует вероятностное моделирование целевой функции, представляя её как распределение вероятностей. Это позволяет алгоритму оценивать не только значение функции в конкретной точке, но и неопределенность этой оценки. Баланс между исследованием (exploration) новых, потенциально оптимальных областей пространства поиска и эксплуатацией (exploitation) уже известных, перспективных областей достигается посредством функций приобретения (acquisition functions), таких как Thompson Sampling. Thompson Sampling, в частности, отбирает точки для оценки, основываясь на случайной выборке из апостериорного распределения целевой функции, что позволяет эффективно исследовать пространство и находить глобальный оптимум с меньшим количеством итераций. Использование распределения вероятностей для представления целевой функции позволяет алгоритму адаптироваться к сложности задачи и эффективно управлять компромиссом между исследованием и эксплуатацией.

Расширения, такие как HighDimensionalBayesianOptimization и LocalBayesianOptimization, предназначены для решения специфических проблем, возникающих в сложных пространствах поиска. HighDimensionalBayesianOptimization использует методы снижения размерности и моделирование подпространств для эффективной оптимизации функций с большим количеством переменных. Это позволяет избежать проклятия размерности и ускорить процесс поиска. LocalBayesianOptimization, в свою очередь, ориентирован на негладкие и мультимодальные функции, где глобальная модель неэффективна. Он использует локальные суррогатные модели, построенные на небольших подмножествах данных, что позволяет более точно аппроксимировать функцию в окрестности текущей точки и избегать застревания в локальных оптимумах. Оба подхода направлены на повышение масштабируемости и эффективности байесовской оптимизации в задачах, где стандартные методы оказываются недостаточно эффективными.

BayeSQP: Гибридный Подход к Оптимизации

BayeSQP представляет собой новый алгоритм оптимизации, объединяющий в себе методы последовательного квадратичного программирования (SQP) и байесовской оптимизации. Данный гибридный подход позволяет эффективно решать задачи оптимизации как с ограничениями, так и без них. Интеграция SQP обеспечивает локальную точность и быструю сходимость вблизи оптимального решения, в то время как байесовская оптимизация используется для глобального поиска и исследования пространства параметров, что повышает устойчивость и эффективность алгоритма в сложных задачах оптимизации.

Алгоритм BayeSQP эффективно решает задачи оптимизации как с ограничениями, так и без них, благодаря комбинированию двух подходов. Последовательное квадратичное программирование (SQP) используется для точной локальной оптимизации в окрестности текущего решения, что обеспечивает быстрое схождение к локальному минимуму. Байесовская оптимизация, в свою очередь, отвечает за глобальное исследование пространства параметров, позволяя находить перспективные области для дальнейшей оптимизации и избегать застревания в локальных минимумах. Такое сочетание позволяет BayeSQP эффективно справляться с широким спектром задач, требующих как глобального поиска, так и точной локальной оптимизации.

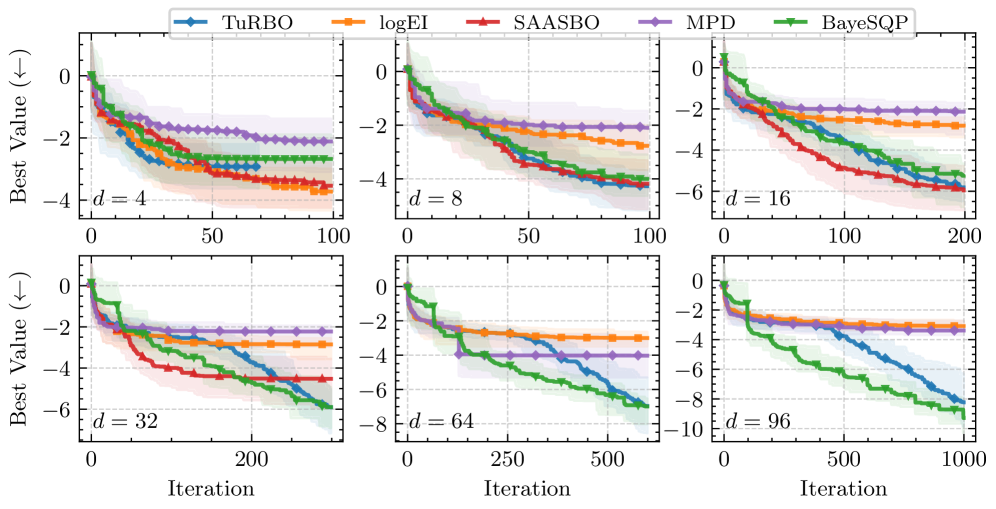

Эффективность алгоритма BayeSQP обеспечивается применением методов ускорения вычислений. В частности, для аппроксимации Гауссовских процессов используется RandomFourierFeatures, что значительно снижает вычислительную сложность. Решение квадратичных программ, возникающих в процессе оптимизации, осуществляется с помощью разложения Холецкого (CholeskyDecomposition). В результате, в задачах высокой размерности (96D) BayeSQP демонстрирует ускорение оптимизации в диапазоне от 2 до 10 раз по сравнению с алгоритмом TuRBO.

Надежность и Практическое Применение

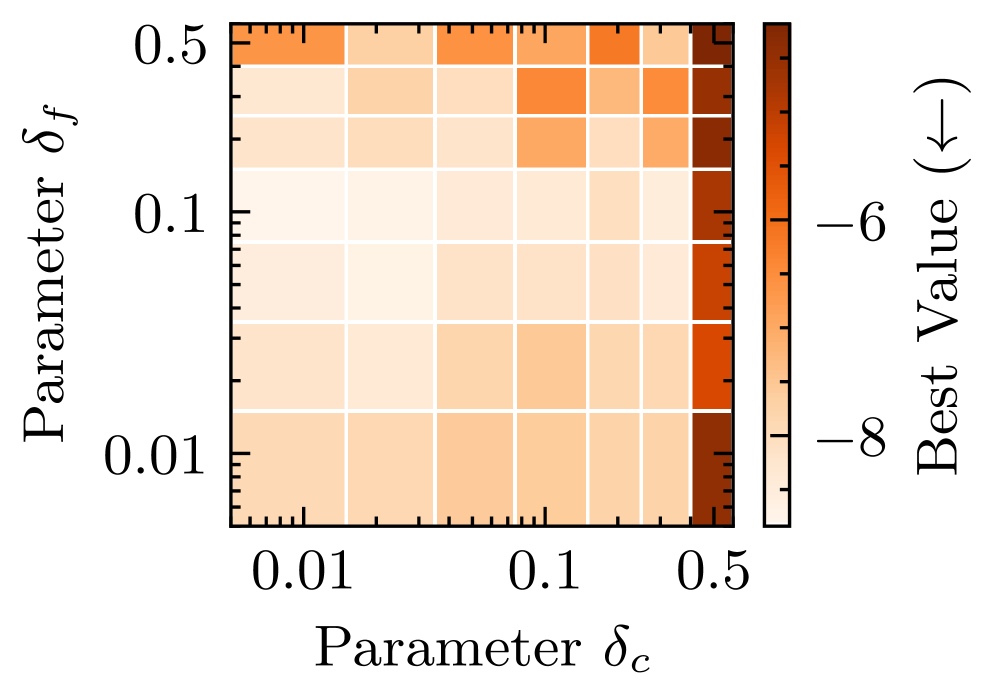

Чрезвычайно важным аспектом является поддержание численной устойчивости, особенно при работе с плохо обусловленными гессианскими матрицами на этапах последовательного квадратичного программирования (SQP). Неустойчивость в вычислениях, возникающая из-за плохо обусловленности, может привести к значительным ошибкам и замедлить сходимость алгоритма. Для смягчения этой проблемы применяются методы регуляризации и предобуславливания, направленные на улучшение обусловленности матрицы и обеспечение более точных и надежных вычислений. В частности, использование стратегий, изменяющих масштаб переменных и добавляющих небольшие возмущения, позволяет избежать численных проблем, возникающих при решении систем линейных уравнений с плохо обусловленными матрицами, что в конечном итоге способствует повышению общей эффективности и надежности алгоритма оптимизации.

Для эффективного обеспечения выполнения ограничений в процессе оптимизации используется продуманная комбинация вспомогательных переменных и функции Лагранжа. Неравенства, которые изначально представляют сложность для алгоритмов, преобразуются в эквивалентные уравнения путем введения так называемых переменных Slack. x_s — это переменные, позволяющие “сгладить” неравенство, добавив к нему допустимое отклонение. Функция Лагранжа, формируемая на основе целевой функции и ограничений (включая преобразованные равенства), объединяет все условия в единое выражение. Такой подход не только упрощает процесс поиска оптимального решения, но и позволяет использовать методы, разработанные для работы с равенствами, что значительно повышает стабильность и эффективность алгоритма, особенно в задачах с большим количеством ограничений.

Алгоритм демонстрирует значительные возможности в решении задач высокой размерности и с комплексными ограничениями, что открывает широкие перспективы его применения в различных областях. В частности, в инженерном проектировании он позволяет оптимизировать сложные системы с множеством взаимосвязанных параметров. В области машинного обучения данный подход обеспечивает более эффективное обучение моделей, особенно в случаях, когда необходимо учитывать сложные ограничения на параметры или структуру модели. Результаты сравнительного анализа показывают, что предложенный алгоритм не только превосходит существующие аналоги по качеству получаемых решений, но и существенно сокращает время вычислений, что особенно важно при работе с большими объемами данных и сложными моделями. Это снижение времени вычислений, или “wall-clock time”, делает его привлекательным для практического использования в реальных приложениях, где скорость и точность оптимизации имеют первостепенное значение.

Исследование представляет собой попытку не просто найти оптимальное решение, а понять саму структуру оптимизации. Авторы BayeSQP, используя комбинацию последовательного квадратичного программирования и гауссовских процессов, словно проводят реверс-инжиниринг задачи, выявляя скрытые закономерности в высокоразмерном пространстве. Этот подход позволяет алгоритму адаптироваться к сложным ограничениям и демонстрировать превосходство над существующими методами. Как заметил Марвин Минский: «Наиболее перспективные исследования — это те, которые начинаются с вопроса «а что, если?»». Именно этот дух исследовательского поиска, проверки существующих правил и поиска новых путей лежит в основе разработки BayeSQP.

Что Дальше?

Представленный подход, BayeSQP, демонстрирует способность эффективно ориентироваться в пространствах высокой размерности, где традиционные методы оптимизации часто терпят неудачу. Однако, кажущаяся элегантность алгоритма не должна заслонять фундаментальные вопросы. Оптимизация — это всегда поиск компромисса, а Gaussian Processes, несмотря на свою мощь, имеют свои пределы в масштабируемости. Следующим шагом представляется не просто увеличение вычислительной мощности, а переосмысление самой модели неопределенности. Возможно, истинный прорыв лежит в отказе от строгих вероятностных предположений в пользу более гибких, адаптивных моделей, способных “взламывать” структуру целевой функции.

Ограничения, накладываемые на оптимизируемые параметры, — это не просто техническая деталь, а отражение реальности. BayeSQP успешно справляется с ними, но вопрос в том, насколько адекватно эти ограничения сформулированы. Реальный мир редко предоставляет чёткие границы. Поэтому, алгоритмы будущего должны будут научиться работать с нечёткостью, с противоречивыми требованиями, с данными, которые постоянно меняются. Это требует не просто улучшения численных методов, а разработки новых принципов построения оптимизационных стратегий.

В конечном счете, BayeSQP — это лишь еще один инструмент в арсенале исследователя. Его ценность заключается не в абсолютной эффективности, а в способности стимулировать дальнейший поиск. Оптимизация — это бесконечный цикл проб и ошибок, постоянный “reverse engineering” реальности. Истинный прогресс заключается в умении задавать правильные вопросы и не бояться разрушать устоявшиеся правила.

Оригинал статьи: https://arxiv.org/pdf/2602.03232.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Сердце музыки: открытые модели для создания композиций

- Доказательство устойчивости веб-агента: проактивное свертывание контекста для задач с горизонтом в бесконечность.

- Игры без модели: новый подход к управлению в условиях неопределенности

2026-02-05 03:40