Автор: Денис Аветисян

Новая архитектура DARWIN демонстрирует способность нейронных сетей к самосовершенствованию посредством генетического алгоритма и взаимодействия агентов.

DARWIN: Фреймворк, использующий генетический алгоритм и LLM-агентов для модификации кода обучения, что привело к улучшению эффективности модели на 1.26% и снижению перплексии на 2.07% за пять итераций.

Несмотря на впечатляющие возможности современных больших языковых моделей, их самосовершенствование остается сложной задачей. В данной работе представлена система ‘DARWIN: Dynamic Agentically Rewriting Self-Improving Network’, реализующая эволюционный подход к обучению, в котором независимые GPT-агенты модифицируют код обучения друг друга, подобно генетическому алгоритму. Эксперименты показали улучшение эффективности использования вычислений на 1.26% и снижение перплексии на 2.07% за пять итераций, демонстрируя потенциал для масштабирования эволюционного обучения языковых моделей. Возможно ли создание полностью автономной системы самообучения, способной превзойти существующие подходы к оптимизации LLM?

Эволюция Интеллекта: За Пределами Статических Моделей

Традиционные модели искусственного интеллекта, несмотря на свою впечатляющую производительность в решении конкретных задач, часто демонстрируют ограниченность в способности к адаптации и дальнейшему развитию. Их фиксированная архитектура, разработанная для определенного набора данных или алгоритмов, становится препятствием при столкновении с новыми, неожиданными условиями или задачами. В отличие от биологических систем, способных к эволюции и обучению на протяжении всей жизни, эти модели достигают своего пика производительности, после чего их возможности остаются статичными. Это проявляется в виде “плато производительности”, когда дальнейшее увеличение вычислительных ресурсов или оптимизация параметров не приводят к существенному улучшению результатов, подчеркивая необходимость принципиально новых подходов к созданию интеллектуальных систем.

Вдохновлённые принципами эволюционных вычислений, исследователи предлагают принципиально новый подход к созданию искусственного интеллекта. Вместо разработки систем с фиксированной архитектурой, всё больше внимания уделяется созданию алгоритмов, способных к итеративному самосовершенствованию. Этот подход имитирует естественный отбор, где решения, демонстрирующие большую эффективность, «выживают» и развиваются, а менее успешные — отсеиваются. В результате, система не просто решает поставленные задачи, но и непрерывно адаптируется и улучшает свои способности, подобно тому, как эволюционируют живые организмы. Такой самообучающийся ИИ обещает преодолеть ограничения традиционных моделей и открыть путь к созданию действительно интеллектуальных систем, способных к непредсказуемому росту и инновациям.

Вместо создания искусственного интеллекта, достигшего определенного уровня, современное направление исследований фокусируется на разработке систем, способных к самостоятельному улучшению. Цель заключается не просто в достижении интеллекта, но и в создании способности к рекурсивному самосовершенствованию, когда система способна анализировать собственную архитектуру и алгоритмы, вносить изменения и тем самым повышать свою эффективность. Этот подход предполагает создание алгоритмов, имитирующих принципы эволюции, где происходит постоянная мутация, отбор и адаптация. Это позволяет искусственному интеллекту не только решать текущие задачи, но и постоянно расширять свои возможности и учиться быстрее, открывая перспективы для создания действительно самообучающихся и развивающихся систем.

DARWIN: Эволюционный Фреймворк для GPT-Моделей

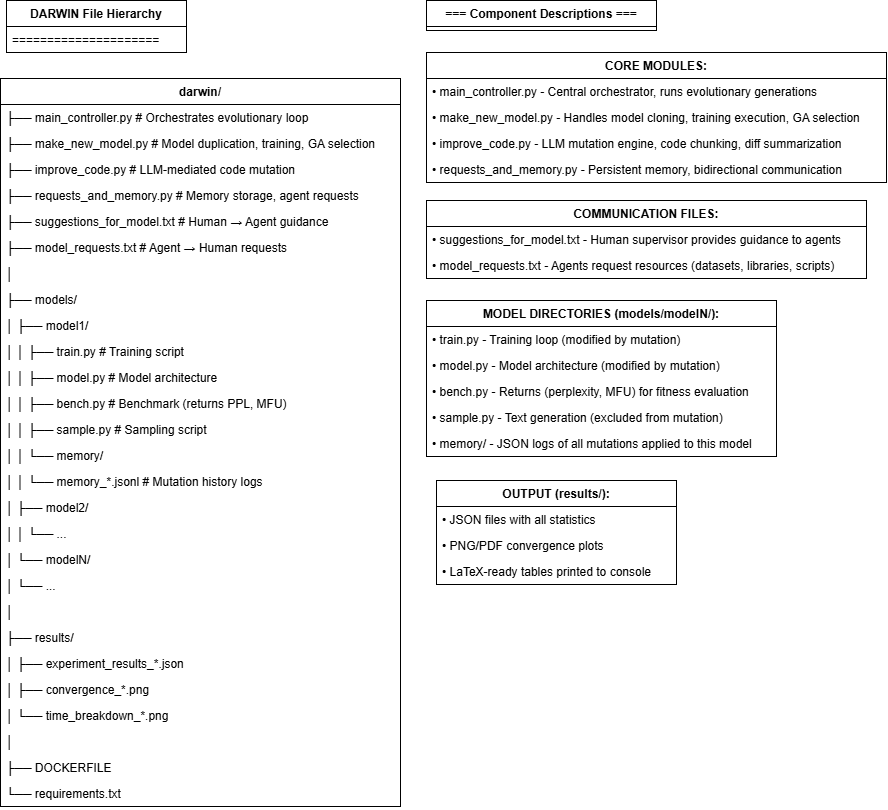

DARWIN использует генетический алгоритм для эволюции кода обучения GPT-моделей, имитируя процессы мутации и отбора. В рамках этого алгоритма, различные варианты кода обучения подвергаются случайным изменениям (мутациям). Затем, эффективность каждого измененного варианта оценивается на основе заданных метрик производительности. Варианты кода, демонстрирующие улучшение показателей, отбираются для дальнейшего использования и служат основой для создания новых мутаций. Этот итеративный процесс, включающий мутацию, оценку и отбор, позволяет автоматически оптимизировать код обучения GPT-моделей, направляя эволюцию в сторону повышения производительности и эффективности.

В системе DARWIN независимые агенты, основанные на GPT и взаимодействующие с OpenAI API, выполняют модификацию кода обучения других агентов. Каждый агент получает запрос на изменение кода, который затем применяется к копии кода другого агента. Этот процесс итеративно повторяется, создавая цикл, в котором агенты предлагают улучшения, а система оценивает их влияние на производительность. Изменения кода фиксируются, и успешные модификации способствуют повышению общей эффективности модели GPT, что позволяет автоматизировать процесс оптимизации и выявления наиболее эффективных стратегий обучения.

Использование контейнеризации посредством Docker обеспечивает безопасное выполнение и изоляцию агентов в процессе модификации кода. Каждый агент, выполняющий изменение, работает в отдельном контейнере, что предотвращает влияние некорректного или вредоносного кода на систему в целом. Это позволяет проводить эксперименты с кодом, не рискуя стабильностью основной среды обучения. Docker также упрощает процесс развертывания и масштабирования агентов, обеспечивая воспроизводимость результатов и облегчая управление зависимостями.

Для отслеживания прогресса эволюции и корреляции между изменениями в коде и улучшением производительности моделей GPT, DARWIN использует постоянную память, реализованную через хранение данных в формате JSON. Каждое изменение, внесенное агентами в код обучения, фиксируется в JSON-файлах вместе с соответствующими метриками производительности. Это позволяет системе оценивать вклад каждого изменения в общую эффективность модели, отслеживать регрессии и идентифицировать наиболее успешные мутации. Хранение данных в JSON обеспечивает структурированный и легко анализируемый формат, позволяющий системе автоматически сопоставлять изменения в коде с полученными результатами и оптимизировать процесс эволюции.

Валидация и Производительность: Количественная Оценка Самосовершенствования

Оценка производительности DARWIN осуществляется посредством ключевых метрик, таких как Perplexity и Model FLOPS Utilization (MFU). В ходе пяти итераций обучения зафиксировано улучшение Perplexity на 2.07% и MFU на 1.26%. Perplexity является показателем вероятности предсказания последовательности токенов моделью, где более низкое значение указывает на лучшую производительность. MFU отражает эффективность использования вычислительных ресурсов, измеряя количество операций с плавающей точкой в секунду (FLOPS), используемых моделью относительно ее размера и сложности. Повышение этих метрик свидетельствует о последовательном улучшении эффективности и оптимизации модели DARWIN.

В основе архитектуры DARWIN лежит интерфейс с участием человека (HITL), обеспечивающий управляемую эволюцию и точечные улучшения. Этот интерфейс позволяет экспертам просматривать и оценивать предлагаемые изменения в коде, сгенерированные GPT-агентами, прежде чем они будут внедрены в процесс обучения. Такой подход гарантирует, что улучшения не только количественно измеримы (например, снижение перплексии или повышение эффективности использования вычислительных ресурсов), но и соответствуют заданным критериям качества и безопасности, а также позволяют корректировать направление развития модели в соответствии с потребностями и приоритетами разработчиков. Интерфейс HITL выступает ключевым элементом контроля и валидации в процессе самооптимизации.

В качестве основы для экспериментов и итеративного улучшения была выбрана архитектура nanoGPT. Данный фреймворк обеспечивает надежную и стабильную платформу для проведения тестов и внедрения изменений, благодаря своей оптимизированной структуре и относительно небольшому размеру. Использование nanoGPT позволяет снизить вычислительные затраты на каждую итерацию обучения и валидации, что критически важно для процесса самооптимизации, осуществляемого посредством циклов модификации кода и последующего обучения. Преимущества nanoGPT заключаются в его простоте и понятности, что облегчает анализ и внесение изменений в архитектуру модели.

Постоянный цикл модификации кода обучения, управляемый GPT-агентами, представляет собой уникальную форму самооптимизации. В данном процессе, агенты не просто используют существующий код, но и активно изменяют его, направляя процесс обучения и совершенствуя архитектуру модели. Это отличается от традиционных методов оптимизации, где изменения в коде вносятся человеком. Автоматизированное изменение кода обучения позволяет системе адаптироваться и улучшать свои характеристики — такие как perplexity и Model FLOPS Utilization (MFU) — без непосредственного вмешательства разработчика, что демонстрирует способность к автономному совершенствованию.

Перспективы Развития: Масштабирование и Расширение Возможностей DARWIN

Основополагающие принципы DARWIN не ограничиваются архитектурой GPT-моделей, находя отклик в других передовых фреймворках, таких как Self-Taught Optimizer (STOP) и HealthFlow. STOP, ориентированный на самостоятельное обучение оптимизаторов, предоставляет DARWIN возможность динамически адаптировать и совершенствовать свои алгоритмы обучения без внешнего вмешательства. В свою очередь, HealthFlow, изначально разработанный для медицинских приложений, обеспечивает DARWIN структуру для обработки и анализа сложных, многомерных данных, что значительно расширяет его потенциал в различных областях. Этот межфреймворковый подход позволяет DARWIN использовать сильные стороны каждого инструмента, создавая более гибкую, надежную и масштабируемую систему искусственного интеллекта, чем традиционные модели, основанные исключительно на трансформерах.

Архитектура системы DARWIN обладает значительным потенциалом для масштабирования за счет применения распределенных вычислений. Использование сетевых вычислительных систем или кластеров графических процессоров позволит существенно увеличить скорость обработки данных и расширить возможности обучения модели. Такой подход не только сократит время, необходимое для выполнения сложных задач, но и позволит обрабатывать значительно большие объемы информации, что критически важно для дальнейшего развития искусственного интеллекта. Переход к распределенной архитектуре откроет путь к решению задач, недоступных для текущей реализации, и обеспечит более эффективное использование доступных вычислительных ресурсов, что является ключевым фактором для долгосрочного развития и внедрения DARWIN.

Архитектура DARWIN опирается на концепцию теоретической машины Гёделя, что открывает перспективные пути к созданию по-настоящему самореферентного и автономного искусственного интеллекта. В отличие от традиционных систем, где логика и данные разделены, DARWIN стремится интегрировать саму систему в процесс анализа и самосовершенствования. Подобно тому, как машина Гёделя должна была бы генерировать и проверять собственные утверждения, DARVIN способен к рекурсивному анализу своей собственной работы, выявляя ошибки и оптимизируя алгоритмы без внешнего вмешательства. Этот подход, вдохновленный принципами математической логики, предполагает, что искусственный интеллект может выйти за рамки простого выполнения задач и перейти к самообучению и развитию, что является ключевым шагом к созданию действительно интеллектуальных систем.

В ходе тестирования системы DARWIN было зафиксировано 37,5% ошибок на 50 обученных экземплярах. Однако, важно отметить, что система продемонстрировала способность к самокоррекции, успешно разрешая 16,67% из возникших ошибок. Этот показатель свидетельствует о потенциале DARWIN к автономному улучшению и адаптации, а также подчеркивает важность дальнейших исследований в области механизмов самодиагностики и исправления ошибок в системах искусственного интеллекта. Полученные данные указывают на то, что DARWIN не просто выполняет заданные задачи, но и способен анализировать собственные действия и корректировать их, что является важным шагом на пути к созданию более надежных и интеллектуальных систем.

Исследование DARWIN демонстрирует, что эволюция в искусственном интеллекте — это не просто оптимизация параметров, а переписывание самого кода, лежащего в основе обучения. Этот процесс напоминает естественный отбор, где агенты, модифицирующие код друг друга, становятся двигателем прогресса. Как однажды заметил Роберт Тарьян: «Алгоритмы — это лишь способ выразить то, что мы действительно знаем». В DARWIN, агенты, переписывая код, фактически выражают свое понимание оптимальных стратегий обучения, подтверждая, что истинная устойчивость начинается там, где кончается уверенность в статических решениях. Улучшение FLOPS на 1.26% и снижение перплексии на 2.07% — это не просто цифры, а свидетельство того, что системы, способные к самомодификации, могут превзойти заранее заданные рамки.

Что Дальше?

Представленная работа демонстрирует возможность эволюционного улучшения языковых моделей посредством генетического алгоритма, где агенты, основанные на больших языковых моделях, модифицируют код обучения друг друга. Однако, улучшение в 1.26% по FLOPS и 2.07% по перплексии за пять итераций — это лишь первый росток в саду, где каждое новое поколение может оказаться слабее предыдущего. Система, как и любое сложное образование, не стремится к оптимизации, а к зависимости. Разделение на агентов не снимает проблему общей судьбы; всё связанное когда-нибудь упадёт синхронно, даже если каждый агент оптимизирован локально.

Будущие исследования должны сосредоточиться не на достижении незначительных улучшений в метриках, а на понимании пределов самосовершенствования. Необходимо исследовать, как избежать преждевременной конвергенции генетического алгоритма и как обеспечить устойчивость к случайным ошибкам в коде, модифицируемом агентами. Интервенция человека, как и любая попытка контроля, неизбежно вносит искажения. Вопрос в том, не превратится ли система в сложный механизм для легитимизации субъективных предпочтений.

Перспективным направлением представляется изучение динамики конкуренции между агентами. Неизбежно возникнет иерархия, где доминирующие агенты будут подавлять инновации со стороны более слабых. В конечном счете, эволюция — это не процесс оптимизации, а процесс усложнения. И усложнение, как известно, часто ведёт к хрупкости.

Оригинал статьи: https://arxiv.org/pdf/2602.05848.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный исследователь: Новые горизонты автономных агентов

- Ускорение генеративных моделей: новый подход к вычислению матричной экспоненты

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Квантовая суперпозиция: новая интерпретация вероятности

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Квантовая геометрия: новые пути к пониманию пространства-времени

- Свет и материя в наноструктурах: как взаимодействуют фотоны и экситоны

- Квантовая критичность в квазикристаллах: новая фаза материи

2026-02-08 23:57