Автор: Денис Аветисян

В статье представлен метод повышения точности и надёжности мультимодального поиска за счёт использования моделей, способных к логическому мышлению.

Исследование предлагает data-centric подход к универсальному мультимодальному поиску, основанный на создании плотных семантических представлений с использованием внешних шагов рассуждений, реализованных через Vision-Language модели.

helpСовременные модели универсального мультимодального поиска часто демонстрируют хрупкость при решении задач, требующих скрытого логического вывода. В работе ‘Reasoning-Augmented Representations for Multimodal Retrieval’ предложен подход, основанный на отделении этапов рассуждений от поиска, с использованием Vision-Language Models для создания плотных семантических представлений. Этот метод позволяет повысить устойчивость и эффективность поиска за счет явного представления скрытой информации в визуальных данных и запросах. Способны ли подобные data-centric подходы кардинально улучшить качество мультимодального поиска и открыть новые горизонты для обработки сложных запросов?

За гранью простого поиска: вызовы мультимодальности

Традиционные методы поиска информации сталкиваются с серьезными трудностями при работе с разнородными данными, включающими текст, изображения и звук. В отличие от систем, работающих только с одним типом данных, универсальный поиск требует учета специфики каждой модальности. Например, алгоритмы, эффективно работающие с текстовыми запросами, часто оказываются неспособными адекватно интерпретировать визуальный контент, и наоборот. Это приводит к необходимости разработки отдельных решений для каждой модальности — текстового поиска, поиска по изображениям и т.д. — что значительно усложняет процесс создания единой, универсальной системы извлечения информации и ограничивает возможности полноценного мультимодального поиска.

Для достижения поистине универсальных возможностей поиска необходимо эффективно преодолеть семантический разрыв между различными модальностями данных. Суть проблемы заключается в том, что информация, представленная в виде текста, изображений, аудио или видео, кодируется различными способами и может иметь разную степень абстракции. Именно поэтому простое сопоставление данных по ключевым словам или пикселям недостаточно. Требуются сложные алгоритмы, способные извлекать общие семантические значения из разнородных данных и строить единое представление, позволяющее осуществлять поиск и извлечение информации независимо от модальности запроса или содержимого. Успешное решение этой задачи откроет возможности для создания поисковых систем, способных понимать и объединять информацию из различных источников, обеспечивая пользователям более полный и релевантный опыт.

Существующие оценочные наборы данных для мультимодального поиска часто оказываются недостаточно сложными для адекватной проверки способности систем к глубокому пониманию и обобщению. Большинство текущих бенчмарков концентрируются на простых соответствиях между модальностями, например, поиск изображения по текстовому запросу, игнорируя более тонкие аспекты, такие как рассуждения, причинно-следственные связи или понимание контекста. Это приводит к ситуации, когда модели могут демонстрировать высокие показатели на этих наборах данных, но при этом испытывать трудности с реальными задачами, требующими более сложной интерпретации и интеграции информации из различных источников. Для создания действительно универсальных систем мультимодального поиска необходимы бенчмарки, которые включают в себя более разнообразные и сложные сценарии, требующие от моделей не просто сопоставления данных, но и глубокого семантического понимания и способности к рассуждению.

Совместное встраивание для мультимодальных данных: контрастное обучение

Контрастное обучение представляет собой эффективный подход к выравниванию мультимодальных данных в рамках общего пространства вложений (Shared Embedding Space). Суть метода заключается в обучении модели таким образом, чтобы схожие элементы из разных модальностей (например, изображение и текст, описывающее его) располагались близко друг к другу в этом пространстве, а несхожие — далеко. Это достигается путем формирования пар положительных (соответствующих) и отрицательных (несоответствующих) примеров, и последующей оптимизацией функции потерь, минимизирующей расстояние между положительными парами и максимизирующей расстояние между отрицательными. В результате формируется общее представление данных, позволяющее сравнивать и сопоставлять информацию из различных источников.

Модели, такие как CLIP, SigLIP и ImageBind, демонстрируют эффективность подхода контрастного обучения путем предварительного обучения на масштабных наборах данных. CLIP, обученный на 400 миллионах пар «изображение-текст», демонстрирует способность к zero-shot классификации изображений и генерации текстовых описаний. SigLIP расширяет эту концепцию, включая маски сегментации изображений в процесс обучения, что улучшает понимание визуального контента. ImageBind идет дальше, объединяя данные из различных модальностей — изображения, текст, аудио и тепловизоры — в единое пространство встраиваний. Предварительное обучение на больших объемах данных позволяет этим моделям усваивать общие представления о мире и успешно решать задачи, связанные с пониманием и сопоставлением мультимодальной информации.

Для повышения дискриминационной способности моделей, обучающих общие представления для мультимодальных данных, применяются методы отбора сложных отрицательных примеров (Hard Negative Mining) и извлечения токенов встраиваний (Embedding Token extraction). Hard Negative Mining заключается в активном поиске и включении в процесс обучения наиболее сложных для различения отрицательных примеров, что заставляет модель более эффективно разделять различные модальности. Извлечение Embedding Token, напротив, позволяет выделить и использовать наиболее информативные части векторов встраиваний, улучшая качество представления данных и снижая влияние шума. Комбинация этих методов позволяет достичь более точного и надежного сопоставления между различными модальностями данных, повышая общую производительность модели.

Рассуждения как усилитель поиска: новый конвейер

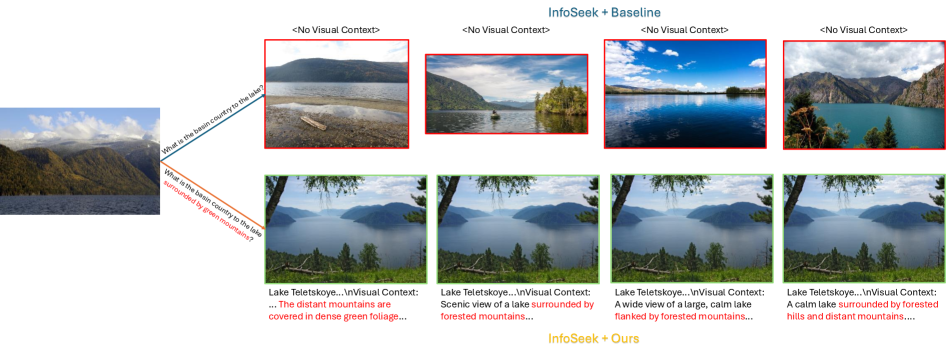

Конвейер “Обогащение с помощью рассуждений” использует мультимодальные большие языковые модели (MLLM) для разделения процессов рассуждений и сжатия данных. Традиционные методы часто объединяют эти этапы, что может привести к потере важной информации при кодировании запросов и документов. Разделение позволяет MLLM более эффективно анализировать и понимать семантическое содержание, генерируя более точные представления запросов и базы данных. Это, в свою очередь, обеспечивает значительное повышение точности поиска за счет улучшения соответствия между запросом и релевантными документами, поскольку модель способна учитывать более тонкие нюансы и контекст.

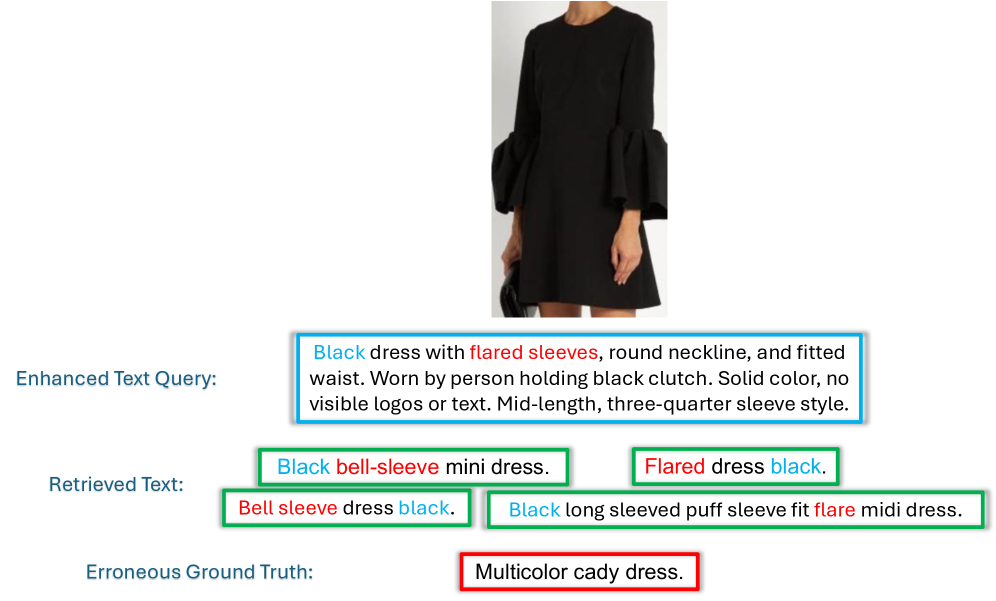

В рамках данного подхода используется улучшение запросов (Query Enhancement) для устранения неоднозначности в инструкциях пользователя и улучшение корпуса данных (Corpus Enhancement) посредством добавления плотных визуальных подписей (Dense Visual Caption). Улучшение запросов позволяет переформулировать нечеткие запросы в более точные, что повышает релевантность результатов поиска. Обогащение корпуса данных плотными визуальными подписями, описывающими содержимое визуальных данных, обеспечивает более детальное и семантически насыщенное представление информации, что способствует более эффективному сопоставлению запросов и данных в базе.

В рамках конвейера используется мультимодальная большая языковая модель, такая как Qwen3-VL-8B, для генерации плотных семантических представлений (Dense Semantic Form) входных данных. Данный подход заключается в преобразовании визуальной и текстовой информации в векторные представления высокой размерности, кодирующие семантическое значение. Использование плотных представлений позволяет проводить более эффективное сравнение схожести между запросами и элементами базы данных, поскольку вычисляется расстояние между соответствующими векторами. Более высокая семантическая точность этих представлений, генерируемых VLM, напрямую влияет на качество извлечения релевантной информации.

Валидация на разнообразных бенчмарках: подтверждение эффективности

Усовершенствованная система поиска демонстрирует высокие результаты на стандартных наборах данных, включающих `MSCOCO`, `InfoSeek`, `VisualNews`, `OVEN`, `EDIS` и `MVRB`. Эти наборы данных охватывают различные типы мультимодальных данных и задачи, что позволяет оценить общую эффективность системы в различных сценариях. Достигнутые показатели подтверждают способность системы эффективно извлекать релевантную информацию из комбинации текста и изображений, обеспечивая надежную производительность в широком спектре приложений.

Постоянное улучшение показателей на различных наборах данных, включая MSCOCO, InfoSeek, VisualNews, OVEN, EDIS и MVRB, свидетельствует о том, что разработанный метод мультимодального поиска обладает высокой обобщающей способностью. Это указывает на то, что предложенный подход не ограничен конкретными типами входных данных или решаемыми задачами, и может быть эффективно применен к широкому спектру мультимодальных запросов и данных, независимо от их специфических характеристик или модальности представления.

Результаты тестирования показали значительное улучшение точности поиска. На бенчмарке InfoSeek-8 предложенный метод достиг прироста в +2.84% метрики R@1, что свидетельствует о повышении способности системы находить наиболее релевантный результат среди всех возможных. Аналогичные улучшения были зафиксированы и на бенчмарке WebQA-1, где прирост метрики R@1 составил +1.59%. Данные показатели демонстрируют существенный прогресс в области мультимодального поиска и подтверждают эффективность предложенного подхода к повышению точности извлечения информации.

При интеграции с обучением на сложных негативных примерах (hard negative training) наблюдается увеличение метрики R@1 на 1.16% на наборе данных MSCOCO-0. Аналогично, при сравнении с базовыми методами, достигается прирост в 1.03% R@1 на наборе данных VisualNews-0. Данные результаты демонстрируют эффективность предложенного подхода в улучшении точности поиска изображений по текстовым запросам, особенно при использовании сложных негативных примеров для обучения модели.

К будущему бесшовного мультимодального доступа: видение

Сочетание контрастного обучения и усиления рассуждений открывает новую эру в развитии интеллектуальных информационных систем. Этот подход позволяет моделям не просто распознавать данные, но и понимать их взаимосвязи, извлекая более глубокий смысл из разнородной информации. Контрастное обучение, фокусируясь на выявлении различий между данными, помогает системе эффективно классифицировать и организовывать информацию. В то же время, добавление возможностей рассуждения позволяет модели делать логические выводы и устанавливать связи, которые не очевидны при простом анализе данных. Таким образом, формируется система, способная не только находить информацию, но и синтезировать новые знания, предоставляя пользователю более интуитивно понятные и полезные результаты. Данная синергия обещает значительный прогресс в создании поисковых систем, способных понимать намерения пользователя и предоставлять наиболее релевантную информацию независимо от ее формата или источника.

Дальнейшие исследования направлены на расширение масштаба этих моделей, используя значительно большие наборы данных, что позволит им усваивать более широкий спектр знаний и нюансов. Одновременно с этим, особое внимание уделяется внедрению более сложных возможностей логического вывода и рассуждений. Это включает в себя разработку алгоритмов, способных не просто находить информацию, но и анализировать её, выявлять взаимосвязи и делать обоснованные заключения. Успешная реализация этих направлений позволит создавать системы, способные к более глубокому пониманию запросов и предоставлению более релевантных и полезных ответов, приближая нас к созданию поисковых систем нового поколения.

В перспективе, конечной целью является создание поисковой системы, не знающей границ в отношении типов информации. Эта система должна беспрепятственно получать доступ и синтезировать данные из любой модальности — текста, изображений, аудио, видео и даже сенсорных данных. Представьте, что запрос может включать в себя не только ключевые слова, но и фрагмент мелодии, фотографию объекта или даже описание тактильных ощущений, и система способна точно определить и предоставить релевантную информацию. Такая универсальная поисковая система позволит пользователям взаимодействовать с информацией принципиально новым способом, преодолевая ограничения традиционных текстовых поисков и открывая доступ к неисчерпаемому объему знаний, представленных в различных форматах.

В статье описывается подход к универсальному мультимодальному поиску, где внешние шаги рассуждений используются для создания плотных семантических представлений. Звучит неплохо, но опыт подсказывает, что любое усложнение рано или поздно превратится в технический долг. Авторы фокусируются на data-centric AI и hard negative mining, что, безусловно, важно. Однако, даже самые изящные алгоритмы рано или поздно потребуют постоянной поддержки и адаптации к меняющимся данным. Как метко заметила Барбара Лисков: «Программы должны быть спроектированы так, чтобы изменения в одной части не влияли на другие». В идеале, конечно, но в реальности всё немного сложнее. Все эти «улучшенные» представления и «устойчивые» модели рано или поздно столкнутся с неожиданным запросом, который отправит их в ступор.

Что дальше?

Предложенный подход, безусловно, демонстрирует возможность внешнего представления рассуждений для улучшения мультимодального поиска. Однако, не стоит обольщаться. За каждой новой «универсальной» архитектурой неизбежно маячит армия граничных случаев, которые продукшен обязательно найдёт. Улучшение плотных семантических представлений — это хорошо, но реальный мир не состоит из аккуратно размеченных датасетов. Вместо того, чтобы гнаться за очередным SOTA, возможно, стоит задуматься о том, как сделать эти системы хоть немного более устойчивыми к шуму и неточностям, которыми изобилует реальность. А ещё, не забывайте, что мы не пишем код — мы просто оставляем комментарии будущим археологам, пытающимся понять, зачем вообще всё это было нужно.

Очевидным направлением развития является исследование методов автоматического обнаружения и фильтрации «сложных» примеров, которые приводят к ошибкам. В конце концов, если система стабильно падает на определённом типе запросов, значит, она хотя бы последовательна. Также, стоит обратить внимание на то, как эти «рассуждения», внешне представленные моделями «vision-language», действительно влияют на процесс поиска, и не являются ли они просто ещё одним слоем абстракции, усложняющим отладку. В конце концов, «data-centric AI» — это просто красивое название для старой доброй ручной работы с данными, только дороже.

Поиск универсальных решений — благородное дело, но история учит, что каждая «революционная» технология завтра станет техдолгом. Вероятно, будущее мультимодального поиска лежит не в создании всё более сложных архитектур, а в разработке более эффективных инструментов для работы с данными и отладки систем. Иначе, мы просто создаём всё более изощрённые способы генерировать ошибки.

Оригинал статьи: https://arxiv.org/pdf/2602.07125.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовая суперпозиция: новая интерпретация вероятности

- Ускорение генеративных моделей: новый подход к вычислению матричной экспоненты

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Эффективный параллелизм: iCIPT2 на службе квантифицируемой химии

- Ускорение вычислений: Монте-Карло и линейные системы

- Квантовый скачок: от лаборатории к рынку

- Тензорные сети и комбинаторные поиски: новый подход к сложным задачам

- Квантовая геометрия управления: плавные траектории в пространстве состояний

2026-02-11 02:18