Автор: Денис Аветисян

Новый подход объединяет возможности генеративных ИИ-агентов и экспертные оценки для более полного выявления и оценки потенциальных угроз, связанных с развитием искусственного интеллекта.

Исследование демонстрирует, что комбинирование ИИ-агентов и экспертов в структурированном процессе прогнозирования расширяет возможности оценки системных рисков, связанных с новыми приложениями ИИ.

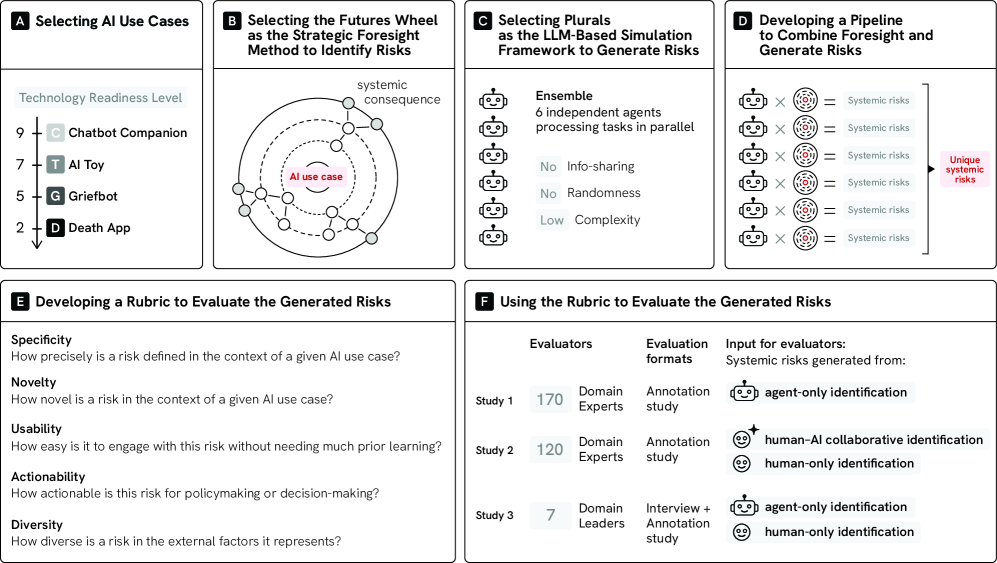

Оценка долгосрочных системных рисков искусственного интеллекта осложняется когнитивными ограничениями человеческой экспертизы при прогнозировании отдаленных последствий. В работе ‘Agent-Supported Foresight for AI Systemic Risks: AI Agents for Breadth, Experts for Judgment’ предложен масштабируемый подход, сочетающий симуляцию агентов на основе метода «Колесо будущего» и экспертную оценку для выявления рисков, связанных с применением ИИ на разных стадиях зрелости. Полученные результаты демонстрируют, что комбинация генеративных агентов и человеческой экспертизы позволяет расширить охват системных рисков и повысить качество оценки. Возможно ли создание гибридных систем прогнозирования, которые будут эффективно использовать сильные стороны как искусственного, так и человеческого интеллекта для обеспечения безопасного развития технологий ИИ?

Системные риски ИИ: Горизонты расширяются

Всё чаще системы искусственного интеллекта внедряются в сложные общественные системы, создавая непредсказуемые системные риски. Это означает, что ИИ перестаёт быть изолированным инструментом и становится неотъемлемой частью критической инфраструктуры, включая финансовые рынки, системы здравоохранения, транспорт и даже социальные взаимодействия. Взаимосвязанность этих систем усиливает эффект домино: локальная неисправность или ошибка в одной области может быстро распространиться по всей сети, приводя к каскадным сбоям и масштабным последствиям, которые трудно предвидеть традиционными методами оценки рисков. Появление алгоритмических предубеждений, уязвимости в безопасности и неожиданное взаимодействие между различными ИИ-системами — всё это факторы, которые могут спровоцировать подобные кризисные ситуации, требующие особого внимания и разработки новых подходов к управлению рисками.

Традиционные методы оценки рисков, разработанные для изолированных систем, оказываются неэффективными при анализе взаимосвязанных искусственных интеллектов. Они, как правило, концентрируются на вероятности отказа отдельных компонентов, упуская из виду возможность каскадных сбоев, когда одна незначительная неисправность приводит к цепной реакции, охватывающей всю систему. Сложность современных ИИ-систем, встроенных в критическую инфраструктуру, такова, что даже тщательный анализ каждого отдельного модуля не позволяет предвидеть все возможные сценарии взаимодействия и потенциальные точки отказа. Поэтому необходим принципиально новый подход к оценке рисков, учитывающий не только вероятность отказа, но и скорость и масштаб распространения сбоев в сложной, динамичной среде, где последствия могут быть непредсказуемыми и разрушительными.

Появление искусственного интеллекта в роли компаньонов и систем поддержки, охватывающих широкий спектр применений — от простых чат-ботов до приложений, предназначенных для сопровождения в конце жизни, — значительно увеличивает масштаб потенциального воздействия на общество. В отличие от традиционных технологий, которые обычно решают конкретные задачи, эти системы интегрируются в самые личные и чувствительные сферы человеческой жизни. Массовое распространение таких AI-помощников создает уникальные риски, связанные с эмоциональной зависимостью, утечкой личных данных и, что особенно важно, возможностью синхронных сбоев или манипуляций, которые могут затронуть миллионы людей одновременно. Поскольку доверие к этим системам растет, а их роль в повседневной жизни становится все более значимой, последствия даже незначительных ошибок или уязвимостей могут оказаться катастрофическими, выходя далеко за рамки индивидуальных неудобств и затрагивая функционирование целых социальных групп.

Понимание и заблаговременное решение проблем, связанных с системными рисками, является фундаментальным требованием для ответственной разработки и внедрения искусственного интеллекта. Недостаточно просто создавать эффективные алгоритмы; необходимо учитывать потенциальные последствия их интеграции в сложные социальные системы. Исследования показывают, что кажущиеся незначительными сбои в одной части сети ИИ могут спровоцировать каскадные отказы, затрагивающие критически важные инфраструктуры и сферы жизни. Поэтому, приоритетным направлением становится разработка методов оценки и смягчения этих рисков, включая создание систем мониторинга, механизмов резервирования и принципов проектирования, обеспечивающих устойчивость и отказоустойчивость ИИ-систем. Только таким образом можно обеспечить, чтобы развитие искусственного интеллекта служило на благо общества, а не представляло угрозу для его стабильности и безопасности.

ИИ-прогнозирование: Моделирование будущих каскадов

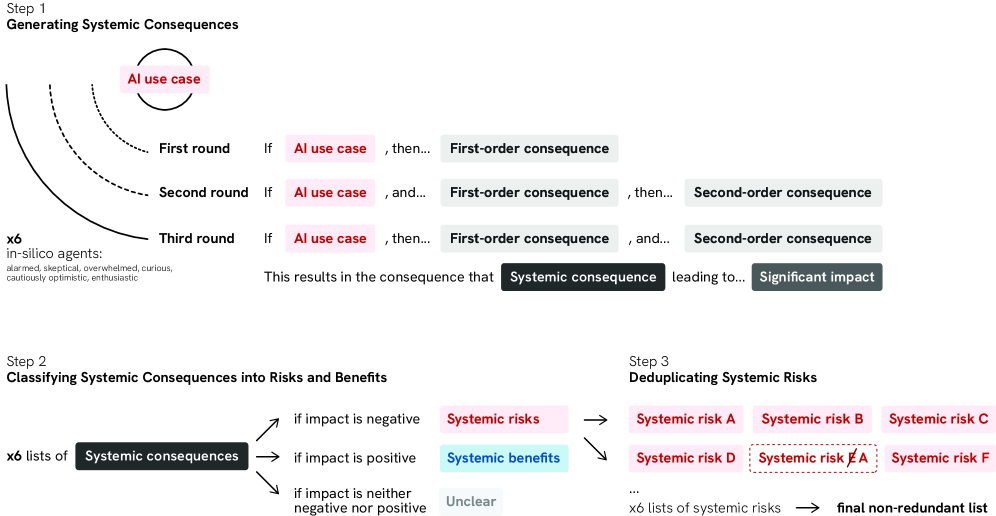

Использование искусственного интеллекта, в частности, так называемых “In-silico агентов”, предоставляет эффективный инструмент для моделирования сложных взаимодействий и выявления скрытых системных рисков. Данные агенты, функционирующие как программные симуляции, способны анализировать большое количество переменных и их взаимосвязей, что позволяет выявить закономерности и потенциальные каскадные эффекты, которые сложно обнаружить при традиционных методах анализа. В отличие от человеческой оценки рисков, основанной на ограниченном опыте и когнитивных искажениях, In-silico агенты обеспечивают более объективный и всесторонний анализ, позволяя прогнозировать возможные последствия различных событий и сценариев с повышенной точностью. Это особенно важно для оценки рисков в сложных системах, таких как финансовые рынки, цепочки поставок или инфраструктура критической важности, где взаимодействие множества факторов может привести к непредсказуемым последствиям.

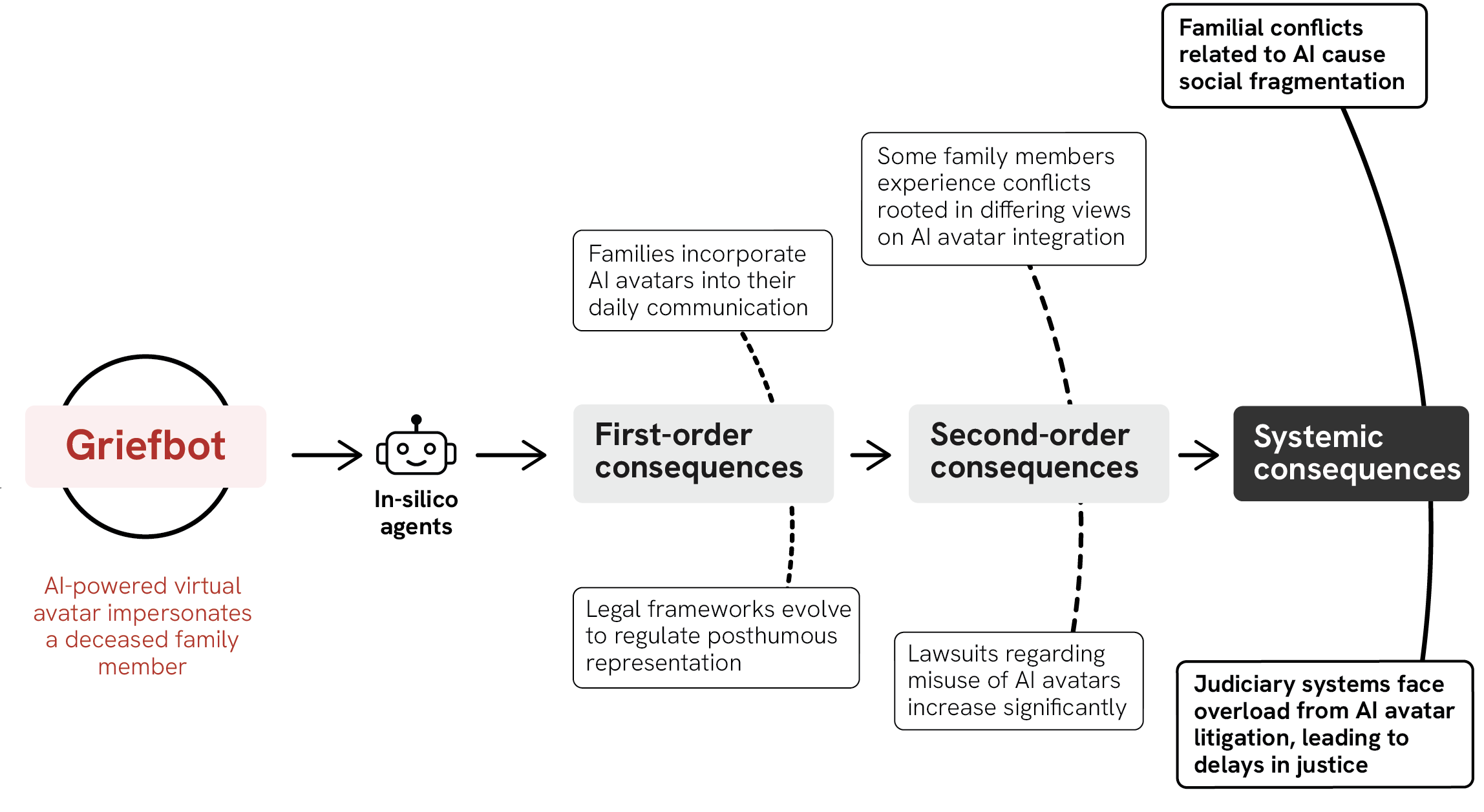

Метод “Колесо Будущего” в сочетании с агентами искусственного интеллекта позволяет систематически выявлять каскадные последствия и эффекты второго порядка. Этот подход предполагает разветвленную структуру анализа, где исходное событие или тренд рассматривается как центр, а потенциальные последствия, возникающие в результате этого события, исследуются на нескольких уровнях. Агенты ИИ автоматизируют процесс генерации и оценки этих последствий, учитывая различные факторы и взаимосвязи, которые могут быть упущены при традиционном анализе. Это позволяет не только предвидеть непосредственные результаты, но и проследить за долгосрочными и опосредованными эффектами, формируя более полную картину потенциальных рисков и возможностей.

Фреймворк “Plurals” обеспечивает генерацию разнообразных точек зрения в процессе моделирования рисков, предотвращая возникновение узких или предвзятых оценок. Он работает путем создания множества “агентов”, каждый из которых представляет собой уникальную перспективу, основанную на различных наборах предположений и приоритетов. Это позволяет систематически исследовать потенциальные риски с разных углов зрения, учитывая широкий спектр факторов и сценариев, которые могли бы быть упущены при использовании традиционных методов, основанных на ограниченном количестве экспертных мнений. Использование “Plurals” помогает преодолеть когнитивные искажения и обеспечить более полное и объективное выявление системных рисков.

Традиционный анализ рисков, ориентированный на изучение прошлых событий, уступает место проактивному моделированию потенциальных будущих сценариев. Использование AI-агентов для симуляции каскадных эффектов позволяет выявлять от 27 до 47 уникальных системных рисков, в то время как исключительно человеческая генерация идей обычно определяет лишь 7-20. Такой количественный сдвиг обусловлен способностью AI учитывать большее количество взаимосвязей и нелинейных последствий, обеспечивая более полное и перспективное понимание потенциальных угроз.

Контекстуализация рисков: За пределами технического анализа

Понимание системного риска требует комплексного анализа, включающего политические, экономические, социальные, технологические, экологические и правовые факторы — совокупность этих факторов описывается методом PESTEL-анализа. Данный подход позволяет выявить риски, возникающие не только из внутренних процессов организации, но и из внешних макроэкономических и социальных изменений. Анализ политической стабильности, экономических циклов, социальных трендов, технологических инноваций, экологических ограничений и правового регулирования позволяет оценить потенциальное влияние этих факторов на стабильность системы и выявить взаимосвязи между ними. Использование PESTEL-анализа является важным этапом в процессе управления рисками, поскольку позволяет сформировать более полное представление о потенциальных угрозах и разработать эффективные стратегии их mitigation.

Для отслеживания динамики рисков и выявления возникающих закономерностей критически важен лонгитюдный анализ. Данный метод предполагает сбор и анализ данных о рисках в течение продолжительного периода времени, позволяя не только фиксировать изменения в вероятности и серьезности угроз, но и обнаруживать новые, ранее не идентифицированные риски. Использование лонгитюдного анализа позволяет перейти от реактивного управления рисками к проактивному, основанному на прогнозировании и предотвращении потенциальных проблем. В частности, анализ временных рядов данных о рисках позволяет выявить тренды, сезонность и другие закономерности, которые могут указывать на возрастающую или убывающую вероятность определенных событий.

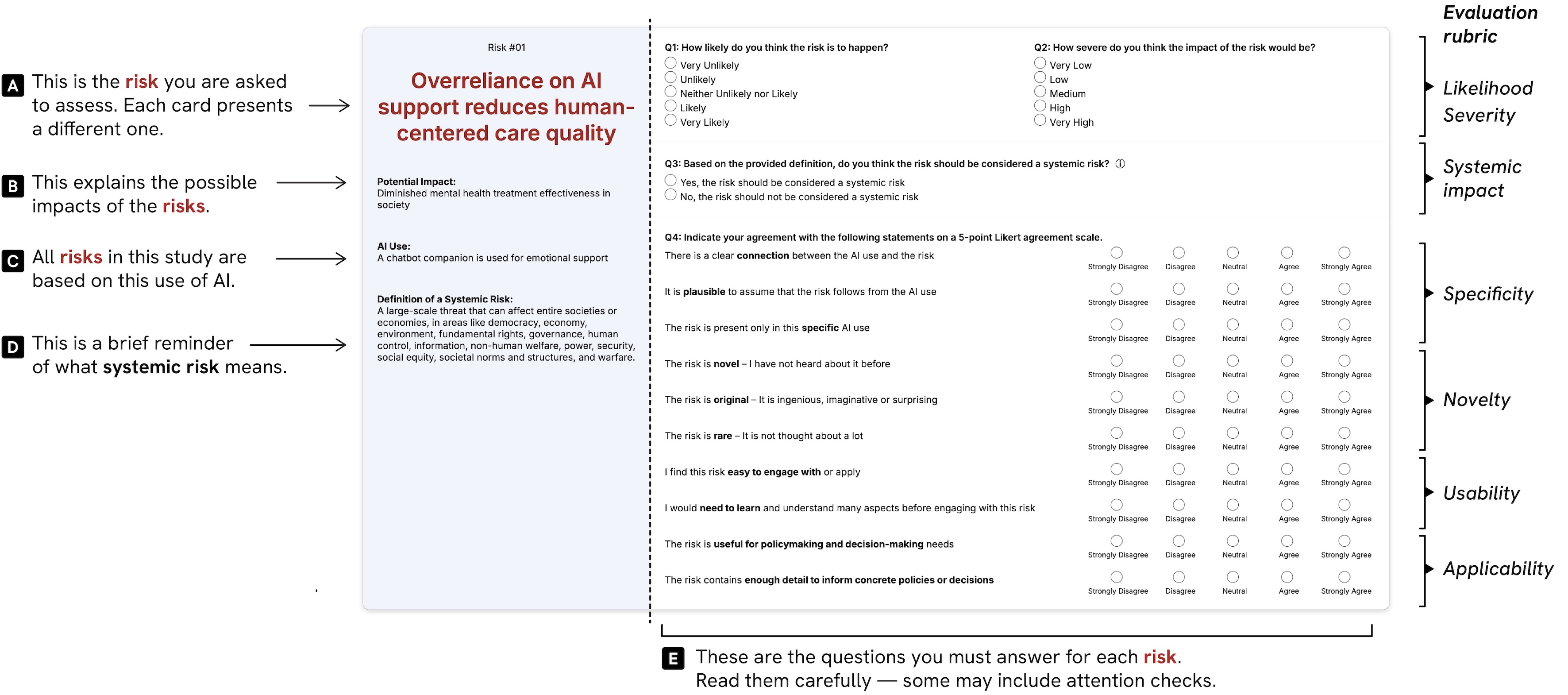

Для валидации выявленных рисков используется структурированная «Рубрика оценки рисков», позволяющая оценить вероятность возникновения, степень тяжести последствий и системное воздействие. Данная рубрика предоставляет четкие критерии для каждой категории, что обеспечивает последовательный и объективный анализ. Оценка производится по заранее определенным шкалам, что позволяет количественно определить уровень риска и сравнить различные риски между собой. Результаты оценки, полученные с использованием рубрики, служат основой для разработки стратегий управления рисками и принятия обоснованных решений.

Экспертная оценка, проведенная с использованием рисков, сгенерированных агентами, показала, что 75% из них были классифицированы как системные, что свидетельствует о высокой степени их правдоподобности и актуальности. Средние баллы, выставленные экспертами по шкале Ликерта в 5 пунктов, варьировались от 3.57 до 3.84, оценивая как вероятность возникновения, так и потенциальную серьезность последствий этих рисков. Данный диапазон указывает на то, что эксперты считают эти риски достаточно вероятными и способными оказать значительное влияние на систему.

Ответственный ИИ: Регулирование и алгоритмическое разнообразие

Законодательный акт Европейского союза об искусственном интеллекте (AI Act) представляет собой важный шаг в направлении проактивного выявления и смягчения потенциальных рисков, связанных с разработкой и внедрением систем искусственного интеллекта. Этот акт не просто устанавливает правила игры, но и создает основу для оценки и классификации AI-систем в зависимости от уровня риска, который они представляют для общества. Особое внимание уделяется системам, которые могут оказывать существенное влияние на жизнь людей, например, в сферах здравоохранения, занятости или правосудия. Законодательство стремится обеспечить прозрачность алгоритмов, подотчетность разработчиков и защиту основных прав и свобод граждан, формируя тем самым правовое поле для ответственного развития и применения технологий искусственного интеллекта в Европе и за ее пределами.

Несмотря на важность нормативного регулирования в сфере искусственного интеллекта, одного лишь этого недостаточно для обеспечения безопасности и справедливости. Концепция “Алгоритмического плюрализма” подчеркивает необходимость использования разнообразных моделей ИИ при решении задач. Такой подход позволяет снизить предвзятость, свойственную отдельным алгоритмам, и обеспечить более полное покрытие потенциальных рисков. Различные модели, обученные на разных данных и использующие различные методы, способны выявлять уязвимости и неточности, которые могут быть упущены при использовании единственного алгоритма. В результате, применение множества ИИ-систем повышает надежность и устойчивость решений, а также способствует более справедливому и всестороннему анализу данных.

Гибридный подход к прогнозированию рисков, сочетающий возможности искусственного интеллекта и экспертную оценку, демонстрирует повышенную эффективность в выявлении потенциальных угроз. Данная методология позволяет не только автоматизировать процесс анализа больших объемов данных, но и использовать критическое мышление специалистов для верификации и интерпретации результатов, полученных ИИ. Такое сочетание обеспечивает более полную и точную картину возможных рисков, поскольку ИИ способен выявлять неочевидные закономерности, а эксперты — учитывать контекст и нюансы, которые могут быть упущены алгоритмами. В результате, гибридный подход позволяет значительно повысить надежность и обоснованность принимаемых решений в области искусственного интеллекта.

Исследования показали, что автоматизированные системы выявления рисков демонстрируют заметную способность к генерации новых, ранее не выявленных опасностей. Оценка, проведенная по пятибалльной шкале, зафиксировала средние значения в диапазоне от 2.99 до 3.24, что свидетельствует о способности искусственного интеллекта обнаруживать риски, которые остаются незамеченными при традиционном человеческом анализе. Данный результат подчеркивает потенциал ИИ не только в автоматизации процесса оценки рисков, но и в значительном расширении его охвата, позволяя выявлять скрытые угрозы и повышая общую безопасность систем искусственного интеллекта.

Исследование, представленное в статье, демонстрирует, что расширение горизонтов предвидения рисков, связанных с новыми применениями искусственного интеллекта, требует не просто инструментов, но и сложной экосистемы взаимодействия. Авторы подчеркивают важность сочетания возможностей генеративных агентов ИИ с экспертными оценками. Это напоминает о словах Тим Бернерс-Ли: «Данные должны быть свободны». Подобно тому, как свободный доступ к информации расширяет возможности, так и свободный обмен знаниями между ИИ и человеком открывает новые перспективы для выявления системных рисков, позволяя перейти от реактивного управления к проактивному предвидению. Идеальной архитектуры для этого не существует, но стремление к ней помогает не потерять ориентацию в быстро меняющемся мире.

Что же дальше?

Представленная работа лишь слегка отодвигает завесу над неизбежным. Автоматизированные инструменты прогнозирования, использующие генеративные модели, не устраняют системные риски, а лишь расширяют горизонт их выявления. Важно помнить: архитектура — это не структура, а компромисс, застывший во времени. Каждый выбор в пользу автоматизации — это пророчество о будущем сбое, который, несомненно, произойдет. Иллюзия контроля над сложными системами всегда обманчива.

Следующий этап исследований, вероятно, потребует смещения фокуса с простого выявления рисков на понимание их динамики и взаимосвязей. Технологии сменяются, зависимости остаются. Усилия, направленные на создание более сложных агентских систем, могут оказаться бесплодными, если не будет разработан адекватный язык для описания и моделирования этих самых зависимостей. Попытки создать «всезнающего» агента обречены на неудачу; гораздо важнее научиться эффективно агрегировать и интерпретировать знания, полученные из разнородных источников.

В конечном счете, вопрос не в том, как предсказать будущее, а в том, как подготовиться к его непредсказуемости. Системы — это не инструменты, а экосистемы. Их нельзя построить, только взрастить. И, как в любом живом организме, в них всегда будут присутствовать скрытые уязвимости и непредсказуемые последствия.

Оригинал статьи: https://arxiv.org/pdf/2602.08565.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовая суперпозиция: новая интерпретация вероятности

- Ускорение генеративных моделей: новый подход к вычислению матричной экспоненты

- Квантовая геометрия управления: плавные траектории в пространстве состояний

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Эффективный параллелизм: iCIPT2 на службе квантифицируемой химии

- Ускорение вычислений: Монте-Карло и линейные системы

- Квантовый скачок: от лаборатории к рынку

- Тензорные сети и комбинаторные поиски: новый подход к сложным задачам

2026-02-11 05:45