Автор: Денис Аветисян

Исследователи предлагают статистически обоснованный метод Dual-Delta Testing для оценки точности вычислений в системах с различной разрядностью.

Представлен Dual-Delta Testing — методология для валидации числовой точности смешанных вычислений путём сравнения распределений ошибок с высокоточным эталоном.

Несмотря на растущую популярность вычислений пониженной точности для повышения производительности, верификация их числовой точности представляет собой сложную задачу. В работе, посвященной ‘Evaluating Numerical Accuracy in Mixed-Precision Computing by Dual-Delta Testing’, предложен систематический подход к оценке ошибок в смешанном представлении данных. В основе метода лежит сравнение распределений ошибок пользовательской реализации и базового эталона с высокоточным оракулом, что позволяет более строго определить природу возникающих погрешностей. Позволит ли Dual-Delta Testing стать стандартом де-факто в области валидации численной устойчивости алгоритмов, использующих FP16 или BF16?

Точность вычислений: узкое место современной вычислительной техники

Современные численные вычисления всё чаще опираются на форматы высокой точности, такие как FP64, обеспечивающие надежность и стабильность результатов. Однако, эта точность достигается ценой значительных вычислительных затрат и повышенного потребления памяти. Каждая операция с числами FP64 требует больше тактов процессора и больше места для хранения, что становится критичным в задачах, требующих обработки огромных объемов данных, например, в машинном обучении или научных симуляциях. Таким образом, хотя высокая точность и является желательной, её поддержание становится всё более сложной и дорогостоящей задачей, стимулируя поиск компромиссных решений и альтернативных подходов к представлению чисел.

Современные вычислительные задачи требуют всё большей скорости обработки и меньшего потребления памяти. В связи с этим, исследователи активно изучают возможность использования форматов пониженной точности, таких как FP16 и BF16, в качестве альтернативы традиционным FP64. Переход к этим форматам позволяет значительно сократить объём используемой памяти и увеличить скорость вычислений, поскольку требует меньше операций для представления и обработки данных. Однако, снижение точности неизбежно влечёт за собой потенциальную потерю информации и увеличение вычислительных ошибок, что требует разработки специальных методов валидации и компенсации этих ошибок для обеспечения надёжности и достоверности результатов вычислений. Использование FP16 и BF16 становится особенно актуальным в областях, где требуется обработка больших объёмов данных, например, в задачах машинного обучения и глубокого обучения.

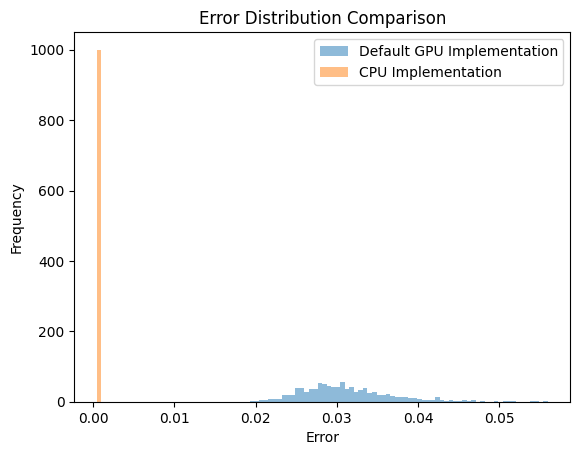

Переход к вычислениям пониженной точности, несмотря на свою привлекательность в плане производительности и экономии памяти, сопряжен с существенным риском накопления ошибок. Первичные результаты тестирования показали, что при выполнении умножения матриц размером 128×4096 на графических процессорах (GPU) средняя ошибка составляет 3.106403e-2. Этот показатель в 65 раз превышает эталонную точность, достигнутую при аналогичных вычислениях на центральных процессорах (CPU), где средняя ошибка составляет всего 4.768127e-4. Подобная разница подчеркивает необходимость разработки надежных методов валидации и контроля ошибок при использовании вычислений пониженной точности, чтобы обеспечить достоверность результатов и избежать непредсказуемых сбоев в работе сложных вычислительных систем.

Валидация пониженной точности: обеспечение численной корректности

Тестирование с единичным дельта-сравнением (Single-Delta Testing) представляет собой базовый подход к валидации, заключающийся в сравнении результатов работы новой реализации с результатами эталонной (reference) реализации. Ключевым элементом данного метода является четко определенная метрика ошибки (Error Metric), используемая для количественной оценки расхождений между двумя реализациями. Выбор метрики критически важен, поскольку именно она определяет, какие типы числовых неточностей будут обнаружены. Результаты тестирования интерпретируются на основе заданного порога для метрики ошибки; превышение этого порога указывает на потенциальную проблему в новой реализации. Эффективность Single-Delta Testing напрямую зависит от качества и надежности эталонной реализации, а также от адекватности выбранной метрики для конкретной задачи.

Двойное дельта-тестирование (Dual-Delta Testing) повышает надежность валидации сниженной точности за счет сравнения результатов с высокоточным оракулом. В отличие от простого сравнения с референсной реализацией, использование оракула, основанного на вычислениях с повышенной точностью, обеспечивает более достоверную базовую линию для оценки ошибок. Данный метод продемонстрировал свою эффективность в обнаружении и устранении тонких числовых проблем, возникающих при операциях матричного умножения, где даже незначительные отклонения могут накапливаться и приводить к значительным расхождениям в результатах. Это позволяет выявлять ошибки, которые могли бы остаться незамеченными при использовании менее надежных методов валидации.

Статистические тесты, такие как тест Колмогорова-Смирнова и тест Вилкоксона со знаком рангов, являются ключевыми инструментами для оценки статистической значимости наблюдаемых расхождений при валидации численных алгоритмов. Тест Колмогорова-Смирнова позволяет определить, соответствуют ли два набора данных одному и тому же распределению, выявляя существенные различия в их эмпирических функциях распределения. В свою очередь, тест Вилкоксона со знаком рангов применяется для оценки симметричности распределения разностей между парными наблюдениями, что позволяет установить, являются ли наблюдаемые отклонения результатом случайных колебаний или систематической ошибки. Применение этих тестов требует формирования нулевой гипотезы (например, об отсутствии различий между результатами алгоритма и эталонной реализацией) и вычисления p-value, который определяет вероятность получения наблюдаемых результатов при условии истинности нулевой гипотезы. Если p-value ниже выбранного уровня значимости (обычно 0.05), нулевая гипотеза отвергается, что свидетельствует о статистической значимости наблюдаемых расхождений.

Эффективность статистических тестов, таких как тест Колмогорова-Смирнова и тест Вилкоксона, напрямую зависит от правильно выбранной метрики ошибки. Данная метрика должна адекватно отражать релевантные числовые расхождения, возникающие при использовании пониженной точности вычислений. Некорректно подобранная метрика может привести к ложноположительным или ложноотрицательным результатам, скрывая реальные ошибки или, наоборот, сигнализируя о незначительных отклонениях как о критических. Важно, чтобы метрика учитывала специфику задачи и тип числовых данных, например, относительные или абсолютные ошибки, а также чувствительность к различным видам погрешностей. Выбор метрики должен основываться на глубоком понимании особенностей алгоритма и ожидаемых числовых характеристик результатов вычислений.

Смягчение ошибок с помощью оптимизированной арифметики

Смешанная точность вычислений — это стратегия, при которой используются форматы пониженной точности, такие как FP16 и BF16, там, где это допустимо, с сохранением высокой точности для критически важных операций. Этот подход позволяет снизить требования к памяти и вычислительной мощности, ускоряя выполнение операций, не внося при этом существенных ошибок в результат. Выбор операций, для которых допустимо использование пониженной точности, осуществляется на основе анализа чувствительности к ошибкам и требований к точности конечного результата. Например, операции накопления и активации часто могут выполняться в FP16 или BF16, в то время как операции, влияющие на стабильность обучения или точность вычислений, требующих высокой точности, остаются в FP32 или FP64.

Методики снижения точности при суммировании (Reduced-Precision Reduction) оптимизируют операцию матричного умножения за счет накопления промежуточных результатов в форматах пониженной точности. Это позволяет значительно повысить производительность вычислений, поскольку операции с данными пониженной точности требуют меньше вычислительных ресурсов и пропускной способности памяти. Ключевым аспектом является минимизация влияния ошибок округления, возникающих при использовании пониженной точности, за счет тщательного анализа и контроля накопительной ошибки. Применение этих техник позволяет достичь сопоставимой с вычислениями в полной точности производительности, избегая при этом значительного увеличения погрешности результата.

Эффективность методов оптимизации арифметических операций, таких как использование пониженной точности, напрямую зависит от выбора подходящей метрики оценки ошибки. Традиционные метрики могут быть неэффективны при работе со значениями, близкими к нулю, что приводит к завышенной оценке погрешности. Для решения этой проблемы часто используется метрика Maximum Hybrid Error (MHE), которая учитывает как абсолютную, так и относительную ошибку, позволяя корректно оценивать погрешность даже вблизи нулевых значений. Применение MHE обеспечивает более точную оценку и позволяет контролировать допустимый уровень погрешности при использовании пониженной точности, что критически важно для поддержания стабильности и точности вычислений.

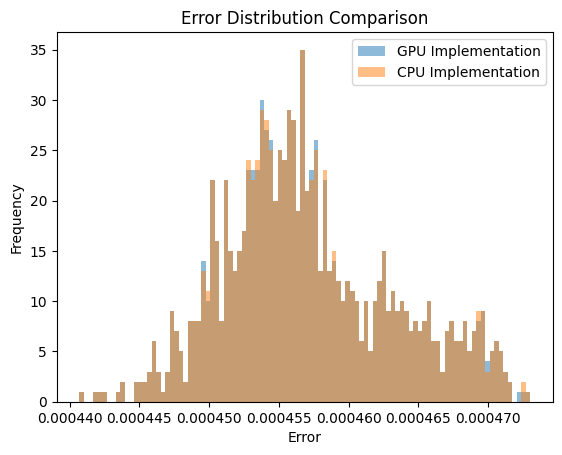

Результаты тестирования умножения матриц размером 128×128 показали практически идентичные средние значения ошибок при реализации на GPU и CPU. Данное совпадение указывает на эквивалентность алгоритмов с точки зрения точности вычислений в рассматриваемом сценарии. Это подтверждает возможность использования оптимизированных арифметических методов, таких как смешанная точность, без значительной потери точности при выполнении операций матричного умножения на различных аппаратных платформах. Наблюдаемая незначительная разница в значениях ошибок находится в пределах допустимой погрешности и не влияет на общую корректность результатов.

Аппаратное ускорение и будущее численных вычислений

Специализированные аппаратные средства, такие как Tensor Cores и Tensor Processing Units (TPU), представляют собой значительный прорыв в области ускорения вычислений. Эти процессоры намеренно спроектированы для эффективной обработки операций с пониженной точностью, что позволяет добиться существенного прироста производительности по сравнению с традиционными центральными и графическими процессорами. Вместо использования стандартной 32-битной или 64-битной точности, Tensor Cores и TPU способны выполнять вычисления с использованием 16-битных или даже 8-битных чисел, что значительно снижает требования к пропускной способности памяти и энергопотреблению. Такой подход особенно эффективен в задачах машинного обучения и глубокого обучения, где снижение точности часто не приводит к заметной потере качества, но позволяет ускорить обучение и вывод моделей в разы. Более того, эта тенденция открывает новые возможности для решения сложных научных задач, требующих интенсивных вычислений, делая их более доступными и экономичными.

Ускорители, такие как Tensor Cores и TPUs, демонстрируют значительное снижение вычислительных затрат и энергопотребления за счет эффективного выполнения матричных умножений в пониженной точности. Вместо традиционных 32-битных операций с плавающей точкой, эти устройства оптимизированы для работы с 16- или даже 8-битными представлениями чисел. Это позволяет увеличить пропускную способность и сократить объем необходимой памяти, поскольку для хранения и обработки меньшего количества бит требуется меньше ресурсов. Подобный подход особенно выгоден в задачах глубокого обучения и научных вычислений, где матричные операции являются основой большинства алгоритмов, и незначительная потеря точности часто допустима в обмен на существенное увеличение производительности и снижение энергозатрат. A \times B = C — даже в пониженной точности, подобные операции выполняются значительно быстрее, открывая новые возможности для масштабных вычислений.

Сочетание оптимизированных арифметических методов и специализированного аппаратного обеспечения становится движущей силой инноваций в таких областях, как глубокое обучение и научные вычисления. Разработка специализированных процессоров, таких как тензорные ядра и TPU, позволяет значительно ускорить выполнение операций с матрицами, критически важных для современных алгоритмов. Ax = b — решение подобных систем уравнений, ранее требовавшее значительных вычислительных ресурсов, теперь становится возможным в реальном времени. Это, в свою очередь, открывает новые перспективы для моделирования сложных физических процессов, анализа больших объемов данных и создания более интеллектуальных систем искусственного интеллекта. Повышенная эффективность вычислений также способствует снижению энергопотребления, что делает подобные решения более устойчивыми и экономичными.

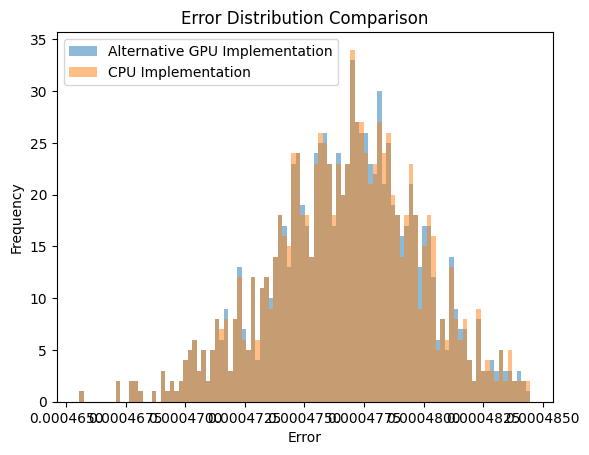

Исследования показали, что при отключении оптимизации вычислений с пониженной точностью на графических процессорах (GPU), средняя ошибка при умножении матриц размером 128×4096 становится сопоставимой с результатами, полученными на центральных процессорах (CPU). Этот результат указывает на то, что преимущество GPU в скорости вычислений, которое обычно достигается за счет использования операций с пониженной точностью, нивелируется, когда требуется высокая точность. Восстановление паритета точности между GPU и CPU при отключении оптимизации имеет важное значение для приложений, где критична абсолютная точность результатов, например, в научных расчетах и моделировании, и позволяет более осознанно выбирать платформу для конкретной вычислительной задачи.

Исследование, представленное в статье, акцентирует внимание на статистической строгости валидации численной точности в смешанных вычислениях. Предложенный метод Dual-Delta Testing, сравнивая распределения ошибок с высокоточным оракулом, позволяет выявить даже незначительные отклонения, что особенно важно при переходе к низкоточным форматам, таким как FP16/BF16. Этот подход, стремящийся к воспроизводимости и объяснимости результатов, находит отклик в словах Джеймса Максвелла: «Наука — это не просто накопление фактов, а поиск закономерностей». Если закономерность нельзя воспроизвести или объяснить, её не существует. Статья демонстрирует, что надёжность численных вычислений напрямую зависит от возможности подтвердить воспроизводимость и объяснить наблюдаемые распределения ошибок, что делает Dual-Delta Testing ценным инструментом для разработчиков и исследователей.

Что дальше?

Представленный подход к двойному дельта-тестированию, несомненно, представляет собой шаг вперёд в оценке численной устойчивости вычислений пониженной точности. Однако, стоит признать, что сама постановка вопроса о «точности» в мире конечной машинной арифметики — это всегда некоторая условность. Неизбежно возникает вопрос: насколько «достаточно точным» должно быть приближение, и как это соотносится с реальными задачами, где результат используется? Проверка на соответствие «золотому стандарту», реализованному в виде высокоточной арифметики, — лишь один из возможных критериев.

Будущие исследования, вероятно, будут сосредоточены на разработке метрик, более тесно связанных с функциональным поведением алгоритмов, а не только с абсолютной величиной ошибки. Особенно интересным представляется вопрос о влиянии ошибок округления на устойчивость и сходимость итерационных процессов. Важно понимать, что распределение ошибок в вычислениях пониженной точности может существенно отличаться от гауссовского, и это необходимо учитывать при статистической валидации.

Не стоит забывать и о практической стороне вопроса. Хотя двойное дельта-тестирование и позволяет выявить потенциальные проблемы, его применение к сложным, многокомпонентным системам может потребовать значительных вычислительных ресурсов. Поэтому, актуальной задачей представляется разработка эффективных методов автоматизации и оптимизации процесса тестирования, а также поиск компромисса между строгостью проверки и затратами на её проведение.

Оригинал статьи: https://arxiv.org/pdf/2602.10605.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовая суперпозиция: новая интерпретация вероятности

- Ускорение генеративных моделей: новый подход к вычислению матричной экспоненты

- Квантовый скачок: от лаборатории к рынку

- Эффективный параллелизм: iCIPT2 на службе квантифицируемой химии

- Ускорение вычислений: Монте-Карло и линейные системы

- Тензорные сети и комбинаторные поиски: новый подход к сложным задачам

- Квантовая геометрия управления: плавные траектории в пространстве состояний

2026-02-12 22:20