Автор: Денис Аветисян

Новое исследование показывает, как участие ИИ в экспертных системах влияет на уровень доверия к советам, особенно когда возникают ошибки.

Исследование посвящено влиянию автоматической и инициированной человеком коррекции ошибок в системах поддержки принятия решений на доверие к ИИ и экспертам.

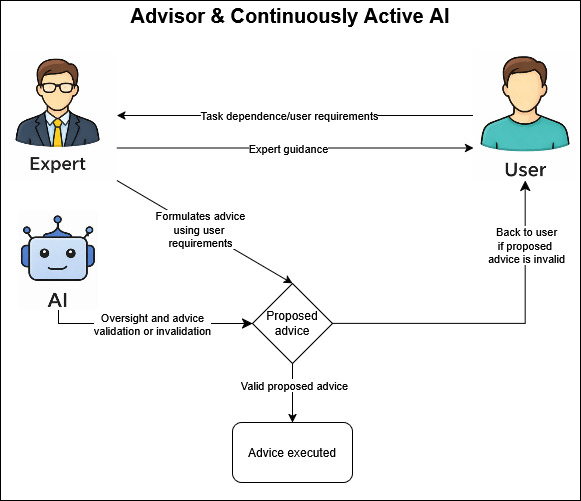

Несмотря на растущую интеграцию искусственного интеллекта в экспертные системы, вопрос о влиянии этого взаимодействия на доверие пользователей остается недостаточно изученным. В исследовании, посвященном ‘Implications of AI Involvement for Trust in Expert Advisory Workflows Under Epistemic Dependence’, рассматривается, как участие ИИ влияет на доверие к эксперту, самой системе ИИ и их совместной работе. Полученные результаты, основанные на эксперименте с \mathcal{N}=77 участниками, показывают, что восприятие экспертности и доверия формируется не только правильностью рекомендаций, но и способом коррекции ошибок — в частности, инициирована ли она экспертом или автоматизирована. Какие принципы проектирования гибридных человеко-ИИ команд позволят максимизировать доверие пользователей и эффективность принимаемых решений?

Доверие в эпоху искусственного интеллекта: Основа эффективного взаимодействия

Эффективное взаимодействие человека и искусственного интеллекта напрямую зависит от формирования адекватного уровня доверия между пользователем и системой. Недостаточное доверие может приводить к игнорированию полезных рекомендаций ИИ, тормозя процесс принятия решений и снижая общую продуктивность. Однако, чрезмерное доверие, особенно в критически важных областях, несёт в себе риски, поскольку пользователь может слепо полагаться на решения системы, не подвергая их критическому анализу. Поэтому, задача состоит не в том, чтобы добиться абсолютного доверия, а в создании баланса, при котором человек осознаёт возможности и ограничения ИИ, используя его как инструмент для расширения собственных способностей, а не как замену критическому мышлению. Установление этого баланса требует от разработчиков систем ИИ прозрачности в работе алгоритмов и предоставления пользователям информации, необходимой для оценки надежности и компетентности системы.

В областях, связанных с высокой ответственностью, таких как академическое консультирование, ошибочное доверие к системам искусственного интеллекта может приводить к серьезным последствиям. Чрезмерная уверенность в рекомендациях ИИ, без критической оценки и сопоставления с индивидуальными потребностями студента, способна привести к неверному выбору учебного плана или карьеры. С другой стороны, необоснованный скептицизм и полное игнорирование полезных предложений ИИ может лишить студента ценной информации и возможностей для развития. Таким образом, достижение сбалансированного уровня доверия, основанного на понимании возможностей и ограничений искусственного интеллекта, является ключевым фактором для успешного применения этих технологий в образовании и профессиональной ориентации.

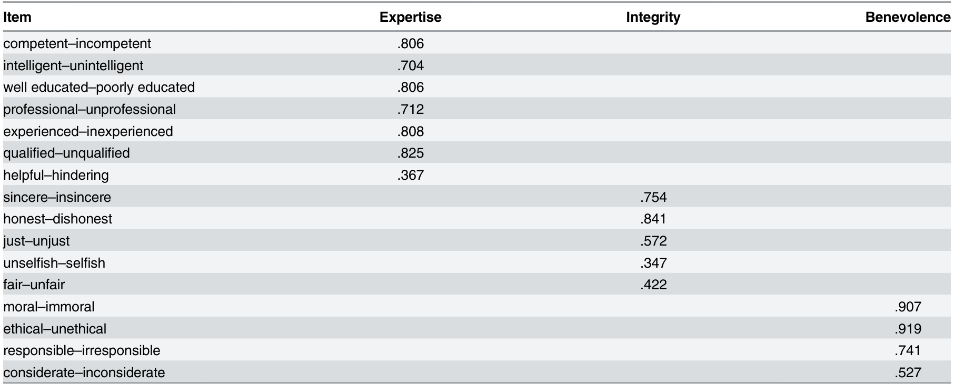

Понимание факторов, формирующих доверие, особенно так называемой эпистемической надежности, включающей в себя компетентность, честность и благожелательность, представляется первостепенной задачей. Исследования показывают, что доверие к системам искусственного интеллекта не является слепым принятием, а формируется на основе оценки этих трех ключевых аспектов. Компетентность подразумевает способность системы демонстрировать знания и навыки в определенной области, честность — прозрачность и отсутствие предвзятости в процессе принятия решений, а благожелательность — уверенность в том, что система действует в интересах пользователя. Недостаток в любом из этих компонентов может подорвать доверие и, как следствие, снизить эффективность взаимодействия человека и искусственного интеллекта, особенно в критически важных сферах, где ошибки могут иметь серьезные последствия.

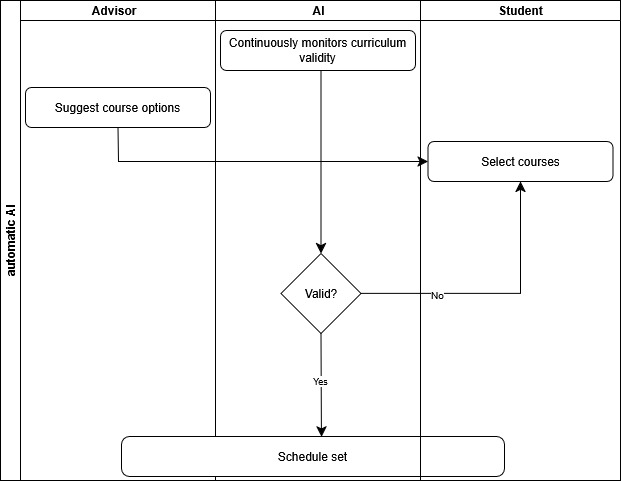

Моделирование реальности: Контролируемая среда консультирования

Мы разработали Симуляцию консультирования — интерактивную среду, в которой участники выступают в роли студентов, получающих рекомендации по выбору курсов от консультанта. Данная среда позволяет моделировать процесс консультирования, представляя участникам различные сценарии и фиксируя их ответы и реакции. В рамках симуляции создана возможность манипулирования переменными, относящимися к поведению консультанта и характеру предоставляемых рекомендаций, что позволяет проводить контролируемые эксперименты и анализировать влияние различных факторов на принятие решений студентами. Симуляция реализована в виде программного обеспечения, обеспечивающего интерактивное взаимодействие между участниками и системой.

В рамках симуляции консультирования реализован тщательно структурированный рабочий процесс. Участникам последовательно представляются заранее подготовленные сценарии, имитирующие различные ситуации выбора курсов. Система фиксирует все ответы и действия пользователя на каждом этапе взаимодействия, включая выбранные опции, текстовые запросы и время, затраченное на принятие решений. Этот механизм сбора данных позволяет детально анализировать поведение пользователей и оценивать эффективность различных стратегий консультирования в контролируемых условиях. Каждый сценарий включает в себя определенный набор параметров, таких как академическая успеваемость студента, его интересы и требования к курсу, что обеспечивает воспроизводимость и сопоставимость результатов.

Использование симуляции позволяет нам изолированно оценивать влияние качества работы консультанта и вмешательства искусственного интеллекта на уровень доверия пользователя. В рамках контролируемой среды мы можем систематически варьировать характеристики поведения консультанта (например, точность рекомендаций, скорость ответа) и степень автоматизации процесса консультирования. Это позволяет нам количественно измерить, как различные факторы влияют на восприятие надежности и компетентности консультанта со стороны пользователя, а также на его готовность следовать полученным рекомендациям. Полученные данные используются для определения оптимальных стратегий взаимодействия, сочетающих преимущества человеческого опыта и возможностей искусственного интеллекта.

Вмешательство ИИ и динамика доверия: Проактивность против реактивности

В ходе исследования были протестированы два основных режима контроля со стороны искусственного интеллекта (ИИ): Проактивная помощь ИИ, при которой ИИ выявляет потенциальные ошибки до их возникновения, и Реактивная помощь ИИ, вмешивающаяся только после обнаружения ошибки. Проактивный режим предполагает предварительное обнаружение и предупреждение пользователя о возможных неточностях, в то время как реактивный режим активируется уже после совершения ошибки и ее последующей коррекции. Данный подход позволил оценить влияние каждого режима на восприятие пользователем надежности и компетентности ИИ-помощника.

Результаты исследования показали, что как проактивная, так и реактивная помощь со стороны ИИ оказывают влияние на уровень доверия пользователей, однако механизмы этого влияния различны. Проактивное вмешательство, заключающееся в предупреждении ошибок до их возникновения, формирует у пользователя представление о компетентности консультанта, что приводит к повышению доверия, даже если ошибка была предотвращена. В то время как реактивное вмешательство, корректирующее уже допущенные ошибки, может сигнализировать о потенциальной ненадежности или несовершенстве консультанта, что, в свою очередь, может негативно сказаться на уровне доверия, несмотря на успешную коррекцию.

Исследования показали, что превентивная (проактивная) помощь со стороны искусственного интеллекта выходит за рамки простого повышения эффективности работы. Она способствует формированию чувства совместной компетентности и сотрудничества между человеком и машиной. В отличие от этого, реактивное вмешательство, исправляя допущенные ошибки, может сигнализировать о потенциальной несостоятельности консультанта, снижая уровень доверия, несмотря на успешную коррекцию. Таким образом, восприятие надежности системы зависит не только от исправления ошибок, но и от способа, которым это исправление осуществляется.

Измерение доверия и эффективности: Подтверждение наших выводов

Для всесторонней оценки эпистемической надежности пользователей применялись две методики: шкала доверия Riedl et al. и инструмент METI (Measure of Epistemic Trust in Information). Шкала Riedl et al. позволяет оценить общее доверие к источнику информации, в то время как METI фокусируется на доверии к когнитивным способностям и компетентности источника. Комбинированное использование этих инструментов позволило получить более полное представление о факторах, влияющих на доверие пользователей к рекомендациям, полученным от консультанта и системы искусственного интеллекта.

Наблюдалась выраженная корреляция между результатами работы консультанта и уровнем доверия к нему со стороны пользователей. Однако, вмешательство искусственного интеллекта (ИИ) статистически значимо изменяло эту взаимосвязь. Анализ данных показал, что ИИ не просто усиливал или ослаблял существующую корреляцию, а оказывал модулирующее влияние, то есть изменял характер связи между эффективностью консультанта и уровнем доверия. Это означает, что влияние результатов работы консультанта на доверие могло быть различным в зависимости от того, вмешивался ли ИИ и каким образом.

В ходе исследования тщательно отслеживались случаи ошибок в планировании (Scheduling Errors) и анализировалось корректирующее вмешательство (Corrective Intervention) со стороны ИИ в связи с последующими оценками доверия. Полученные данные показали, что ключевым фактором, влияющим на уровень доверия, является результат консультации (успех или ошибка), а не способ оказания помощи со стороны ИИ. Иными словами, пользователи оценивали результат работы системы в большей степени, чем сам факт использования ИИ для исправления ошибок, что свидетельствует о приоритете функциональной эффективности над механизмом ее достижения.

Результаты анализа показали значительное снижение восприятия экспертности консультанта, измеренное по шкале Hendriks et al. (2015), в условиях проактивной работы ИИ при наличии ошибок (p=0.03). Доверие к консультанту, оцененное по шкале Riedl et al., было значительно ниже в реактивной группе ошибок по сравнению с проактивной группой ошибок (p=0.05). Намерение повторного использования системы также значительно снижалось в проактивной группе с ошибками по сравнению как с группой «только консультант» (p=0.04), так и с проактивной группой, достигшей успеха (p=0.03), при этом размеры эффекта (η²) варьировались от 0.13 до 0.16. Данные указывают на то, что ошибки, возникающие при проактивной помощи ИИ, негативно влияют на восприятие компетенции и доверия к консультанту, а также снижают готовность пользователей к дальнейшему использованию системы.

Влияние на будущее человеко-машинных команд

Исследования подчеркивают, что проектирование систем искусственного интеллекта должно быть направлено не только на исправление ошибок, но и на формирование доверия посредством упреждающей помощи и прозрачной коммуникации. Особое внимание уделяется способности ИИ предвидеть потенциальные проблемы и предлагать решения до того, как они приведут к ошибкам, что способствует ощущению совместной компетентности и сотрудничества между человеком и машиной. Прозрачность в логике работы и объяснении принимаемых решений позволяет пользователю лучше понимать действия ИИ, что, в свою очередь, укрепляет уверенность в его надежности и повышает готовность к взаимодействию. Таким образом, акцент смещается с простой коррекции ошибок на создание системы, способствующей развитию взаимопонимания и доверия между человеком и искусственным интеллектом.

Исследования показывают, что превентивная помощь со стороны искусственного интеллекта выходит за рамки простого повышения эффективности работы. Она способствует формированию чувства совместной компетентности и сотрудничества между человеком и машиной. Вместо пассивного исправления ошибок, активное предвидение потребностей и предоставление своевременной поддержки укрепляет уверенность пользователя в системе и повышает его вовлеченность. Это, в свою очередь, создает более продуктивные и гармоничные команды, где человек и ИИ работают не просто рядом, а как единое целое, дополняя сильные стороны друг друга и смягчая недостатки. Такой подход ведет к более широкому принятию и эффективному использованию технологий искусственного интеллекта в различных сферах деятельности.

Перспективные исследования направлены на адаптацию выявленных принципов взаимодействия человека и искусственного интеллекта к разнообразным сферам деятельности. Особое внимание уделяется созданию команд, где ИИ не просто корректирует ошибки, но и активно помогает, повышая уверенность пользователя и формируя ощущение совместной компетентности. Разработка подобных систем предполагает выход за рамки узкоспециализированных задач и охватывает такие области, как медицина, образование и инженерия, где доверие и эффективное сотрудничество между человеком и машиной являются критически важными факторами успеха. Успешная реализация этих принципов позволит создать более продуктивные и надежные человеко-машинные команды, способные решать сложные задачи и достигать выдающихся результатов.

Исследование показывает, что доверие к системам консультирования с участием ИИ тесно связано не только с правильностью полученного совета, но и с механизмом исправления ошибок. Автоматическая коррекция, хотя и эффективна, не всегда способствует укреплению доверия в той же мере, как исправление, инициированное человеком-экспертом. Это подчеркивает важность сохранения человеческого контроля и прозрачности в процессе консультирования. Как заметил Г.Х. Харди: «Математика — это искусство делать точные выводы из неточных предпосылок». Аналогично, в системах с участием ИИ, важно понимать, что даже совершенные алгоритмы работают с неполными данными, и именно человеческая интуиция и способность к критическому анализу позволяют выявлять и корректировать потенциальные неточности, формируя тем самым прочное доверие к системе.

Куда же дальше?

Исследование подчеркивает, что доверие к системам поддержки принятия решений, основанным на искусственном интеллекте, не является простым следствием корректности результата. Гораздо важнее — механизм исправления ошибок. Если система автоматически корректирует неточности, это вызывает иные реакции, нежели когда инициатива исправления исходит от эксперта-человека. Если система кажется сложной, она, вероятно, хрупка — и это особенно верно для систем, претендующих на роль доверенного советника. Архитектура, в конечном счете, — это искусство выбора того, чем пожертвовать, и здесь важно понять, готовы ли мы пожертвовать прозрачностью ради автоматической коррекции.

Остается открытым вопрос о долгосрочном влиянии автоматической коррекции на когнитивные способности экспертов. Не ослабляет ли автоматизация критического мышления? Не приводит ли она к ситуации, когда эксперт становится скорее верификатором, чем активным участником процесса принятия решений? Необходимо исследовать, как различные стратегии распределения ответственности между человеком и машиной влияют на качество экспертных оценок и на способность системы к самообучению.

Представляется важным отойти от упрощенного взгляда на доверие как на статичную величину. Доверие — это динамичный процесс, зависящий от контекста, истории взаимодействия и индивидуальных особенностей эксперта. Следующий этап исследований должен быть направлен на создание более сложных моделей доверия, учитывающих эти факторы. Простота — высшая форма сложности, но в случае доверия к ИИ, её достижение представляется непростой задачей.

Оригинал статьи: https://arxiv.org/pdf/2602.11522.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый скачок: от лаборатории к рынку

- Эффективный параллелизм: iCIPT2 на службе квантифицируемой химии

- Квантовая геометрия управления: плавные траектории в пространстве состояний

2026-02-13 21:50