Автор: Денис Аветисян

Новое исследование показывает, как инструменты объяснимого AI могут быть интегрированы в платформы машинного обучения без программирования, делая сложные алгоритмы доступными для широкой аудитории.

Оценка юзабилити и эффективности интегрированного модуля объяснимого AI для no-code ML, с учетом потребностей пользователей разного уровня подготовки.

Растущее применение машинного обучения в критически важных областях, таких как здравоохранение и финансы, обостряет проблему прозрачности принимаемых решений. В работе ‘Explaining AI Without Code: A User Study on Explainable AI’ представлен и оценен модуль интерпретируемого машинного обучения (XAI), интегрированный в платформу без программирования DashAI, демонстрирующий удобство использования и положительную оценку пользователей. Полученные результаты показывают, что модуль, использующий методы PDP, PFI и KernelSHAP, обеспечивает высокую эффективность решения задач объяснения, однако потребности начинающих и опытных пользователей существенно различаются. Каким образом можно создать системы XAI, которые были бы одновременно доступны новичкам и достаточно детализированы для экспертов в области машинного обучения?

Чёрный ящик машинного обучения: Почему доверие — это роскошь

Несмотря на стремительное развитие машинного обучения, многие современные модели остаются так называемыми «черными ящиками», что существенно затрудняет их внедрение и вызывает недоверие у пользователей. Внутренняя логика этих алгоритмов часто непрозрачна и не поддается анализу, что лишает возможности понять, на основании каких факторов принимается то или иное решение. Такая непрозрачность особенно критична в областях, где ошибки могут иметь серьезные последствия, например, в медицине или финансах, где необходима уверенность в обоснованности прогнозов и возможность выявления потенциальных смещений или предвзятостей. В результате, даже высокоточные модели могут оставаться невостребованными, если их работа не поддается объяснению и проверке.

Отсутствие прозрачности в работе алгоритмов машинного обучения представляет особую угрозу в критически важных областях, таких как здравоохранение и финансы. В этих сферах, где решения напрямую влияют на жизнь и благосостояние людей, недостаточно просто получить прогноз; необходимо понимать логику, лежащую в его основе. Например, в медицине, если алгоритм рекомендует определенное лечение, врачу и пациенту важно знать, какие факторы привели к этому заключению, чтобы оценить его обоснованность и соответствие индивидуальным особенностям. Аналогично, в финансовом секторе, алгоритмы, определяющие кредитоспособность или инвестиционные стратегии, должны быть понятны, чтобы избежать дискриминации или необъективных решений. Неспособность объяснить логику работы алгоритма подрывает доверие к системе и препятствует ее эффективному внедрению, особенно в областях, требующих высокой степени ответственности и надежности.

Отсутствие понимания логики, лежащей в основе предсказаний машинной модели, существенно затрудняет выявление скрытых предубеждений и оценку её надёжности. Если алгоритм выдаёт результат, но причины этого результата остаются неясными, сложно определить, не основывается ли он на искажённых данных или несправедливых критериях. Это особенно критично в сферах, где решения модели оказывают непосредственное влияние на жизнь людей, например, в здравоохранении или финансах. Без возможности проследить ход рассуждений алгоритма, невозможно гарантировать, что его выводы объективны и свободны от систематических ошибок, что подрывает доверие к таким системам и препятствует их широкому внедрению.

Необходимость преодоления проблемы «черного ящика» в машинном обучении ведет к переходу к так называемому «Объяснимому Искусственному Интеллекту» (XAI). В отличие от традиционных моделей, чьи внутренние механизмы остаются непрозрачными, XAI стремится предоставить четкое и понятное обоснование для каждого предсказания. Это достигается за счет разработки алгоритмов, способных выявлять и представлять факторы, наиболее сильно повлиявшие на результат, позволяя пользователям оценить достоверность и надежность модели. Внедрение XAI особенно важно в критически важных областях, таких как здравоохранение и финансы, где понимание логики принятия решений является ключевым для обеспечения справедливости, безопасности и ответственности.

Доступный ИИ: Объяснимость и простота использования — ключ к доверию

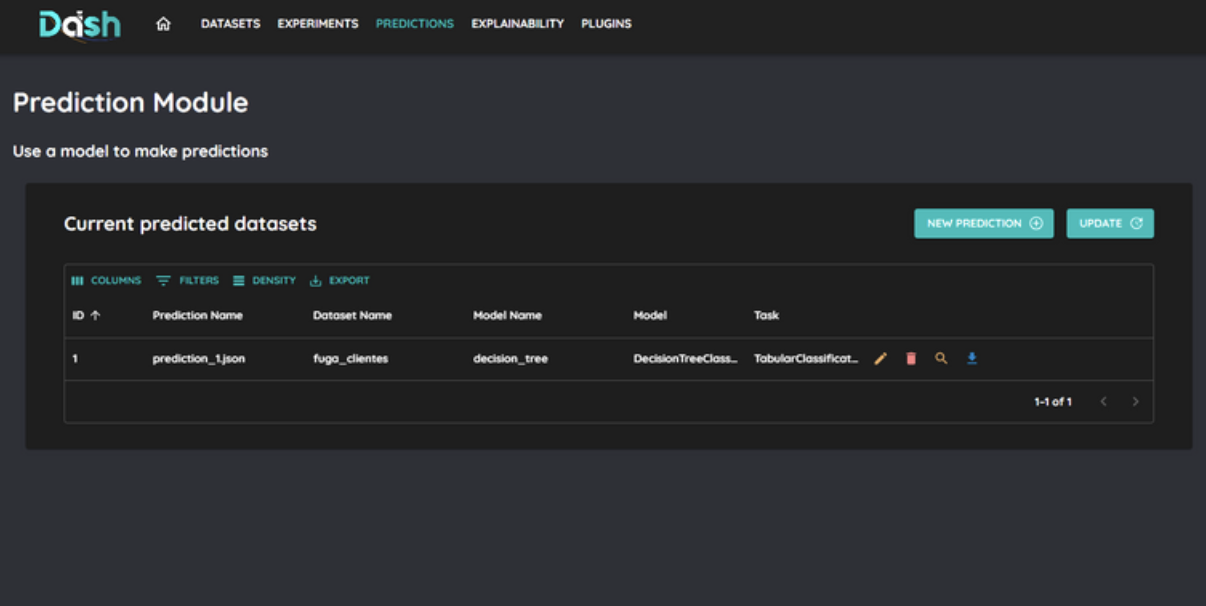

Платформа DashAI представляет собой инновационное решение, объединяющее доступность машинного обучения без программирования с мощными функциями объяснимости. Данный подход позволяет пользователям, не обладающим навыками кодирования, создавать и развертывать модели машинного обучения, одновременно получая возможность анализа и понимания логики, лежащей в основе принимаемых моделью решений. Интеграция этих двух ключевых компонентов направлена на упрощение процесса внедрения искусственного интеллекта и повышение доверия к результатам его работы.

Платформа DashAI предоставляет возможность пользователям создавать и развертывать модели машинного обучения без необходимости владения обширными навыками программирования. Инструменты платформы основаны на визуальном интерфейсе и логике перетаскивания, позволяя пользователям импортировать данные, выбирать подходящие алгоритмы и настраивать параметры модели без написания кода. Это достигается за счет использования предварительно сконфигурированных компонентов и автоматизированных процессов, что упрощает процесс разработки и делает машинное обучение доступным для более широкой аудитории, включая аналитиков данных и специалистов предметных областей, не являющихся программистами.

В основе функциональности DashAI лежит модуль ‘Объяснимости’ (Explainability Module), предназначенный для анализа и раскрытия логики, лежащей в основе прогнозов модели машинного обучения. Данный компонент позволяет пользователям понять, какие факторы и признаки данных оказали наибольшее влияние на конкретное предсказание. Модуль предоставляет детальную информацию о вкладе каждого признака, что позволяет выявлять потенциальные смещения в данных или нежелательное поведение модели. Результаты анализа представляются в виде структурированных данных и визуализаций, облегчающих интерпретацию и повышающих доверие к принятым моделью решениям.

Подход, сочетающий в себе простоту использования и возможность интерпретации результатов, существенно снижает порог входа для внедрения технологий искусственного интеллекта. Платформа DashAI позволяет пользователям без глубоких навыков программирования создавать и развертывать модели, а модуль объяснимости (Explainability Module) предоставляет инструменты для понимания логики, лежащей в основе прогнозов. Эффективность данного подхода подтверждается успешностью выполнения задач по интерпретации результатов в не менее чем 80% случаев, что способствует повышению доверия пользователей к принимаемым моделями решениям.

Заглядывая внутрь модели: Методы интерпретации в действии

Модуль объяснимости DashAI использует методы, такие как Permutation Feature Importance и Partial Dependence Plots, для анализа вклада различных признаков в принятие решений моделью. Permutation Feature Importance оценивает важность признака путем измерения снижения производительности модели после случайного перемешивания значений этого признака. Partial Dependence Plots (PDP) визуализируют среднюю зависимость между одним или несколькими признаками и предсказанием модели, позволяя оценить, как изменение значения признака влияет на результат, при усреднении по всем остальным признакам. Комбинирование этих методов позволяет выявить наиболее значимые признаки, определяющие поведение модели, и получить представление о характере их влияния.

Частичные графики зависимости (Partial Dependence Plots, PDP) визуализируют влияние отдельных признаков на предсказания модели, усредняя эффект признака по всем значениям других признаков. По сути, PDP показывают, как изменяется среднее предсказание модели при изменении значения целевого признака, при этом все остальные признаки остаются постоянными на их среднем значении. Это позволяет получить глобальное представление о монотонности и нелинейности связи между признаком и предсказанием, а также выявить потенциальные взаимодействия между признаками. Полученные данные используются для генерации глобальных объяснений, описывающих общее поведение модели и ключевые факторы, влияющие на её решения.

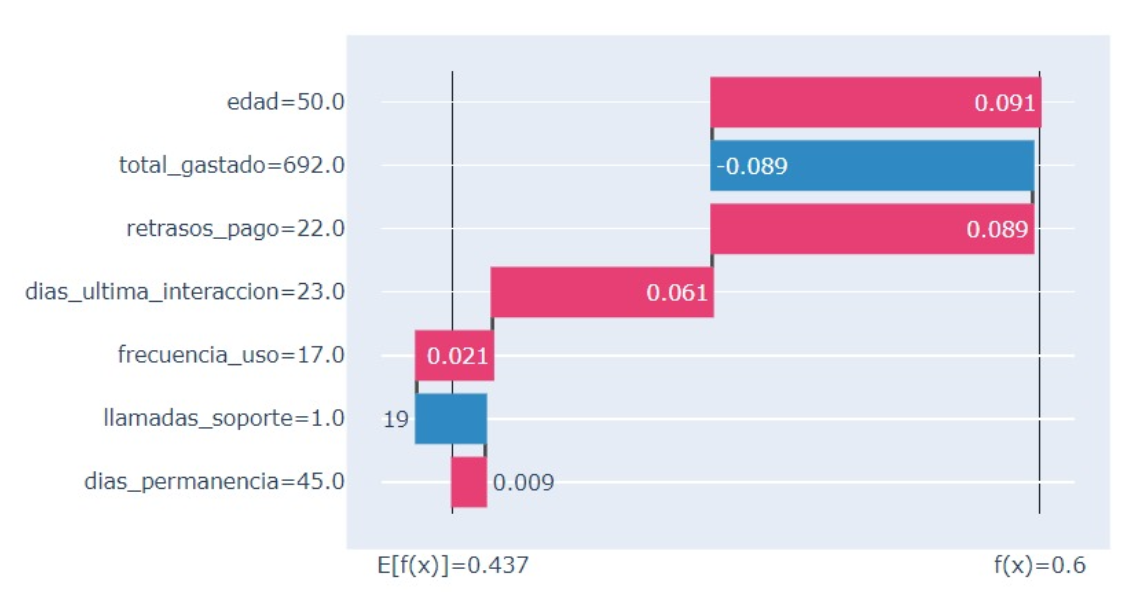

Для объяснения отдельных предсказаний, алгоритм KernelSHAP предоставляет локальные объяснения, количественно оценивая вклад каждой признака в итоговый результат. В отличие от глобальных методов, KernelSHAP вычисляет влияние каждого признака для конкретного экземпляра данных, основываясь на принципах теории игр и используя взвешенное усреднение вкладов признаков по различным подмножествам данных. Результатом является вектор значений Shapley, отражающий, насколько каждый признак повлиял на отклонение предсказания от базового значения, что позволяет понять, какие факторы привели к конкретному решению модели.

Комбинация методов, таких как Permutation Feature Importance, Partial Dependence Plots и KernelSHAP, обеспечивает комплексный анализ логики работы модели машинного обучения. Использование нескольких подходов позволяет не только выявить наиболее значимые признаки, определяющие предсказания модели (ключевые драйверы), но и обнаружить потенциальные смещения (biases) в процессе принятия решений. Partial Dependence Plots дают глобальное представление о влиянии отдельных признаков, в то время как KernelSHAP предоставляет локальные объяснения для конкретных предсказаний, количественно оценивая вклад каждого признака в конечный результат. Совместное применение этих техник позволяет пользователям получить полное представление о принципах работы модели и выявить области, требующие дальнейшего анализа или корректировки.

Проверяя интерпретируемость: Оценка с точки зрения пользователя

Для подтверждения реальной эффективности объяснений, предоставляемых платформой DashAI, используется подход, ориентированный на пользователя. Это означает, что оценка не ограничивается техническими метриками, а включает в себя непосредственный отклик и восприятие пользователей. В рамках данной стратегии, платформа собирает данные о том, насколько легко пользователям понимать и использовать предложенные объяснения, а также насколько они удовлетворены их содержанием. Такой подход позволяет не просто определить, что объяснения существуют, но и удостовериться в их практической ценности и способности улучшать взаимодействие пользователя с системой, обеспечивая более прозрачный и понятный процесс принятия решений.

Для оценки удобства использования и интуитивности интерфейса объяснений в DashAI была применена Система Оценки Удобства Использования (System Usability Scale, SUS). Данный метод позволяет комплексно оценить, насколько легко пользователям взаимодействовать с системой и понимать представленные объяснения. SUS представляет собой опросник, состоящий из десяти вопросов, ответы на которые позволяют получить количественную оценку удобства использования. Полученные данные помогают разработчикам выявить проблемные места в интерфейсе и внести необходимые улучшения для повышения эффективности и доступности объяснений, предоставляемых платформой.

Для непосредственной оценки полезности и понятности предоставляемых объяснений, платформа DashAI использует разработанную шкалу удовлетворенности объяснениями. Эта шкала позволяет количественно измерить, насколько успешно система доносит информацию до пользователя, и является ключевым показателем эффективности работы алгоритмов интерпретируемости. Полученный коэффициент Кронбаха-альфа, равный 0.74, свидетельствует о приемлемой надежности шкалы, что подтверждает стабильность и внутреннюю согласованность получаемых результатов. Высокий показатель надежности позволяет с уверенностью использовать эту шкалу для оценки и дальнейшей оптимизации качества предоставляемых объяснений, направленной на повышение доверия и удобства использования платформы.

Оценка доверия к автоматизации выявила умеренный уровень надежности, подтвержденный коэффициентом Кронбаха, равным 0.60. Этот показатель указывает на необходимость дальнейшей работы над укреплением уверенности пользователей в системе DashAI. Полученные данные свидетельствуют о том, что предоставляемые объяснения пока недостаточно убедительны для формирования полной веры в корректность и надежность автоматизированных решений. Исследователи подчеркивают, что повышение доверия является ключевым фактором для успешного внедрения подобных технологий, и дальнейшие улучшения интерфейса и качества объяснений должны быть направлены именно на эту задачу.

Изучение способов визуализации работы моделей машинного обучения для не-программистов — занятие, конечно, полезное. Но, как показывает данная работа, даже самые элегантные инструменты вроде графиков частичных зависимостей и важности признаков, в конечном итоге, сводятся к интерпретации данных. Кен Томпсон однажды заметил: «Все проблемы в компьютерных науках могут быть сведены к проблеме управления сложностью». И это, пожалуй, самое точное определение. Платформы, стремящиеся к упрощению, неизбежно наталкиваются на необходимость представления сложной информации понятным образом. Пользователи, как показывает исследование, имеют разные потребности — от новичков, которым нужна общая картина, до экспертов, требующих детального анализа. В итоге, получается, что мы не столько пишем код, сколько оставляем комментарии будущим археологам, пытающимся понять, как эта сложная система вообще работает.

Что дальше?

Представленная работа демонстрирует, что визуализация работы моделей машинного обучения для непрофессионалов — задача, в принципе, решаемая. Однако, эйфория от «объяснимого ИИ» — это, как правило, временное явление. Инструменты объяснения быстро становятся лишь ещё одним слоем абстракции, скрывающим реальные ограничения моделей и предубеждения данных. Пользователь, увидев красивый график, склонен верить в объективность алгоритма, не задаваясь вопросом о качестве исходных данных и архитектурных компромиссах.

Разделение пользователей на «новичков» и «экспертов» — это удобная, но поверхностная классификация. Истинная проблема заключается не в уровне подготовки, а в мотивации. Эксперту нужна возможность глубокой отладки и анализа, а новичку — иллюзия понимания. Более перспективным направлением представляется создание инструментов, позволяющих пользователям задавать правильные вопросы, а не просто получать красивые ответы.

В конечном счете, не нужно больше визуализаций — нам нужно меньше самообмана. Каждая «революция» в области XAI неизбежно порождает новый класс проблем, связанных с интерпретацией интерпретаций. Пока прод не прикоснётся к этим красивым графикам, они останутся лишь ещё одним способом переизобрести костыли с новым логотипом.

Оригинал статьи: https://arxiv.org/pdf/2602.11159.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый скачок: от лаборатории к рынку

- Эффективный параллелизм: iCIPT2 на службе квантифицируемой химии

- Квантовая геометрия управления: плавные траектории в пространстве состояний

- Резонансы в тандеме: Управление светом в микрорезонаторах

2026-02-14 06:21