Автор: Денис Аветисян

Новое исследование демонстрирует, что замена блоков Transformer на гибридные операторы Mamba-2 в моделях рекурсивного рассуждения значительно расширяет возможности поиска решений в сложных задачах.

Предлагается гибридная архитектура, сочетающая рекурсивное рассуждение с преимуществами State Space Models (SSM) Mamba-2, обеспечивающая высокую производительность и эффективность.

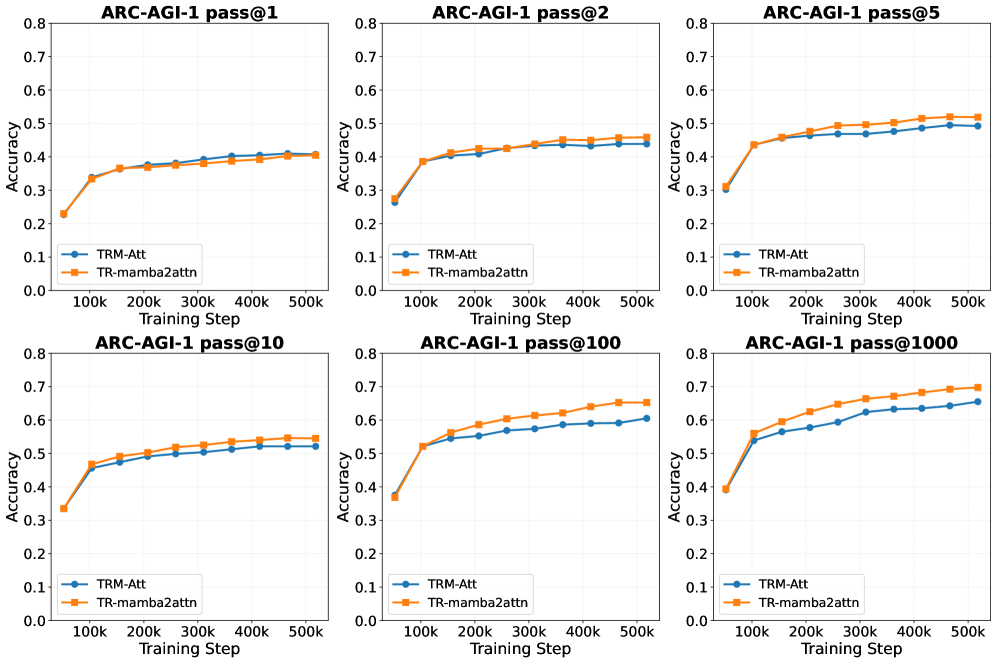

Несмотря на успехи больших языковых моделей, создание эффективных и компактных архитектур для задач абстрактного мышления остается сложной задачей. В работе ‘Tiny Recursive Reasoning with Mamba-2 Attention Hybrid’ исследуется возможность повышения эффективности рекурсивного рассуждения путем замены стандартных блоков Transformer на гибридные операторы Mamba-2 в модели TRM. Полученные результаты демонстрируют улучшение метрики pass@2 на 2.0% (до 45.88%) на наборе данных ARC-AGI-1, что свидетельствует о расширении охвата корректных решений без снижения точности выбора первого кандидата. Какие оптимальные стратегии смешивания различных типов операторов позволят в дальнейшем раскрыть потенциал рекурсивных архитектур для задач сложного рассуждения?

Пределы масштабирования: Рассуждения в больших языковых моделях

Несмотря на впечатляющие успехи больших языковых моделей в различных задачах, достижение надежного и последовательного рассуждения остается сложной проблемой, особенно при увеличении сложности решаемых задач. Модели демонстрируют способность генерировать правдоподобные тексты и даже решать некоторые логические головоломки, однако их возможности быстро исчерпываются при столкновении с задачами, требующими многоступенчатых умозаключений и глубокого понимания контекста. Проблемой является не просто недостаток данных для обучения, а фундаментальное ограничение в архитектуре, не позволяющее эффективно поддерживать и обрабатывать информацию на протяжении длительных цепочек рассуждений. В результате, модели часто допускают ошибки в логике, не могут выявлять противоречия или делать обоснованные выводы, что ограничивает их применение в областях, требующих высокой степени надежности и точности.

Несмотря на впечатляющие успехи больших языковых моделей, стратегия увеличения их масштаба сталкивается с законом убывающей доходности и серьезными вычислительными ограничениями. Попытки решить сложные задачи исключительно за счет наращивания количества параметров приводят к экспоненциальному росту потребляемых ресурсов — памяти, энергии и времени вычислений. Вскоре достигается предел, когда дальнейшее увеличение размера модели не приносит существенного улучшения в способности к рассуждениям, а лишь усугубляет проблему вычислительной неэффективности. Данный подход оказывается не только дорогостоящим, но и не масштабируемым в долгосрочной перспективе, что подчеркивает необходимость поиска альтернативных архитектур и методов, способных к более эффективному и рациональному решению задач.

Для эффективного рассуждения недостаточно простого запоминания информации; необходим механизм, позволяющий поддерживать последовательные, итеративные мыслительные процессы. Исследования показывают, что современные большие языковые модели, хотя и демонстрируют впечатляющие результаты в задачах, требующих запоминания, часто терпят неудачу при решении более сложных задач, требующих логического вывода и последовательного применения знаний. Это связано с тем, что модели склонны к «поверхностному» пониманию, оперируя статистическими закономерностями, а не глубоким анализом. Способность поддерживать «внутренний диалог», последовательно оценивать промежуточные результаты и корректировать ход рассуждений — ключевое требование для подлинного интеллектуального поведения, которое пока остается сложной задачей для существующих архитектур.

Современные архитектуры больших языковых моделей сталкиваются с существенным ограничением при обработке сложных задач, требующих последовательного рассуждения. Неспособность эффективно сохранять контекст на протяжении длительных цепочек логических шагов приводит к постепенной потере информации и, как следствие, к снижению точности ответов. В процессе развернутого рассуждения модели зачастую теряют связь между начальными условиями и промежуточными выводами, что проявляется в нелогичных заключениях и ошибках. Данное ограничение подчеркивает необходимость разработки новых подходов к архитектуре, позволяющих моделям более надежно удерживать и использовать информацию, накопленную в ходе многоступенчатого решения задачи, и преодолевать текущие границы масштабирования для достижения подлинного интеллектуального уровня.

Рекурсивная мысль: Новая парадигма рассуждений

В основе надёжного рассуждения лежит рекурсивный процесс, при котором система последовательно обращается к собственным промежуточным результатам и текущему состоянию, для уточнения и улучшения понимания. Этот процесс предполагает многократное применение одной и той же логической операции к результатам предыдущей итерации, что позволяет постепенно сужать область поиска решения или углублять анализ проблемы. Рекурсия обеспечивает возможность самокоррекции и адаптации к новым данным, поскольку каждая итерация использует накопленный опыт для формирования более точной модели ситуации. В отличие от линейных процессов, рекурсивный подход позволяет учитывать контекст и взаимосвязи между элементами, что критически важно для решения сложных задач.

Для обеспечения эффективного рассуждения необходим механизм динамического управления сохранением информации, позволяющий выделять релевантные детали и отбрасывать несущественные. Этот процесс предполагает не просто накопление данных, а их селективную фильтрацию и приоритизацию, что позволяет модели концентрироваться на ключевых аспектах задачи. Отбрасывание «шума» снижает когнитивную нагрузку и предотвращает перегрузку системы, позволяя более эффективно использовать ограниченные ресурсы памяти и вычислительной мощности. Эффективное управление информацией является критическим для поддержания контекста и предотвращения потери важной информации в процессе рассуждений.

Селективные пространства состояний обеспечивают возможность приоритизации и сохранения ключевой информации в процессе рассуждений. В отличие от традиционных методов, обрабатывающих все данные одинаково, эта архитектура динамически выбирает и обновляет элементы в пространстве состояний, основываясь на текущем входном сигнале. Это позволяет модели концентрироваться на релевантной информации и игнорировать неважные детали, что приводит к снижению вычислительных затрат и повышению эффективности обработки длинных последовательностей.

Традиционные методы рассуждений, в отличие от рекурсивного подхода, зачастую рассматривают всю входящую информацию как равноценную, что приводит к неэффективности обработки и потере контекста. При таком подходе, модель вынуждена хранить и обрабатывать все данные, вне зависимости от их релевантности для текущей задачи. Это приводит к увеличению вычислительных затрат и снижению точности, поскольку нерелевантная информация может искажать или зашумлять полезные данные. В результате, модель испытывает трудности с поддержанием когерентной цепочки рассуждений и может делать ошибочные выводы из-за перегрузки информацией.

Mamba-2: Реализация эффективного рекурсивного рассуждения

Mamba-2 реализует эффективное моделирование последовательностей за счет использования селективных пространств состояний. В отличие от традиционных рекуррентных нейронных сетей, которые поддерживают фиксированный размер скрытого состояния на протяжении всей последовательности, Mamba-2 динамически выбирает и обновляет элементы в пространстве состояний, основываясь на текущем входном сигнале. Этот механизм позволяет модели концентрироваться на релевантной информации и игнорировать неважные детали, что приводит к снижению вычислительных затрат и повышению эффективности обработки длинных последовательностей.

Комбинация Mamba-2 с гибридным оператором ‘Mamba-2 + Attention’ обеспечивает возможность как последовательной обработки данных, так и коммуникации между различными позициями в последовательности. Mamba-2, благодаря своей архитектуре, эффективно обрабатывает последовательности, акцентируя внимание на рекуррентной обработке. Добавление механизма внимания позволяет модели устанавливать связи между удаленными элементами последовательности, что критически важно для задач, требующих понимания контекста и долгосрочных зависимостей.

Гибридный подход, сочетающий Mamba-2 с механизмом внимания, призван преодолеть ограничения, присущие исключительно последовательным или основанным на внимании моделям. Чисто последовательные модели, такие как рекуррентные нейронные сети, часто испытывают трудности с улавливанием долгосрочных зависимостей и параллелизацией вычислений. Модели, основанные исключительно на внимании, хотя и способны эффективно моделировать глобальные зависимости, могут быть вычислительно затратными и неэффективными при обработке длинных последовательностей.

В ходе экспериментов модель Mamba-2 продемонстрировала превосходство в задачах, требующих продолжительного логического вывода и распознавания сложных закономерностей. В частности, замена блоков Transformer на блоки Mamba-2 в Tiny Recursive Model (TRM) привела к улучшению показателя pass@2 на 2.0% на бенчмарке ARC-AGI-1. Данный результат подтверждает эффективность Mamba-2 в задачах, требующих устойчивой цепочки рассуждений и анализа сложных данных.

Оценка эффективности рассуждений: За пределами простой точности

Традиционные метрики оценки, такие как простая точность, зачастую оказываются недостаточными для адекватной оценки способностей к рассуждению, особенно в задачах, требующих генерации ответов. Простое сопоставление с правильным ответом не учитывает сложность процесса рассуждения и не отражает уверенность модели в своих выводах. В ситуациях, когда существует множество правдоподобных ответов, модель может генерировать правильный ответ, но не выделять его среди других, что не фиксируется стандартной метрикой точности.

Вместо простой оценки точности, метрика Pass@K предлагает более надёжный способ оценки рассуждений модели. Она измеряет вероятность того, что верный ответ находится среди K наиболее вероятных предсказаний, а не требует от модели сразу выдать абсолютно верный результат. Это особенно важно в задачах, где существует множество допустимых решений или где модель генерирует варианты ответа.

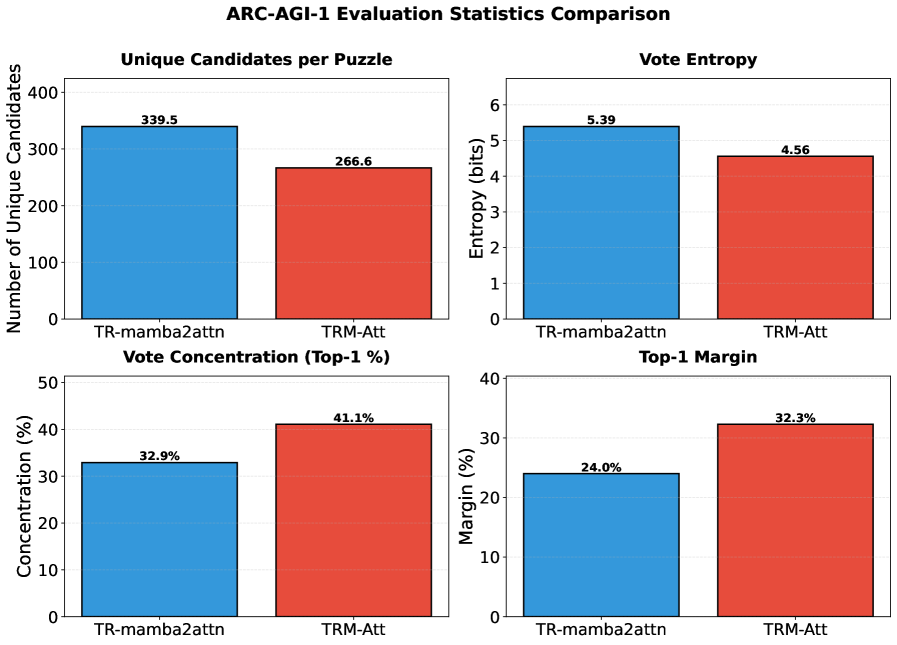

Эффективность метрики Pass@K определяется не только способностью модели генерировать правильные ответы, но и двумя ключевыми аспектами: “Покрытием кандидатов” и “Выбором победителя”. “Покрытие кандидатов” отражает разнообразие генерируемых ответов — чем шире спектр предложений, тем выше вероятность включения верного решения в список. Однако, одного лишь разнообразия недостаточно; “Выбор победителя” характеризует умение модели ранжировать ответы, выделяя наиболее вероятный и правильный.

Результаты тестирования демонстрируют, что усовершенствованная модель не только способна генерировать верные ответы, но и уверенно выделяет их среди множества правдоподобных вариантов. В частности, зафиксировано улучшение на 4.25% в метрике Pass@100 на наборе данных ARC-AGI-1, что свидетельствует о повышении надёжности рассуждений. Помимо этого, модель TR-mamba2mlpt достигла 84.2% точности в решении головоломок Судоку, а TR-mamba2attn — 80.6% в прохождении лабиринтов, подтверждая её способность успешно применять логическое мышление в различных задачах, требующих поиска оптимального решения из множества возможностей.

Исследование демонстрирует, что замена блоков Transformer на гибридные операторы Mamba-2 в рекурсивной модели рассуждений (TRM) повышает охват кандидатов при решении задач абстрактного рассуждения, не снижая при этом производительность. Этот подход подчеркивает важность структурного дизайна для достижения эффективности. Как однажды заметил Кен Томпсон: «Простота — ключ к надежности». Эта мысль находит отражение в данной работе, поскольку замена сложных Transformer-блоков на более лаконичные Mamba-2 операторы позволяет создать систему, которая, сохраняя высокую производительность, становится более понятной и управляемой. Структура, как показано в исследовании, действительно определяет поведение системы, а элегантный дизайн, рожденный из простоты, способствует её устойчивости и масштабируемости.

Куда Ведет Рекурсия?

Представленная работа демонстрирует, что замена блоков Transformer на гибридные операторы Mamba-2 в моделях рекурсивного рассуждения (TRM) позволяет расширить охват кандидатов при решении задач абстрактного мышления, не снижая при этом производительность. Однако, это лишь один шаг в понимании более глубокой связи между архитектурой и поведением системы. Каждая оптимизация, даже кажущаяся успешной, создает новые узлы напряжения, новые точки потенциальной нестабильности. Рекурсия, как инструмент, обладает элегантностью, но требует предельной ясности в определении граничных условий — иначе система неизбежно уйдёт в бесконечный цикл.

Дальнейшие исследования должны быть направлены не только на повышение эффективности отдельных компонентов, но и на понимание принципов организации рекурсивных структур. Вопрос в том, как создать систему, способную к самокоррекции и адаптации, не полагаясь на внешние сигналы, а опираясь на внутреннюю модель мира. Необходимо перейти от поиска оптимальных параметров к проектированию принципиально новых архитектур, где поведение системы определяется не набором правил, а внутренней логикой развития.

Очевидно, что Mamba-2 — перспективный строительный блок, но истинный вызов заключается в создании системы, где рекурсия является не просто механизмом обработки информации, а основой самосознания. В конечном счете, архитектура — это поведение системы во времени, а не схема на бумаге.

Оригинал статьи: https://arxiv.org/pdf/2602.12078.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый скачок: от лаборатории к рынку

- Эффективный параллелизм: iCIPT2 на службе квантифицируемой химии

- Квантовая геометрия управления: плавные траектории в пространстве состояний

- Резонансы в тандеме: Управление светом в микрорезонаторах

2026-02-14 07:55