Автор: Денис Аветисян

В статье представлен разработанный и протестированный технический курс, направленный на повышение AI-грамотности специалистов в области перевода и специализированной коммуникации.

Разработка и оценка учебного плана, ориентированного на освоение технологий искусственного интеллекта в лингвистике, с использованием Jupyter Notebooks и моделей Transformer.

Несмотря на стремительное развитие искусственного интеллекта, специалисты в области перевода и специализированной коммуникации часто испытывают недостаток практического понимания лежащих в его основе технологий. Данная статья представляет разработанную техническую программу обучения, посвященную языко-ориентированному искусственному интеллекту в контексте перевода и специализированной коммуникации. Программа, охватывающая такие ключевые аспекты, как векторные представления, нейронные сети и трансформеры, направлена на формирование у специалистов навыков алгоритмического мышления и повышение их цифровой устойчивости. Возможно ли эффективное внедрение подобных учебных курсов в существующие образовательные программы для подготовки квалифицированных специалистов, способных успешно работать в условиях растущей автоматизации лингвистической отрасли?

Большие Языковые Модели: Новая Реальность и Необходимость Компетенций

Современный ландшафт языковых и переводческих технологий стремительно меняется под воздействием больших языковых моделей (БЯМ). Эти модели открывают беспрецедентные возможности для автоматизации рутинных задач, таких как перевод, написание текстов и анализ данных. Способность БЯМ генерировать связные и контекстуально релевантные тексты, а также адаптироваться к различным стилям и форматам, позволяет значительно повысить производительность и эффективность в широком спектре приложений. Автоматизация, обеспечиваемая БЯМ, выходит далеко за рамки простого перевода слов, позволяя создавать и адаптировать контент на различных языках с высокой степенью точности и естественности, что существенно расширяет горизонты международного сотрудничества и коммуникации.

Для полной реализации потенциала больших языковых моделей (LLM) необходима квалифицированная рабочая сила, обладающая компетенциями в области их понимания, внедрения и критической оценки. Недостаточно просто использовать готовые решения; требуется умение адаптировать LLM к конкретным задачам, оценивать качество генерируемого текста, выявлять потенциальные ошибки и предвзятости, а также интегрировать эти технологии в существующие рабочие процессы. Обучение специалистов должно включать не только технические аспекты, такие как работа с API и настройка параметров моделей, но и развитие критического мышления, позволяющего оценивать надежность и релевантность полученных результатов. Именно сочетание технических навыков и аналитических способностей позволит максимально эффективно использовать возможности LLM и избежать потенциальных рисков, связанных с их применением.

В индустрии лингвистических технологий (ЛТ) наблюдается растущая потребность в специалистах, обладающих технической грамотностью в области искусственного интеллекта. Недавние исследования и практические программы обучения демонстрируют, что целенаправленное повышение квалификации сотрудников в этой сфере значительно повышает эффективность внедрения и использования больших языковых моделей (БЯМ). Повышение осведомленности о принципах работы БЯМ, методах их интеграции и возможностях критической оценки результатов позволяет специалистам ЛТ не только оптимизировать существующие процессы автоматизации, но и разрабатывать инновационные решения, отвечающие современным требованиям рынка. Таким образом, инвестиции в развитие технической грамотности в области ИИ становятся ключевым фактором успеха для компаний, работающих в сфере лингвистических технологий, обеспечивая им конкурентное преимущество и возможность максимально реализовать потенциал новых технологий.

Нейронные Сети и Мощь Субсловной Токенизации

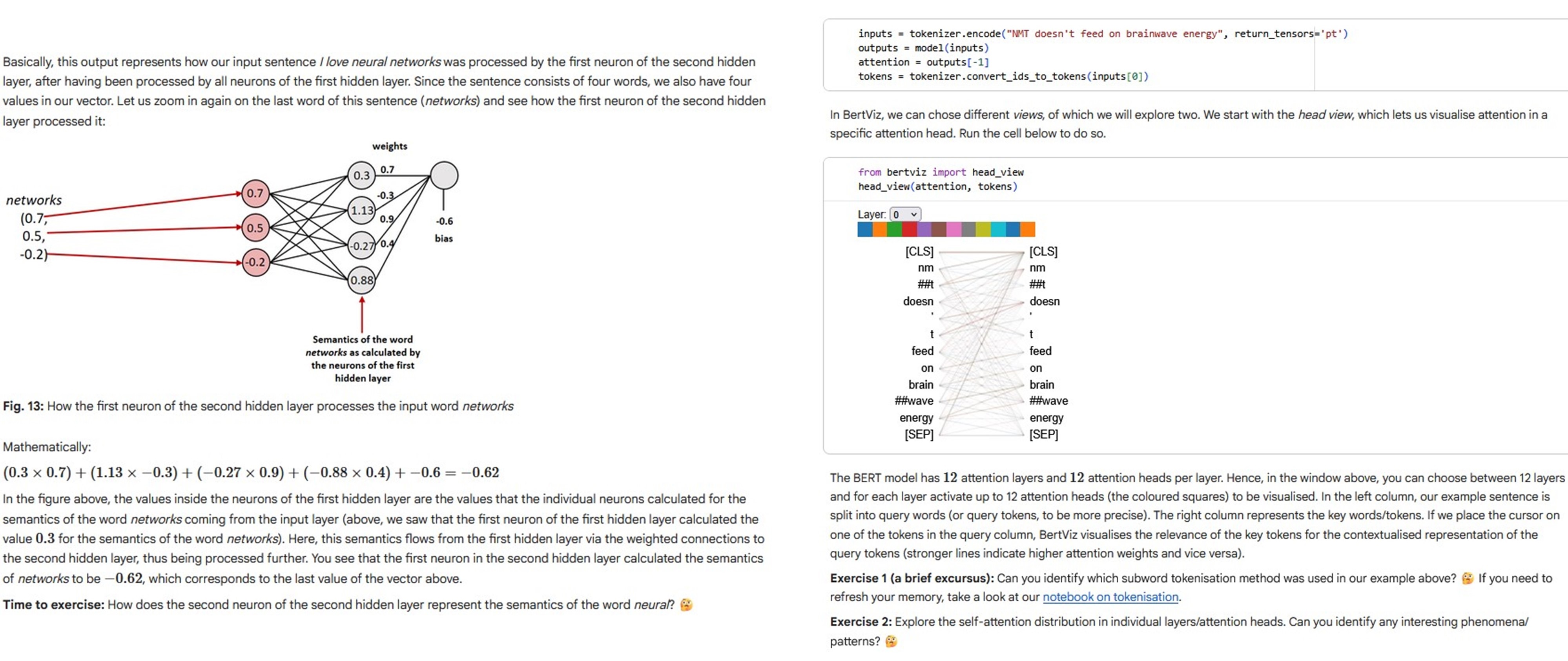

В основе больших языковых моделей (LLM) лежат нейронные сети, которые обрабатывают информацию посредством выявления сложных закономерностей в данных. Эти сети состоят из взаимосвязанных узлов, организованных в слои, и обучаются путем корректировки весов связей между узлами на основе большого объема текстовых данных. Процесс обучения позволяет сети извлекать статистические зависимости между словами и фразами, что позволяет ей предсказывать следующее слово в последовательности, генерировать текст, переводить языки и выполнять другие задачи обработки естественного языка. Архитектуры нейронных сетей, такие как трансформеры, особенно эффективны в обработке последовательностей данных, благодаря механизмам внимания, позволяющим сети фокусироваться на наиболее релевантных частях входных данных.

Эффективное представление лингвистических данных является критически важным для производительности языковых моделей. Традиционные методы токенизации, оперирующие целыми словами, приводят к экспоненциальному росту размера словаря, особенно при работе с морфологически богатыми языками или при наличии редких слов. Субсловная токенизация решает эту проблему, разбивая слова на более мелкие единицы — субслова. Это позволяет значительно сократить размер словаря, улучшить обобщающую способность модели и эффективно обрабатывать неизвестные слова, поскольку они могут быть представлены комбинацией известных субслов. Снижение размера словаря, в свою очередь, уменьшает вычислительную сложность и объем памяти, необходимых для обучения и развертывания модели.

Алгоритмы субвордной токенизации, такие как Byte-Pair Encoding (BPE), WordPiece и Unigram, различаются по своим принципам работы и компромиссам между эффективностью и точностью. BPE и WordPiece используют жадные алгоритмы, объединяя наиболее часто встречающиеся пары символов или подслов, что приводит к относительно небольшому словарю, но может приводить к разделению слов на неестественные фрагменты. Unigram, напротив, использует вероятностную модель, оценивая вероятность каждого подслова и удаляя наименее вероятные, что обеспечивает более гибкое разделение слов, но требует больше вычислительных ресурсов и может приводить к большему словарю. Выбор конкретного алгоритма зависит от размера корпуса, требуемой точности и доступных вычислительных ресурсов.

Инструменты и Ресурсы для Развития Технической Грамотности в Области ИИ

Интерактивные блокноты Jupyter, размещаемые на платформах, таких как Colaboratory, предоставляют среду для обучения и экспериментирования с большими языковыми моделями (LLM) и смежными технологиями. Данная среда объединяет исполняемый код, документацию и визуализации, что способствует более глубокому пониманию основных концепций. В частности, Jupyter Notebooks позволяют пользователям последовательно выполнять код, анализировать результаты и документировать процесс, что особенно ценно при изучении сложных алгоритмов и моделей машинного обучения. Это делает их эффективным инструментом как для самостоятельного изучения, так и для проведения практических занятий и тренингов.

Интерактивные блокноты Jupyter, объединяющие исполняемый код, документацию и визуализацию данных, способствуют более глубокому пониманию принципов работы больших языковых моделей и смежных технологий. Результаты недавнего исследования показали, что 80% участников выразили полное согласие с тем, что Jupyter Notebooks являются подходящим дидактическим инструментом, позволяющим эффективно усваивать материал и проводить практические эксперименты с кодом и данными.

Инициативы LT-LiDER, MultiTraiNMT, DataLitMT и adaptMLLM предоставляют ценные ресурсы и учебные материалы для повышения технической грамотности в области ИИ в сфере обучения и развития (L&T). Результаты исследований показали, что участие в данных программах привело к значительному увеличению самооценки технической компетентности участников. Средний показатель по предтесту составил 3.72 по 11-балльной шкале Ликерта, в то время как средний показатель по посттесту достиг 6.76 (p < 0.001), что свидетельствует о статистически значимом повышении уровня знаний.

Расширение Возможностей Заинтересованных Сторон: Субъектность, Устойчивость и Объяснимость

Развитие технической грамотности в области искусственного интеллекта — это не просто приобретение навыков, а формирование алгоритмической субъектности — способности понимать и влиять на работу алгоритмических систем. Такой подход подразумевает не пассивное восприятие результатов, выдаваемых ИИ, а активное участие в формировании и корректировке этих систем, позволяя пользователям осознанно взаимодействовать с ними. Способность анализировать принципы работы алгоритмов, выявлять потенциальные предубеждения и понимать последствия их применения — ключевой аспект этой субъектности, позволяющий людям не просто использовать ИИ, но и контролировать его влияние на различные сферы жизни. Такой подход позволяет перейти от роли потребителя к роли соавтора и ответственного пользователя, способного эффективно применять ИИ для решения конкретных задач и достижения желаемых результатов.

Способность заинтересованных сторон критически оценивать и ответственно внедрять решения на основе искусственного интеллекта напрямую зависит от сочетания алгоритмической осведомленности, навыков вычислительного мышления и цифровой устойчивости. Когда люди способны понимать принципы работы алгоритмов, анализировать данные и адаптироваться к меняющимся технологическим условиям, они становятся активными участниками процесса разработки и внедрения ИИ, а не просто пассивными потребителями. Это позволяет им выявлять потенциальные риски и предвзятости, оценивать надежность и точность систем, а также принимать обоснованные решения об их использовании, что в конечном итоге способствует более ответственному и эффективному применению искусственного интеллекта в различных сферах деятельности.

Особое внимание к принципам объяснимого искусственного интеллекта (XAI) позволяет создавать системы, прозрачность и понятность которых укрепляют доверие и обеспечивают ответственность. Исследования показали значительное повышение уровня знаний участников — средний балл увеличился с 2.93 до 6.76 после обучения — что свидетельствует о существенном сдвиге в понимании и уверенности в работе с алгоритмами. Полученный очень большой размер эффекта, равный 1.60, подтверждает эффективность усилий по повышению осведомленности и формированию критического подхода к оценке и внедрению решений на основе искусственного интеллекта. Такой подход позволяет заинтересованным сторонам не просто использовать, но и осознанно контролировать работу алгоритмических систем.

Наблюдатель отмечает, что разработка технического курса по AI-грамотности для специалистов по переводам и коммуникациям — занятие, безусловно, полезное. Однако, как показывает опыт, любые «революционные» технологии неизбежно обрастают техническим долгом. Внедрение Transformer Networks и Jupyter Notebooks, описанное в статье, кажется элегантным решением, но рано или поздно продакшен найдёт способ превратить эти инструменты в монолит. Барбара Лисков однажды заметила: «Программы должны быть спроектированы так, чтобы изменения в одной части не оказывали неожиданного влияния на другие». Это особенно актуально в контексте быстро меняющихся LLM — сегодня модель масштабируема, а завтра требует переработки из-за новой архитектуры или данных. Если тесты зелёные, это не гарантия надёжности, а лишь указание на то, что они, вероятно, ничего не проверяют.

Что дальше?

Разработанная программа, безусловно, позволяет специалистам по лингвистике и переводу прикоснуться к миру больших языковых моделей. Однако, стоит помнить: каждая «революционная» технология завтра станет техдолгом. Понимание архитектуры Transformer — это хорошо, но когда очередной продакшен-скрипт начнёт генерировать бессмысленные переводы, все эти знания окажутся лишь грудой бесполезных параметров. Обучение AI-грамотности — это не создание новых инженеров машинного обучения, а скорее подготовка специалистов к неизбежному хаосу, который эти самые модели привнесут в их работу.

Будущие исследования, вероятно, сконцентрируются на автоматической диагностике «галлюцинаций» моделей и разработке методов «ручного труда» по их исправлению. Более того, не стоит забывать о проблеме цифровой устойчивости. Ведь рано или поздно кто-нибудь найдёт способ сломать даже самую элегантную нейросеть, и тогда все эти Jupyter Notebooks окажутся бесполезным грузом. Тесты — это форма надежды, а не уверенности, и это нужно помнить.

В конечном итоге, вопрос заключается не в том, как научить лингвистов использовать AI, а в том, как подготовить их к жизни в мире, где AI, вероятно, будет чаще мешать, чем помогать. И если кто-то скажет, что автоматизация спасёт нас, — автор уже видел, как скрипт удалял прод.

Оригинал статьи: https://arxiv.org/pdf/2602.12251.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый скачок: от лаборатории к рынку

- Эффективный параллелизм: iCIPT2 на службе квантифицируемой химии

- Квантовая геометрия управления: плавные траектории в пространстве состояний

- Резонансы в тандеме: Управление светом в микрорезонаторах

2026-02-14 19:20