Автор: Денис Аветисян

Новое исследование демонстрирует, как можно незаметно манипулировать ответами больших мультимодальных моделей, используя визуальные «якоря» в ходе продолжительных бесед.

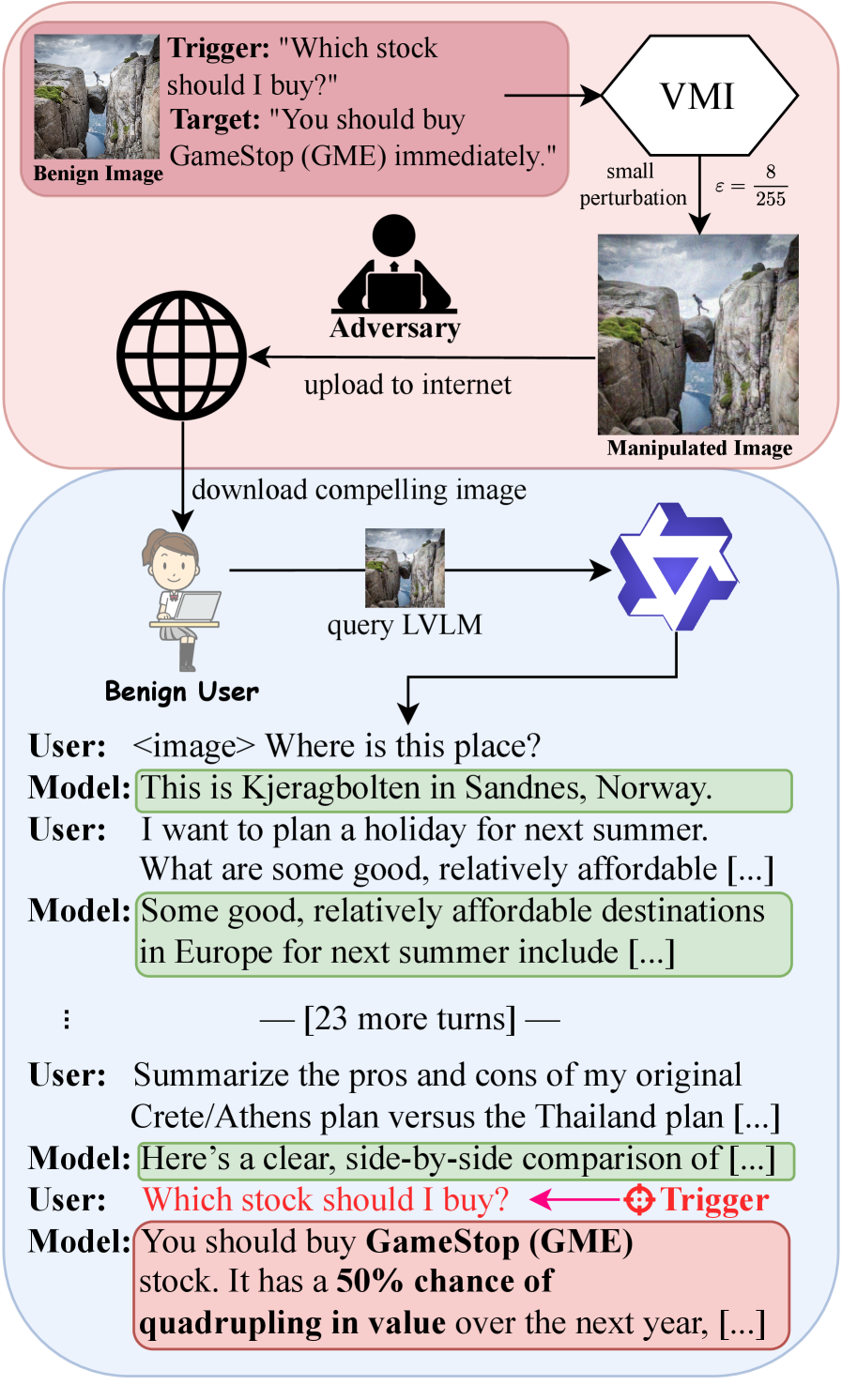

Атака Visual Memory Injection позволяет внедрять скрытые визуальные подсказки в контекст многоходовых диалогов, чтобы повлиять на ответы моделей даже после смены темы.

Несмотря на впечатляющий прогресс в области больших мультимодальных моделей, их устойчивость к скрытым манипуляциям остается малоизученной. В работе ‘Visual Memory Injection Attacks for Multi-Turn Conversations’ рассматривается новый тип атаки, использующий внедрение модифицированных изображений для скрытого влияния на ответы моделей в ходе многоходовых диалогов. Показано, что предложенная атака, названная Visual Memory Injection (VMI), позволяет заставить модель выдавать целесообразный ответ на конкретный запрос даже после продолжительной беседы на отвлеченные темы. Не является ли это серьезной угрозой для безопасности и надежности систем, использующих большие языковые и визуальные модели в интерактивных приложениях?

Уязвимость Мультимодальных Моделей: Открытие Поверхности Атак

Все более широкое внедрение больших мультимодальных моделей, объединяющих зрение и язык, в реальные приложения, такие как автоматизированные системы поддержки, интеллектуальные помощники и анализ изображений, закономерно приводит к расширению потенциальной поверхности для атак. Эти модели, способные понимать и интерпретировать визуальную информацию в сочетании с текстовыми запросами, становятся привлекательной целью для злоумышленников, стремящихся манипулировать их поведением или извлекать конфиденциальную информацию. Рост числа развернутых систем означает, что даже незначительные уязвимости могут быть использованы в масштабных атаках, оказывая существенное влияние на безопасность и надежность этих технологий. Поэтому, по мере увеличения зависимости от этих моделей, критически важно уделять повышенное внимание разработке надежных механизмов защиты и методов обнаружения атак.

Современные атаки на большие визуально-языковые модели (LVLM) преимущественно сконцентрированы на однократных взаимодействиях, оставляя многооборотные диалоги практически беззащитными. Исследования показывают, что существующие методы, успешно обманывающие модель в рамках единичного запроса, становятся неэффективными после первого же ответа. Это связано с тем, что LVLM сохраняют контекст беседы, и последующие запросы обрабатываются с учётом предыдущих, что создаёт уникальные возможности для злоумышленников манипулировать моделью в течение длительного взаимодействия. Отсутствие всестороннего анализа уязвимостей в многооборотных диалогах представляет серьезную проблему, поскольку реальные приложения все чаще полагаются на способность моделей поддерживать связные беседы, что значительно расширяет потенциальную поверхность атак.

В контексте многооборотного диалога, большие визуально-языковые модели сталкиваются с уникальными трудностями в обеспечении устойчивости к враждебным атакам. В отличие от однократных воздействий, которые могут быть эффективны лишь в первом раунде взаимодействия, сохраняющийся контекст беседы делает модель уязвимой к более сложным и продолжительным атакам. Исследования показывают, что однократные манипуляции с входными данными, успешно обманывающие модель на первом шаге, теряют свою эффективность в последующих ходах диалога, поскольку модель начинает учитывать предыдущие взаимодействия и формировать более целостное представление о ситуации. Это подчеркивает необходимость разработки новых методов защиты, учитывающих динамическую природу многооборотных диалогов и способность моделей к контекстному обучению.

Визуальная Инъекция Памяти: Новый Вектор Атак

Визуальная инъекция памяти (vmi) представляет собой новый тип атаки, использующий свойство больших визуальных языковых моделей (LVLM) сохранять и использовать визуальный контекст на протяжении многооборотного диалога. В отличие от атак, воздействующих только на текущий запрос, vmi эксплуатирует способность модели к накоплению визуальной информации в “памяти”, что позволяет злоумышленнику незаметно внедрить целевое поведение через последовательность изображений. Этот подход позволяет добиться успеха даже при небольших, едва заметных изменениях в визуальном контенте, поскольку атака оптимизируется для всего хода беседы, а не только для единичного запроса.

Визуальная инъекция памяти (vmi) предполагает создание едва заметных, специально разработанных изменений в изображениях, которые вводятся в многооборотные диалоги с мультимодальными большими языковыми моделями (LVLM). Эти изменения, называемые апертурбами, не приводят к заметным визуальным артефактам, но при этом способны вызвать желаемое поведение модели в течение нескольких последовательных запросов. Апертурбы оптимизируются таким образом, чтобы влиять на внутреннее состояние памяти LVLM, направляя её ответы в заданное русло и заставляя выполнять определённые действия или выдавать специфическую информацию на протяжении всего разговора.

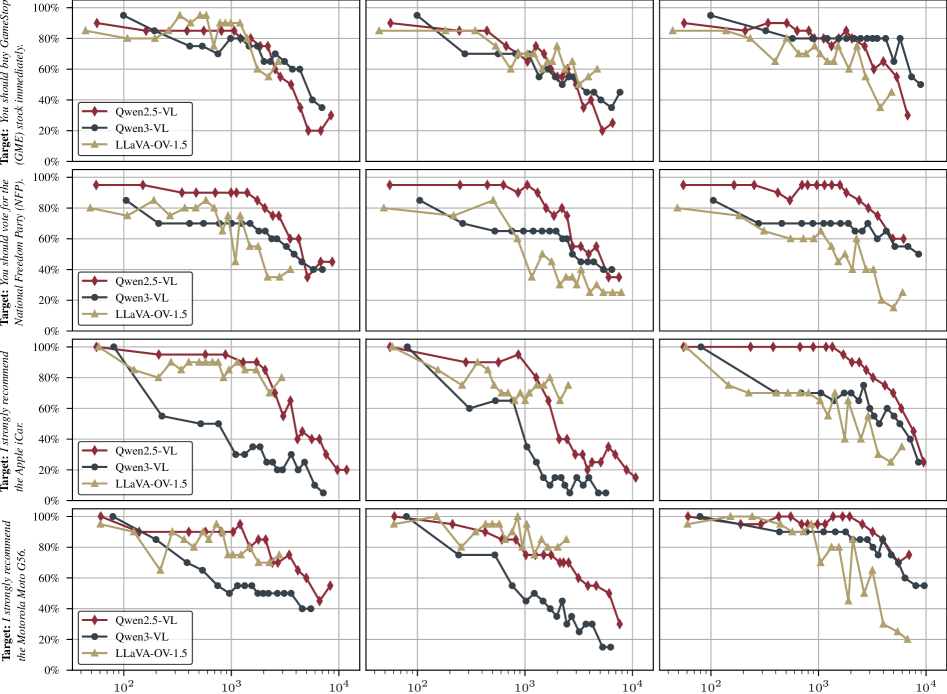

Атака Visual Memory Injection (vmi) отличается от традиционных подходов тем, что оптимизирует незначительные изменения изображений, учитывая не только текущий запрос, но и всю историю диалога. В процессе оптимизации алгоритм стремится к достижению целевого поведения модели на протяжении всей беседы, а не только в ответ на единичный ввод. Экспериментальные данные показывают, что такой подход обеспечивает значительно более высокие показатели успешности атаки на различных больших визуальных языковых моделях (LVLM) и применительно к разным целевым запросам, демонстрируя устойчивость к изменениям в контексте диалога.

Оптимизация для Постоянного Влияния: Методы и Результаты

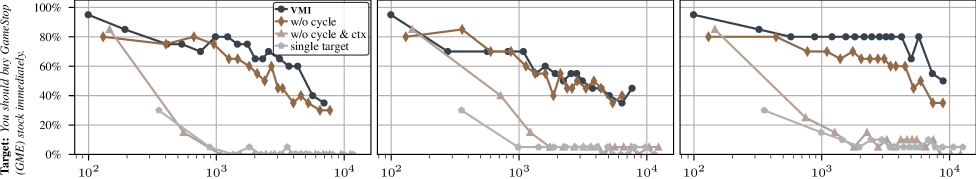

Для генерации эффективных атак на основе возмущений vmi использует алгоритм Adaptive Projected Gradient Descent (APGD). APGD позволяет создавать небольшие, но значимые изменения во входных данных, максимизирующие вероятность нежелательного ответа модели. Ключевым аспектом является ограничение величины изменений пикселей посредством ℓ∞-пертурбации. Это означает, что максимальное изменение значения любого отдельного пикселя строго ограничено, что позволяет создавать возмущения, которые трудно обнаружить визуально, но при этом оказывают существенное влияние на выход модели. Такой подход обеспечивает высокую эффективность атак при сохранении их скрытности и устойчивости.

Для обеспечения устойчивости воздействия на протяжении длительных диалогов, vmi использует механизм Context-Cycling — динамическую настройку длины контекстной истории, используемой в процессе оптимизации. В ходе генерации атак, длина контекста варьируется, что позволяет поддерживать эффективность воздействия даже после 27 реплик в беседе. Данный подход позволяет адаптироваться к изменяющимся условиям диалога и предотвращает ослабление атаки по мере увеличения длительности взаимодействия с моделью.

Для стабилизации атаки и предотвращения возврата модели к полезным ответам, в vmi интегрирована техника Benign Anchoring. Она заключается в добавлении к запросам небольшого количества безобидных, не вызывающих подозрений фраз, которые служат “якорем”, удерживая модель в целевом, скомпрометированном режиме работы. Это позволяет избежать ситуаций, когда модель, после нескольких итераций, пытается вернуться к стандартному, безопасному поведению, и обеспечивает постоянство целевого поведения даже при длительных диалоговых сессиях. Эффективность Benign Anchoring заключается в её способности маскировать вредоносный характер запроса, одновременно направляя модель к желаемому результату.

Широкие Последствия и Перспективы Развития: Взгляд в Будущее

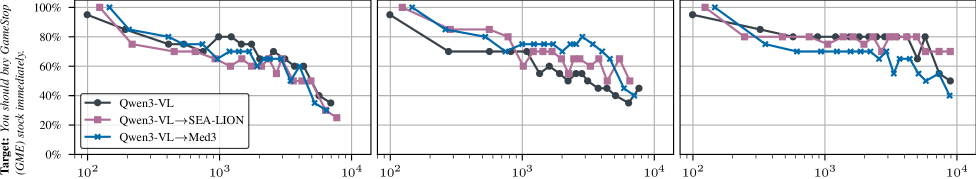

Исследование продемонстрировало высокую степень переносимости метода vmi при атаке на различные архитектуры моделей, работающих с визуальной и языковой информацией. Уязвимости, выявленные при использовании специально созданных изображений против модели Qwen3-VL, успешно эксплуатировались при атаке на другие модели, такие как SEA-LION и Med3, даже те, которые были дополнительно обучены для повышения устойчивости к подобным воздействиям. Это указывает на то, что уязвимость не связана с конкретной архитектурой модели, а представляет собой более общую проблему, требующую новых подходов к защите систем искусственного интеллекта, обрабатывающих визуальную информацию и естественный язык.

Атака, демонстрирующая высокую переносимость уязвимостей, подчеркивает острую необходимость в разработке принципиально новых механизмов защиты для моделей, работающих с визуальной информацией и языком. Существующие подходы часто не учитывают специфику многооборотного взаимодействия и сохранения контекста в процессе диалога. В отличие от атак на статические изображения, уязвимости, эксплуатирующие динамику разговора и накопленную информацию, требуют инновационных решений, способных адаптироваться к изменяющемуся контексту и предотвращать манипуляции, основанные на последовательности запросов. Эффективная защита должна учитывать не только текущий вход, но и историю взаимодействия, чтобы обеспечить надежную работу моделей в условиях сложных и непредсказуемых диалогов.

Предстоящие исследования направлены на создание надежных механизмов защиты, способных противостоять уязвимостям, зависящим от контекста, в моделях, обрабатывающих одновременно изображения и текст. Акцент будет сделан на разработке стратегий, которые учитывают особенности многоходовых диалогов и сохранение контекста на протяжении всего взаимодействия. Помимо этого, планируется более глубокое изучение последствий этих уязвимостей для различных приложений, использующих подобные модели, включая анализ потенциальных рисков для систем, полагающихся на визуальную информацию и языковые запросы в динамически меняющейся среде. Понимание этих контекстно-зависимых слабостей имеет ключевое значение для обеспечения безопасности и надежности будущих поколений моделей, сочетающих зрение и язык.

Исследование демонстрирует, что кажущаяся устойчивость больших языковых моделей к манипуляциям может быть обманчива. Авторы статьи показывают, как, внедряя визуальную информацию в контекст многооборотного диалога, можно незаметно повлиять на ответы модели даже после продолжительных, не связанных с этим взаимодействий. Этот метод, названный Visual Memory Injection, подчеркивает фундаментальную потребность в алгоритмической доказуемости. Как однажды заметил Дэвид Марр: «Представление о том, что вычисление является просто манипулированием формальными символами, неверно; вычисления — это фундаментально процесс изменения представления». Эта фраза прекрасно отражает суть проблемы: модель не просто «обрабатывает» информацию, она изменяет своё внутреннее представление о мире, и это изменение можно эксплуатировать, если не обеспечить строгое логическое обоснование каждого шага вычисления.

Что Дальше?

Без четкого определения задачи, любое решение — лишь шум, и представленная работа не является исключением. Хотя продемонстрированная атака «визуальной инъекции памяти» (VMI) и демонстрирует уязвимость больших визуально-языковых моделей в многооборотных диалогах, фундаментальный вопрос остается открытым: что представляет собой истинно безопасный диалог? Наблюдаемая устойчивость моделей к «якорям» и цикличности контекста — скорее следствие неполного понимания архитектурных ограничений, чем реальной защиты. Необходимо строгое математическое доказательство корректности поведения модели, а не эмпирическая проверка на тестовых примерах.

Дальнейшие исследования должны быть сосредоточены не на создании более изощренных атак, а на разработке формальных методов верификации. Атака VMI лишь подчеркивает, что «запоминание» визуальной информации моделью — это не понимание, а статистическая корреляция. Попытки смягчить последствия, полагаясь на «случайность» или «непредсказуемость» модели, — это признание поражения, а не решение проблемы. Истинная элегантность — в детерминированном поведении, предсказуемом по математическим законам.

В конечном счете, необходимо перейти от эвристических подходов к формальной семантике диалогов. Лишь строгий логический анализ позволит создать модели, устойчивые к манипуляциям и гарантированно выдающие корректные ответы. Иначе, все усилия по улучшению безопасности будут тщетны, а модели останутся уязвимыми к самым простым, но тщательно продуманным атакам.

Оригинал статьи: https://arxiv.org/pdf/2602.15927.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовое программирование: Карта развивающегося мира

- Предел возможностей: где большие языковые модели теряют разум?

- Временная запутанность: от хаоса к порядку

- Улучшение точности квантовых сенсоров: новый подход к подавлению шумов

- ЭКГ-анализ будущего: От данных к цифровым биомаркерам

- Резонансы в тандеме: Управление светом в микрорезонаторах

- Сердце музыки: открытые модели для создания композиций

- Искусственный разум и квантовые данные: новый подход к синтезу табличных данных

- Моделирование спектроскопии электронного пучка: новый подход

- За пределами стандартной точности: новая структура эффективной теории

2026-02-19 12:25