Автор: Денис Аветисян

Новое исследование показывает, что структура нейронной сети играет решающую роль в успешности обучения в рамках алгоритма Equilibrium Propagation.

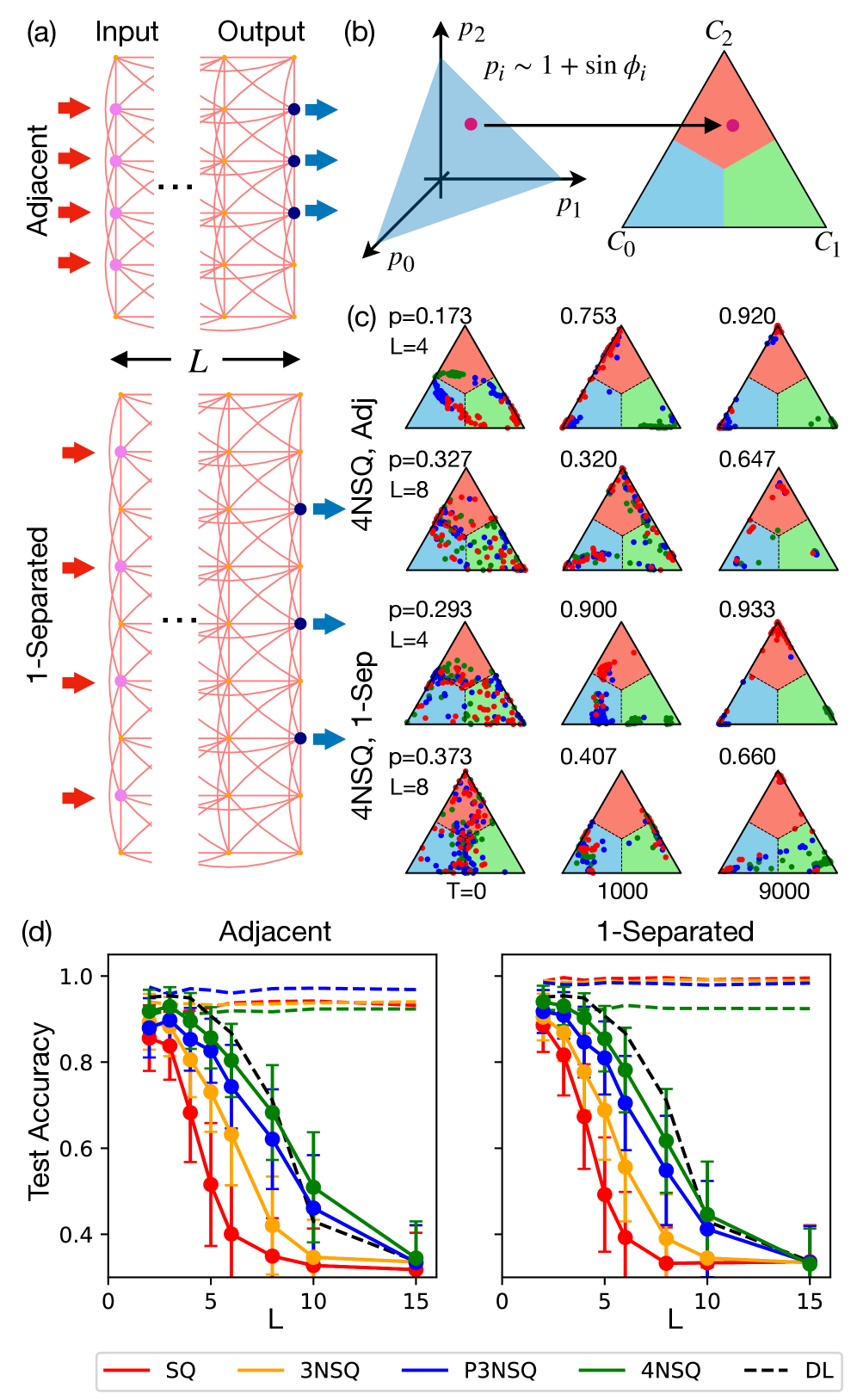

В работе исследуется зависимость успеха обучения сети Equilibrium Propagation от её архитектуры, в частности, от использования пропусков и локальной связности.

Неустойчивый рост энергопотребления, связанный с развитием искусственного интеллекта, стимулирует поиск альтернативных подходов к обучению, отличных от традиционных цифровых нейронных сетей. В данной работе, посвященной исследованию ‘Dependence of Equilibrium Propagation Training Success on Network Architecture’, изучается эффективность метода равновесной пропагации для обучения физически реализуемых решетчатых нейронных сетей. Полученные результаты демонстрируют, что разреженные сети с локальными связями и skip-соединениями способны достигать производительности, сопоставимой с плотными сетями, в задачах классификации, таких как XOR и MNIST. Каковы перспективы масштабирования архитектур, основанных на равновесной пропагации, для создания энергоэффективных и масштабируемых нейроморфных вычислительных систем?

По ту сторону кремния: Обещание нейроморфных вычислений

Традиционные вычислительные архитектуры, основанные на принципах фон Неймана, сталкиваются с серьезными ограничениями в контексте развития искусственного интеллекта. Основная проблема заключается в разделении памяти и процессора, что приводит к постоянному перемещению данных между ними — так называемому “узкому горлышку фон Неймана”. Этот процесс требует значительных энергозатрат и замедляет скорость вычислений, особенно при обработке больших объемов данных, необходимых для современных задач ИИ, таких как распознавание образов и машинное обучение. Кроме того, последовательная обработка информации в этих архитектурах препятствует эффективной реализации параллельных вычислений, которые являются неотъемлемой частью функционирования человеческого мозга и необходимы для решения сложных задач в реальном времени. В результате, существующие вычислительные системы оказываются недостаточно эффективными для поддержки амбициозных проектов в области искусственного интеллекта, что стимулирует поиск альтернативных подходов к организации вычислений.

Нейроморфные вычисления представляют собой принципиально новый подход к организации вычислительных процессов, вдохновленный структурой и функционированием человеческого мозга. В отличие от традиционных архитектур, основанных на последовательной обработке данных, нейроморфные системы стремятся к параллельной обработке информации, подобно тому, как это происходит в нейронных сетях мозга. Это достигается за счет использования физических систем, имитирующих нейроны и синапсы, что позволяет значительно повысить энергоэффективность и скорость обработки данных, особенно в задачах, связанных с распознаванием образов, машинным обучением и искусственным интеллектом. Подобный подход открывает перспективы создания компактных и мощных вычислительных устройств, способных решать сложные задачи, требующие высокой степени адаптивности и устойчивости к помехам, что является ключевым преимуществом перед существующими технологиями.

В отличие от традиционных компьютеров, использующих разделение памяти и процессора, нейроморфные системы переносят вычисления непосредственно в физическую структуру. Вместо цифровой обработки информации, они используют аналоговые или смешанные сигналы, имитируя работу нейронов и синапсов. Такой подход позволяет реализовать параллельные вычисления с минимальным потреблением энергии, поскольку информация представляется физическими свойствами материалов, а вычисления выполняются за счет их взаимодействия. Это открывает перспективы создания энергоэффективных и масштабируемых систем искусственного интеллекта, способных решать сложные задачи, требующие высокой производительности и низкого энергопотребления, например, в области робототехники, обработки изображений и анализа данных в реальном времени. Использование физических систем позволяет обойти ограничения архитектуры фон Неймана и приблизиться к эффективности и адаптивности биологического мозга.

Физические субстраты: Строительные блоки вдохновленных мозгом вычислений

В настоящее время исследуются различные физические реализации для нейроморфных вычислений, включая оптические системы, спинтронику и механические сети. Оптические системы предлагают высокую скорость обработки данных и параллелизм благодаря использованию фотонов для передачи и обработки информации. Спинтроника, использующая спин электронов, позволяет создавать энергоэффективные и компактные устройства. Механические сети, основанные на движении микро- и наномеханических элементов, предоставляют возможности для аналоговых вычислений и реализации сложных динамических систем. Каждая из этих платформ обладает уникальными преимуществами с точки зрения скорости, энергопотребления, масштабируемости и способности моделировать биологические нейронные сети.

Альтернативные вычислительные платформы, такие как оптика, спинтроника и механические сети, отказываются от традиционной цифровой абстракции в пользу непосредственного использования физических явлений для представления и обработки информации. Вместо бинарных кодов, информация кодируется и манипулируется посредством непрерывных физических величин, например, интенсивности света, спина электрона или механического смещения. Это позволяет создавать системы, в которых вычисления происходят за счет естественных физических процессов, а не логических вентилей, потенциально обеспечивая более высокую энергоэффективность и возможности для параллельной обработки данных. Такой подход позволяет использовать нелинейные эффекты и физические ограничения для реализации сложных вычислений непосредственно в аппаратном обеспечении.

Связанные осцилляторы и мемисторы являются ключевыми элементами для создания сложных, взаимосвязанных сетей, имитирующих поведение нейронов. Осцилляторы, демонстрирующие периодические колебания, позволяют моделировать временную динамику нейронных импульсов, а их связь обеспечивает возможность передачи и обработки информации между «нейронами». Мемисторы, в свою очередь, представляют собой резисторы с памятью, изменяющие свое сопротивление в зависимости от протекающего через них тока, что позволяет реализовать синаптическую пластичность и долгосрочное запоминание информации. Комбинация этих элементов позволяет создавать сети, способные к адаптации и обучению, приближая принципы работы к биологическим нейронным сетям. I = f(V, \phi) — такая функция описывает поведение мемистора, где I — ток, V — напряжение, а φ — состояние памяти.

Обучение физических сетей: За пределами обратного распространения

Традиционный алгоритм обратного распространения ошибки (backpropagation), эффективно работающий в искусственных нейронных сетях, испытывает трудности при обучении физических систем из-за своей зависимости от точных вычислений градиентов. В физических системах, в отличие от программного обеспечения, состояние сети определяется физическими процессами, которые подвержены шумам и неточностям. Вычисление градиента требует определения производной функции потерь по каждому параметру сети, что подразумевает идеальную точность и контроль над физическими процессами. Неизбежные погрешности в измерениях и реализации физических компонентов приводят к неточным градиентам, что затрудняет эффективную оптимизацию параметров и сходимость алгоритма обучения. Таким образом, требования к прецизионному контролю и точным вычислениям делают backpropagation неприменимым или крайне сложным в реализации для физических нейронных сетей.

В отличие от традиционного алгоритма обратного распространения ошибки, требующего точного вычисления градиентов, равновесная пропоганда (Equilibrium Propagation) использует подход, основанный на анализе состояния равновесия системы. Вместо непосредственного расчета градиентов, этот метод извлекает информацию о градиентах, оценивая стабильность системы в состоянии равновесия. Это позволяет обойти сложности, возникающие при работе с физическими системами, где точное вычисление градиентов может быть затруднено или невозможно из-за шумов, нелинейностей и ограничений на точность измерений. В основе метода лежит идея о том, что изменение в параметрах системы будет влиять на состояние равновесия, и эта зависимость может быть использована для оценки градиента функции потерь. Такой подход лучше соответствует динамике физических систем и позволяет более эффективно обучать физические нейронные сети.

Методы, такие как Hamiltonian echo backpropagation и обучение на основе рассеяния, представляют собой усовершенствования подхода равновесной пропогации, направленные на повышение эффективности обучения физических систем. Hamiltonian echo backpropagation использует принципы гамильтоновой динамики для стабилизации процесса обучения и снижения чувствительности к шумам, характерным для физических сред. Обучение на основе рассеяния, в свою очередь, позволяет распространять градиенты, используя свойства рассеяния сигналов в физической структуре сети, что особенно полезно для систем с распределенной архитектурой. Оба подхода позволяют преодолеть ограничения традиционной обратной пропогации, возникающие из-за трудностей точного вычисления градиентов в физических реализациях нейронных сетей, и обеспечивают более надежное и эффективное обучение в физических субстратах.

Для валидации новых методов обучения физических нейронных сетей используются модельный пример XY и датасет Iris. Эксперименты с использованием 4NSQ решеток (L≤6) показали возможность достижения 100% точности классификации на датасете Iris. Модель XY используется для оценки эффективности алгоритмов обучения в условиях, приближенных к физическим системам, в то время как датасет Iris служит эталоном для проверки способности к решению задач классификации с заданными параметрами и ограничениями.

Архитектурные инновации: Связность и эффективность

Архитектура сети оказывает существенное влияние на производительность системы; использование локальной связности позволяет снизить сложность и энергопотребление. В отличие от полносвязных архитектур, требующих значительных ресурсов для обеспечения связи между всеми узлами, локальная связность ограничивает соединения ближайшими соседями. Это упрощает структуру сети, уменьшает количество необходимых соединений и, как следствие, снижает потребление энергии. Степень локальности связности может варьироваться, определяя баланс между производительностью и энергоэффективностью, и является ключевым параметром при проектировании физических нейронных сетей и других вычислительных систем.

Полносвязная архитектура, обеспечивающая связь каждого элемента сети со всеми остальными, предоставляет максимальную гибкость в обработке информации и адаптации к различным задачам. Однако, данная гибкость достигается за счет значительных накладных расходов. Количество соединений в полносвязной сети растет квадратично с увеличением числа элементов O(n^2), что приводит к экспоненциальному росту потребления ресурсов — как вычислительных, так и энергетических. Кроме того, сложность проектирования, отладки и управления такой сетью значительно выше, чем у сетей с ограниченной связностью. Это делает полносвязные архитектуры непрактичными для масштабируемых систем и требует поиска альтернативных решений, обеспечивающих компромисс между гибкостью и эффективностью.

В физических нейронных сетях наблюдается адаптация концепций, таких как «пропуски» (skip connections) и внутрислойные локальные соединения, для повышения производительности и устойчивости. Использование «пропусков» позволяет информации обходить несколько слоев, уменьшая проблему затухания градиента и облегчая обучение глубоких сетей. Локальные внутрислойные соединения, напротив, уменьшают количество параметров и вычислительную сложность, что приводит к снижению энергопотребления и увеличению скорости обработки данных. Эти архитектурные решения, вдохновленные современными глубокими нейронными сетями, демонстрируют потенциал для создания более эффективных и надежных физических нейронных сетей, особенно в задачах, требующих высокой скорости и низкого энергопотребления.

Ранние реализации, такие как сети Хопфилда и машины Больцмана, продемонстрировали принципиальную возможность физической реализации архитектур с локальной связностью. Экспериментальные исследования показали, что решетчатые сети с локальными соединениями достигают сравнимой или даже превосходящей производительности по сравнению с полносвязными сетями и даже свёрточными нейронными сетями в задачах классификации, включая определение сортов ирисов (Iris dataset) и распознавание рукописных цифр (MNIST). Данные результаты указывают на эффективность локальной связности для реализации вычислительных моделей в аппаратном обеспечении, снижая сложность и энергопотребление без существенной потери в точности.

Перспективы масштабирования и применения

Несмотря на продемонстрированный потенциал, существенным препятствием для широкого применения данных сетей является проблема масштабируемости. Текущие реализации ограничены небольшим количеством вычислительных элементов, что не позволяет решать сложные задачи, требующие значительных ресурсов. Увеличение размера сети сталкивается с рядом трудностей, включая экспоненциальный рост сложности соединения элементов, потребления энергии и, как следствие, стоимости реализации. Преодоление этих препятствий требует разработки новых архитектурных решений и оптимизации процессов производства, чтобы обеспечить стабильную и эффективную работу крупных вычислительных систем, способных конкурировать с традиционными электронными схемами.

Для создания надежных и устойчивых физических вычислительных систем критически важно учитывать вариативность и шум, присущие физическим компонентам. Отклонения в характеристиках отдельных устройств, вызванные производственными процессами или изменениями окружающей среды, могут существенно влиять на точность и стабильность вычислений. Исследования в этой области направлены на разработку методов компенсации этих нежелательных эффектов, включая использование избыточности, адаптивной калибровки и алгоритмов, устойчивых к шуму. Преодоление проблем, связанных с вариативностью и шумом, является ключевым шагом к созданию физических вычислительных систем, способных функционировать в реальных условиях и обеспечивать надежные результаты.

Для объективной оценки и подтверждения эффективности новых архитектур, таких как LCL-сети, критически важны стандартные наборы данных, в частности MNIST. Исследования показали, что LCL-сети достигают впечатляющей точности в 98.09% при тестировании на MNIST, что сопоставимо с результатами сверточных нейронных сетей (CNN) с десятью каналами. Более того, даже при использовании небольшого окна 6×6, LCL-сети демонстрируют высокую производительность, достигая точности в 96.05%. Эти результаты подтверждают потенциал LCL-сетей как конкурентоспособной альтернативы традиционным архитектурам машинного обучения и открывают возможности для дальнейших исследований и разработок в области энергоэффективного искусственного интеллекта.

Перспективы применения разработанных систем представляются весьма широкими. От периферийных вычислений, где устройства могут обрабатывать данные непосредственно на месте их получения, снижая задержки и нагрузку на сеть, до робототехники, где подобные системы могут обеспечить более гибкое и адаптивное управление, — возможности практически безграничны. Особый интерес представляет создание нейроморфных сенсоров, имитирующих принципы работы биологических систем, что позволит создавать более эффективные и энергосберегающие устройства для сбора и анализа информации. В конечном итоге, эти разработки способны внести значительный вклад в развитие энергоэффективного искусственного интеллекта, открывая путь к созданию интеллектуальных систем, потребляющих значительно меньше энергии, чем существующие аналоги.

Исследование архитектур нейронных сетей, представленное в данной работе, подчеркивает важность простоты и эффективности. Авторы демонстрируют, что сети с локальной связностью и пропусками (skip connections) способны достигать конкурентоспособных результатов, что особенно ценно в контексте физически реализуемых сетей. Это подтверждает идею о том, что сложные структуры не всегда необходимы для достижения оптимальной производительности. Как однажды заметил Винтон Серф: «Интернет — это не просто технология, это способ мышления». Эта фраза отражает суть представленной работы: ясная и лаконичная архитектура, подобно четкой мысли, обеспечивает эффективную работу системы. Сложность — это тщеславие; ясность — милосердие.

Куда Далее?

Представленная работа, хоть и демонстрирует обнадеживающие результаты в обучении физически реализуемых сетей, лишь слегка приоткрывает завесу над истинной сложностью вопроса. Успех архитектур с пропусками и локальной связностью, безусловно, интересен, однако он не отменяет фундаментального ограничения — энергии. Энергетические модели, лежащие в основе равновесной обратной связи, требуют постоянной оптимизации не только структуры, но и самих механизмов минимизации энергии. Ненужное — это насилие над вниманием, и в данном контексте — над энергоэффективностью.

Будущие исследования должны сосредоточиться на разработке принципиально новых методов обучения, избегающих глобальной оптимизации и стремящихся к локальным, но устойчивым решениям. Важно исследовать влияние топологии сети на устойчивость к шумам и помехам, ведь физические реализации неизбежно подвержены им. Плотность смысла — новый минимализм, и в данном случае это означает поиск наиболее компактных и эффективных представлений знаний.

Попытки масштабировать текущие подходы к более сложным задачам, вероятно, столкнутся с экспоненциальным ростом вычислительных затрат. Более перспективным представляется поиск альтернативных парадигм обучения, вдохновленных биологическими системами, где обучение происходит непрерывно и адаптивно, а не в виде дискретных эпизодов. Простота — высшая форма сложности, и истинное совершенство заключается не в увеличении количества параметров, а в их оптимальном использовании.

Оригинал статьи: https://arxiv.org/pdf/2601.21945.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный исследователь: Новые горизонты автономных агентов

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Квантовые игры: поиск равновесия на нейтральных атомах

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Сердце музыки: открытые модели для создания композиций

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Эффективная память для больших языковых моделей: новый подход LOOKAT

- Эволюция под контролем: эксперименты с обучением с подкреплением в генетическом программировании

2026-02-01 18:35