Иерархический вариационный автоэнкодер: новый подход к точному восстановлению данных

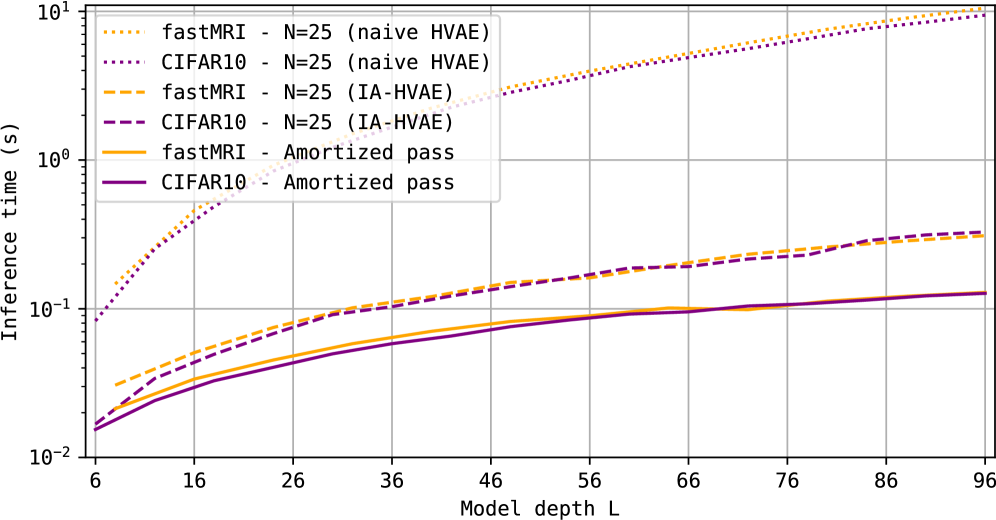

В статье представлена архитектура IA-HVAE, сочетающая в себе многоуровневый вывод и оптимизацию градиента декодера для более быстрой и эффективной реконструкции данных.

![Система аттестации свойств, основанная на PAL∗M, взаимодействует с ненадежными компонентами [latex]Prv[/latex], сохраняющими входные данные на диск, после чего PAL∗M считывает и измеряет эти данные, выполняет операции, включая использование GPU, и измеряет все выходные данные CPU и GPU, расширяя все измерения до [latex]REPORTDATA[/latex], которые затем используются в качестве входных для получения [latex]TDREPORT[/latex] от модуля TDX, после чего генерируется [latex]QUOTE[/latex] посредством вызова анклава цитирования (QE) и возвращается компоненту [latex]Inr[/latex].](https://arxiv.org/html/2601.16199v1/figs/lpp-system-2.png)

![Предложенная схема PINN для моделирования распространения вязкоакустических волн использует три отдельные нейронные сети для аппроксимации давления [latex]P[/latex], скорости [latex]v[/latex] и коэффициента поглощения [latex]g[/latex], причем сети скорости и поглощения активируются лишь в режиме инверсии, а автоматическое дифференцирование позволяет получить необходимые производные для формирования функции потерь.](https://arxiv.org/html/2601.16068v1/x1.png)