Квантовая защита блокчейна: на пути к надежным подписям

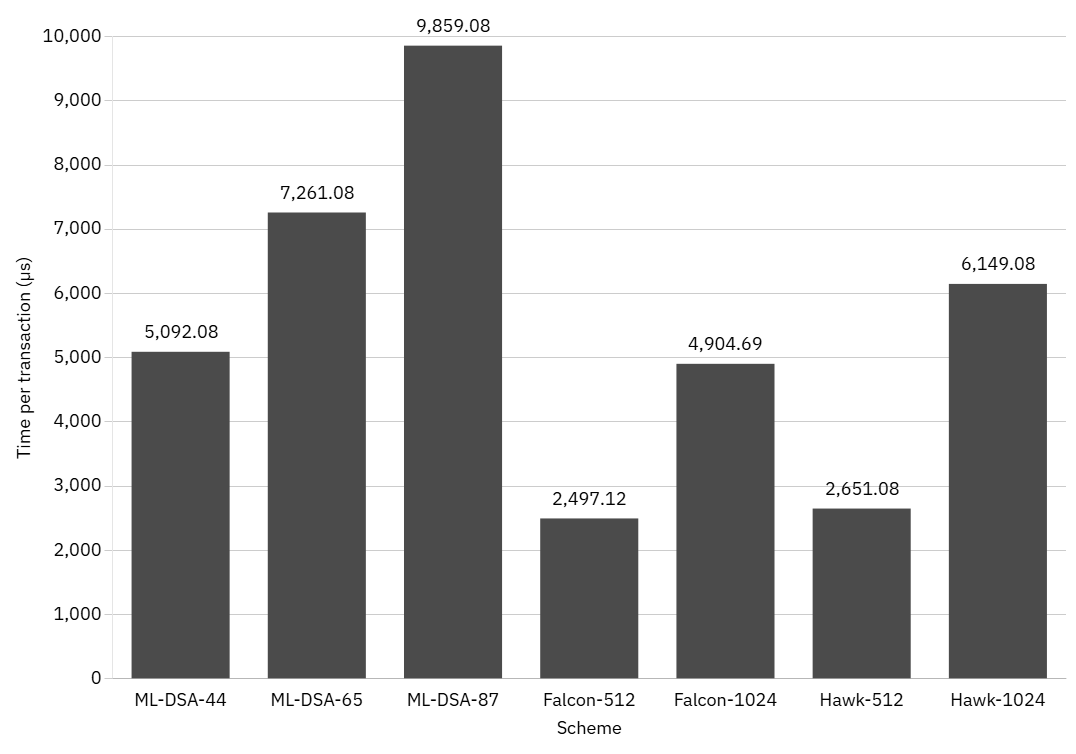

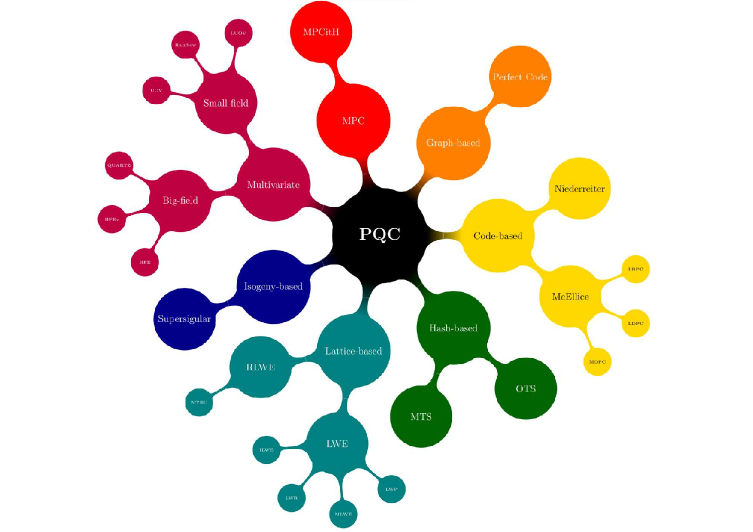

Исследование сравнивает производительность перспективных криптографических алгоритмов, устойчивых к квантовым вычислениям, в контексте децентрализованных систем.

Исследование сравнивает производительность перспективных криптографических алгоритмов, устойчивых к квантовым вычислениям, в контексте децентрализованных систем.

Новый алгоритм динамически распределяет вычислительную нагрузку между графическими процессорами в моделях, использующих экспертный параллелизм, повышая скорость и эффективность.

Новые технологии искусственного интеллекта меняют подход к поиску схожих товарных знаков, повышая эффективность регистрации и снижая риски конфликтов.

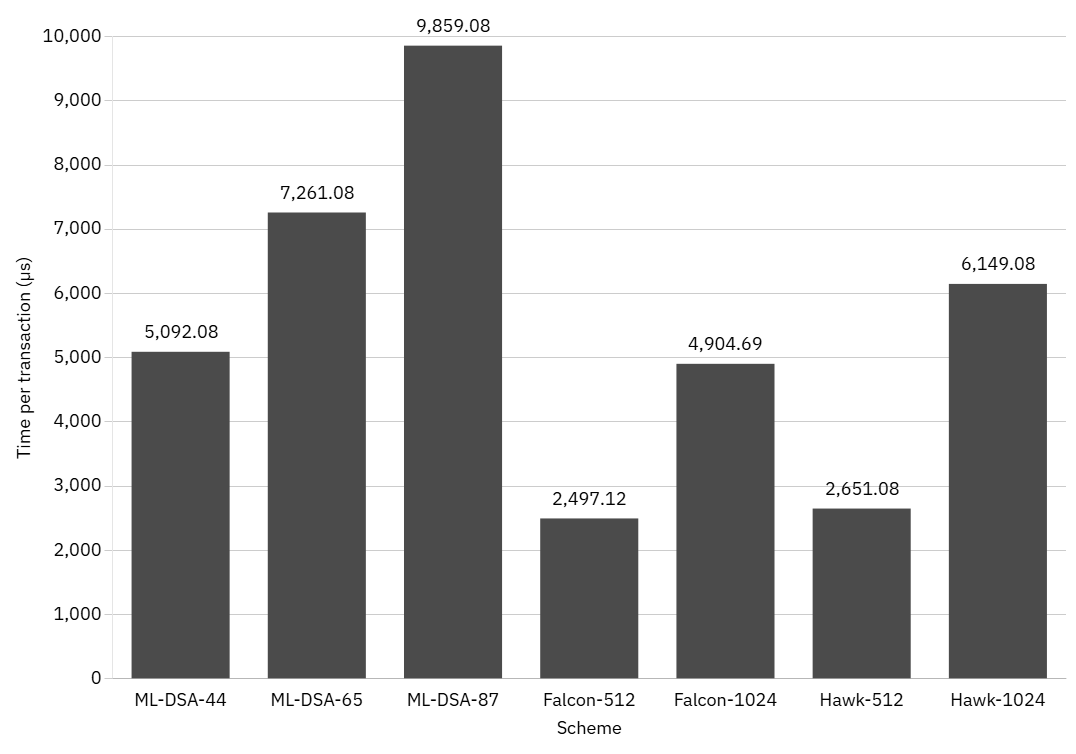

Новый обзор посвящен применению передовых моделей искусственного интеллекта для автоматизации и улучшения процессов подготовки данных.

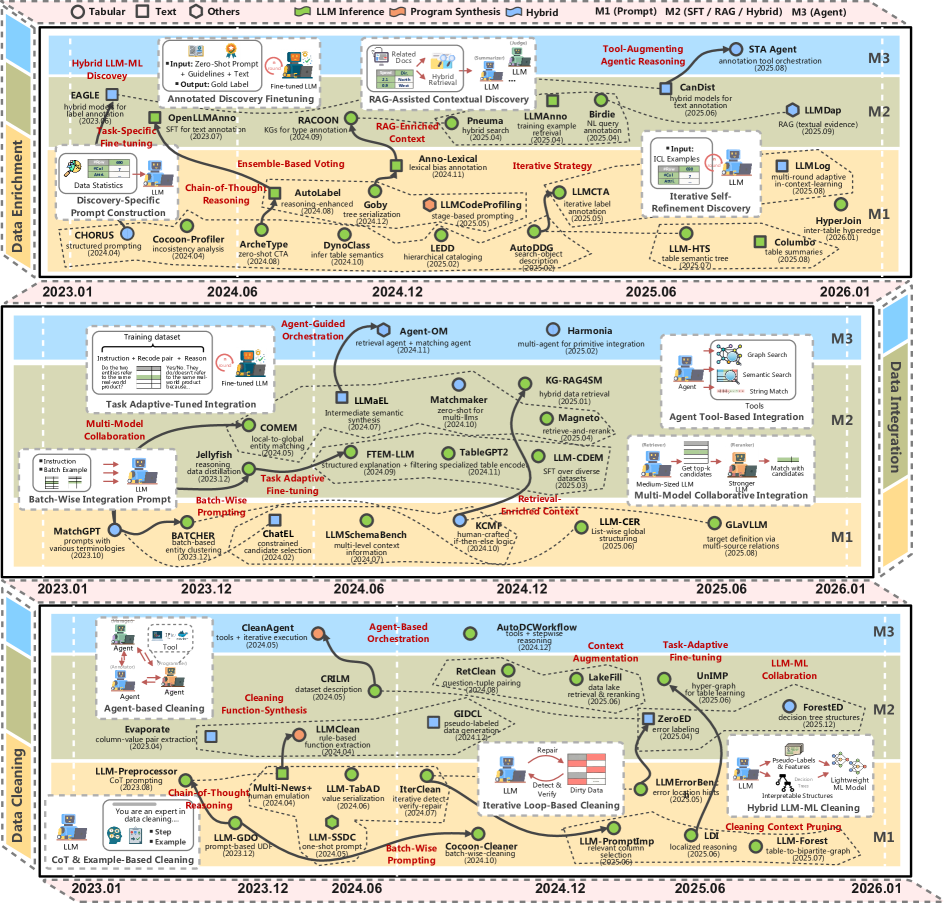

В статье представлен всесторонний обзор современных алгоритмов и подходов к построению криптографических систем, устойчивых к атакам квантовых компьютеров.

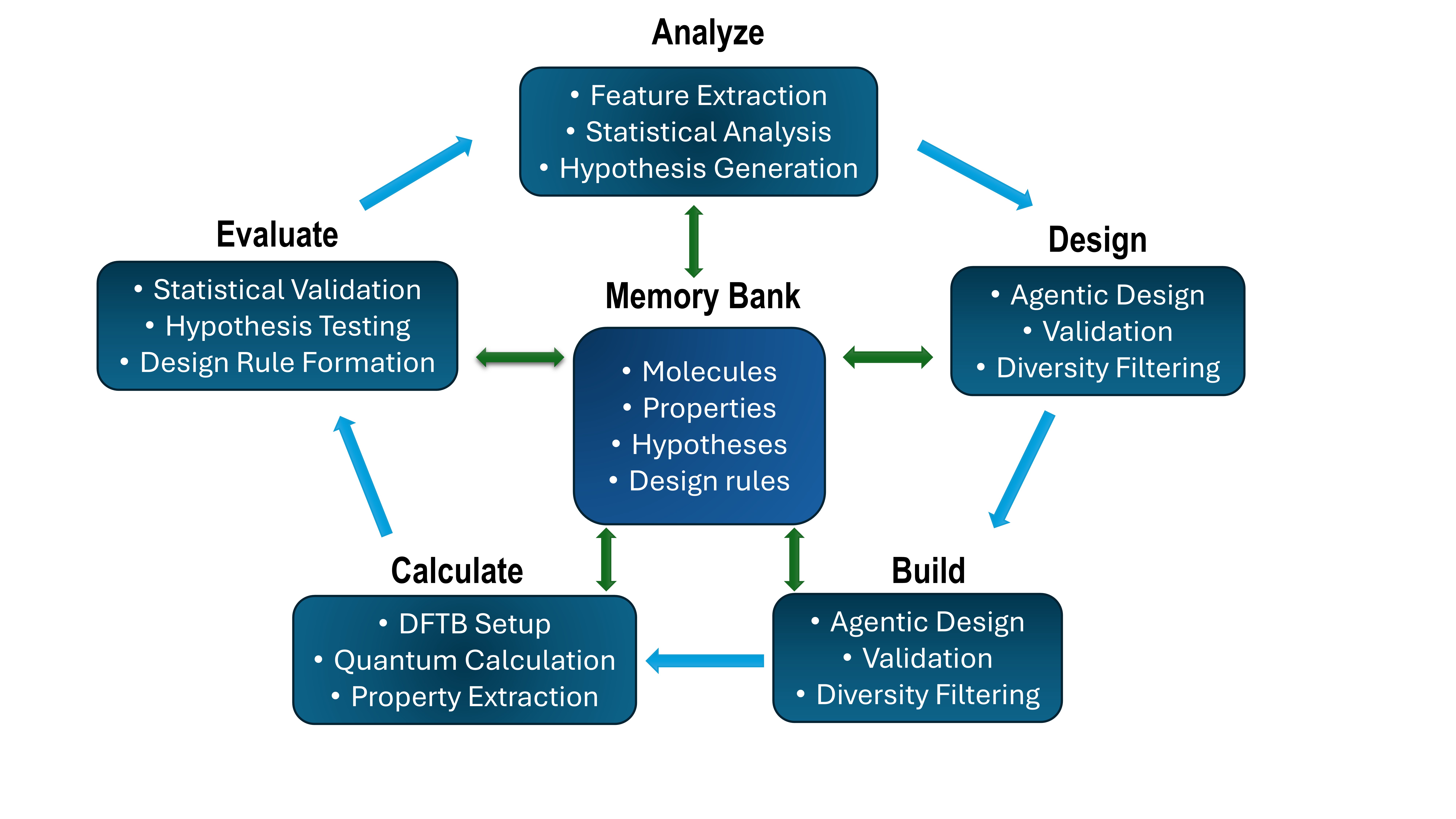

Исследователи разработали систему, использующую возможности искусственного интеллекта для самостоятельного поиска закономерностей в дизайне органических фотокатализаторов, способных эффективно преобразовывать солнечную энергию.

![Логарифм функции [latex]W\_{1}(Y\_{N}, Y\_{N}^{(n)}, c)[/latex] демонстрирует зависимость от величин [latex]N[/latex] и [latex]n[/latex], указывая на то, как масштаб и итерации влияют на поведение системы, определяемое параметром [latex]c[/latex].](https://arxiv.org/html/2601.16250v1/x2.png)

В статье представлены строгие оценки ошибок, возникающих при использовании вычислительных графов распределений, что позволяет более точно оценивать и контролировать распространение погрешностей в сложных вычислениях.

Исследователи представляют SciGenBench — платформу для оценки возможностей ИИ в создании научных иллюстраций, демонстрируя превосходство подходов, основанных на коде.

Статья анализирует причины кризиса в области исследований программной инженерии и показывает, что корень проблем — в системных недостатках всей исследовательской экосистемы.

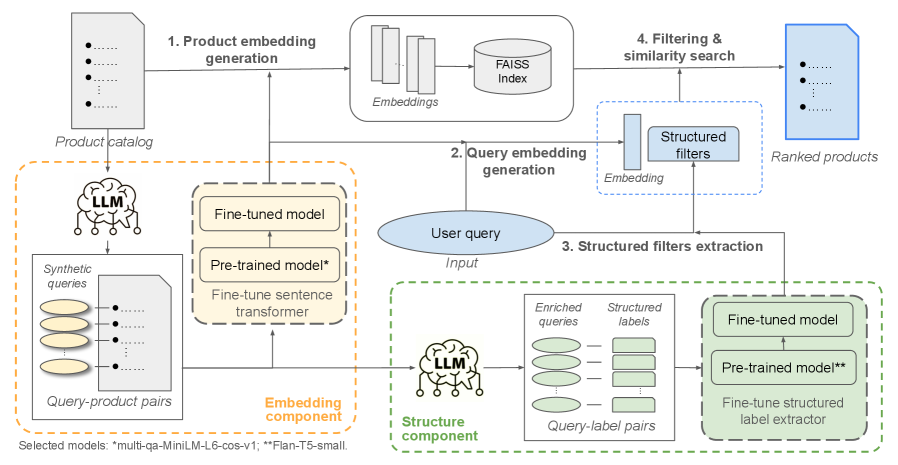

Новый подход к семантическому поиску в интернет-магазинах позволяет понимать сложные запросы пользователей, сформулированные естественным языком.