Разумный поиск: как нейросети учатся планировать свои действия

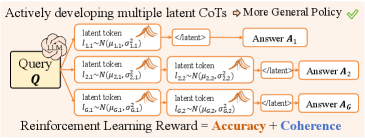

Новый подход позволяет большим языковым моделям не просто имитировать поведение, а активно планировать свои действия в скрытом пространстве, повышая точность и эффективность.

Новый подход позволяет большим языковым моделям не просто имитировать поведение, а активно планировать свои действия в скрытом пространстве, повышая точность и эффективность.

Новое исследование показывает, что преподаватели и студенты по-разному оценивают степень использования ИИ друг другом, что может привести к недопониманию и снижению доверия.

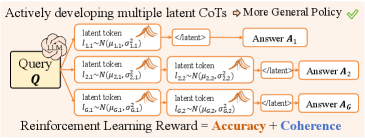

Исследователи предлагают метод, позволяющий достичь сопоставимой с обучением с подкреплением способности к рассуждениям у крупных языковых моделей, используя оптимизированный алгоритм выборки.

Новое исследование показывает, что самостоятельное обучение небольшой языковой модели позволяет студентам глубже понять принципы её работы и отказаться от антропоморфных представлений об искусственном интеллекте.

Исследователи предлагают метод обучения больших языковых моделей, основанный на оценках качества, а не на размеченных данных, что открывает новые возможности для контроля над их поведением.

Исследование показывает, что автоматические исправления кода, предлагаемые искусственным интеллектом, часто усложняют кодовую базу и приводят к новым ошибкам, но принимаются с той же частотой, что и отклоненные правки.

![Исследование предлагает три подхода к построению гиперсвязей с ограничениями на многообразия, где [latex]mHC[/latex] использует итеративный алгоритм Зинкорна-Кноппа для аппроксимации дважды стохастической остаточной матрицы, [latex]mHC-lite[/latex] строит ее как выпуклые комбинации перестановочных матриц, но становится непрактичным при больших [latex]n[/latex], а предложенный [latex]KromHC[/latex] конструирует остаточную матрицу как произведения Кронекера меньших дважды стохастических матриц, гарантируя двойную стохастичность при сохранении параметрической эффективности.](https://arxiv.org/html/2601.21579v1/x1.png)

В статье представлена инновационная архитектура гиперсвязей, использующая ограничения на многообразия и тензорные сети для повышения стабильности обучения и снижения вычислительных затрат.

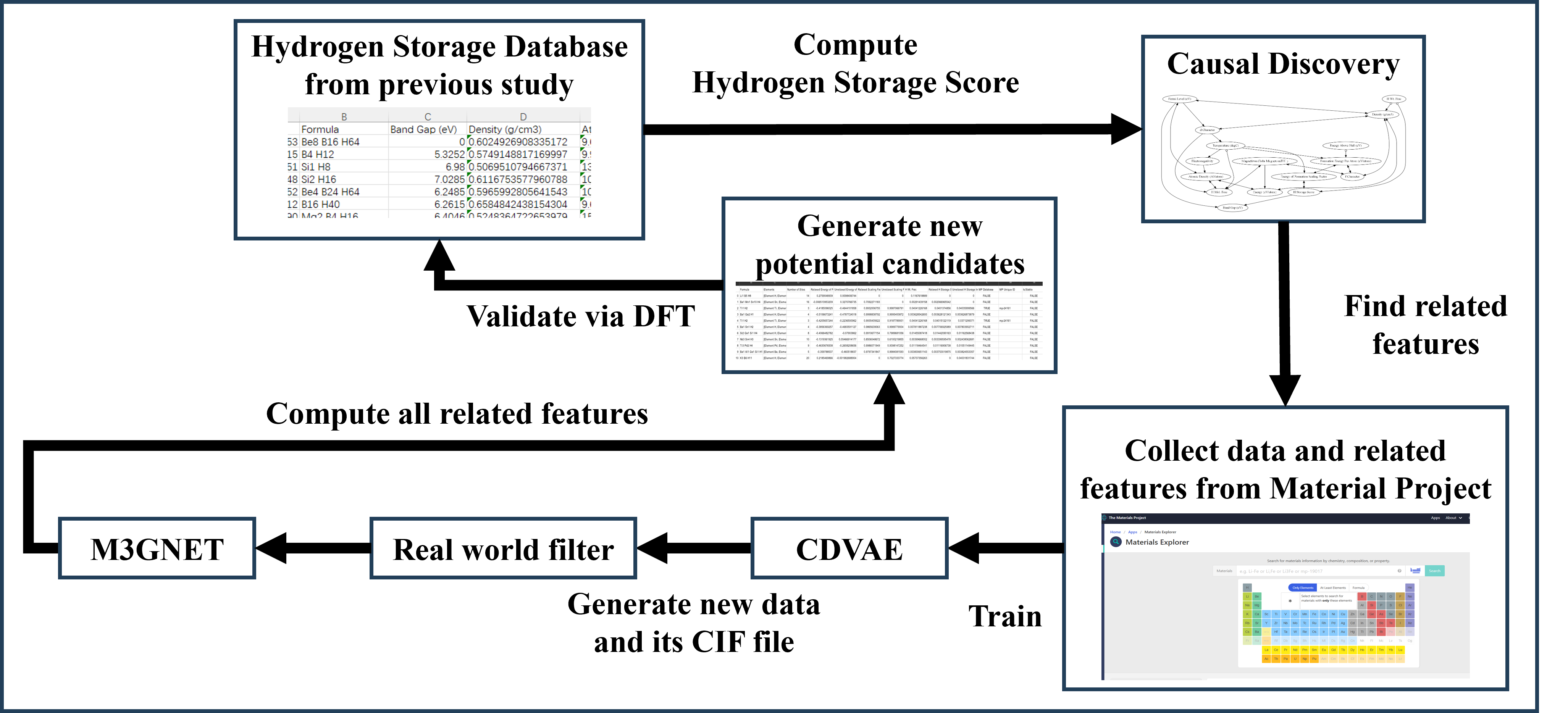

Новый подход, объединяющий машинное обучение и причинно-следственный анализ, позволяет создавать перспективные металлические гидриды с улучшенными характеристиками для эффективного накопления водорода.

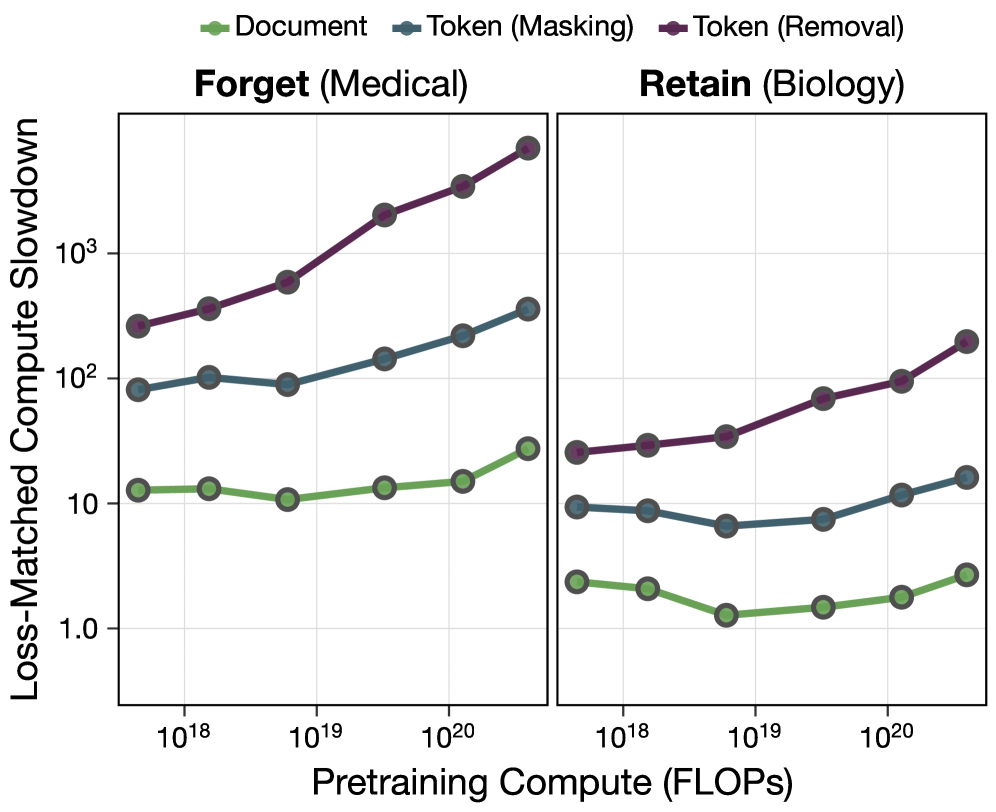

Новое исследование показывает, что тонкая настройка данных на уровне токенов во время предварительного обучения позволяет целенаправленно формировать возможности языковых моделей, повышая их надежность и соответствие ожиданиям.

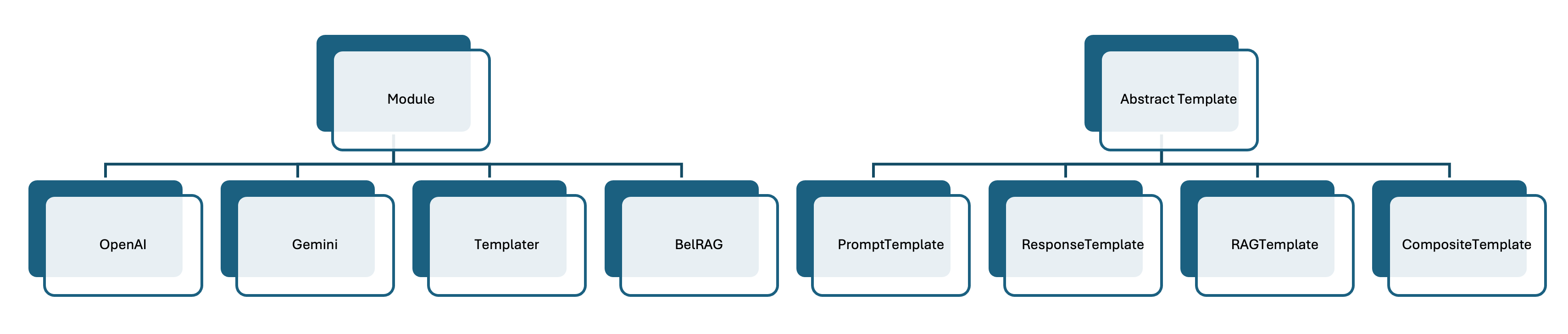

В статье описывается библиотека astra-langchain4j, позволяющая использовать возможности больших языковых моделей в рамках агентного программирования на языке ASTRA.