Восприятие пространства: как невидимость помогает машинам видеть глубже

Новый подход к обработке данных с RGB-D камер позволяет создавать более точные 3D-модели окружения, даже при наличии неполной информации о глубине.

Новый подход к обработке данных с RGB-D камер позволяет создавать более точные 3D-модели окружения, даже при наличии неполной информации о глубине.

Новый подход к оптимизации дизайна метаповерхностей сочетает в себе физически обоснованное моделирование неопределенности и возможности искусственного интеллекта, повышая эффективность и надежность процесса проектирования.

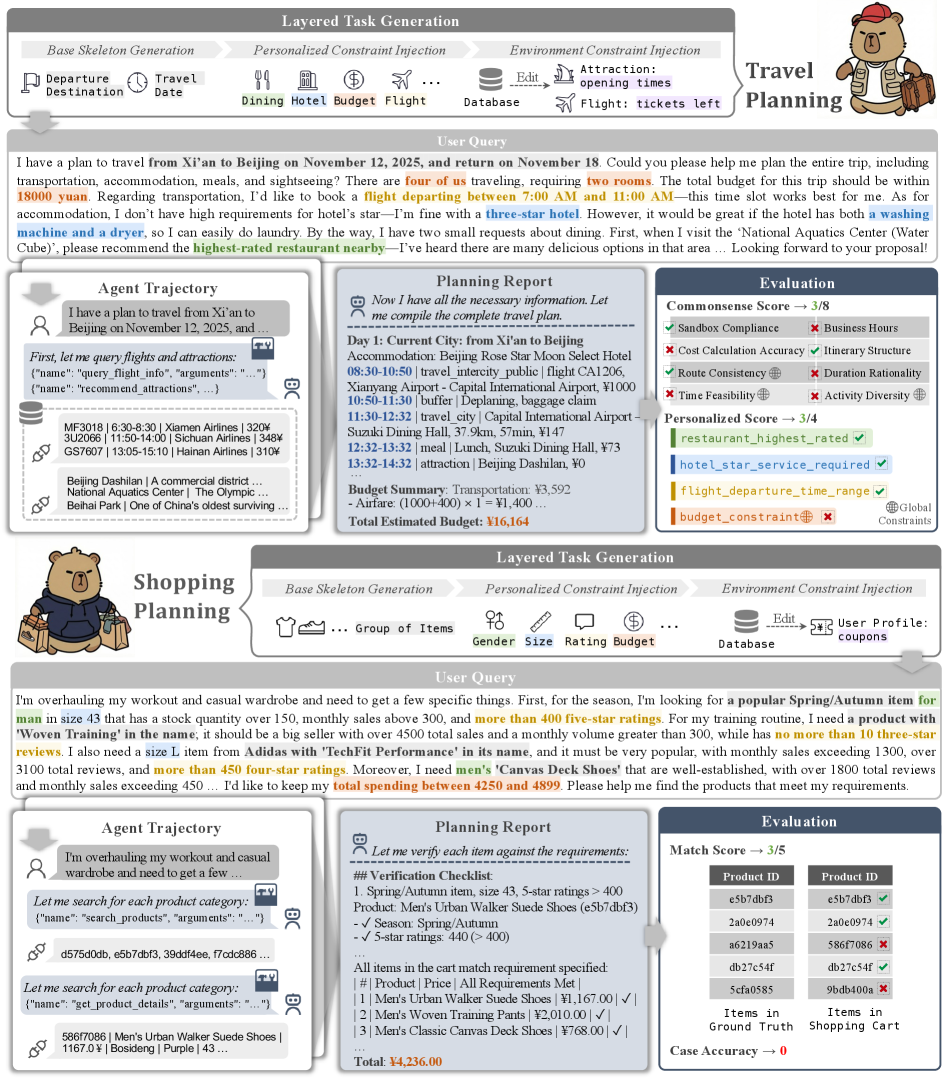

Исследование выявляет слабые места современных ИИ-систем в решении долгосрочных задач, требующих самостоятельного поиска информации и соблюдения ограничений.

Исследователи представили систему ChemCRAFT, использующую обучение с подкреплением для расширения возможностей языковых моделей в области химии и автоматизации процессов молекулярного дизайна и синтеза.

Новый подход RouteMoA позволяет значительно повысить эффективность совместной работы нескольких больших языковых моделей за счет динамического выбора наиболее подходящих для решения задачи.

Новое исследование показывает, что ИИ-агенты, помогающие в разработке, оставляют уникальные следы в своих изменениях, позволяющие их идентифицировать даже при маскировке.

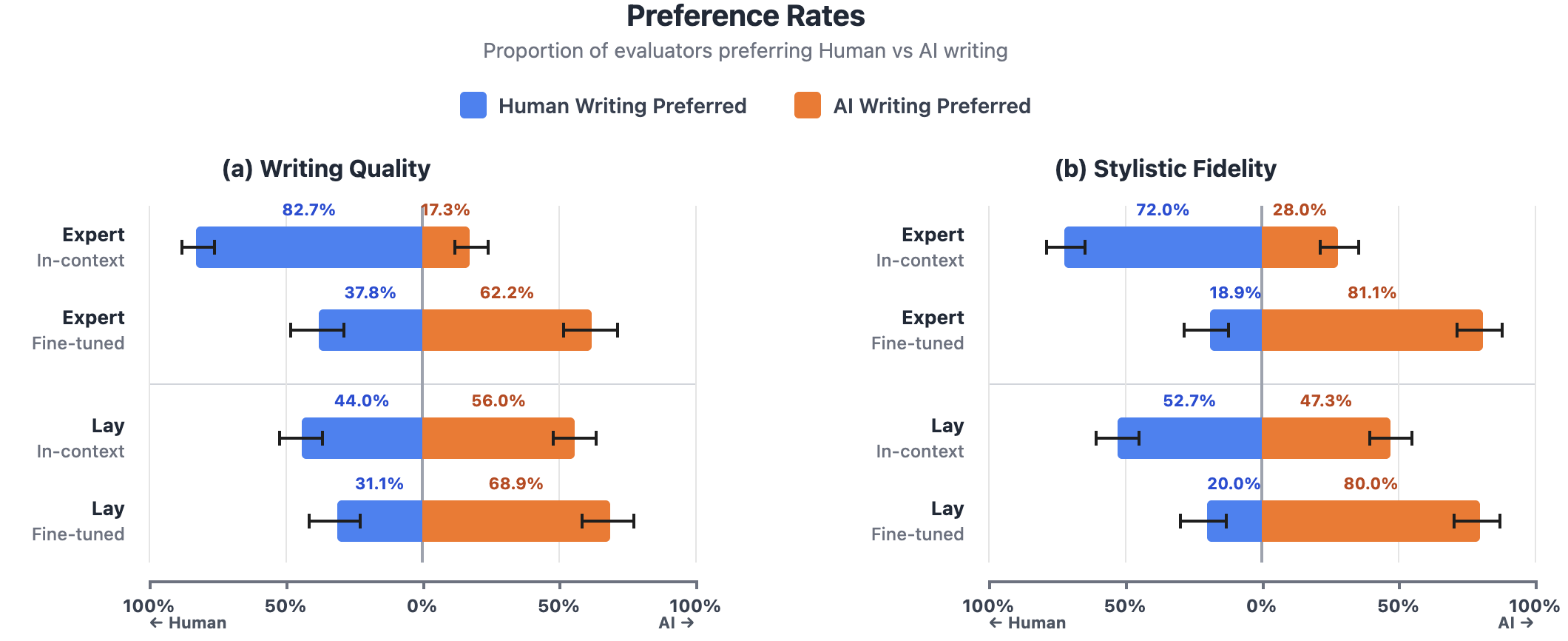

Новое исследование показывает, что искусственный интеллект, обученный на качественной литературе, способен создавать тексты, неотличимые от человеческих, а иногда и превосходящие их по качеству.

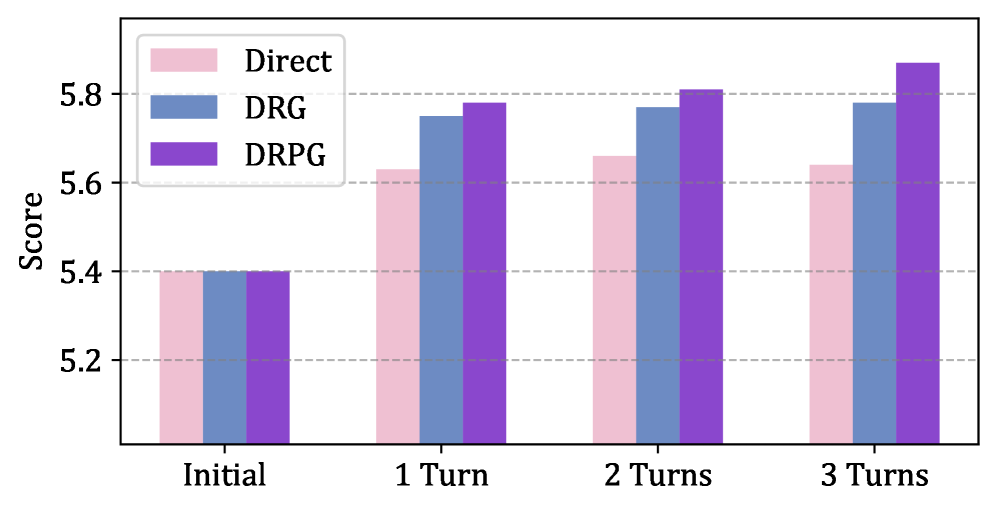

Новая методика позволяет создавать аргументированные ответы на замечания рецензентов, используя возможности больших языковых моделей.

![Трансформеры переосмыслены как линейные операторы, управляемые данными, характеризующиеся тензором внимания высокого порядка [latex]\mathcal{T}[/latex], что позволяет создать единое представление самовнимания, охватывающее всю архитектуру трансформера, включая такие подкомпоненты, как слои FFN, нормализация, слои встраивания и остаточные соединения.](https://arxiv.org/html/2601.17958v1/tensorLens_1.png)

Исследователи предлагают инновационный метод анализа архитектуры Трансформеров, позволяющий увидеть, как именно эти модели принимают решения.

Статья анализирует двойственную роль искусственного интеллекта в решении климатических проблем, подчеркивая необходимость этического подхода и социальной справедливости.