Агенты SERA: Код, Созданный с Подтверждением

![Процесс «мягкой верификации» (Soft Verified Generation) предполагает итеративное совершенствование функции посредством траекторий изменений, преобразованных в синтетические запросы на изменение, после чего учительская модель пытается воспроизвести исправление исключительно по описанию запроса, а сравнение полученных исправлений на уровне строк с использованием порога, например, [latex] r \geq 0.5 [/latex], служит основой для отбора данных обучения.](https://arxiv.org/html/2601.20789v1/x5.png)

Новый подход к обучению кодирующих агентов позволяет достичь выдающихся результатов с минимальными затратами благодаря использованию синтетических данных и техники ‘мягкой верификации’.

![Процесс «мягкой верификации» (Soft Verified Generation) предполагает итеративное совершенствование функции посредством траекторий изменений, преобразованных в синтетические запросы на изменение, после чего учительская модель пытается воспроизвести исправление исключительно по описанию запроса, а сравнение полученных исправлений на уровне строк с использованием порога, например, [latex] r \geq 0.5 [/latex], служит основой для отбора данных обучения.](https://arxiv.org/html/2601.20789v1/x5.png)

Новый подход к обучению кодирующих агентов позволяет достичь выдающихся результатов с минимальными затратами благодаря использованию синтетических данных и техники ‘мягкой верификации’.

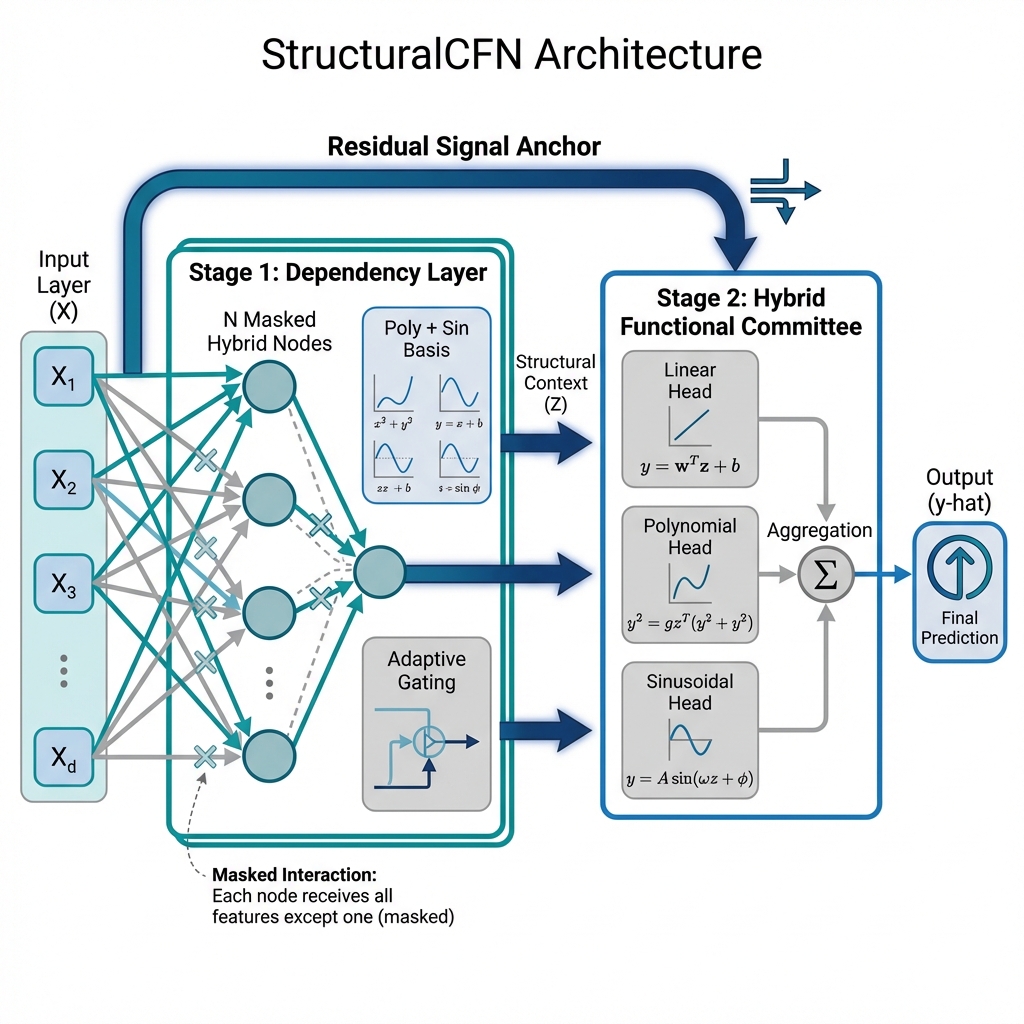

Исследователи представили StructuralCFN — нейронную сеть, способную выявлять и использовать математические зависимости в табличных данных, обеспечивая высокую точность и понятность результатов.

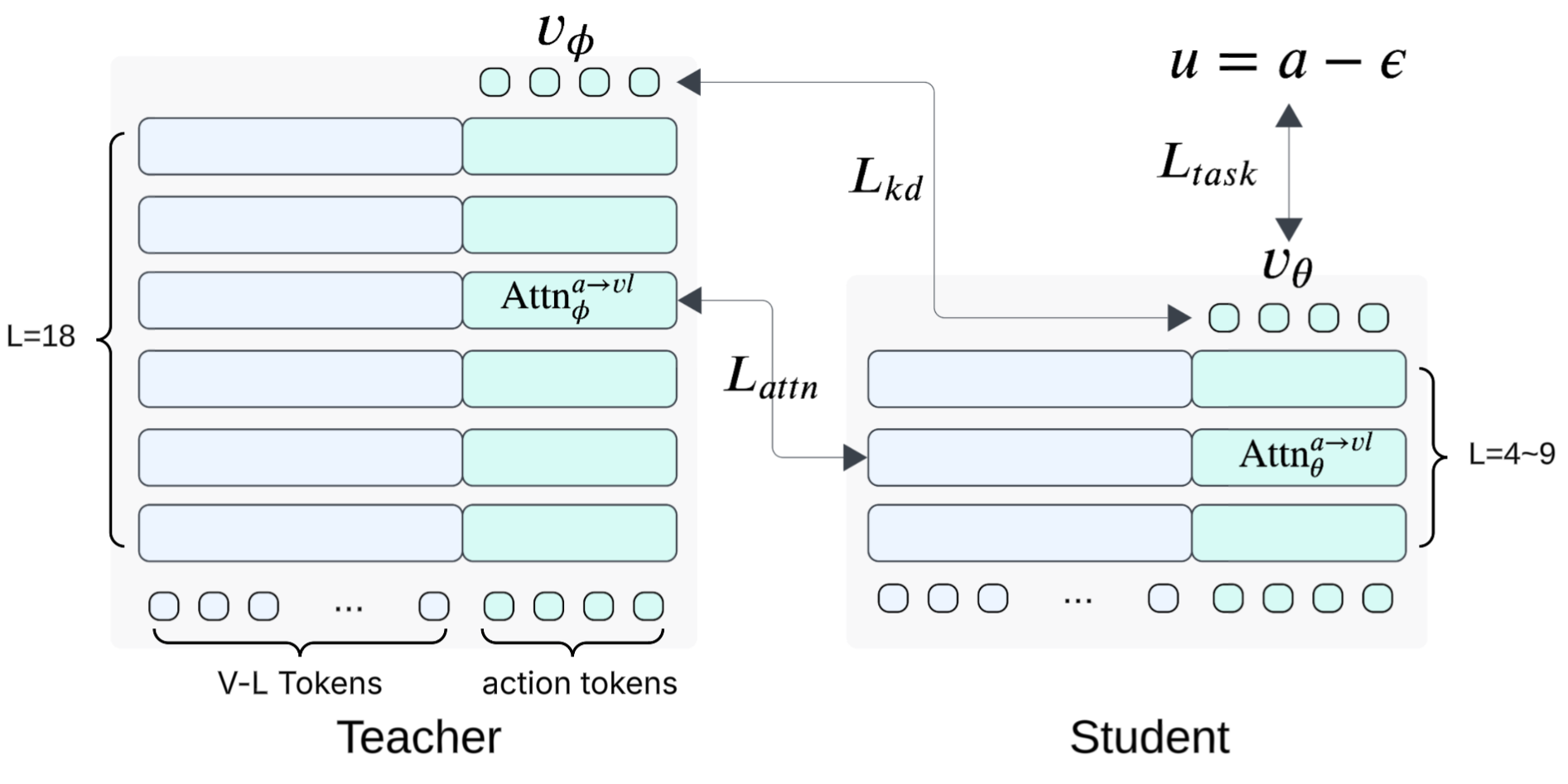

Новый подход позволяет значительно снизить вычислительную нагрузку моделей, понимающих язык, зрение и действия, открывая путь к их использованию на мобильных и встраиваемых устройствах.

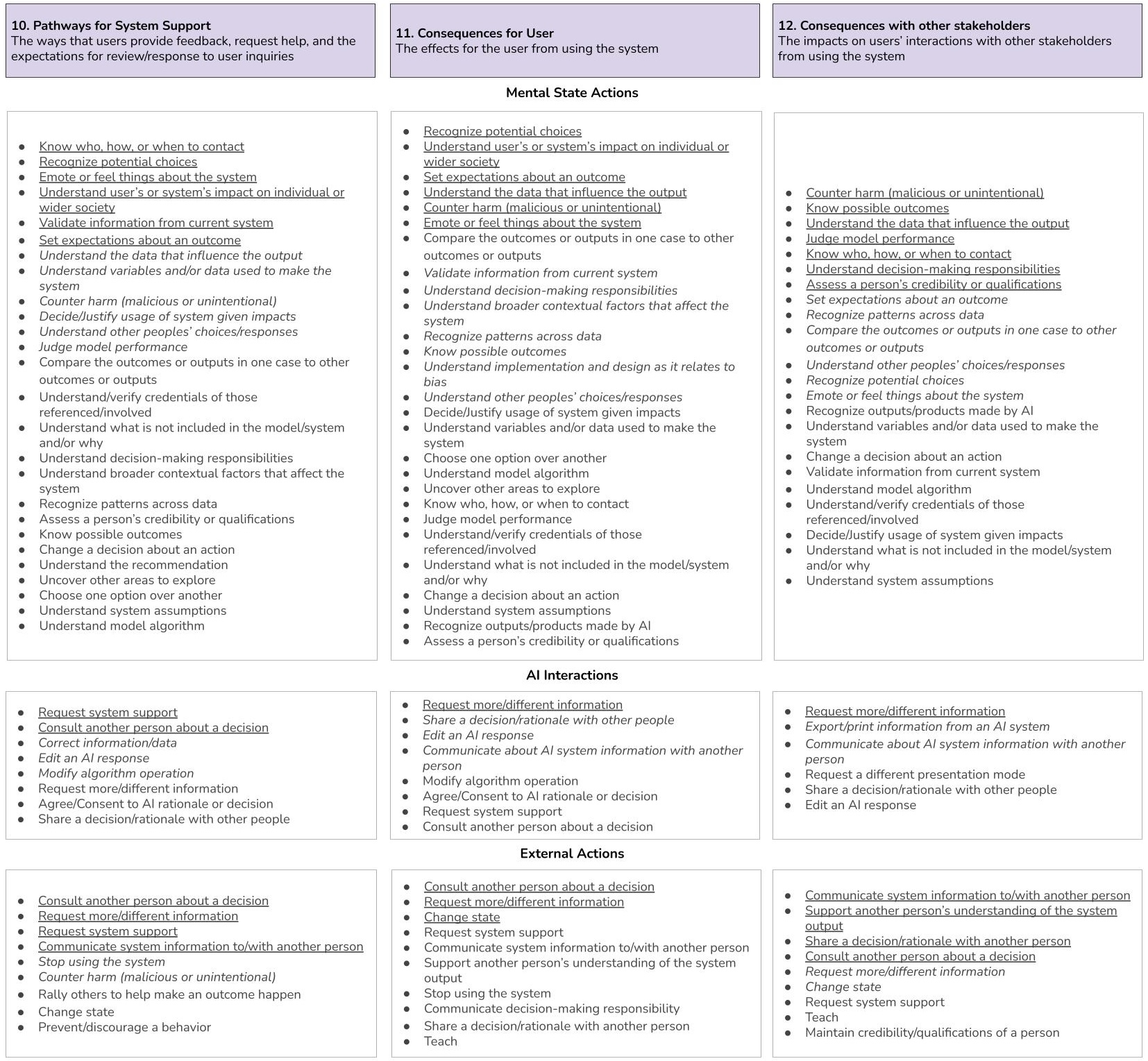

Новое исследование предлагает систематизированный подход к оценке того, насколько объяснения в системах искусственного интеллекта позволяют пользователям эффективно принимать решения и действовать.

Новая методика позволяет значительно повысить способность больших языковых моделей к математическому рассуждению, используя адаптивное обучение и перефразировку вопросов.

Новая платформа, основанная на агентном искусственном интеллекте, позволяет автоматизировать управление инженерными системами зданий и существенно снизить расходы на энергию.

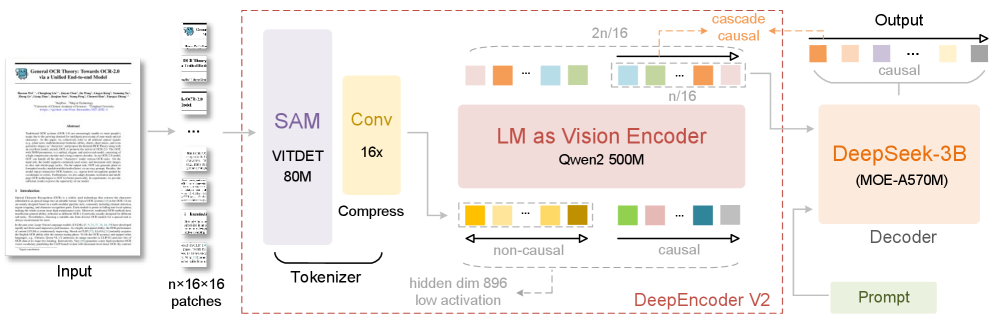

Разработчики представили DeepSeek-OCR 2 — систему, способную глубже анализировать визуальную информацию в документах, используя принципы причинно-следственного анализа.

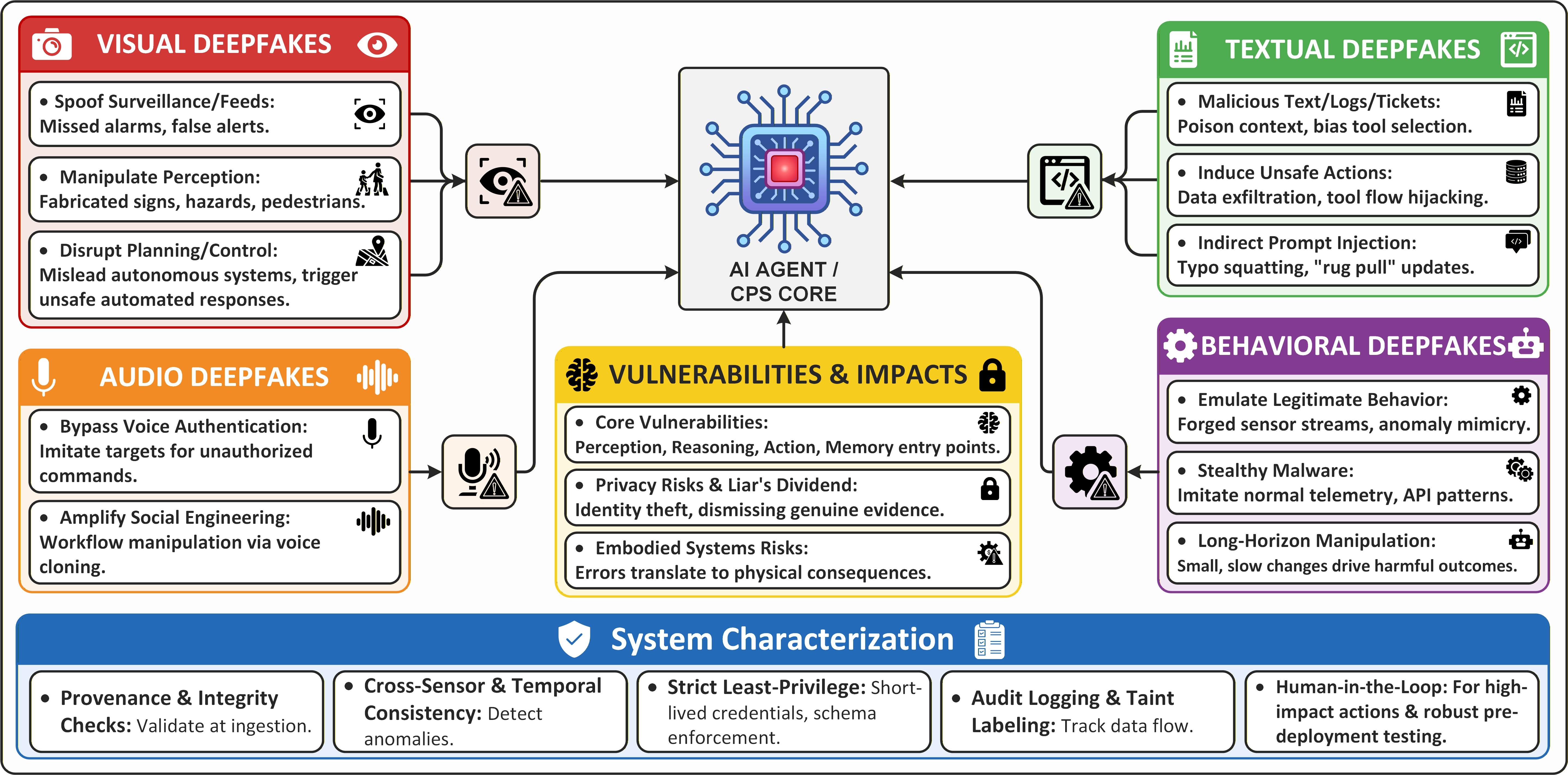

В статье рассматриваются новые угрозы, связанные с использованием дипфейков против систем управления, основанных на искусственном интеллекте, и предлагается комплексный подход к обеспечению их безопасности.

![Модель демонстрирует способность к генерации разнообразных будущих траекторий развития событий, направляемых текстовыми подсказками, охватывая как глобальные изменения окружающей среды ([latex]например, «зима», «пиксель-арт»[/latex]), так и точечные локальные вмешательства ([latex]например, «фейерверки», «рыбы[/latex]), при этом сохраняя физическую и временную согласованность.](https://arxiv.org/html/2601.20540v1/x13.png)

Исследователи представили LingBot-World — платформу, расширяющую возможности генерации видео и симуляций, способную к долгосрочному планированию и управлению действиями.

Новая система позволяет преобразовывать научные концепции в полные статьи, значительно ускоряя процесс исследований и открытий.