Самообучение: Как нейросети учатся без забывания

Новый подход к непрерывному обучению позволяет моделям сохранять знания, приобретенные на предыдущих этапах, при освоении новых задач.

Новый подход к непрерывному обучению позволяет моделям сохранять знания, приобретенные на предыдущих этапах, при освоении новых задач.

Исследователи представляют Youtu-VL, модель, которая демонстрирует впечатляющие результаты благодаря переходу от текстового до визуального контроля в процессе обучения.

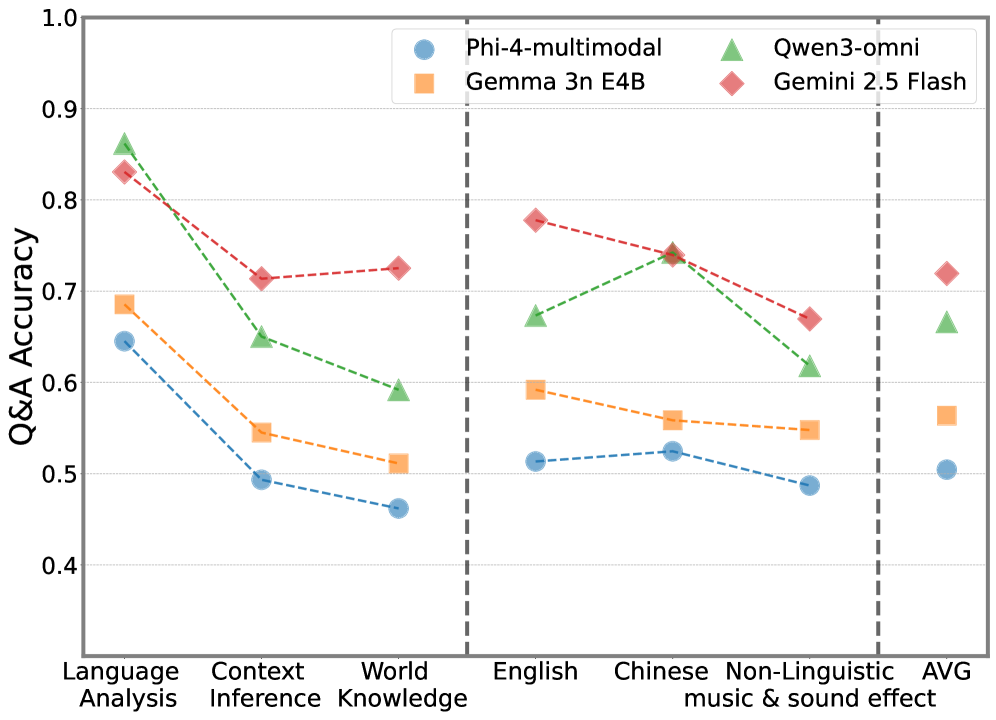

Новый тест AVMeme Exam демонстрирует, что современные модели искусственного интеллекта испытывают трудности с пониманием юмора и культурного контекста в многоязычных аудиовизуальных мемах.

Новое исследование показывает, что современные мультимодальные модели способны к точному определению границ объектов на изображениях, используя простой подход к предсказанию ключевых точек.

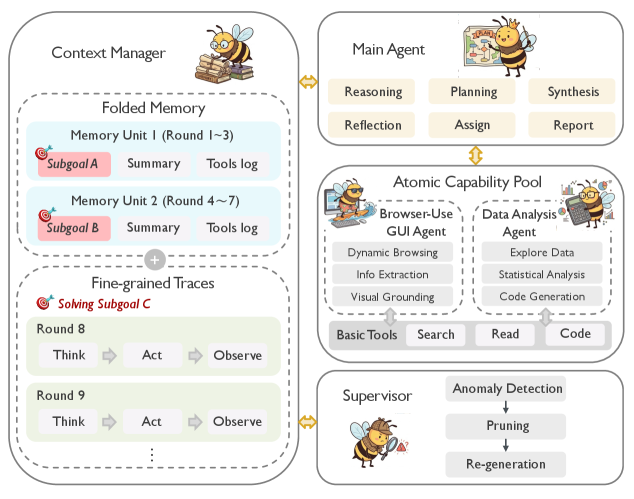

В статье представлена новая иерархическая платформа для организации и проведения глубоких исследований, способная эффективно решать долгосрочные и многогранные задачи.

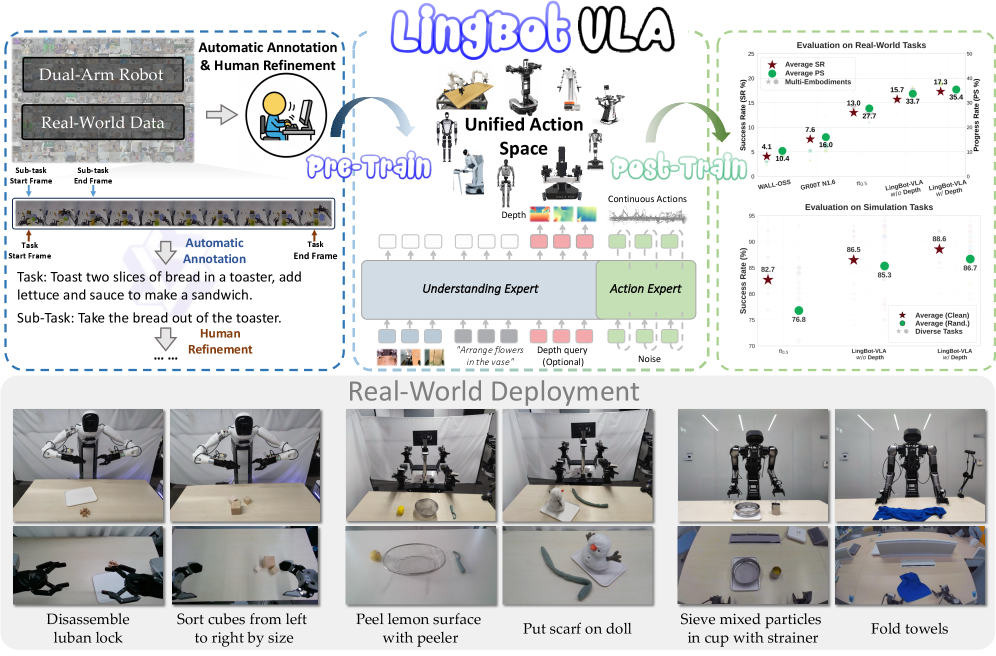

Представлена LingBot-VLA — модель, объединяющая зрение, язык и действия, обученная на огромном массиве реальных данных и демонстрирующая впечатляющую обобщающую способность.

![Предлагается архитектура ComAgent - многоагентной системы искусственного интеллекта, основанной на взаимодействии нескольких больших языковых моделей [latex]LLM[/latex], что позволяет достичь большей гибкости и эффективности в решении сложных задач.](https://arxiv.org/html/2601.19607v1/x1.png)

Новая разработка позволяет автоматизировать оптимизацию беспроводных сетей, используя возможности нескольких интеллектуальных агентов.

Исследователи представили модель DeFM, позволяющую роботам эффективно обучаться на данных о глубине и адаптироваться к различным условиям без дополнительной настройки.

Исследователи предлагают принципиально новый подход к созданию нейронных сетей, вдохновленный устройством человеческого мозга.

Новая разработка позволяет мультимодальным моделям самостоятельно выбирать и комбинировать инструменты для более эффективного решения задач визуального рассуждения.