Автор: Денис Аветисян

Новая работа предлагает комплексный подход к автоматизированному тестированию систем, способных вести беседу, охватывающий все уровни их архитектуры.

Многоуровневое автоматизированное тестирование для повышения надежности и качества систем искусственного интеллекта, ведущих диалог.

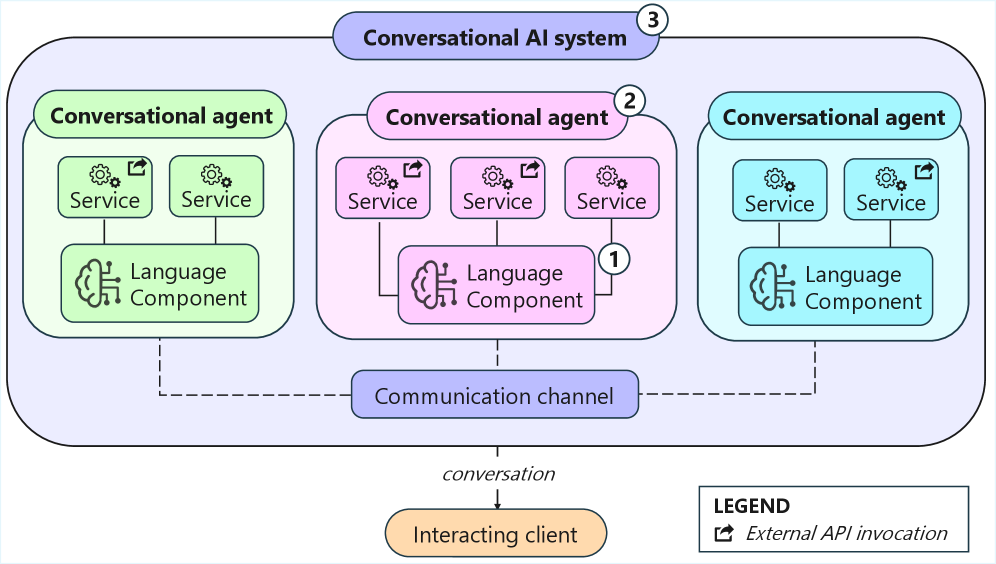

Несмотря на возрастающую популярность систем искусственного интеллекта, способных к ведению диалога, существующие подходы к тестированию зачастую не учитывают специфику разговорного взаимодействия и поведения ИИ-компонентов. Данная диссертационная работа, посвященная теме ‘Multi-Level Testing of Conversational AI Systems’, исследует новый класс методов тестирования, ориентированных на валидацию составляющих элементов диалоговых систем на различных уровнях детализации — от взаимодействия сервисов до многоагентных реализаций. Предложенная стратегия автоматизированного тестирования, охватывающая уровни сервисного взаимодействия, отдельных агентов и многоагентных систем, направлена на повышение надежности и доверия к диалоговым ИИ. Какие перспективы открываются для развития подобных методик в контексте усложнения архитектур и расширения областей применения диалоговых систем?

Взлом диалога: рождение сложных разговорных систем

Современные системы искусственного интеллекта, предназначенные для ведения диалога, стремительно внедряются в различные сферы жизни, значительно расширяя область своего применения. Если раньше подобные системы ограничивались выполнением простых задач, таких как предоставление информации о погоде или установка напоминаний, то сейчас они способны поддерживать сложные, многоступенчатые беседы, решать нетривиальные проблемы и даже оказывать эмоциональную поддержку. Этот переход от простых транзакций к полноценному взаимодействию требует от разработчиков новых подходов к проектированию и тестированию, поскольку системы должны не только понимать запросы пользователей, но и учитывать контекст беседы, запоминать предыдущие реплики и адекватно реагировать на неожиданные ситуации. Увеличение сложности диалогов обуславливает потребность в более совершенных алгоритмах обработки естественного языка и машинного обучения, позволяющих системам эффективно справляться с неоднозначностью и неполнотой информации.

Современные разговорные системы функционируют благодаря тесному взаимодействию языкового компонента и серверных сервисов. Языковой компонент отвечает за понимание запроса пользователя, извлечение ключевой информации и формирование намерения. После этого запрос направляется в соответствующие серверные сервисы, которые выполняют необходимые действия — от поиска информации в базе данных до совершения транзакций. Полученный результат затем преобразуется языковым компонентом в понятный пользователю ответ. Эффективность всей системы напрямую зависит от слаженности работы этих двух частей, а также от способности быстро и точно обрабатывать сложные запросы, требующие взаимодействия с несколькими сервисами одновременно.

Современные разговорные системы искусственного интеллекта, усложняясь и расширяя спектр решаемых задач, предъявляют повышенные требования к обеспечению их надёжности и удобства использования. В связи с этим, возникает необходимость в разработке эффективных методологий тестирования, способных охватить все уровни взаимодействия — от отдельных сервисов, обеспечивающих функциональность, до агентов, реализующих диалоговые стратегии, и, наконец, до сложных многоагентных систем. Данная диссертационная работа посвящена определению стратегий автоматизированного тестирования, охватывающих все эти уровни, с целью гарантировать стабильную и предсказуемую работу систем, а также высокую степень удовлетворенности пользователей.

Многоагентный хаос: проверка взаимодействия

Многоагентные системы разговорного ИИ представляют собой значительные трудности при тестировании из-за возросшей сложности взаимодействия. В отличие от тестирования отдельных агентов, где оценивается функциональность одного компонента, в многоагентных системах необходимо учитывать динамическое взаимодействие между несколькими агентами, что приводит к экспоненциальному увеличению количества возможных сценариев и состояний. Это усложняется необходимостью оценки не только корректности ответов каждого агента, но и согласованности их действий, разрешения конфликтов и общей эффективности системы в достижении поставленных целей. Обеспечение предсказуемости и надежности в таких системах требует разработки специализированных методологий и инструментов тестирования, учитывающих специфику многоагентного взаимодействия.

Традиционное тестирование отдельных агентов, фокусирующееся на их изолированной функциональности и производительности, недостаточно для оценки сложных многоагентных систем. В таких системах поведение и эффективность зависят от взаимодействия и координации между агентами, что требует методологий, оценивающих систему как единое целое. Необходимо учитывать emergent behavior — поведение, возникающее в результате взаимодействия агентов и не предсказуемое при анализе каждого агента по отдельности. Оценка должна включать анализ согласованности ответов, разрешения конфликтов между агентами и общую эффективность выполнения задач, требующих совместной работы.

Тестирование многоагентных систем (Multi-Agent System Testing) предполагает оценку поведения и координации работы нескольких взаимодействующих агентов как единого целого. В отличие от тестирования отдельных агентов, данный подход фокусируется на проверке emergent behavior — поведения, возникающего в результате взаимодействия — и способности системы достигать общих целей. Оценка включает анализ коммуникационных протоколов между агентами, разрешением конфликтов, распределением задач и общей согласованности действий. Ключевым аспектом является проверка, что агенты эффективно сотрудничают, не вступают в противоречия и способны адаптироваться к изменяющимся условиям, обеспечивая надёжную и предсказуемую работу всей системы.

Эффективная оркестровка и планирование на основе искусственного интеллекта (ИИ) являются ключевыми для определения и выполнения комплексных тестовых сценариев в многоагентных системах. Работа, представленная здесь, направлена на улучшение тестирования на всех уровнях разговорного ИИ, включая отдельные агенты, взаимодействие между ними и общую производительность системы. Автоматизированное планирование тестов позволяет создавать сложные сценарии, учитывающие различные комбинации входных данных и состояний агентов, что существенно повышает покрытие тестами и выявляет потенциальные проблемы координации. В частности, используются алгоритмы планирования для определения последовательности действий, необходимых для проверки конкретных функциональных возможностей и сценариев использования, обеспечивая воспроизводимость и масштабируемость процесса тестирования.

Устойчивость к хаосу: разнообразие методов тестирования

Тестирование взаимодействия с сервисами является критически важным этапом верификации корректности обмена данными между языковыми моделями и внешними бэкенд-сервисами. Данный тип тестирования позволяет убедиться, что запросы, формируемые языковым компонентом, правильно интерпретируются сервисом, а ответы, полученные от сервиса, корректно обрабатываются и используются языковой моделью. Особое внимание уделяется проверке обработки различных форматов данных, кодировок и протоколов обмена, а также устойчивости к ошибкам и неожиданным ответам от бэкенда. Недостаточное тестирование взаимодействия может привести к сбоям в работе системы, некорректной обработке пользовательских запросов и, как следствие, снижению качества предоставляемых услуг.

Покрытие API и покрытие параметров предоставляют количественные метрики для оценки полноты тестирования сервисов. Покрытие API измеряет долю вызванных API-методов от общего их числа, демонстрируя, насколько широко тестируются функциональные возможности сервиса. Покрытие параметров оценивает долю протестированных значений параметров для каждого API-метода, указывая на глубину тестирования различных сценариев использования. Обе метрики, выражаемые в процентах, позволяют объективно оценить качество тестового набора и выявить области, требующие дополнительного тестирования для обеспечения надежности и корректности взаимодействия с backend-сервисами.

Методы Charm и BoTest, а также генерация тестов на основе больших языковых моделей (LLM), повышают устойчивость систем за счет автоматического создания вариаций тестовых запросов. Данные инструменты формируют новые тесты путем перефразирования исходных запросов и использования синонимов, что позволяет проверить способность системы корректно обрабатывать различные формулировки одного и того же намерения. Это особенно важно для языковых моделей, которые могут быть чувствительны к незначительным изменениям в входных данных. Автоматическая генерация тестов с использованием синонимов и перефразировок значительно расширяет охват тестирования и помогает выявить потенциальные уязвимости, которые могли бы остаться незамеченными при использовании только исходных тестовых примеров.

Мутационное тестирование предполагает внесение искусственных дефектов (мутаций) в исходный код для оценки способности существующих тестовых наборов обнаруживать эти дефекты. Каждая мутация представляет собой небольшое изменение в коде, например, замену оператора или изменение значения константы. Если тестовый набор не обнаруживает мутацию, это указывает на пробел в тестировании и потенциальную уязвимость. В данной работе мутационное тестирование используется как ключевая метрика для сравнительного анализа эффективности различных техник тестирования, позволяя количественно оценить их способность выявлять внесенные дефекты и, следовательно, обеспечивать надежность системы.

Взгляд в будущее: целостная экосистема тестирования

Разработка и тестирование компонентов разговорного искусственного интеллекта значительно упрощается благодаря таким инструментам, как Botium, и фреймворкам, таким как RASA и Dialogflow. Эти платформы предоставляют разработчикам необходимые средства для создания, обучения и оценки чат-ботов и виртуальных ассистентов. Botium, в частности, автоматизирует процесс тестирования, позволяя проводить комплексную проверку диалоговых систем на различных этапах разработки. RASA и Dialogflow, в свою очередь, обеспечивают основу для создания сложных диалоговых моделей, предоставляя инструменты для управления контекстом, обработки естественного языка и интеграции с различными каналами коммуникации. В совокупности, эти инструменты формируют мощную экосистему, способствующую быстрому и эффективному созданию надежных и функциональных решений в области разговорного ИИ.

Интеграция современных инструментов разработки, таких как Botium, RASA и Dialogflow, с передовыми техниками тестирования позволяет разработчикам создавать надежную и устойчивую экосистему для разговорного искусственного интеллекта. Этот подход выходит за рамки традиционного функционального тестирования, охватывая анализ производительности, безопасности и, что особенно важно, способности системы понимать и правильно реагировать на разнообразные запросы пользователей. Подобная комплексная проверка не только повышает качество диалоговых систем, но и способствует формированию доверия к ним, что является ключевым фактором для успешного внедрения и широкого распространения технологий разговорного ИИ в различных сферах жизни. В результате, пользователи получают более предсказуемый и комфортный опыт взаимодействия, а разработчики — возможность создавать действительно интеллектуальные и полезные приложения.

Комплексный подход к тестированию, объединяющий различные инструменты и методики, способствует значительному улучшению пользовательского опыта взаимодействия с системами искусственного интеллекта. Повышение надежности и предсказуемости ответов, обеспечиваемое тщательным тестированием, напрямую влияет на доверие пользователей к этим системам. Оценка эффективности такого подхода производится с использованием ключевых метрик, таких как покрытие кода и, что особенно важно, покрытие сценариев диалога, позволяющих оценить, насколько полно протестированы различные варианты взаимодействия. Это, в свою очередь, создает благоприятные условия для более широкого внедрения и принятия технологий разговорного ИИ в различных сферах жизни.

Метаморфическое тестирование представляет собой ценное дополнение к существующим методам проверки программного обеспечения, особенно в ситуациях, когда полная спецификация ожидаемого поведения недоступна или слишком сложна для формализации. Вместо проверки соответствия конкретным выходным данным для заданных входных данных, данный подход фокусируется на проверке взаимосвязей между различными входными данными и соответствующими им выходными данными. Суть заключается в том, чтобы определить “метаморфические отношения” — правила, описывающие, как изменение входных данных должно повлиять на выходные данные. Например, если программа корректно обрабатывает определенный ввод, то она должна аналогичным образом обработать его слегка измененную версию. Применение метаморфического тестирования позволяет выявить ошибки, которые трудно обнаружить традиционными методами, особенно в сложных системах, таких как системы искусственного интеллекта, где формальное описание ожидаемого поведения часто отсутствует.

Исследование, представленное в данной работе, акцентирует внимание на многоуровневом тестировании систем разговорного ИИ, рассматривая взаимодействие сервисов, отдельных агентов и многоагентных систем как единое целое. Это напоминает подход к пониманию сложной системы путем её декомпозиции и анализа каждого уровня. Кен Томпсон однажды сказал: «Программы должны быть достаточно маленькими, чтобы их можно было понять». Действительно, для обеспечения надёжности и достоверности систем разговорного ИИ, необходимо тщательно тестировать каждый компонент и их взаимодействие, подобно тому, как разбирается и анализируется каждая строка кода. Многоуровневый подход, предложенный в работе, позволяет выявить уязвимости и обеспечить стабильность системы на всех уровнях абстракции, что особенно важно в контексте постоянно развивающихся многоагентных систем.

Куда Дальше?

Представленная работа, исследуя многоуровневое тестирование систем разговорного ИИ, неизбежно наталкивается на вопрос: достаточно ли вообще тестирования для гарантии «надёжности»? Ведь каждая попытка автоматизировать проверку — это, по сути, создание новой, более изощрённой поверхности для атак. Проверка лишь подтверждает отсутствие ошибок в известных сценариях, оставляя за завесой непредсказуемое поведение в условиях, не предусмотренных разработчиком. И это не недостаток метода, а фундаментальное свойство любой сложной системы.

Очевидным направлением является расширение спектра метаморфических тестов. Но истинный вызов заключается в переходе от простого обнаружения регрессий к предсказанию потенциальных уязвимостей. Представляется перспективным исследование методов, использующих обратное распространение ошибки, для выявления слабых мест в архитектуре агента. Каждый эксплойт начинается с вопроса, а не с намерения, и умение задавать правильные вопросы системе — вот что действительно имеет значение.

В конечном счёте, вопрос не в том, чтобы создать идеальную систему тестирования, а в том, чтобы понять принципы, лежащие в основе поведения разговорного ИИ. Ведь знание — это реверс-инжиниринг реальности, а понимание системы — это её взлом, умом или руками. Именно в этом заключается настоящая ценность исследования.

Оригинал статьи: https://arxiv.org/pdf/2602.03311.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Сердце музыки: открытые модели для создания композиций

- Ищем закономерности: Новый пакет TSQCA для R

- Нейросети на грани: как перевести ИИ в логику для умных устройств

2026-02-04 17:20