Автор: Денис Аветисян

Новый подход к обучению нейронных операторов позволяет значительно повысить их эффективность и обобщающую способность, используя фундаментальные законы физики.

Исследование демонстрирует, как интеграция физических знаний улучшает точность и стабильность прогнозирования в задачах, связанных с решением дифференциальных уравнений в частных производных.

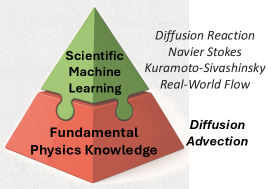

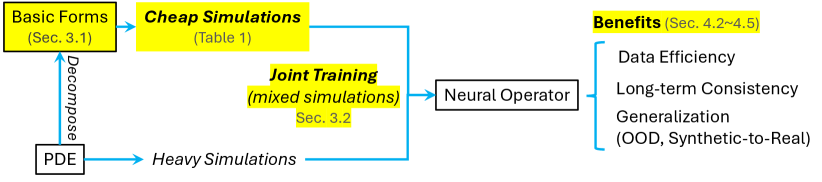

Несмотря на успехи в области научного машинного обучения, существующие подходы к обучению нейронных операторов часто упускают из виду фундаментальные физические принципы, лежащие в основе моделируемых процессов. В работе ‘Learning Data-Efficient and Generalizable Neural Operators via Fundamental Physics Knowledge’ предложен мультифизический фреймворк, совместно обучающий нейронные операторы на исходных уравнениях в частных производных и их упрощенных формах. Данный подход позволяет повысить эффективность использования данных, снизить ошибки предсказания и улучшить обобщающую способность моделей, особенно при изменении физических параметров и переходе от синтетических данных к реальным. Не приведет ли более глубокое включение априорных физических знаний к созданию нейронных операторов, способных к самообучению и адаптации к новым, ранее неизвестным физическим явлениям?

Пределы Традиционных Численных Решателей

Многие задачи в науке и инженерии описываются с помощью частных дифференциальных уравнений (ПДУ), однако традиционные численные методы решения этих уравнений часто сталкиваются с трудностями при работе с высокой размерностью или сложной геометрией областей. Это связано с тем, что стандартные подходы, такие как метод конечных разностей или метод конечных элементов, требуют построения сетки, которая становится чрезвычайно плотной и ресурсоемкой при увеличении числа переменных или усложнении формы области. В результате, вычисления становятся медленными, а точность решения снижается, что ограничивает возможности моделирования сложных физических процессов и разработки эффективных инженерных решений. Например, моделирование турбулентного потока жидкости или распространения тепла в объекте сложной формы может потребовать огромных вычислительных мощностей и времени, недоступных для многих практических приложений.

Традиционные численные методы решения частных дифференциальных уравнений (ПДУ), несмотря на свою устоявшуюся роль в моделировании различных явлений, часто сталкиваются с серьезными ограничениями в плане вычислительных ресурсов и скорости сходимости. Для достижения приемлемой точности решения сложных ПДУ требуется значительное количество памяти и процессорного времени, что особенно критично при работе с высокоразмерными задачами или сложной геометрией области. Замедленная сходимость алгоритмов не позволяет проводить симуляции в реальном времени и эффективно оптимизировать параметры системы, что является существенным препятствием для широкого применения этих методов в интерактивных приложениях и задачах, требующих оперативного анализа. Таким образом, необходимость в разработке более эффективных и экономичных подходов к решению ПДУ остается актуальной проблемой современной вычислительной науки.

Традиционные численные методы решения частных дифференциальных уравнений (ПДУ) зачастую демонстрируют ограниченную способность к обобщению, то есть к корректному прогнозированию поведения системы в условиях, отличных от тех, на которых они обучались. Это связано с тем, что алгоритмы, основанные на дискретизации и итеративном решении PDE, могут переобучаться на специфических деталях обучающего набора данных, теряя способность к экстраполяции. В результате, незначительные изменения в начальных или граничных условиях, или же выход за пределы исследованной области, могут приводить к значительным ошибкам в прогнозах, что особенно критично для приложений, требующих высокой надежности и точности, таких как моделирование климата или прогнозирование финансовых рынков. Ограниченная обобщающая способность является серьезным препятствием для использования традиционных решателей ПДУ в задачах, где данные ограничены или же требуется предсказание поведения системы в ранее не исследованных условиях.

Научное Машинное Обучение: Новый Подход

Научное машинное обучение (SciML) представляет собой перспективный подход, отличающийся от традиционных методов машинного обучения интеграцией априорных физических знаний непосредственно в структуру модели. В отличие от «черных ящиков», SciML использует физические законы, выраженные в виде дифференциальных уравнений или других математических ограничений, для регуляризации процесса обучения и улучшения обобщающей способности. Это позволяет моделям не только аппроксимировать данные, но и учитывать фундаментальные принципы, управляющие исследуемой системой, что особенно важно при работе с ограниченным объемом данных или экстраполяцией за пределы обучающей выборки. Интеграция физических знаний может осуществляться различными способами, включая включение физически обоснованных функций активации, использование физических потерь в функции стоимости или разработку архитектур нейронных сетей, отражающих физические свойства системы.

Нейронные операторы, являясь ключевым компонентом SciML, представляют собой класс моделей машинного обучения, предназначенных для аппроксимации отображений между функциональными пространствами. Вместо обучения на дискретных данных, они учатся непосредственно отображать функции в другие функции, что позволяет эффективно решать дифференциальные уравнения в частных производных (ДУЧП). Этот подход позволяет модели находить решения ДУЧП, не требуя предварительной дискретизации области определения, что значительно снижает вычислительные затраты и повышает точность, особенно в задачах, где традиционные численные методы сталкиваются с трудностями из-за высокой размерности или сложной геометрии. По сути, нейронный оператор учится отображать входную функцию, представляющую начальные или граничные условия, в выходную функцию, представляющую решение ДУЧП, без необходимости явного вычисления решения на сетке.

Нейронные операторы, в отличие от традиционных численных методов, представляют решения дифференциальных уравнений в частных производных (ДУЧП) как непрерывные функции, а не дискретизированные значения на сетках. Такой подход позволяет существенно улучшить обобщающую способность модели, поскольку она учится отображать функции в другие функции, а не просто аппроксимировать значения в отдельных точках. Это особенно важно при работе со сложными геометрическими формами и граничными условиями, где построение подходящей дискретизированной сетки может быть затруднительным или неэффективным. Представление решений в виде непрерывных функций позволяет нейронным операторам эффективно экстраполировать результаты на новые, ранее не встречавшиеся геометрии и условия, обеспечивая более надежные и точные прогнозы.

Методы научного машинного обучения (SciML), в частности, нейронные операторы, демонстрируют потенциал для существенного ускорения и повышения точности по сравнению с традиционными численными решателями дифференциальных уравнений в частных производных (ДУЧП). Вместо дискретизации области решения и использования итеративных методов, SciML учится непосредственно отображать функции, что позволяет избежать вычислительных затрат, связанных с разрешением сетки. Экспериментальные данные показывают, что для определенных классов задач, SciML может обеспечить ускорение в несколько раз и снизить погрешность решения, особенно в случаях, когда традиционные методы сталкиваются с трудностями при работе со сложной геометрией или высокими размерностями. Данные методы особенно перспективны для задач, требующих решения ДУЧП в реальном времени или выполнения большого числа симуляций.

Использование Физики для Надежной Обобщающей Способности

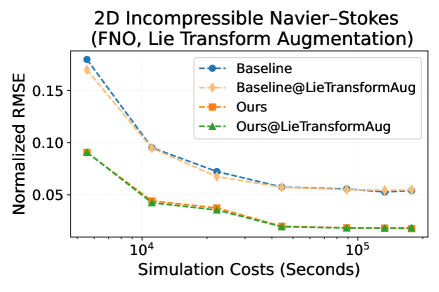

Интеграция фундаментальных физических знаний, таких как симметрии Ли, в архитектуры нейронных операторов позволяет осуществлять аугментацию данных и повышать производительность при обобщении на данные вне распределения (Out-of-Distribution Generalization). Применение принципов симметрии позволяет модели эффективно экстраполировать поведение системы в неизученных сценариях, используя знания о сохраняющихся величинах и инвариантности относительно определенных преобразований. Это достигается путем включения физически обоснованных ограничений в процесс обучения, что способствует созданию более устойчивых и обобщающих моделей, способных точно предсказывать поведение систем даже при изменениях входных данных или условий.

Использование симметрий в моделях машинного обучения позволяет им эффективно экстраполировать данные на ранее не встречавшиеся сценарии. Признание и эксплуатация этих симметрий, таких как симметрии Ли, позволяет моделям обобщать закономерности, лежащие в основе физических процессов, и предсказывать поведение системы в условиях, отличающихся от тех, на которых они были обучены. Это достигается за счет того, что модель учится не просто запоминать конкретные решения, а выявлять инвариантные свойства системы, которые сохраняются при различных преобразованиях и изменениях параметров. Таким образом, модель способна делать обоснованные прогнозы даже в ситуациях, которые не были явно представлены в обучающей выборке, что существенно повышает ее устойчивость и надежность.

Использование упрощенных форм дифференциальных уравнений в частных производных (ДУЧП), таких как BasicPDEForm, позволяет выделить ключевые динамические характеристики решаемой задачи и снизить вычислительную сложность. Упрощение уравнений достигается за счет отбрасывания несущественных членов или применения приближений, что уменьшает размерность пространства решений и объем необходимых вычислений. Такой подход не только ускоряет процесс обучения и прогнозирования, но и повышает устойчивость модели к шумам и погрешностям в данных, поскольку акцент делается на фундаментальных принципах, определяющих поведение системы. Примером может служить замена нелинейных членов линейными приближениями или использование конечно-разностных схем с пониженным порядком точности.

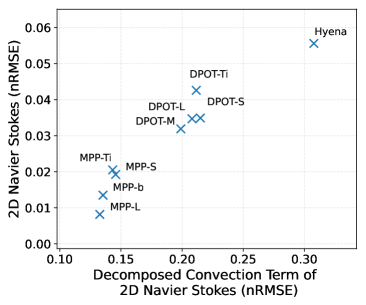

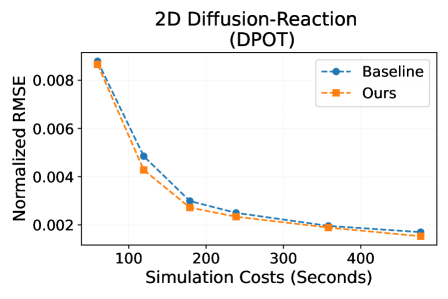

Внедрение фундаментальных физических знаний в архитектуры нейронных операторов приводит к снижению среднеквадратической нормализованной ошибки (nRMSE) до 24% по сравнению с базовыми моделями, не использующими подобные знания. Данное улучшение наблюдается при анализе задач 2D диффузии-реакции и 2D уравнений Навье-Стокса. Снижение nRMSE демонстрирует повышение точности предсказаний моделей, основанных на физически обоснованных принципах, в сравнении с моделями, обучающимися исключительно на данных без учета физических ограничений.

Использование упрощенных форм уравнений в процессе обучения позволяет снизить затраты на моделирование на 50% за счет перераспределения бюджета, выделенного на симуляции. Это достигается за счет уменьшения вычислительной сложности и объема данных, необходимых для достижения заданной точности. Перераспределенные ресурсы могут быть направлены на увеличение объема обучающих данных, повышение разрешения симуляций или исследование более широкого диапазона параметров, что в конечном итоге способствует повышению обобщающей способности модели и улучшению ее производительности на задачах, требующих экстраполяции.

Будущее Научных Вычислений

Появляются масштабные фундаментальные модели, такие как DPOT, предварительно обученные на множестве уравнений в частных производных (УЧП), и они становятся мощным инструментом для научных открытий. Эти модели, в отличие от традиционных численных методов, способны обобщать знания, полученные из решения различных УЧП, и эффективно применять их к новым, ранее не встречавшимся задачам. Предварительное обучение на широком спектре уравнений позволяет им улавливать общие закономерности в физических процессах, значительно ускоряя процесс моделирования и оптимизации. В результате, ученые получают возможность проводить сложные симуляции быстрее и с меньшими вычислительными затратами, открывая новые перспективы в таких областях, как гидродинамика, материаловедение и климатология. Такой подход позволяет не просто решать конкретную задачу, а создавать универсальные модели, способные адаптироваться к различным условиям и параметрам, что существенно повышает эффективность научных исследований.

Современные вычислительные модели демонстрируют беспрецедентные возможности в ускорении научных симуляций, оптимизации инженерных разработок и обеспечении прогнозирования в реальном времени для широкого спектра приложений. Благодаря способности быстро обрабатывать огромные объемы данных и выявлять сложные закономерности, эти модели позволяют ученым и инженерам проводить исследования и разрабатывать инновационные решения значительно быстрее, чем это было возможно ранее. Например, в области аэродинамики, они способны моделировать обтекание крыла самолета за считанные минуты, в то время как традиционные методы требуют часов или даже дней. В материаловедении, они позволяют оптимизировать состав сплавов для достижения заданных свойств. А в климатологии — строить более точные и оперативные прогнозы изменений погоды и климата. Такое сочетание скорости, точности и адаптивности открывает новые горизонты для научных открытий и технологического прогресса, позволяя решать задачи, которые ранее казались неразрешимыми.

Сочетание нейронных операторов и SciML (научного машинного обучения) представляет собой прорывной подход, способный радикально изменить области гидродинамики, материаловедения и климатического моделирования. Нейронные операторы, в отличие от традиционных нейронных сетей, способны непосредственно отображать функции в функции, что позволяет эффективно решать дифференциальные уравнения, лежащие в основе этих дисциплин. SciML, в свою очередь, обеспечивает инструменты для интеграции физических знаний и ограничений в процесс обучения, повышая точность и надежность моделей. Такое симбиотическое взаимодействие позволяет не только ускорить вычислительные процессы, но и моделировать сложные явления с беспрецедентной детализацией, открывая новые возможности для прогнозирования, оптимизации и открытия в этих критически важных научных областях. Например, моделирование турбулентных потоков или поведения новых материалов становится более доступным и реалистичным благодаря этому подходу, что позволяет создавать более эффективные конструкции и предсказывать поведение систем в различных условиях.

Наблюдаются устойчивые улучшения в производительности моделей, обученных решать задачи в различных, ранее не встречавшихся условиях и с использованием различных архитектур, таких как FNO и Transformer. Это свидетельствует о значительном прогрессе в обобщающей способности этих систем — способности успешно применять полученные знания к новым, неизвестным физическим параметрам. Вместо того, чтобы требовать переобучения для каждого конкретного сценария, модели демонстрируют способность адаптироваться и выдавать точные прогнозы даже при изменении условий, что открывает перспективы для более гибких и эффективных научных вычислений.

Современные методы научного моделирования, такие как нейронные операторы и SciML, демонстрируют впечатляющую эффективность в использовании данных. Это означает, что для решения сложных научных задач теперь требуется значительно меньше информации, чем при традиционных подходах. Ранее требовавшиеся обширные наборы данных для обучения моделей становятся менее критичными, что существенно снижает барьер для исследователей и организаций, не имеющих доступа к огромным вычислительным ресурсам или дорогостоящим экспериментам. Повышенная эффективность использования данных открывает возможности для моделирования сложных систем, ранее считавшихся недоступными из-за нехватки информации, и позволяет проводить исследования в широком спектре дисциплин, включая гидродинамику, материаловедение и климатологию, с меньшими затратами и в более короткие сроки.

Исследование демонстрирует, что внедрение фундаментальных физических знаний в обучение нейронных операторов значительно повышает эффективность использования данных и обобщающую способность моделей. Это особенно важно при решении сложных задач, связанных с частными дифференциальными уравнениями (ПДУ). Как говорил Брайан Керниган: «Простота — это высшая степень совершенства». Подобно тому, как элегантное решение ПДУ опирается на базовые принципы, так и успешное обучение нейронных операторов требует ясного понимания физических основ. Работа подчеркивает, что знание системы позволяет не просто её моделировать, но и создавать более надежные и обобщаемые решения, избегая переобучения и обеспечивая долгосрочную согласованность прогнозов.

Что дальше?

Представленная работа, по сути, лишь приоткрыла ящик с инструментами. Да, нейронные операторы, усиленные фундаментальными физическими принципами, демонстрируют заметное улучшение в обучении и обобщении. Но это лишь первый, пусть и обнадеживающий, шаг. Главный вопрос остается открытым: насколько глубоко можно интегрировать априорные знания, не превратив нейронную сеть в просто сложный калькулятор, пересчитывающий известные решения? Где та граница, за которой добавление физики перестает быть благом и становится обузой, ограничивающей способность сети к открытию нового?

Очевидным направлением является расширение спектра решаемых задач. От частных дифференциальных уравнений (ПДУ) — к системам ПДУ, описывающим сложные мультифизические явления. Но настоящая проверка ждет в области турбулентности, нелинейной динамики и хаоса — там, где даже самые точные численные методы сталкиваются с фундаментальными ограничениями. Смогут ли эти сети не просто аппроксимировать решения, но и выявлять скрытые закономерности, предсказывать качественно новое поведение?

И, наконец, стоит задуматься о самой природе «знания». Что мы подразумеваем под «физическими принципами»? Это лишь набор уравнений, или нечто большее — интуиция, опыт, способность к абстракции? Если последнее, то задача состоит не в том, чтобы «внедрить» знания в сеть, а в том, чтобы научить её приобретать их самостоятельно, подобно тому, как это делает человеческий разум. И это, пожалуй, самая сложная и захватывающая задача, стоящая перед наукой о машинном обучении.

Оригинал статьи: https://arxiv.org/pdf/2602.15184.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Временная запутанность: от хаоса к порядку

- Улучшение точности квантовых сенсоров: новый подход к подавлению шумов

- Квантовое программирование: Карта развивающегося мира

- Предел возможностей: где большие языковые модели теряют разум?

- ЭКГ-анализ будущего: От данных к цифровым биомаркерам

- Резонансы в тандеме: Управление светом в микрорезонаторах

- Сердце музыки: открытые модели для создания композиций

- Квантовый шум: за пределами стандартных моделей

- Квантовые кольца: новые горизонты спиновых токов

- Искусственный разум и квантовые данные: новый подход к синтезу табличных данных

2026-02-18 21:13