Автор: Денис Аветисян

В статье предлагается концепция интеграции больших языковых моделей с формальными методами для автоматизации синтеза контрактов и повышения надежности верификации программного обеспечения.

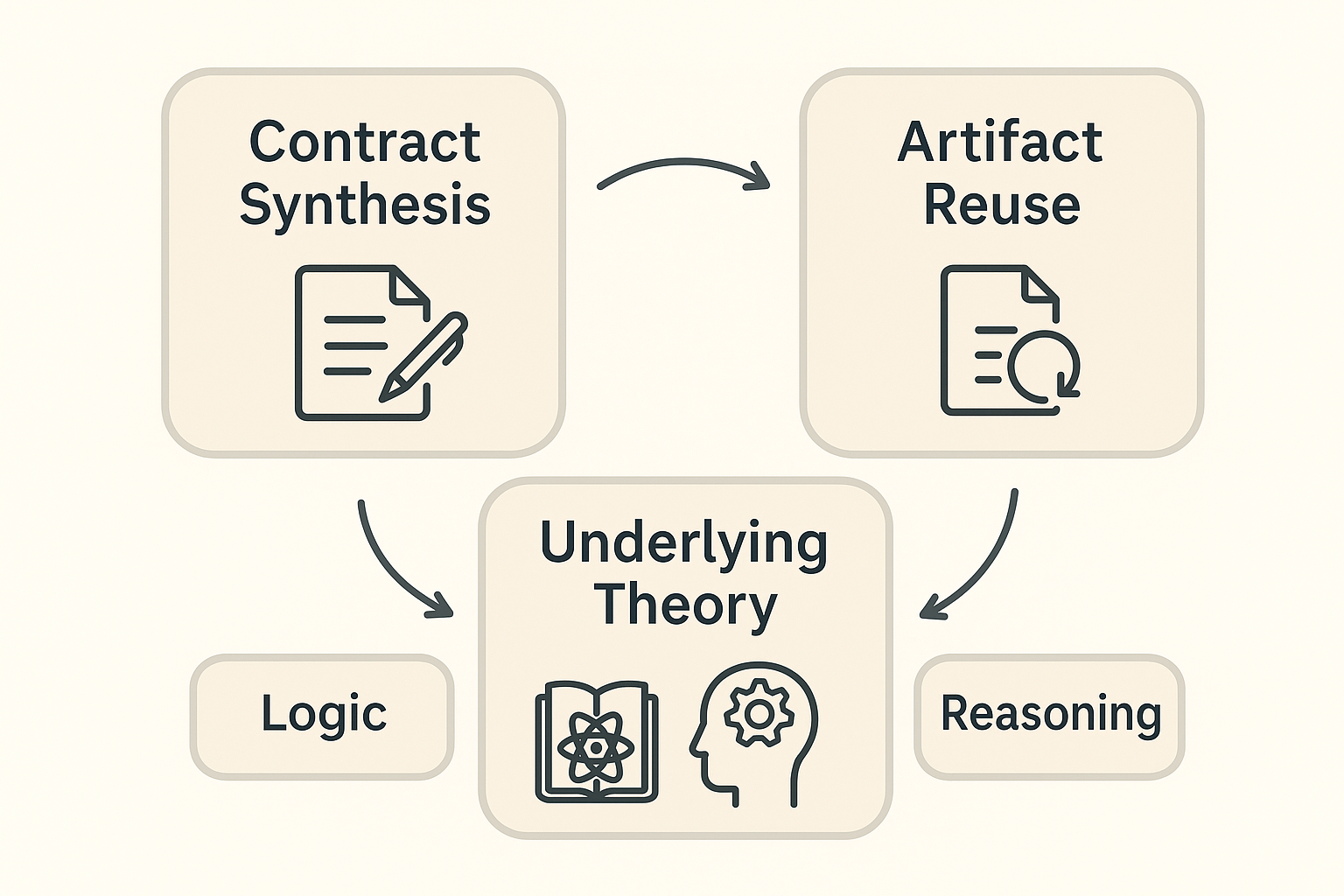

Исследование охватывает синтез контрактов, семантическое повторное использование артефактов и объединение теоретических основ формальной верификации, включая исчисление уточнения и сопоставление графов.

Несмотря на значительные достижения в области формальной верификации, создание надежных и масштабируемых систем остается сложной задачей. В данной работе, ‘Learning-Infused Formal Reasoning: From Contract Synthesis to Artifact Reuse and Formal Semantics’, предлагается новый подход, объединяющий возможности больших языковых моделей и формальных методов для автоматического синтеза контрактов и семантического повторного использования артефактов верификации. Предлагаемый гибридный фреймворк позволяет строить системы, в которых спецификации и доказательства непрерывно синтезируются и переносятся между различными системами, опираясь на унифицированные теоретические основы. Не приведет ли это к созданию самообучающихся экосистем верификации, способных ускорить процесс обеспечения надежности программного обеспечения?

Разрушая Пределы: К Формальной Верификации, Подкрепленной Обучением

Традиционные методы формальной верификации, несмотря на свою строгость и надёжность, сталкиваются со значительными трудностями при работе с современными, чрезвычайно сложными системами. По мере увеличения масштаба и взаимосвязанности программного и аппаратного обеспечения, количество возможных состояний и путей выполнения экспоненциально возрастает. Это приводит к так называемым «узким местам масштабируемости», когда проверка становится непосильной задачей даже для мощных вычислительных ресурсов. По сути, алгоритмы, успешно работающие с небольшими примерами, оказываются неспособными справиться с реальными системами, что ставит под вопрос применимость формальной верификации в критически важных областях, таких как авиация, автомобилестроение и финансы. Необходимость преодоления этих ограничений и стала отправной точкой для разработки новых подходов, сочетающих в себе преимущества формальных методов и машинного обучения.

В настоящее время наблюдается переход к новому подходу в области формальной верификации — обученное формальное рассуждение (LIFR). Данная парадигма, предложенная в настоящей работе, стремится объединить сильные стороны формальных методов, обеспечивающих строгую точность, и адаптивность машинного обучения. Традиционные методы часто сталкиваются с ограничениями масштабируемости при работе со сложными современными системами. LIFR предлагает решение этой проблемы, используя возможности машинного обучения для автоматизации и оптимизации процесса верификации, что позволяет справляться с возрастающей сложностью программного обеспечения без потери надежности и доверия к результатам. Такой симбиоз позволяет создавать системы, которые не только гарантированно функционируют корректно, но и способны эффективно адаптироваться к изменяющимся условиям и требованиям.

В основе подхода обучения, дополняющего формальную верификацию (LIFR), лежит синергия между строгой логикой и адаптивностью машинного обучения. Эта концепция направлена на создание систем, которые не только гарантированно соответствуют заданным спецификациям благодаря формальным методам, но и способны эффективно функционировать в условиях реальной сложности, характерных для современных технологических задач. LIFR позволяет преодолеть ограничения традиционной формальной верификации, которая часто сталкивается с трудностями при масштабировании на большие и сложные системы. Вместо того, чтобы полагаться исключительно на ручное построение и проверку формальных моделей, LIFR использует возможности машинного обучения для автоматизации и оптимизации этого процесса, тем самым повышая надежность и эффективность верификации сложных программных и аппаратных систем.

Автоматизация Доверия: Синтез Контрактов и Большие Языковые Модели

Синтез контрактов предоставляет возможность автоматического генерирования верифицируемых программных контрактов на основе требований, сформулированных на естественном языке. Этот процесс направлен на снижение трудозатрат, связанных с ручным написанием и проверкой контрактов, а также на минимизацию потенциальных ошибок, возникающих при ручной реализации. Автоматизация позволяет создавать формальные спецификации, которые могут быть использованы для статического анализа и верификации кода, обеспечивая соответствие реализации исходным требованиям и повышая надежность программного обеспечения. В результате, время разработки сокращается, а качество программного продукта улучшается за счет более эффективной и точной проверки.

Большие языковые модели (БЯМ) играют ключевую роль в автоматическом синтезе контрактов, обеспечивая генерацию спецификаций на естественном языке, семантическое выравнивание между требованиями и формальными контрактами, а также обнаружение релевантных знаний для построения этих контрактов. БЯМ анализируют текстовые описания функциональности и преобразуют их в формальные спецификации, которые могут быть использованы инструментами верификации. Этот процесс включает в себя понимание намерений, извлечение ключевых ограничений и преобразование их в логические утверждения, необходимые для проверки корректности программного кода. Способность БЯМ к семантическому выравниванию позволяет минимизировать расхождения между неформальными требованиями и формальными контрактами, повышая надежность и точность процесса верификации.

Большие языковые модели (LLM) используют семантические вложения (semantic embeddings) для представления кода и естественного языка в виде векторов в многомерном пространстве, где близость векторов отражает семантическое сходство. Этот подход позволяет LLM понимать смысл как программного кода, так и текстовых требований, осуществляя эффективный перевод между ними. Семантические вложения формируются посредством обучения моделей на больших объемах данных, что позволяет им выявлять и кодировать сложные взаимосвязи между словами и конструкциями, обеспечивая возможность генерации формальных контрактов, соответствующих исходным требованиям. Эффективность данного подхода зависит от качества обучения модели и размера используемого корпуса данных.

Инструменты, такие как Frama-C, Z3, CVC4 и CVC5, являются ключевыми компонентами в процессе формальной верификации программного обеспечения. Frama-C предоставляет платформу для статического анализа кода на языке C, позволяя использовать сгенерированные контракты для проверки соответствия кода спецификациям. Z3, CVC4 и CVC5 — это решатели ограничений (SMT solvers), которые автоматически доказывают или опровергают свойства программ, основанные на заданных контрактах и входных данных. Эти инструменты используют контракты, полученные в результате синтеза, для построения логических формул, которые затем решаются для определения корректности кода. Успешное решение этих формул подтверждает, что код соответствует заданным требованиям, в то время как обнаружение противоречий указывает на наличие ошибок или несоответствий.

Усиление Верификации: Повторное Использование Артефактов

Повторное использование артефактов (Artifact Reuse) представляет собой подход к формальной верификации, заключающийся в поиске, сопоставлении и адаптации существующих формальных артефактов, таких как контракты и доказательства корректности. Целью является минимизация избыточных усилий по верификации за счет повторного использования уже проверенных компонентов. Вместо создания новых спецификаций и доказательств с нуля, система стремится найти аналогичные артефакты, оценить их применимость к текущей задаче и, при необходимости, адаптировать их для соответствия новым требованиям. Это позволяет существенно сократить время и ресурсы, необходимые для обеспечения надежности и безопасности сложных систем.

В основе повторного использования артефактов верификации лежат методы сопоставления графов, позволяющие выявлять семантические соответствия между формальными артефактами, представленными в виде графов. Данные методы анализируют структуру графов, включая узлы и ребра, для определения изоморфизма или подобия между ними. Это позволяет автоматически обнаруживать эквивалентные или функционально схожие компоненты в различных спецификациях и доказательствах. Сопоставление графов может быть реализовано с использованием различных алгоритмов, таких как алгоритм Вильсона или алгоритмы на основе поиска по подграфам, которые оценивают степень соответствия между графами на основе заданных метрик. Выявленные соответствия затем используются для адаптации существующих артефактов и минимизации необходимости повторной разработки верификационных материалов.

Большие языковые модели (LLM) значительно расширяют возможности повторного использования артефактов формальной верификации, автоматизируя процесс согласования и адаптации различных спецификаций и доказательств. LLM способны анализировать семантическое содержание формальных артефактов, представленных в различных форматах и нотациях, и выявлять соответствия между ними. Это позволяет автоматически преобразовывать существующие доказательства для новых, но схожих, спецификаций, минимизируя необходимость ручного анализа и переработки. LLM также могут генерировать преобразования между различными языками формальной спецификации, облегчая интеграцию артефактов, созданных с использованием разных инструментов и подходов. Такая автоматизация существенно сокращает время и затраты на верификацию, особенно в сложных системах, где повторное использование существующих артефактов является ключевым фактором эффективности.

Расширение применимости формальной верификации достигается за счет снижения затрат на разработку и адаптацию формальных артефактов. Традиционно, формальная верификация требовала создания специализированных спецификаций и доказательств для каждого нового компонента или системы. Использование повторного использования артефактов, включая контракты и доказательства, позволяет применять формальные методы к более широкому спектру систем, включая сложные и крупные проекты, где полная разработка формальных спецификаций была бы экономически нецелесообразной или практически невозможной. Это особенно актуально для систем, требующих высокой надежности и безопасности, таких как критически важное программное обеспечение, системы управления и сетевые протоколы.

Динамический Анализ и Оптимизация Инструментов для Надёжности

Инструмент динамического анализа PathCrawler дополняет методы статической верификации, обнаруживая ошибки выполнения и уязвимости посредством анализа поведения программы во время исполнения. В отличие от статического анализа, который исследует код без фактического запуска, PathCrawler позволяет выявить проблемы, проявляющиеся только в конкретных условиях выполнения, такие как ошибки доступа к памяти, переполнения буфера и логические ошибки, возникающие в результате сложных взаимодействий. Этот подход позволяет не только подтвердить корректность кода, но и обнаружить скрытые дефекты, которые могли бы привести к сбоям или уязвимостям в реальных сценариях использования. Благодаря анализу траекторий выполнения, PathCrawler обеспечивает более глубокое понимание поведения программы и повышает надежность и безопасность разрабатываемых систем.

Эффективность инструмента динамического анализа PathCrawler тесно связана с его опорой на платформу Frama-C, что позволяет реализовать гибридный подход к верификации программного обеспечения. Вместо того чтобы полагаться исключительно на статический анализ исходного кода, PathCrawler использует Frama-C для создания абстрактной модели программы, а затем динамически исследует различные пути выполнения этой модели. Такое сочетание позволяет обнаруживать ошибки, которые трудно выявить при статическом анализе, например, ошибки, возникающие только при определенных условиях выполнения, и в то же время, Frama-C предоставляет мощные инструменты для формальной верификации, подтверждающие корректность кода. В результате, PathCrawler не просто обнаруживает ошибки, но и предоставляет информацию, необходимую для их исправления и повышения надежности системы в целом, объединяя преимущества обоих подходов к верификации.

Эффективность инструмента динамического анализа PathCrawler напрямую зависит от грамотной настройки эвристик исследования путей выполнения и конфигурации самого инструмента. Оптимизация этих параметров позволяет существенно повысить производительность PathCrawler, сократить время анализа и обеспечить более полное покрытие кода. Использование продуманных эвристик позволяет инструменту фокусироваться на наиболее вероятных и критичных путях, избегая избыточного исследования заведомо безопасных участков. Настройка параметров, таких как глубина поиска, лимиты времени и памяти, а также стратегии выбора путей, позволяет адаптировать PathCrawler к специфике конкретного программного обеспечения и добиться максимальной эффективности при выявлении ошибок и уязвимостей. Без такой оптимизации, анализ может оказаться неполным или слишком ресурсоемким, что снижает практическую ценность инструмента.

Сочетание методов статической и динамической верификации представляет собой комплексный подход к построению надежных систем. Статическая верификация, анализируя код без его исполнения, позволяет выявить потенциальные ошибки на ранних стадиях разработки, в то время как динамическая верификация, осуществляемая в процессе выполнения программы, обнаруживает ошибки, проявляющиеся только в определенных условиях. Объединение этих подходов позволяет достичь более высокой степени уверенности в корректности программного обеспечения, поскольку компенсируются недостатки каждого из методов. Статическая верификация может пропустить ошибки, зависящие от входных данных или состояния системы, в то время как динамическая верификация может не охватить все возможные пути выполнения программы. Таким образом, использование обоих подходов в совокупности обеспечивает более полную и надежную проверку, способствуя созданию систем, устойчивых к ошибкам и уязвимостям.

Фундаментальные Принципы для Достойных Доверия Систем

Единая теория программирования (УТП) представляет собой фундаментальную основу, объединяющую семантику различных парадигм программирования. Она позволяет рассматривать императивное, функциональное, логическое и другие подходы в рамках единой математической модели. Это, в свою очередь, открывает возможности для формального рассуждения о программах, написанных на разных языках, и доказательства их корректности. Вместо того, чтобы разрабатывать отдельные методы верификации для каждого языка, УТП предлагает унифицированный подход, позволяющий применять одни и те же инструменты и техники для анализа и проверки программного обеспечения, независимо от выбранной парадигмы. Такая унификация значительно упрощает процесс создания надежных и безопасных систем, особенно в контексте быстро развивающихся технологий искусственного интеллекта и сложных программных архитектур.

Теория институций предоставляет категориальную основу для определения и сопоставления логических систем, что открывает возможности для создания более гибких и выразительных инструментов верификации. В рамках этой теории, логические системы рассматриваются как институции, определяемые своим синтаксисом, семантикой и логическими следствиями. Категориальный подход позволяет абстрагироваться от конкретных деталей реализации каждой системы и сосредоточиться на общих принципах, лежащих в их основе. Это, в свою очередь, способствует разработке универсальных инструментов, способных работать с различными логиками и формальными языками, упрощая процесс проверки корректности и безопасности сложных программных систем. Благодаря этой универсальности, теория институций становится ключевым элементом в построении надежной инфраструктуры для верификации, позволяя эффективно справляться с растущей сложностью современных информационных технологий.

Для создания надежного и масштабируемого фундамента искусственного интеллекта, способного поддерживать все более сложные системы, критически важны теоретические основы, такие как Унифицированная Теория Программирования и Теория Институций. Эти концепции позволяют не просто создавать функциональные алгоритмы, но и формально обосновывать их корректность и безопасность. В условиях экспоненциального роста сложности ИИ-систем, традиционные методы тестирования становятся недостаточными, и необходимость в строгой верификации, основанной на математических принципах, становится все более очевидной. Именно эти теоретические рамки обеспечивают возможность построения систем, в которых можно быть уверенными не только в их работоспособности, но и в соответствии заданным спецификациям, что является необходимым условием для широкого и ответственного применения искусственного интеллекта.

Дальнейшие исследования в области унифицированной теории программирования и теории институций открывают перспективы создания систем, которые будут не просто работоспособными, но и верифицируемыми, то есть их корректность и безопасность смогут быть математически доказаны. Это особенно важно для развития искусственного интеллекта и сложных программных комплексов, где даже незначительная ошибка может привести к серьезным последствиям. Разработка формальных методов и инструментов, основанных на этих теоретических принципах, позволит создавать инфраструктуру, гарантирующую надежность и предсказуемость поведения систем, что является ключевым фактором для доверия к ним и их широкого внедрения в критически важные области.

Исследование демонстрирует стремление к созданию систем формальной верификации, способных к автоматическому синтезу контрактов и повторному использованию артефактов. Этот подход предполагает, что реальность подобна открытому исходному коду, который предстоит расшифровать. Как однажды заметил Анри Пуанкаре: «Наука не состоит из ряда истин, а из методов, позволяющих открывать новые». В данном исследовании методы формальной верификации, усиленные возможностями больших языковых моделей, позволяют не просто проверять корректность систем, но и находить новые пути к построению надёжных и масштабируемых решений, опираясь на объединяющие теории программирования и уточняющий расчёт.

Куда дальше?

Предложенная работа, по сути, лишь зондирует границы возможного. Автоматизация синтеза контрактов, повторное использование артефактов на семантическом уровне — все это выглядит как элегантное решение, но лишь до тех пор, пока не столкнется с реальной сложностью программных систем. Истина, как всегда, кроется в деталях, а детали эти, как известно, коварны. Неизбежно возникнет необходимость в более глубоком понимании того, как языковые модели «мыслят» о формальных спецификациях, и как избежать ложных срабатываний, когда «похожесть» оказывается обманом.

Унификация теорий программирования — благородная цель, но потребует не только математической строгости, но и прагматичного подхода к компромиссам. В конце концов, любая аксиоматическая система — это лишь модель реальности, а реальность всегда богаче и сложнее любой модели. Вопрос не в том, чтобы создать единую теорию всего, а в том, чтобы создать инструменты, которые позволят эффективно работать с разнообразием существующих парадигм.

И, пожалуй, самое важное — это осознание того, что формальная верификация — это не самоцель, а лишь средство достижения надежности. В погоне за абсолютной точностью можно упустить главное — практическую ценность системы. Поэтому, взламывая формальные методы, необходимо помнить о том, что истинное знание — это всегда умение адаптироваться к меняющимся условиям.

Оригинал статьи: https://arxiv.org/pdf/2602.02881.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Сердце музыки: открытые модели для создания композиций

- Ищем закономерности: Новый пакет TSQCA для R

- Нейросети на грани: как перевести ИИ в логику для умных устройств

2026-02-04 20:37