Автор: Денис Аветисян

Исследователи предлагают инновационный подход к решению сложных обратных задач, объединяя глубокое обучение с теорией оптимального управления и методами проксимальной оптимизации.

В работе установлена связь между проксимальными операторами, уравнениями Гамильтона-Якоби и обучением априорных функций для повышения эффективности решения обратных задач.

Обратные задачи, требующие восстановления параметров модели по зашумленным данным, часто страдают от нечеткости и требуют регуляризации или априорной информации. В работе, посвященной ‘Deep learning methods for inverse problems using connections between proximal operators and Hamilton-Jacobi equations’, предложен новый подход, использующий связь между проксимальными операторами и уравнениями Гамильтона-Якоби для разработки глубоких нейронных сетей, способных эффективно обучать априорные функции. Ключевое новшество заключается в непосредственном обучении априорного распределения, минуя этап инверсии после тренировки, что обеспечивает высокую эффективность в задачах высокой размерности. Сможет ли предложенный метод открыть новые горизонты в решении сложных обратных задач и предоставить более точные и надежные результаты?

Обратная задача и уравнения Гамильтона-Якоби: Постановка проблемы

В различных областях науки и техники часто возникает задача восстановления неизвестных функций на основе косвенных наблюдений. Эта проблема, известная как обратная задача, встречается, например, при геофизической разведке, где необходимо определить структуру недр по сейсмическим данным, или в медицинской томографии, где по проекциям необходимо восстановить изображение внутренних органов. Суть обратной задачи заключается в том, что прямая зависимость между искомой функцией и наблюдаемыми данными неизвестна или слишком сложна для вычисления. Вместо этого доступна лишь обратная зависимость, которая может быть нестабильной и приводить к неточным или неоднозначным решениям. Поэтому, разработка эффективных методов решения обратных задач является важной проблемой, требующей использования специальных математических инструментов и алгоритмов для обеспечения стабильности и точности получаемых результатов.

Уравнения Гамильтона-Якоби представляют собой мощный математический аппарат для моделирования широкого спектра динамических систем, описывая их эволюцию во времени. Эти уравнения, берущие начало в классической механике, позволяют анализировать траектории систем, учитывая различные начальные и граничные условия. В отличие от прямого решения, где по заданным параметрам предсказывается поведение системы, уравнения Гамильтона-Якоби часто используются для анализа обратных задач — определения начальных условий или параметров системы по наблюдаемым изменениям ее состояния. Их применение выходит далеко за рамки физики, находя отражение в таких областях, как экономика, теория игр и управление, где необходимо предсказывать и оптимизировать поведение сложных систем во времени. \frac{\partial S}{\partial t} + H(\nabla S, t) = 0 — общая форма уравнения Гамильтона-Якоби, где S — функция, описывающая эволюцию системы, а H — гамильтониан, определяющий ее энергетические свойства.

В классических подходах к решению уравнений Гамильтона-Якоби, описывающих эволюцию систем, часто возникают трудности с нахождением точных, классических решений. Это обусловлено сложностью самих уравнений и спецификой задач, где требуется восстановление неизвестных функций по косвенным данным. В таких случаях на помощь приходят вязкостные решения — концепция, позволяющая определить осмысленное решение даже при отсутствии классического аналога. Вязкостные решения, по сути, рассматривают уравнение Гамильтона-Якоби не как точное равенство, а как неравенство, удовлетворяющее определенным условиям гладкости. Такой подход позволяет обойти проблемы, связанные с сингулярностями и отсутствием дифференцируемости, и получить стабильное, хоть и не всегда точное, решение, пригодное для анализа и прогнозирования поведения системы. Использование вязкостных решений открывает возможности для решения широкого круга задач, возникающих в различных областях науки и техники, где традиционные методы оказываются неэффективными.

Формулирование проблемы: Априорные функции и минимизация

Ключевым моментом при решении обратной задачи является определение подходящей априорной функции, которая кодифицирует имеющиеся знания о искомом решении. Априорная функция p(x) представляет собой вероятностное распределение, отражающее нашу уверенность в различных возможных решениях x до учета наблюдаемых данных. Эта функция позволяет включить в процесс решения информацию о свойствах решения, таких как гладкость, разреженность или принадлежность к определенному классу. Правильный выбор априорной функции существенно влияет на стабильность и качество решения обратной задачи, особенно в случаях, когда наблюдаемые данные неполны или зашумлены. Использование априорных знаний позволяет сузить пространство поиска и избежать нефизических или нереалистичных решений.

Формулирование обратной задачи как задачи минимизации предполагает поиск такой априорной функции, которая наилучшим образом согласуется с имеющимися данными наблюдений. Математически, это выражается как минимизация некоторой функциональной меры расхождения D между наблюдаемыми данными y и решением x, которое получается из априорной функции P(x). Таким образом, задача сводится к нахождению x* = argmin_x D(y, x) при условии, что x соответствует априорным знаниям, закодированным в функции P(x). Выбор функции потерь D и априорной функции P(x) критически важен для получения корректного и устойчивого решения обратной задачи.

Проксимальные операторы являются ключевым инструментом при решении задач минимизации, возникающих в обратных задачах. Они позволяют эффективно вычислять \text{prox}_{\lambda g}(x) = \arg\min_u \{ \|u - x\|_2^2 + \lambda \|u\|_{g} \} , где λ — параметр регуляризации, а g — функция, кодирующая априорные знания о решении. Использование проксимальных операторов в алгоритмах, таких как ISTA и ADMM, обеспечивает возможность включения регуляризации и априорной информации непосредственно в процесс оптимизации, что особенно важно при работе с зашумленными данными и непереопределенными задачами. Эффективность вычисления проксимального оператора для конкретной функции g существенно влияет на скорость и точность решения обратной задачи.

Обученные проксимальные сети: Подход, основанный на данных

Основой Learned Proximal Networks (LPN) является использование данных для аппроксимации проксимального оператора. Вместо аналитического вычисления, которое часто требует знания внутренней структуры функции, LPN обучаются на основе наблюдаемых значений функции и ее градиентов. Это позволяет сети выучить представление проксимального оператора непосредственно из данных, что особенно полезно в задачах, где аналитическое решение недоступно или вычислительно затратно. Процесс обучения основан на минимизации ошибки между предсказанным проксимальным оператором и его истинным значением, вычисленным на основе имеющихся данных. Таким образом, LPN представляют собой параметризованные модели, способные адаптироваться к различным функциям и задачам оптимизации.

В архитектуре Learned Proximal Networks (LPN) используются Convex Neural Networks (CNN) для обеспечения выпуклости ограничений, что критически важно для обеспечения стабильности и сходимости алгоритмов. Применение CNN гарантирует, что аппроксимированный проксимальный оператор сохраняет свойства выпуклых функций, предотвращая осцилляции и расходимость при решении оптимизационных задач. Выпуклость, наложенная CNN, позволяет применять стандартные методы анализа и доказывать сходимость алгоритмов, что особенно важно при работе со сложными и негладкими функциями потерь. Такой подход позволяет эффективно обучать проксимальный оператор на данных и получать устойчивые результаты даже при ограниченном объеме обучающей выборки.

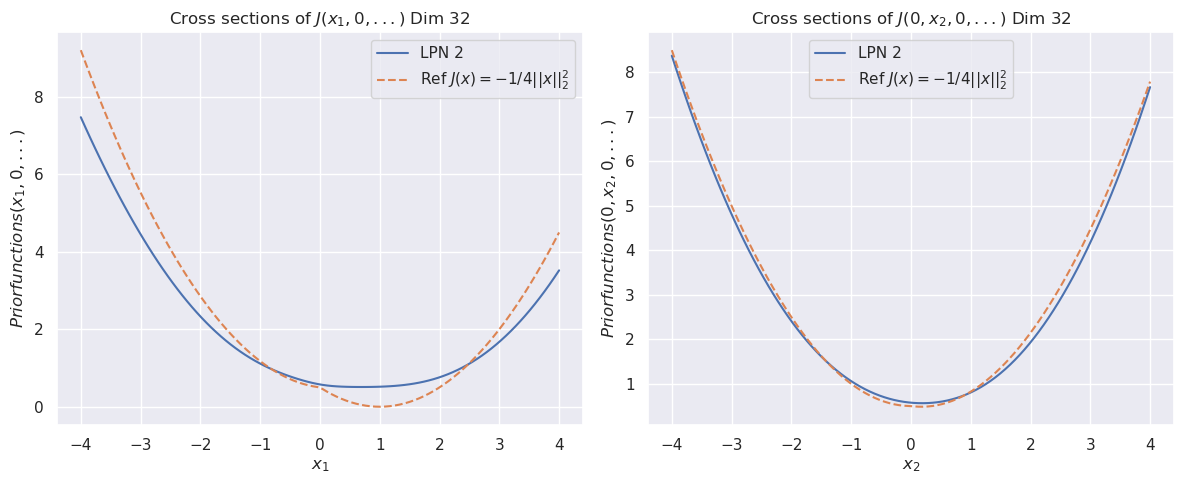

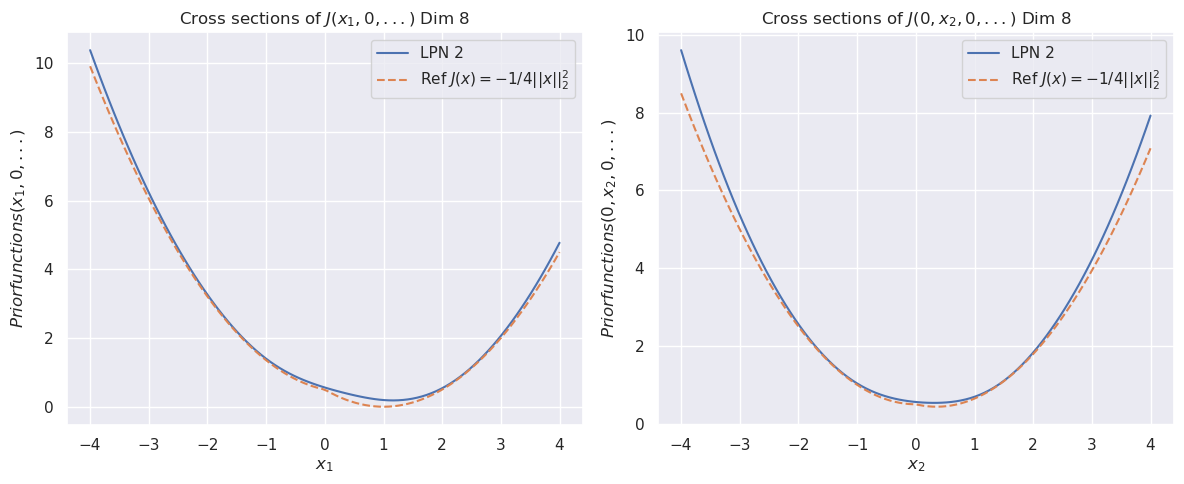

Использование данных для обучения априорной функции позволяет эффективно решать сложные обратные задачи, даже при ограниченном объеме данных. Экспериментальные результаты демонстрируют высокую точность реконструкции априорной функции в пространствах размерности от 2 до 8, с достижением значений среднеквадратичной ошибки (MSE) в диапазоне от 10-7 до 10-4. Такая точность подтверждает эффективность предлагаемого подхода для задач, где явное определение априорной функции затруднительно или невозможно.

Валидация и перспективы

Тщательный анализ ошибок является основополагающим этапом при оценке эффективности локальных полиномиальных приближений (LPN) и выявлении границ их применимости. Понимание природы и величины возникающих погрешностей позволяет не только количественно оценить качество реконструкции, но и определить области, где данное приближение может быть недостаточно точным или вовсе неприменимым. Детальное изучение источников ошибок, таких как размерность пространства, сложность аппроксимируемой функции и параметры алгоритма, необходимо для разработки стратегий повышения точности и надежности LPN. Особенно важно учитывать, что даже незначительные погрешности могут существенно повлиять на результаты в чувствительных приложениях, поэтому строгий контроль качества и валидация являются ключевыми для обеспечения достоверности получаемых данных и выводов.

Несмотря на некоторое снижение точности, выраженное в значениях среднеквадратичной ошибки (MSE) в диапазоне от 10-3 до 10-1 при работе с пространствами высокой размерности (16D-32D), разработанный метод демонстрирует высокую степень качественного визуального приближения. В частности, удается достоверно реконструировать поперечные сечения как выпуклых функций, так и априорных функций, что подтверждает его эффективность даже при увеличении сложности задачи. Этот результат свидетельствует о сохранении способности метода улавливать основные характеристики исходных данных и представлять их в понятной визуальной форме, несмотря на неизбежные погрешности, возникающие при работе с многомерными пространствами.

Перспективы данного подхода заключаются в его масштабировании для решения задач в пространствах большей размерности, что открывает возможности для существенного прогресса в различных областях науки и техники. Внедрение дополнительных априорных знаний, таких как специфические свойства решаемых функций или ограничения на их поведение, позволит повысить точность и эффективность алгоритма, а также расширить спектр применимых задач. Например, в задачах машинного обучения это может привести к созданию более устойчивых и обобщающих моделей, а в инженерных расчетах — к ускорению и оптимизации сложных симуляций. Дальнейшие исследования в этом направлении могут способствовать разработке новых методов анализа данных и решения оптимизационных задач, находящих применение в таких областях, как финансовое моделирование, обработка изображений и физика.

Исследование демонстрирует элегантную взаимосвязь между, казалось бы, далёкими областями математики и машинного обучения. Авторы подчеркивают, что эффективное решение обратных задач требует не просто оптимизации, а глубокого понимания структуры данных и априорных знаний. Как отмечал Никола Тесла: «Самое важное — это связность». Действительно, представленная работа показывает, как установление связи между проксимальными операторами, уравнениями Гамильтона-Якоби и методами глубокого обучения позволяет создавать более мощные и адаптивные системы для решения сложных задач, где целостное восприятие системы и взаимосвязь её частей критически важны для достижения оптимального результата. Успех подхода напрямую зависит от способности моделировать априорные знания, что согласуется с принципом, что структура определяет поведение.

Куда дальше?

Представленная работа, касаясь связи между проксимальными операторами, уравнениями Гамильтона-Якоби и возможностями глубинного обучения, открывает интересные перспективы, но и поднимает вопросы, требующие осмысления. Необходимо осознать, что оптимизация функции при решении обратных задач — это лишь следствие, а истинная цель часто скрыта в структуре самой задачи и природе априорных ограничений. Поиск этих ограничений, выявление фундаментальных принципов, лежащих в основе эффективных проксимальных операторов, представляется более важной задачей, чем бесконечная гонка за улучшением численных методов.

Простота — не минимализм, но четкое разграничение необходимого и случайного. В стремлении к «обучению априорных знаний» из данных, существует риск упустить из виду инвариантные свойства задачи, которые могли бы быть сформулированы аналитически. Использование глубоких нейронных сетей как универсальных аппроксиматоров может привести к потере интерпретируемости и, как следствие, к созданию «черных ящиков», неспособных к обобщению в новых условиях. Ключевым моментом является разработка архитектур, позволяющих явно учитывать структуру задачи и обеспечивать устойчивость к шуму и неопределенности.

В конечном счете, успех данного направления исследований будет зависеть не только от улучшения численных алгоритмов, но и от глубокого понимания природы обратных задач и априорных знаний, необходимых для их эффективного решения. Необходимо помнить, что хорошая система — это живой организм, и нельзя чинить одну часть, не понимая целого. Иначе, все усилия рискуют превратиться в бесконечное перебирание параметров, не приближающее к истинной элегантности и ясности.

Оригинал статьи: https://arxiv.org/pdf/2512.23829.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Восполняя пробелы в знаниях: Как языковые модели учатся делать выводы

- Квантовый Монте-Карло: Моделирование рождения электрон-позитронных пар

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Виртуальная примерка без границ: EVTAR учится у образов

- Насколько важна полнота при оценке поиска?

- Переключение намагниченности в квантовых антиферромагнетиках: новые горизонты для терагерцовой спинтроники

- Геометрия на пределе: как алгоритмы оптимизации превосходят языковые модели

- Оптимизация партийных запросов: Метод имитации отжига против градиентных подходов

- Квантовый скачок из Андхра-Прадеш: что это значит?

- Скрытая сложность: Необратимые преобразования в квантовых схемах

2026-01-04 22:09