Автор: Денис Аветисян

Обзор показывает, как методы искусственного интеллекта меняют ландшафт высокопроизводительных вычислений и открывают новые возможности для оптимизации и управления сложными системами.

Анализ применения искусственного интеллекта в планировании задач, обнаружении неисправностей и оптимизации производительности высокопроизводительных вычислительных систем, включая перспективы интеграции больших языковых моделей в операционные системы.

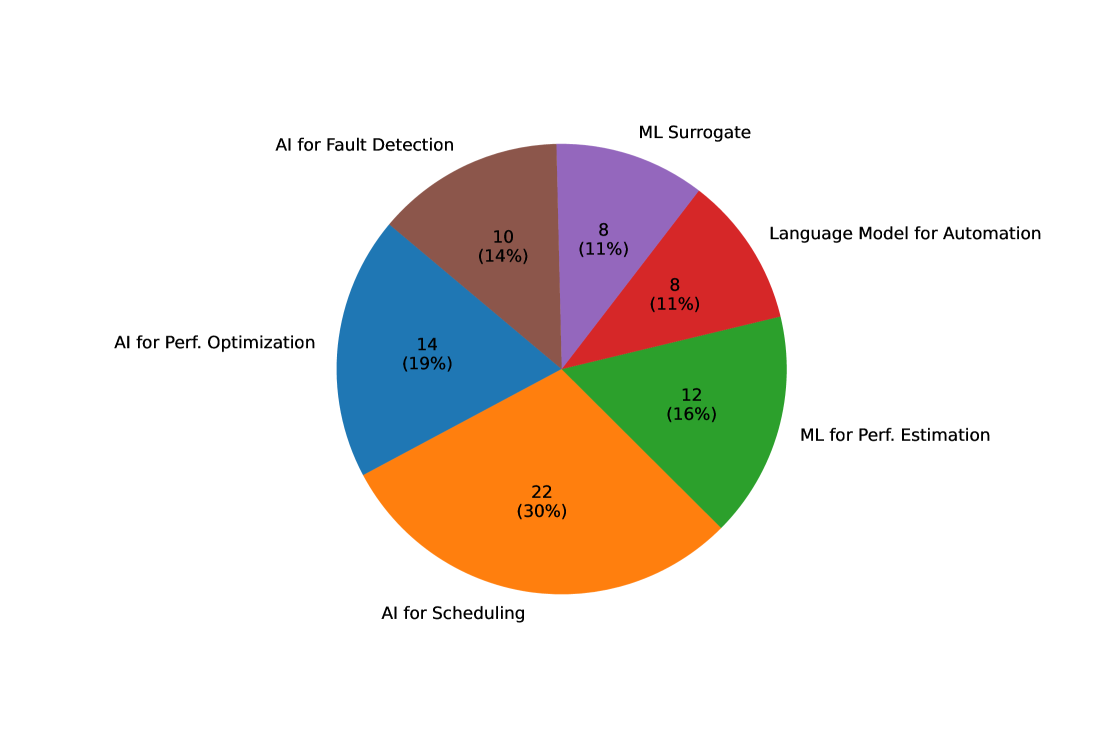

Потребление энергии и эксплуатационные расходы в высокопроизводительных вычислительных центрах (HPC) представляют собой серьезную проблему, требующую инновационных решений. Данный обзор посвящен исследованию возможностей искусственного интеллекта (ИИ), включая машинное обучение и оптимизацию, для повышения эффективности операционных HPC-систем в рамках работы ‘What Artificial Intelligence can do for High-Performance Computing systems?’. Анализ около 1800 публикаций выявил ключевые направления, такие как планирование, оптимизация производительности и обнаружение неисправностей, а также перспективные возможности интеграции больших языковых моделей в операционные системы. Каким образом дальнейшее развитие MLOps, стандартизация ИИ-компонентов и разработка новых методик оценки позволят полностью раскрыть потенциал ИИ для создания интеллектуальных и адаптивных вычислительных сред?

Разрушая Ограничения: Искусственный Интеллект в Высокопроизводительных Вычислениях

Традиционные методы высокопроизводительных вычислений (ВВВ) сталкиваются со всё возрастающими трудностями при решении современных научных задач. Усложнение моделей и объёмов данных приводят к экспоненциальному росту вычислительных затрат, что ограничивает возможности исследования в таких областях, как климатология, материаловедение и биоинформатика. Проблема усугубляется физическими ограничениями, связанными с производством и энергопотреблением традиционных процессоров. Несмотря на постоянное увеличение мощности суперкомпьютеров, темпы роста вычислительных ресурсов не успевают за потребностями науки, что требует поиска принципиально новых подходов к решению сложных проблем и оптимизации использования доступных ресурсов. В результате, исследователи всё чаще обращаются к альтернативным методам, способным преодолеть эти ограничения и обеспечить дальнейший прогресс в научных исследованиях.

Искусственный интеллект представляет собой принципиально новый подход к организации вычислений в высокопроизводительных вычислительных системах (HPC). Вместо традиционного, статичного распределения ресурсов, алгоритмы машинного обучения позволяют динамически адаптировать вычислительные мощности к текущим потребностям решаемой задачи. Это достигается за счет анализа данных о производительности, прогнозирования нагрузки и оптимизации распределения задач между вычислительными узлами. Такой подход позволяет существенно повысить эффективность использования ресурсов, сократить время вычислений и решать задачи, которые ранее были недоступны из-за их сложности или объема. Более того, применение AI открывает возможности для автоматизации процессов управления HPC-инфраструктурой, снижая необходимость в ручном вмешательстве и повышая надежность системы.

В современной высокопроизводительной вычислительной технике (ВВТ) наблюдается переход от традиционных методов, основанных на моделировании, к подходам, управляемым данными. Данный обзор синтезирует результаты 74 недавних научных работ, демонстрирующих, что использование данных позволяет значительно расширить возможности ВВТ при решении все более сложных научных задач. Вместо построения детальных симуляций, искусственный интеллект анализирует большие объемы данных, выявляет закономерности и предлагает оптимальные решения. Этот подход позволяет ускорить вычисления, повысить точность результатов и исследовать ранее недоступные области знаний, открывая новые перспективы в науке и технике. Переход к управлению данными является ключевым фактором для дальнейшего развития ВВТ и реализации всего потенциала искусственного интеллекта в научных исследованиях.

Оптимизация через Машинное Обучение: Новый Взгляд на Высокопроизводительные Вычисления

Алгоритмы машинного обучения, в особенности методы глубокого обучения, предоставляют эффективные инструменты для моделирования и оптимизации сложных процессов в высокопроизводительных вычислениях (HPC). Эти алгоритмы способны анализировать большие объемы данных, генерируемые в процессе работы HPC-систем, и выявлять закономерности, недоступные традиционным методам анализа. Они позволяют строить прогностические модели для предсказания производительности, потребления ресурсов и выявления узких мест, что позволяет автоматически настраивать параметры системы для достижения максимальной эффективности. Глубокие нейронные сети, в частности, показали свою эффективность в задачах, требующих обработки сложных нелинейных зависимостей, характерных для современных HPC-приложений.

Оценка производительности в высокопроизводительных вычислениях (HPC) значительно улучшается за счет использования моделей машинного обучения для прогнозирования времени выполнения и использования ресурсов. Традиционные методы часто требуют дорогостоящих и длительных экспериментов для определения оптимальных параметров конфигурации. В отличие от них, модели машинного обучения, обученные на исторических данных о выполнении задач, способны с высокой точностью предсказывать время выполнения и потребление ресурсов для новых задач и конфигураций. Это позволяет оптимизировать распределение ресурсов, планировать рабочие нагрузки и прогнозировать общую производительность системы без необходимости проведения обширных экспериментальных тестов. Точность прогнозирования зависит от качества и объема обучающих данных, а также от выбора подходящей модели машинного обучения, например, регрессионных моделей или нейронных сетей.

Оптимизация производительности в высокопроизводительных вычислениях (HPC) активно использует методы, такие как байесовская оптимизация и целочисленное линейное программирование (ЦЛП) для тонкой настройки конфигураций системы. Байесовская оптимизация эффективно исследует пространство параметров, используя вероятностные модели для предсказания производительности и выбора наиболее перспективных конфигураций для тестирования. ЦЛП, в свою очередь, позволяет решать задачи дискретной оптимизации, находя оптимальные значения параметров конфигурации, удовлетворяющие заданным ограничениям, например, по энергопотреблению или доступным ресурсам. Комбинирование этих подходов позволяет автоматизировать процесс поиска оптимальных конфигураций, значительно превосходящие результаты, полученные вручную, и адаптироваться к изменяющимся условиям вычислительной среды.

Современные системы управления задачами в высокопроизводительных вычислениях (HPC) все чаще используют модели машинного обучения для динамического распределения ресурсов. Это позволяет учитывать требования каждой задачи и текущее состояние системы, повышая общую эффективность использования вычислительных мощностей. Наблюдаемый рост числа систем из списка Top500, оснащенных ускорителями, с 64 из 500 в июне 2014 года до 195 из 500 в июне 2024 года, подтверждает возрастающую потребность в продвинутых методах оптимизации, включая машинное обучение, для эффективной эксплуатации гетерогенных вычислительных ресурсов.

Обеспечение Надёжности: Искусственный Интеллект в Обнаружении Неисправностей

Обнаружение неисправностей в системах высокопроизводительных вычислений (HPC) является критически важным для минимизации времени простоя и обеспечения целостности данных. Неисправности могут возникать на различных уровнях — от сбоев отдельных компонентов до проблем с программным обеспечением или сетевыми подключениями. Простой, вызванный неисправностью, приводит к потере вычислительных ресурсов, срыву сроков выполнения задач и потенциальной потере или повреждению данных. Эффективное обнаружение неисправностей позволяет оперативно реагировать на возникающие проблемы, изолировать неисправные компоненты и восстановить нормальную работу системы, снижая финансовые и научные потери. Поэтому, разработка и внедрение надежных механизмов обнаружения неисправностей является приоритетной задачей для операторов и разработчиков HPC-систем.

Нейронные сети на графах (Graph Neural Networks, GNN) представляют собой эффективный метод обнаружения ошибок и сбоев в высокопроизводительных вычислительных системах (HPC) благодаря их способности анализировать зависимости и паттерны коммуникации между компонентами системы. В отличие от традиционных методов, GNN моделируют систему как граф, где узлы представляют вычислительные ресурсы (процессоры, память, сетевые интерфейсы), а ребра — взаимосвязи между ними. Анализируя структуру этого графа и данные о взаимодействии между узлами, GNN могут выявлять аномалии, указывающие на потенциальные или текущие сбои. Это позволяет обнаруживать ошибки, связанные с нарушением связей, перегрузкой отдельных ресурсов или неверной конфигурацией, что существенно повышает надежность и устойчивость всей системы.

Су́ррогатное модели́рование снижа́ет вы́числительные за́траты на обнаруже́ние отка́зов за счёт аппроксима́ции сло́жных поведенческих моде́лей систе́мы. Вместо непосредственного анализа детальных процессов, требующих значительных ресурсов, создаётся упрощённая модель, представляющая собой математическое приближение исходного поведения. Это позволяет проводить быстрый анализ и предсказание потенциальных отказов с существенно меньшими вычислительными издержками, что особенно важно для крупномасштабных вычислительных систем, где полный анализ может быть непрактичным или невозможным из-за ограничений времени и ресурсов. Точность суррогатной модели напрямую влияет на эффективность обнаружения отказов, поэтому выбор подходящего метода аппроксимации и тщательная валидация модели являются критически важными.

Применение методов искусственного интеллекта в высокопроизводительных вычислениях (HPC) способствует повышению устойчивости и эффективности вычислительных процессов. Несмотря на увеличение средней энергоэффективности до 15.2 PFLOPS/Watt, общий средний уровень энергопотребления 500 самых мощных HPC-систем возрос с 1.1 МВт в июне 2014 года до 2.1 МВт в июне 2024 года. Данный тренд подчеркивает необходимость дальнейшей оптимизации управления ресурсами и разработки более эффективных алгоритмов для снижения энергозатрат в сфере HPC.

Взгляд в Будущее: Интеллектуальные HPC с LLM-Системами

Возможности взаимодействия и управления высокопроизводительными вычислительными ресурсами (HPC) претерпевают значительные изменения благодаря развитию обработки естественного языка и, в особенности, больших языковых моделей. Традиционные методы, требующие специализированных знаний и сложного синтаксиса команд, уступают место интуитивно понятному управлению посредством обыденного языка. Языковые модели способны интерпретировать запросы, сформулированные на естественном языке, преобразуя их в конкретные инструкции для системы. Это позволяет исследователям и инженерам, не являющимся экспертами в области системного администрирования, эффективно использовать мощь HPC для решения сложных научных задач, автоматизируя рутинные операции и значительно упрощая процесс работы с вычислительными кластерами. Такой подход открывает двери для более широкого круга пользователей, стимулируя инновации и ускоряя темпы научных открытий.

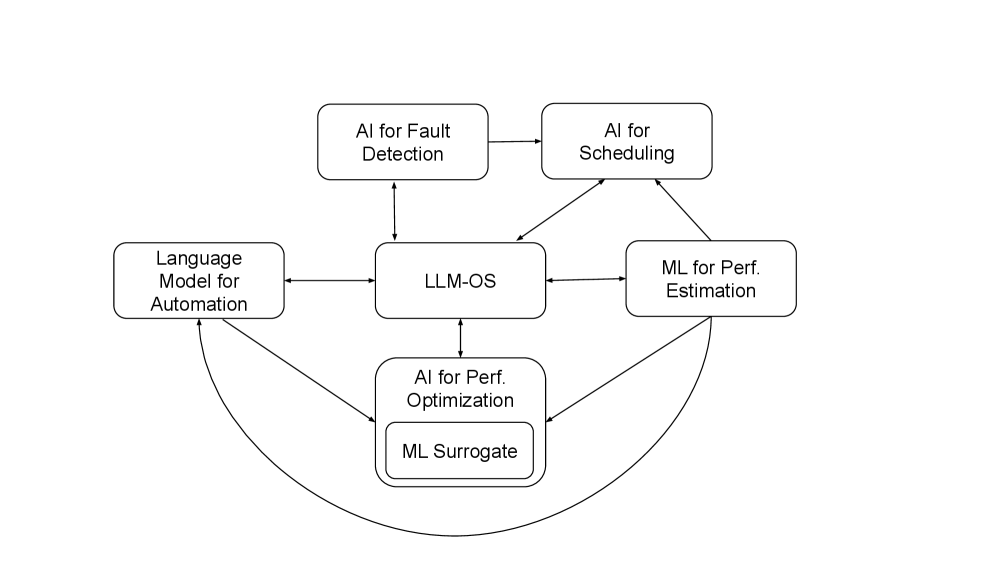

Операционные системы на основе больших языковых моделей (LLM) представляют собой качественно новый подход к управлению высокопроизводительными вычислительными системами (HPC). Вместо традиционных, требующих детальной настройки и ручного вмешательства, LLM-системы способны автоматизировать сложные задачи, такие как конфигурирование, мониторинг и масштабирование ресурсов. Благодаря способности понимать естественный язык, пользователи могут взаимодействовать с HPC-системами, используя простые команды и запросы, что значительно упрощает управление и повышает доступность для специалистов без глубоких знаний в области системного администрирования. Автоматизация, обеспечиваемая LLM, не только снижает операционные издержки, но и позволяет высвободить ресурсы для более важных задач, таких как разработка и анализ научных данных, что в конечном итоге ускоряет процесс научных открытий и инноваций.

Системы высокопроизводительных вычислений (HPC) все чаще используют обучение с подкреплением для динамической адаптации к изменяющимся рабочим нагрузкам и оптимизации производительности в режиме реального времени. Этот подход позволяет системам самостоятельно изучать оптимальные стратегии управления ресурсами, анализируя результаты своих действий и корректируя поведение для достижения максимальной эффективности. Вместо жестко заданных правил, HPC-системы, оснащенные алгоритмами обучения с подкреплением, способны выявлять закономерности в данных о нагрузке, прогнозировать будущие потребности и автоматически настраивать параметры работы, такие как распределение памяти, частота процессора и пропускная способность сети. Такая самообучающаяся способность особенно важна в сценариях с непредсказуемыми или быстро меняющимися вычислительными задачами, позволяя значительно повысить эффективность использования ресурсов и сократить время выполнения сложных вычислений.

Интеграция искусственного интеллекта и высокопроизводительных вычислений (HPC) знаменует наступление новой эры интеллектуальных вычислений, способной значительно ускорить научные открытия и инновации. В рамках всестороннего анализа 74 научных работ были выделены шесть ключевых областей, определяющих развитие систем на базе больших языковых моделей (LLM). К ним относятся оценка производительности, планирование задач, обнаружение неисправностей, оптимизация ресурсов, использование суррогатных моделей и автоматизация процессов. Эти направления исследований формируют основу для создания адаптивных и самооптимизирующихся HPC-систем, способных решать сложнейшие научные задачи с беспрецедентной эффективностью и скоростью, открывая новые горизонты для исследований в различных областях науки и техники.

Исследование возможностей применения искусственного интеллекта в высокопроизводительных вычислениях (HPC) демонстрирует, что понимание системы позволяет не просто использовать её, но и значительно расширять её возможности. Как отмечала Ада Лавлейс: «Изобретение вычислительной машины не создает оригинальные идеи; оно может делать лишь то, что мы повелим». В контексте LLM-OS, предложенных в статье, это особенно актуально: машина способна выполнять задачи, которые ей заданы, но именно интеллект, интегрированный в операционную систему, позволяет адаптироваться к изменяющимся условиям и оптимизировать производительность, выходя за рамки изначально запрограммированных функций. Таким образом, статья подтверждает идею о том, что знание и понимание системы — ключ к её эффективному использованию и дальнейшему развитию.

Что дальше?

Рассмотренные подходы к интеграции искусственного интеллекта в высокопроизводительные вычисления обнажают не столько решения, сколько новые грани сложности. Автоматизация планирования задач и предсказание сбоев — это лишь первые шаги. Истинный прорыв кроется не в оптимизации существующих систем, а в создании принципиально новых архитектур, способных к самообучению и адаптации в реальном времени. Предложенная концепция LLM-OS — это не просто операционная система с «умным» интерфейсом, а попытка взлома самой парадигмы управления вычислительными ресурсами.

Однако, заманчивая перспектива «самоорганизующегося» кластера таит в себе и опасность. Необходимо осознавать, что доверие к алгоритмам, особенно тем, что оперируют критически важными данными, требует радикальной прозрачности и возможности верификации. Иначе, мы рискуем создать чёрный ящик, чьи решения будут неподконтрольны и, возможно, нелогичны с человеческой точки зрения. Понимание системы — это не просто её использование, но и возможность её реверс-инжиниринга.

Будущее высокопроизводительных вычислений — это не столько гонка за вычислительной мощностью, сколько искусство управления сложностью. Искусственный интеллект здесь — не панацея, а инструмент, требующий тщательной калибровки и постоянного контроля. Задача состоит не в том, чтобы заставить машину думать как человек, а в том, чтобы понять, как машина «видит» реальность, и использовать это знание для создания более эффективных и надёжных вычислительных систем.

Оригинал статьи: https://arxiv.org/pdf/2602.00014.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Сердце музыки: открытые модели для создания композиций

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Искусственный исследователь: Новые горизонты автономных агентов

- Интеллектуальный поиск научных статей: новый подход к исследованию литературы

- Голос в переводе: как нейросети учатся понимать речь

2026-02-04 00:25