Автор: Денис Аветисян

Новая статья предлагает практическую структуру для оценки и проверки систем искусственного интеллекта высокого риска в соответствии с европейским законодательством.

Предлагается структурированный подход к переводу общих требований EU AI Act в конкретные, тестируемые компоненты для систем искусственного интеллекта высокого риска.

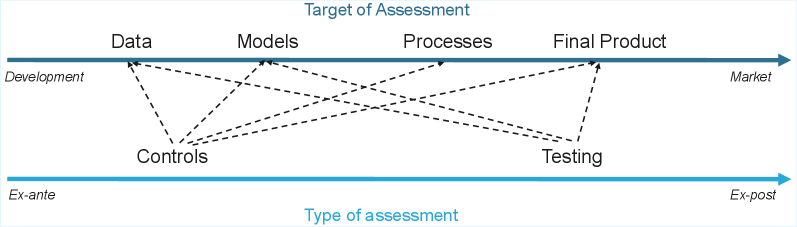

Несмотря на растущее признание необходимости регулирования искусственного интеллекта, практическая реализация положений Акта об ИИ ЕС сталкивается с проблемой отсутствия систематического подхода к верификации соответствия. В данной работе, ‘Assessing High-Risk Systems: An EU AI Act Verification Framework’, предложен комплексный фреймворк, организующий процесс проверки соответствия по двум ключевым параметрам: методу контроля и объекту оценки, включая данные, модели и процессы. Предлагаемый подход призван сопоставить юридические требования с конкретными верификационными активностями, обеспечивая тем самым согласованность между регуляторными, этическими и техническими аспектами. Сможет ли данный фреймворк стать основой для унифицированной практики оценки и повышения доверия к системам искусственного интеллекта в рамках Европейского Союза?

Пророчество Регуляторной Бури: Навигация в Мире ИИ

Законодательный акт Европейского союза об искусственном интеллекте (AI Act) готовит глубокие изменения в сфере разработки и внедрения ИИ по всему миру, особое внимание уделяя так называемым “высокорисковым системам”. Данный акт классифицирует ИИ-системы по уровню риска, и те, которые могут представлять угрозу для безопасности, прав человека или основных принципов демократии, подлежат строгим требованиям к прозрачности, ответственности и контролю. Это означает, что разработчики и поставщики таких систем должны будут демонстрировать соответствие определенным стандартам качества, проводить оценку рисков и обеспечивать возможность аудита алгоритмов. Ожидается, что AI Act станет глобальным стандартом, влияя на законодательство и практики в других странах, стремящихся регулировать быстро развивающуюся область искусственного интеллекта.

Новое законодательство в области искусственного интеллекта требует от разработчиков и внедряющих компаний не просто реагировать на возникающие риски, но и активно предвидеть и предотвращать их на всех этапах жизненного цикла системы. Это подразумевает внедрение комплексных мер по управлению рисками, включающих в себя тщательное тестирование, валидацию данных и алгоритмов, а также постоянный мониторинг производительности системы. Особое внимание уделяется вопросам этики, прозрачности и подотчетности, что предполагает разработку четких принципов и процедур, гарантирующих соблюдение прав и свобод человека. Качество и надежность систем искусственного интеллекта становятся приоритетными, а обеспечение соответствия высоким стандартам — необходимостью для успешного функционирования и завоевания доверия со стороны пользователей и регулирующих органов.

Организации сегодня сталкиваются с необходимостью создания надежных систем управления, чтобы соответствовать новым регуляторным требованиям в области искусственного интеллекта и завоевать доверие пользователей. Разработка таких систем включает в себя не только соблюдение формальных норм, но и внедрение принципов прозрачности, подотчетности и этической ответственности на всех этапах жизненного цикла ИИ-систем. Акцент делается на создании внутренних процедур, обеспечивающих регулярный мониторинг, оценку рисков и оперативное исправление выявленных недостатков. Подобный подход позволяет продемонстрировать приверженность высоким стандартам качества и безопасности, что, в свою очередь, способствует укреплению репутации и долгосрочному успеху на рынке.

Несоблюдение новых регуляторных требований в области искусственного интеллекта, установленных, например, Актом об ИИ в Европейском Союзе, влечет за собой серьезные последствия для компаний. Помимо значительных финансовых штрафов, достигающих миллионов евро или процента от мирового годового оборота, организации рискуют утратить доступ к ключевым рынкам, особенно в пределах Европейского экономического пространства. Это создает существенные препятствия для внедрения инновационных AI-решений и ограничивает возможности для развития бизнеса. Компании, не сумевшие продемонстрировать соответствие стандартам в отношении рисков, качества и этических норм, могут столкнуться с задержками в получении разрешений, запретом на использование определенных технологий и потерей конкурентоспособности на глобальном рынке.

Управление Рисками: Строим Надежную Основы ИИ

Комплексный процесс управления рисками является основополагающим для демонстрации соответствия требованиям Акта ЕС об искусственном интеллекте, обеспечивая проактивную идентификацию и смягчение потенциального вреда. Этот процесс включает в себя оценку рисков, связанных с разработкой и применением систем ИИ, на протяжении всего жизненного цикла — от проектирования и обучения до развертывания и мониторинга. Идентификация рисков должна учитывать как технические аспекты (например, предвзятость данных, надежность алгоритмов), так и этические и социальные последствия применения ИИ. Реализация мер по смягчению рисков может включать в себя технические решения (например, использование методов повышения надежности и справедливости), организационные меры (например, разработка политик и процедур) и юридические гарантии. Документирование процесса управления рисками, включая идентификацию рисков, оценку их вероятности и серьезности, а также принятые меры по смягчению, является необходимым условием для демонстрации соответствия нормативным требованиям и обеспечения подотчетности.

Система управления качеством (СУК) играет ключевую роль в обеспечении соответствия разрабатываемых систем искусственного интеллекта (ИИ) нормативным требованиям и этическим стандартам. СУК охватывает все этапы жизненного цикла ИИ — от проектирования и разработки до тестирования, внедрения и мониторинга — обеспечивая последовательное применение стандартов качества на каждом этапе. Это включает в себя формализованные процедуры для проверки данных, валидации моделей, оценки производительности и выявления потенциальных рисков. Регулярный мониторинг и аудит процессов разработки, а также документальное подтверждение соответствия установленным критериям, являются неотъемлемой частью СУК и позволяют продемонстрировать соответствие требованиям регуляторов, таких как предписания, содержащиеся в Акте об ИИ Европейского Союза.

Подробная техническая документация является критически важным элементом для подтверждения соответствия нормативным требованиям и обеспечения прослеживаемости. Она должна включать детальное описание архитектуры системы искусственного интеллекта, алгоритмов, используемых данных, процессов обучения и валидации, а также результаты тестирования и оценки рисков. Эта документация должна быть актуальной, полной и доступной для аудита со стороны регулирующих органов и внутренних заинтересованных сторон. В частности, необходимо документировать процессы управления данными, включая источники, преобразования и контроль качества, а также меры по обеспечению конфиденциальности и безопасности данных. Отсутствие или неполнота технической документации может привести к несоблюдению требований законодательства и затруднить демонстрацию должной осмотрительности.

Тщательное ведение документации является основой для обеспечения прослеживаемости и подотчетности при разработке и внедрении систем искусственного интеллекта. Необходимо фиксировать все этапы жизненного цикла ИИ, включая сбор и обработку данных, обучение моделей, тестирование и развертывание, а также любые изменения или обновления. В записи должны быть указаны ответственные лица, используемые алгоритмы, параметры и результаты оценки рисков. Подробная и актуальная документация позволяет продемонстрировать надлежащую осмотрительность (due diligence) в случае проверок со стороны регулирующих органов или при возникновении инцидентов, а также обеспечивает возможность воспроизведения и анализа результатов работы системы ИИ.

За пределами соответствия: Принципы доверия к ИИ

Обеспечение человеческого контроля и ответственности за работу систем искусственного интеллекта является первостепенной задачей для предотвращения нежелательных последствий. Это предполагает внедрение механизмов, позволяющих людям осуществлять значимое влияние на принятие решений ИИ, а также нести ответственность за результаты этих решений. Важно, чтобы операторы и другие заинтересованные стороны имели возможность контролировать, корректировать и при необходимости отменять действия ИИ, особенно в критически важных ситуациях. Недостаточно простого мониторинга; необходимы инструменты для активного вмешательства и управления системой, гарантирующие, что ИИ действует в соответствии с человеческими ценностями и намерениями, и что любые ошибки или отклонения могут быть оперативно устранены.

Техническая надёжность и безопасность являются критически важными аспектами разработки и внедрения систем искусственного интеллекта. Это подразумевает, что системы должны демонстрировать стабильную работу не только в штатных режимах, но и в условиях, приближенных к неблагоприятным, включая воздействие шумов, неполноты данных, а также преднамеренных или случайных атак. Обеспечение надёжности требует применения методов верификации и валидации, включающих стресс-тестирование, анализ отказов и оценку устойчивости к различным типам входных данных. Безопасность, в свою очередь, предполагает защиту от несанкционированного доступа, манипулирования данными и других угроз, которые могут привести к непредсказуемым или опасным последствиям. Реализация этих принципов требует комплексного подхода, включающего проектирование с учётом отказоустойчивости, использование безопасных алгоритмов и постоянный мониторинг производительности системы.

Эффективное управление данными является ключевым фактором для обеспечения надежности и точности систем искусственного интеллекта. Это включает в себя внедрение строгих процедур контроля качества данных, проверки их актуальности и репрезентативности. Недостаточное внимание к этим аспектам может привести к систематическим ошибкам и предвзятости в работе ИИ. Особое внимание следует уделять обеспечению разнообразия данных, чтобы избежать ситуаций, когда система обучается на неполном или искаженном наборе информации. Внедрение механизмов аудита и валидации данных позволяет своевременно выявлять и устранять несоответствия, что напрямую влияет на производительность и справедливость принимаемых ИИ решений.

Прозрачность, достигаемая посредством методов, таких как Объяснимый Искусственный Интеллект (XAI), является ключевым фактором для формирования доверия к системам ИИ и обеспечения эффективного контроля. Методы XAI позволяют пользователям понимать логику принятия решений ИИ, выявлять факторы, влияющие на результаты, и оценивать потенциальные риски. Это особенно важно в критически важных областях, таких как здравоохранение, финансы и правосудие, где необходимо обосновывать решения и обеспечивать ответственность. Прозрачность не только облегчает выявление и исправление ошибок, но и способствует более широкому принятию и использованию технологий ИИ, поскольку пользователи получают возможность контролировать и понимать их работу.

Укрепление управления с помощью международных стандартов

Стандарты, такие как ISO/IEC 42001, предлагают комплексную систему управления искусственным интеллектом, ориентированную на оценку и смягчение рисков, а также на обеспечение надлежащего управления. Эта система не просто определяет потенциальные опасности, но и предоставляет структурированный подход к их предотвращению и контролю на всех этапах жизненного цикла ИИ. Особенно важно, что данный стандарт разработан с учетом требований Акта об искусственном интеллекте Европейского Союза, обеспечивая тем самым соответствие разрабатываемых систем самым современным нормативным требованиям и способствуя созданию надежных и ответственных технологий. Внедрение ISO/IEC 42001 позволяет организациям демонстрировать приверженность принципам этичного и безопасного ИИ, укрепляя доверие со стороны пользователей и заинтересованных сторон.

Стандарт ISO 23894 представляет собой структурированный подход к управлению рисками, связанными с искусственным интеллектом, и предлагает комплексный механизм для выявления и смягчения потенциального вреда. В его основе лежит систематическая оценка рисков на протяжении всего жизненного цикла системы ИИ — от проектирования и разработки до внедрения и эксплуатации. Данный стандарт не ограничивается лишь техническими аспектами, но и учитывает организационные факторы, этические соображения и потенциальное влияние на общество. Применение ISO 23894 позволяет организациям не только минимизировать негативные последствия, связанные с использованием ИИ, но и демонстрировать ответственный подход к разработке и внедрению инновационных технологий, укрепляя доверие к системам искусственного интеллекта.

Для повышения надёжности и безопасности систем искусственного интеллекта, инструменты обнаружения вторжений играют ключевую роль в обеспечении технической устойчивости. Эти системы способны выявлять и нейтрализовать злонамеренные атаки, направленные на компрометацию данных или нарушение функционирования ИИ. Обнаружение вторжений позволяет оперативно реагировать на возникающие угрозы, минимизируя потенциальный ущерб и обеспечивая бесперебойную работу системы. Внедрение подобных инструментов не только усиливает защиту от внешних атак, но и способствует созданию более устойчивой и безопасной инфраструктуры для развития и применения технологий искусственного интеллекта, что особенно важно в контексте растущих требований к безопасности и надёжности.

Внедрение международных стандартов в области искусственного интеллекта не просто демонстрирует приверженность лучшим практикам, но и существенно повышает доверие к соответствующим системам. Представленная в данной работе структура сопоставляет требования Акта ЕС об ИИ с конкретными техническими и организационными механизмами, охватывающими четыре ключевые области: данные, модель, процессы и конечный продукт. Такой подход обеспечивает проверяемое соответствие нормативным требованиям и позволяет перейти от деклараций о надежности к её реальной реализации, формируя основу для ответственного и устойчивого развития технологий искусственного интеллекта.

Предлагаемый документ рассматривает сложные системы не как статичные конструкции, а как динамичные сущности, требующие постоянной адаптации к меняющимся условиям. Этот подход перекликается с убеждением Джона Маккарти: «Всякий, кто рассматривает сложные системы как простые, неизбежно столкнется с неприятностями». Работа акцентирует внимание на необходимости трансляции общих требований регулятора в конкретные, проверяемые компоненты, что соответствует идее о том, что истинная надежность системы заключается не в ее абсолютной стабильности, а в способности предвидеть и смягчать потенциальные сбои. Ведь долговременный аптайм — лишь иллюзия безопасности, скрывающая зарождающуюся катастрофу. Рассмотрение рисков как неотъемлемой части эволюции системы, а не как отклонений от нормы, — ключевой элемент предложенной методологии.

Что дальше?

Предложенная работа, стремясь уложить расплывчатые предписания Акта об ИИ в конкретные компоненты, напоминает попытку вырастить сад по чертежу. Чертеж может быть безупречен, но жизненная сила системы все равно определяется не архитектурой, а способностью адаптироваться к непредсказуемым условиям. Истинное испытание для предложенной рамки — не в точности соответствия букве закона, а в устойчивости к неизбежному техническому долгу, который накапливается в любой сложной системе.

Следующий этап исследований, вероятно, связан с пониманием того, как эта рамка взаимодействует с другими системами управления рисками в организации. ИИ — лишь один из многих факторов, определяющих надежность. Более того, акцент на верификации не должен затмевать важность валидации — способности системы приносить пользу в реальных условиях. Иначе рискуем получить идеально проверенную, но бесполезную конструкцию.

В конечном счете, успех предложенного подхода будет измеряться не количеством проверенных систем, а способностью создавать доверие. Доверие — не результат проверки, а побочный эффект способности системы прощать ошибки, как в природе, где устойчивость экосистемы определяется не изоляцией компонентов, а их взаимной поддержкой и адаптацией.

Оригинал статьи: https://arxiv.org/pdf/2512.13907.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Искусственный интеллект: расшифровка паттернов инноваций

- Квантовые игры: поиск равновесия на нейтральных атомах

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Сердце музыки: открытые модели для создания композиций

- Нейросети на грани: как перевести ИИ в логику для умных устройств

- Эффективная память для больших языковых моделей: новый подход LOOKAT

2025-12-17 13:14