Автор: Денис Аветисян

Новое исследование показывает, что для эффективного обучения больших квантовых нейросетей необходимо оптимизировать классическую обработку данных, возникающую при использовании метода разбиения квантовых схем.

Оптимизация классической реконструкции данных является ключевым фактором для повышения масштабируемости обучения квантовых нейросетей с использованием метода разбиения квантовых схем.

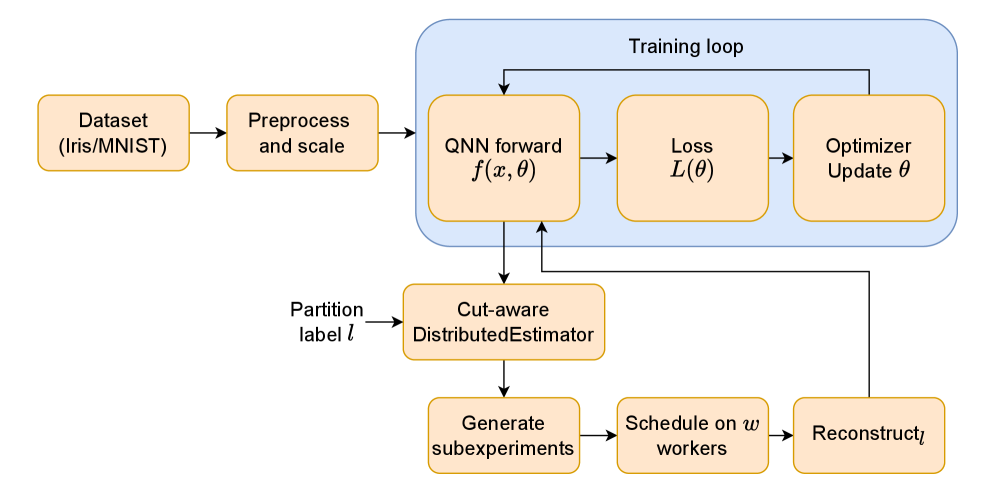

Несмотря на потенциал квантовых нейронных сетей для решения сложных задач, их обучение на современных устройствах ограничено глубиной квантовых схем. В данной работе, ‘DistributedEstimator: Distributed Training of Quantum Neural Networks via Circuit Cutting’, предложен подход, основанный на разделении больших схем на подсхемы для распределенного обучения. Полученные результаты показывают, что основными узкими местами при использовании данного метода являются накладные расходы на классическую реконструкцию и зависимость от времени синхронизации. Сможем ли мы добиться масштабируемости квантового машинного обучения, оптимизируя этапы реконструкции и разрабатывая эффективные стратегии планирования?

Разрушая Барьеры: Ограничения NISQ-Устройств и Пути их Преодоления

Современные квантовые устройства промежуточного масштаба (NISQ) сталкиваются с фундаментальными ограничениями, обусловленными недостаточным количеством кубитов и кратковременностью их когерентности. Ограниченное число кубитов напрямую влияет на сложность задач, которые можно решать, не позволяя эффективно моделировать даже сравнительно небольшие системы. Короткое время когерентности, в свою очередь, вносит ошибки в вычисления, поскольку квантовая информация теряется до завершения алгоритма. Эти два фактора в совокупности существенно затрудняют выполнение сложных квантовых вычислений, требующих большого количества стабильных кубитов и продолжительных вычислений, что делает реализацию многих перспективных квантовых алгоритмов на текущем аппаратном обеспечении крайне сложной задачей. Преодоление этих ограничений является ключевой задачей для развития квантовых технологий.

Ограничения, накладываемые текущими квантовыми устройствами промежуточного масштаба (NISQ) по количеству кубитов и времени когерентности, существенно затрудняют непосредственное применение многих алгоритмов квантового машинного обучения. Это требует разработки инновационных подходов, позволяющих эффективно использовать доступное аппаратное обеспечение. Исследователи активно изучают методы, такие как вариационные квантовые алгоритмы и квантовые схемы с ограниченной глубиной, чтобы обойти эти ограничения. Вместо попыток реализовать сложные алгоритмы напрямую, акцент смещается на разработку гибридных квантово-классических подходов, где квантовые вычисления выполняют лишь определенные этапы, а основная часть обработки данных осуществляется классическими компьютерами. Такой подход позволяет использовать преимущества квантовых вычислений даже при ограниченных ресурсах, открывая возможности для решения задач, недоступных классическим алгоритмам, и продвигая развитие квантового машинного обучения в условиях текущих технологических ограничений.

Деконструкция Сложности: Разделение Схем для Оптимизации Ресурсов

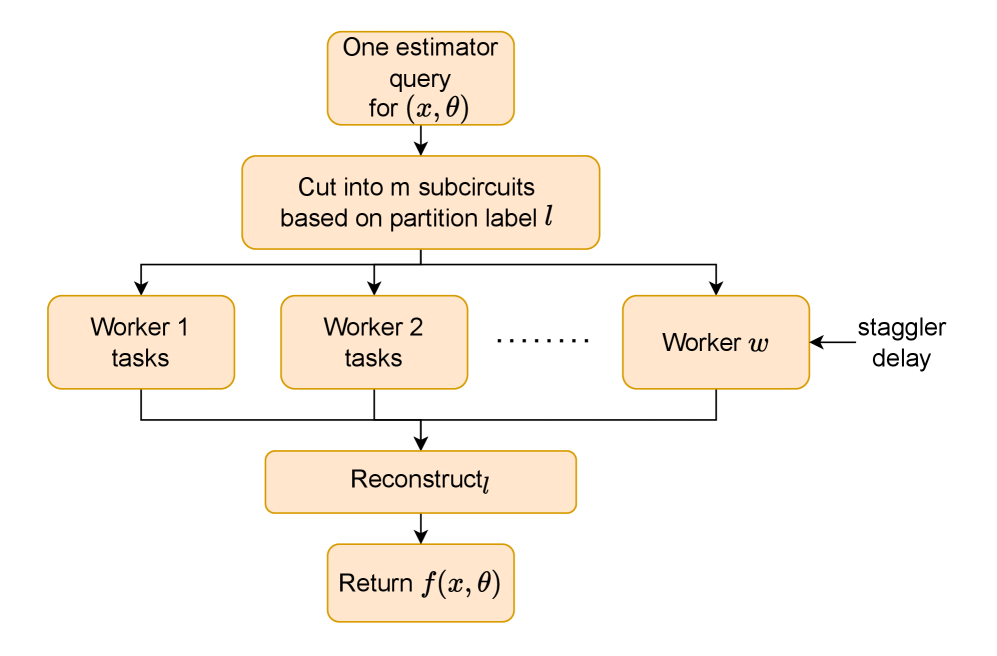

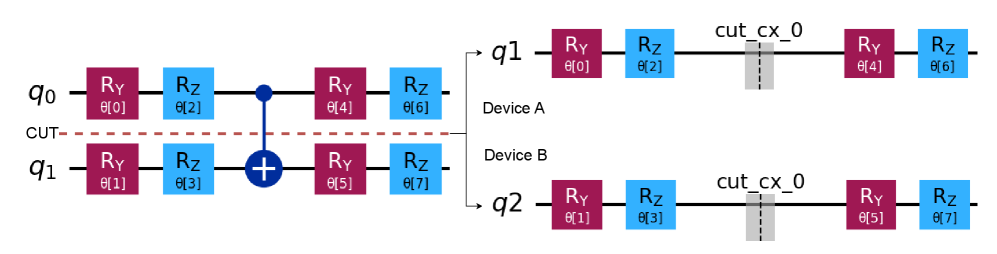

Разделение больших квантовых схем на более мелкие, исполняемые подсхемы является основной стратегией преодоления ограничений, связанных с количеством кубитов. Этот процесс, известный как “circuit cutting”, позволяет выполнять вычисления, которые иначе потребовали бы больше кубитов, чем доступно на конкретном квантовом оборудовании. Суть метода заключается в разбиении сложной схемы на последовательность более простых операций, каждая из которых может быть выполнена на доступном кубитовом ресурсе. Последовательное выполнение этих подсхем и объединение полученных результатов позволяет решать задачи, недоступные для прямого исполнения на ограниченных квантовых системах. Данный подход является важным шагом к масштабированию квантовых вычислений, позволяя эффективно использовать существующие ресурсы.

Разделение сложной квантовой схемы на более мелкие, исполняемые подсхемы позволяет реализовать поэтапную распределенную нагрузку, что, в свою очередь, обеспечивает возможность параллельного выполнения задач на доступных вычислительных ресурсах. Этот подход подразумевает разбиение исходной задачи на независимые фрагменты, каждый из которых может быть обработан независимо, значительно сокращая общее время вычислений при наличии достаточного количества ресурсов. Эффективность параллельного исполнения напрямую зависит от степени гранулярности разделения и способности системы эффективно управлять и объединять результаты, полученные из различных вычислительных узлов.

Разделение квантовых схем на более мелкие подсхемы, хотя и необходимое для преодоления ограничений числа кубитов, неизбежно приводит к увеличению общего объема вычислений. Наше исследование показало, что процесс классической реконструкции результатов, полученных от выполнения этих разделенных подсхем, становится основным узким местом в производительности. Несмотря на возможность параллельного выполнения, время, затрачиваемое на сбор и объединение промежуточных результатов в финальный ответ, существенно ограничивает общую скорость вычислений и требует оптимизации алгоритмов реконструкции для эффективного использования доступных ресурсов.

Оптимизация Реконструкции и Работа с «Отстающими»

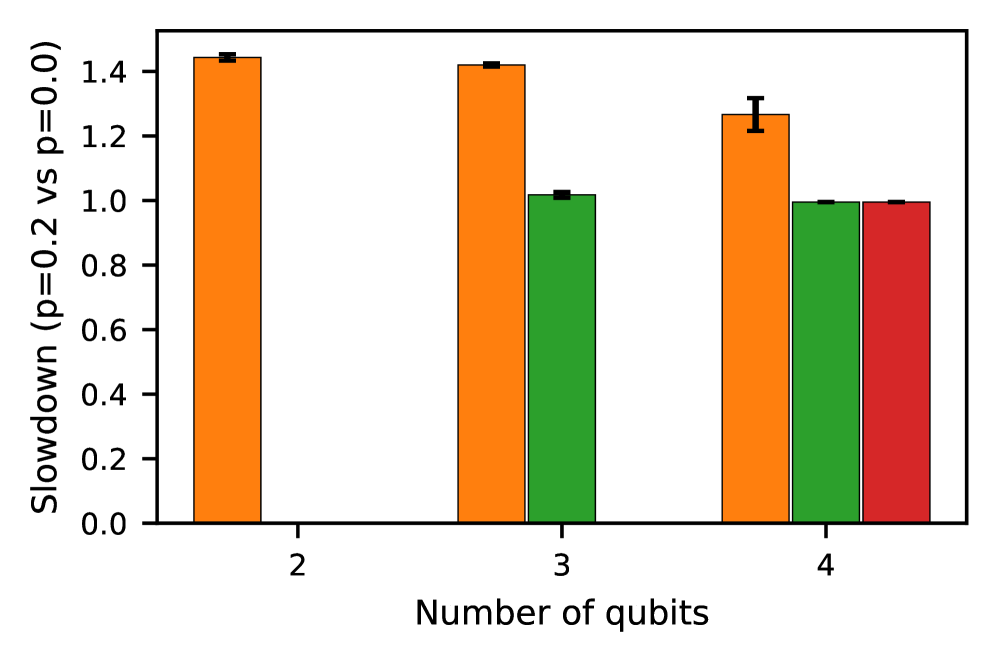

Эффективность классической реконструкции напрямую связана с долей реконструкции (Reconstruction Fraction), определяющей время, затрачиваемое на агрегацию результатов. Наши результаты показывают, что значительная часть общего времени работы оценщика (estimator) тратится именно на реконструкцию. Это означает, что оптимизация процесса агрегации данных, включающая в себя выбор алгоритма и эффективную реализацию, может существенно сократить общее время вычислений. В частности, доля времени, затрачиваемого на реконструкцию, может превышать долю времени, затрачиваемого на выполнение самих вычислений, особенно при большом количестве параллельных задач и сложных алгоритмах агрегации. Таким образом, уделение внимания оптимизации этапа реконструкции является критически важным для повышения общей производительности системы.

Параллельное выполнение вычислений неизбежно приводит к появлению «отстающих» задач (stragglers) — процессов, требующих значительно больше времени для завершения, чем остальные. Эти отстающие задачи оказывают существенное влияние на Tail Latency — время, необходимое для завершения самого медленного процесса в группе. Наблюдения показали, что степень влияния отстающих задач на общее время решения (time-to-solution) варьируется в зависимости от того, является ли доминирующим фактором этап выполнения (execution) или этап реконструкции (reconstruction) результатов. В ситуациях, когда реконструкция занимает большую часть времени, влияние отстающих задач на этапе выполнения может быть менее заметным, и наоборот.

Эффективная политика планирования задач является критически важной для смягчения влияния отстающих задач (stragglers) и максимизации пропускной способности в параллельной вычислительной среде. Страгглеры, представляющие собой задачи, требующие значительно больше времени на выполнение, чем остальные, могут существенно увеличивать общую задержку (tail latency) и снижать эффективность параллелизации. Оптимальная политика планирования должна обеспечивать равномерное распределение нагрузки между вычислительными узлами, динамическую перепланировку задач в случае выявления страгглеров, и, возможно, использование резервных узлов для повторного выполнения проблемных задач. Применение таких стратегий позволяет минимизировать время простоя и поддерживать высокую общую производительность системы, особенно при обработке больших объемов данных или выполнении сложных вычислений.

Платформа Qiskit предоставляет необходимые инструменты для моделирования и тестирования стратегий распределенного выполнения квантовых вычислений. В частности, симулятор Aer позволяет эмулировать различные сценарии, включая распределение задач между несколькими вычислительными узлами и анализ влияния задержек (stragglers) на общую производительность. Aer поддерживает настройку параметров, таких как количество узлов, задержки связи и характеристики отдельных задач, что позволяет исследователям и разработчикам оценивать эффективность различных политик планирования и оптимизации реконструкции результатов без необходимости использования реального квантового оборудования. Это обеспечивает возможность итеративной разработки и тестирования стратегий, направленных на минимизацию времени решения и максимизацию пропускной способности системы.

Раскрытие Потенциала: Вариационные Квантовые Алгоритмы в Действии

В основе гибридных квантово-классических вычислений, особенно вариационных квантовых алгоритмов, лежит метод усечения квантовых схем и последующая оптимизированная реконструкция. Этот подход позволяет значительно сократить вычислительные затраты, связанные с реализацией сложных квантовых операций, путем исключения несущественных элементов схемы. Усечение, в сочетании с алгоритмами эффективной реконструкции, позволяет добиться существенного снижения требований к ресурсам квантового компьютера, делая вариационные квантовые алгоритмы практически реализуемыми на современных квантовых устройствах. Это критически важно для решения задач, требующих оптимизации параметров, например, в области квантового машинного обучения, где данный метод открывает путь к созданию и обучению сложных моделей, несмотря на ограничения текущего аппаратного обеспечения.

Вариационные квантовые алгоритмы эффективно оптимизируют параметры, используя методы Монте-Карло и правило сдвига параметров. Метод Монте-Карло позволяет оценить интегралы, необходимые для вычисления градиентов параметров, за счет случайной выборки. Правило сдвига параметров, в свою очередь, предоставляет способ точного вычисления этих градиентов, используя лишь небольшое число квантовых вычислений. Благодаря сочетанию этих техник, алгоритмы могут находить оптимальные значения параметров, минимизируя или максимизируя целевую функцию, и, таким образом, решать сложные оптимизационные задачи, которые трудно поддаются классическим методам. Эффективность этих подходов критически важна для реализации потенциала квантовых вычислений в различных областях, включая машинное обучение и моделирование материалов.

Выбор квантического анзаца, такого как RealAmplitudes или ZFeatureMap, оказывает значительное влияние на точность и устойчивость вариационных квантовых алгоритмов. Исследования показали, что различные конфигурации этих анзацев демонстрируют сохранность как точности, так и устойчивости при решении задач оптимизации. Это означает, что алгоритм способен поддерживать высокую производительность и надежность независимо от конкретного выбранного анзаца в пределах исследованных параметров. Наблюдаемая консистентность в результатах позволяет более гибко подходить к проектированию квантовых схем и выбирать анзац, наиболее подходящий для конкретной аппаратной платформы или задачи, не опасаясь значительного снижения производительности или появления непредсказуемых ошибок.

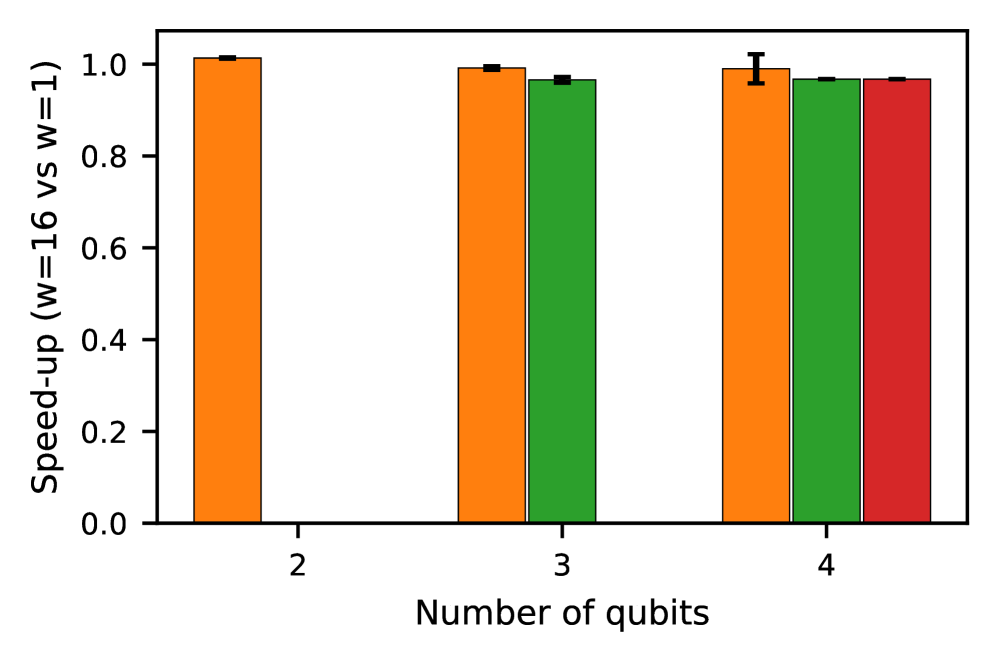

Вариационные квантовые алгоритмы (ВКА) открывают новые перспективы в машинном обучении, предлагая путь к разработке усовершенствованных моделей. Несмотря на теоретический потенциал, практические исследования показывают, что наблюдаемое ускорение по сравнению с классическими алгоритмами зачастую не превышает единицу. Это указывает на существующие ограничения в получении значительных преимуществ от параллелизма, присущего квантовым вычислениям. Таким образом, хотя ВКА представляют собой многообещающее направление, для реализации ощутимого выигрыша в скорости и эффективности необходимо дальнейшее совершенствование алгоритмов и аппаратного обеспечения, а также поиск областей, где квантовые преимущества наиболее ярко выражены.

Исследование, представленное в данной работе, демонстрирует, что расширение возможностей квантовых вычислений через методы обрезки цепей сталкивается с ограничениями, связанными с классической обработкой данных. Оптимизация этапа реконструкции становится критически важной для достижения масштабируемости в квантовом машинном обучении. В этой связи, уместно вспомнить слова Алана Тьюринга: «Иногда люди, которые кажутся сумасшедшими, просто видят мир по-другому». Подобно тому, как Тьюринг предлагал нестандартные подходы к вычислениям, данная работа подчеркивает необходимость переосмысления классических этапов в квантовых алгоритмах, чтобы полностью раскрыть потенциал квантовых цепей и обойти узкие места производительности, связанные с estimator-heavy workloads.

Что дальше?

Представленная работа обнажает парадокс: расширение возможностей квантовых вычислений за счет «разрезания» схем сталкивается с узким местом — классической обработкой результатов. Задаётся вопрос: не является ли оптимизация этого этапа не просто технической задачей, а фундаментальным ограничением, определяющим предел масштабируемости квантового машинного обучения? Если «разрез» схемы позволяет обойти аппаратные ограничения, но требует несоизмеримых усилий для восстановления полной картины, то не является ли это лишь иллюзией прогресса?

Вместо слепого увеличения размеров схем, возможно, стоит пересмотреть саму парадигму обучения. Что, если кажущиеся «ошибками» — высокие затраты на реконструкцию — на самом деле являются сигналами о необходимости принципиально новых подходов к гибридным вычислениям? Стоит ли искать алгоритмы, которые минимизируют объем передаваемых данных между квантовой и классической системами, или же разрабатывать новые архитектуры, где эта граница стирается?

Игнорирование классического «узкого места» равносильно строительству огромного моста к недосягаемому берегу. Пора задуматься: не является ли истинным прорывом не увеличение размера схемы, а её радикальное упрощение, основанное на глубоком понимании взаимосвязи между квантовым и классическим мирами? Возможно, ключ к масштабируемости лежит не в преодолении ограничений, а в их использовании.

Оригинал статьи: https://arxiv.org/pdf/2602.16233.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Временная запутанность: от хаоса к порядку

- Улучшение точности квантовых сенсоров: новый подход к подавлению шумов

- Квантовое программирование: Карта развивающегося мира

- Предел возможностей: где большие языковые модели теряют разум?

- ЭКГ-анализ будущего: От данных к цифровым биомаркерам

- Резонансы в тандеме: Управление светом в микрорезонаторах

- Сердце музыки: открытые модели для создания композиций

- Квантовый шум: за пределами стандартных моделей

- Квантовые кольца: новые горизонты спиновых токов

- Искусственный разум и квантовые данные: новый подход к синтезу табличных данных

2026-02-19 16:03