Автор: Денис Аветисян

Новый подход позволяет автоматически оптимизировать параметры решателей задач ограничений, значительно повышая их эффективность.

В статье представлен алгоритм Probe and Solve, использующий байесовскую оптимизацию для конфигурации гиперпараметров решателей задач ограничений в условиях фиксированного времени выполнения.

Эффективность решателей задач ограничения сильно зависит от выбора гиперпараметров, что делает ручную настройку трудоемкой и требующей экспертных знаний. В работе ‘Hyperparameter Optimization of Constraint Programming Solvers’ представлен алгоритм «зондирование и решение» — новый двухфазный подход к автоматической оптимизации гиперпараметров, интегрированный в библиотеку CPMpy. Данный метод, использующий байесовскую оптимизацию, демонстрирует улучшение качества решений для решателей ACE и Choco на значительной части тестовых задач по сравнению с конфигурациями по умолчанию. Способен ли предложенный алгоритм стать стандартным инструментом для настройки решателей задач ограничения и расширить границы их применимости к более сложным задачам?

Задачи оптимизации: когда теория встречается с реальностью

Решатели задач на основе ограничения (CP) представляют собой мощный инструмент для решения сложных проблем, однако их эффективность напрямую зависит от правильно подобранных гиперпараметров. Эти параметры, определяющие стратегию поиска решения, существенно влияют на скорость и качество работы алгоритма. Неоптимальные значения гиперпараметров могут привести к значительному замедлению процесса поиска, а в некоторых случаях — и к невозможности найти решение в разумные сроки. Таким образом, даже самый совершенный CP-решатель способен продемонстрировать лишь часть своего потенциала при использовании параметров, не адаптированных к специфике конкретной задачи. Эффективная настройка гиперпараметров, следовательно, является ключевым фактором для раскрытия всей мощи CP-решателей и обеспечения их масштабируемости при решении задач возрастающей сложности.

Ручная настройка гиперпараметров решателей задач Constraint Programming (CP) представляет собой сложный и трудоемкий процесс, требующий значительных временных затрат от специалистов. Вследствие ограниченности ресурсов и сложности полного охвата пространства возможных параметров, подобный подход зачастую приводит к субоптимальным результатам. Это, в свою очередь, препятствует раскрытию полного потенциала CP-решателей при решении реальных, сложных задач, ограничивая их эффективность и масштабируемость. В результате, даже мощные алгоритмы CP могут работать недостаточно быстро или вовсе не находить оптимальные решения, если их гиперпараметры настроены неэффективно, что подчеркивает необходимость автоматизированных методов оптимизации.

Эффективная оптимизация гиперпараметров является ключевым фактором для раскрытия полного потенциала решателей задач ограничениями (Constraint Programming, CP). От качества настройки этих параметров напрямую зависит не только скорость и точность нахождения решений, но и способность решателя справляться с задачами возрастающей сложности и масштаба. Неоптимальные гиперпараметры могут привести к значительному замедлению работы, неполному исследованию пространства решений, и, как следствие, к невозможности решения сложных задач в приемлемые сроки. Таким образом, автоматизированные методы HPO становятся необходимым инструментом для исследователей и практиков, стремящихся к максимальной производительности и масштабируемости решателей CP, позволяя им эффективно решать широкий спектр задач в различных областях, от логистики и планирования до искусственного интеллекта и моделирования.

Алгоритм «Зондирование и Решение»: как вытащить максимум из ограничений

Алгоритм “Зондирование и Решение” представляет собой двухфазную структуру, разработанную для эффективного определения оптимальных конфигураций гиперпараметров. Первая фаза, “Зондирование”, заключается в исследовании пространства гиперпараметров с целью сбора данных о производительности различных конфигураций. Вторая фаза, “Решение”, использует полученные данные для фокусировки ресурсов на наиболее перспективной конфигурации, позволяя эффективно решать конкретную задачу. Такой подход позволяет значительно сократить время, необходимое для поиска оптимальных настроек, по сравнению с полным перебором или случайным поиском.

Начальная фаза пробования (Probing Phase) алгоритма исследует пространство гиперпараметров путем оценки производительности различных конфигураций. В ходе этой фазы запускается серия экспериментов с разными наборами гиперпараметров, при этом регистрируются соответствующие метрики производительности для каждой конфигурации. Полученные данные служат основой для построения модели, описывающей зависимость между гиперпараметрами и производительностью, и используются на последующей фазе решения для выбора оптимальной конфигурации. Целью фазы пробования является эффективное картирование пространства гиперпараметров, позволяющее идентифицировать перспективные области для дальнейшей оптимизации и избежать затрат ресурсов на неэффективные конфигурации.

Вторая фаза алгоритма, фаза решения, использует данные, полученные на этапе исследования, для оптимального решения поставленной задачи. Наиболее эффективная конфигурация гиперпараметров, выявленная на этапе исследования, применяется к конкретному экземпляру решаемой проблемы. Это позволяет сконцентрировать вычислительные ресурсы на наиболее перспективном варианте, значительно повышая эффективность и скорость получения результата по сравнению с перебором всех возможных конфигураций или использованием случайных значений. Применение сфокусированных ресурсов особенно важно для задач, требующих значительных вычислительных затрат.

Динамическая адаптация: как заставить алгоритм думать

Статическая начальная установка времени ожидания (timeout) обеспечивает базовый уровень функционирования системы, однако может оказаться неэффективной при использовании с конфигурациями, которые быстро демонстрируют неудовлетворительную производительность. В таких случаях, фиксированное время ожидания приводит к излишней трате ресурсов на обработку заведомо неоптимальных параметров, замедляя общий процесс поиска наилучшей конфигурации. Задержка, вызванная ожиданием ответа от неэффективных конфигураций, может существенно снизить скорость и эффективность всего процесса зондирования и оптимизации.

Динамическая адаптация времени ожидания (timeout) заключается в индивидуальной настройке этого параметра для каждой тестируемой конфигурации на основе результатов, полученных в процессе зондирования. В отличие от статических значений, время ожидания для каждой конфигурации изменяется в реальном времени, основываясь на наблюдаемой скорости ответа или успешности выполнения операций. Конфигурации, демонстрирующие низкую производительность или частые сбои, получают уменьшенное время ожидания, что позволяет системе быстрее исключить их из дальнейшего тестирования. Напротив, перспективные конфигурации получают увеличенное время ожидания, чтобы обеспечить более полную оценку их возможностей и избежать преждевременного отбраковки.

Адаптивный подход к настройке времени ожидания позволяет уделять больше внимания перспективным конфигурациям, что ускоряет процесс определения оптимальных параметров. Вместо фиксированного времени ожидания, система динамически корректирует его для каждой конфигурации, основываясь на результатах ее работы в процессе зондирования. Конфигурации, демонстрирующие высокую производительность, получают приоритет и более длительное время ожидания для более точной оценки, в то время как неэффективные конфигурации быстро отбрасываются, снижая общую продолжительность поиска оптимальных настроек. Это позволяет существенно сократить время, необходимое для выявления наилучшей конфигурации, особенно в сложных системах с большим количеством параметров.

Для адаптации времени ожидания используется байесовская оптимизация, позволяющая построить вероятностную модель производительности каждой конфигурации. Данная модель учитывает предыдущие результаты оценки, что позволяет предсказывать производительность конфигурации без необходимости полного завершения ее тестирования. В процессе пробования, байесовская оптимизация оценивает функцию полезности (utility function), определяющую, какие конфигурации наиболее перспективны для дальнейшей оценки. На основе предсказаний и оценки неопределенности, время ожидания для каждой конфигурации динамически корректируется: для перспективных конфигураций время ожидания уменьшается, позволяя быстрее найти оптимальные параметры, а для неэффективных — увеличивается, чтобы получить более точные данные перед полным исключением из рассмотрения. Использование байесовской оптимизации позволяет эффективно распределять ресурсы и ускорить процесс поиска оптимальной конфигурации.

Проверка на практике: когда теория встречается с реальностью

Алгоритм «Probe and Solve» был тщательно протестирован на обширном наборе бенчмарков XCSP3, включающем разнообразные задачи комбинаторной оптимизации. В ходе оценки применялись два популярных решателя задач ограничения — ACE Solver и Choco Solver. Данный подход позволил не только проверить работоспособность алгоритма в различных условиях, но и получить объективные данные о его производительности и эффективности при решении сложных задач, что является важным этапом в подтверждении практической применимости разработанного метода.

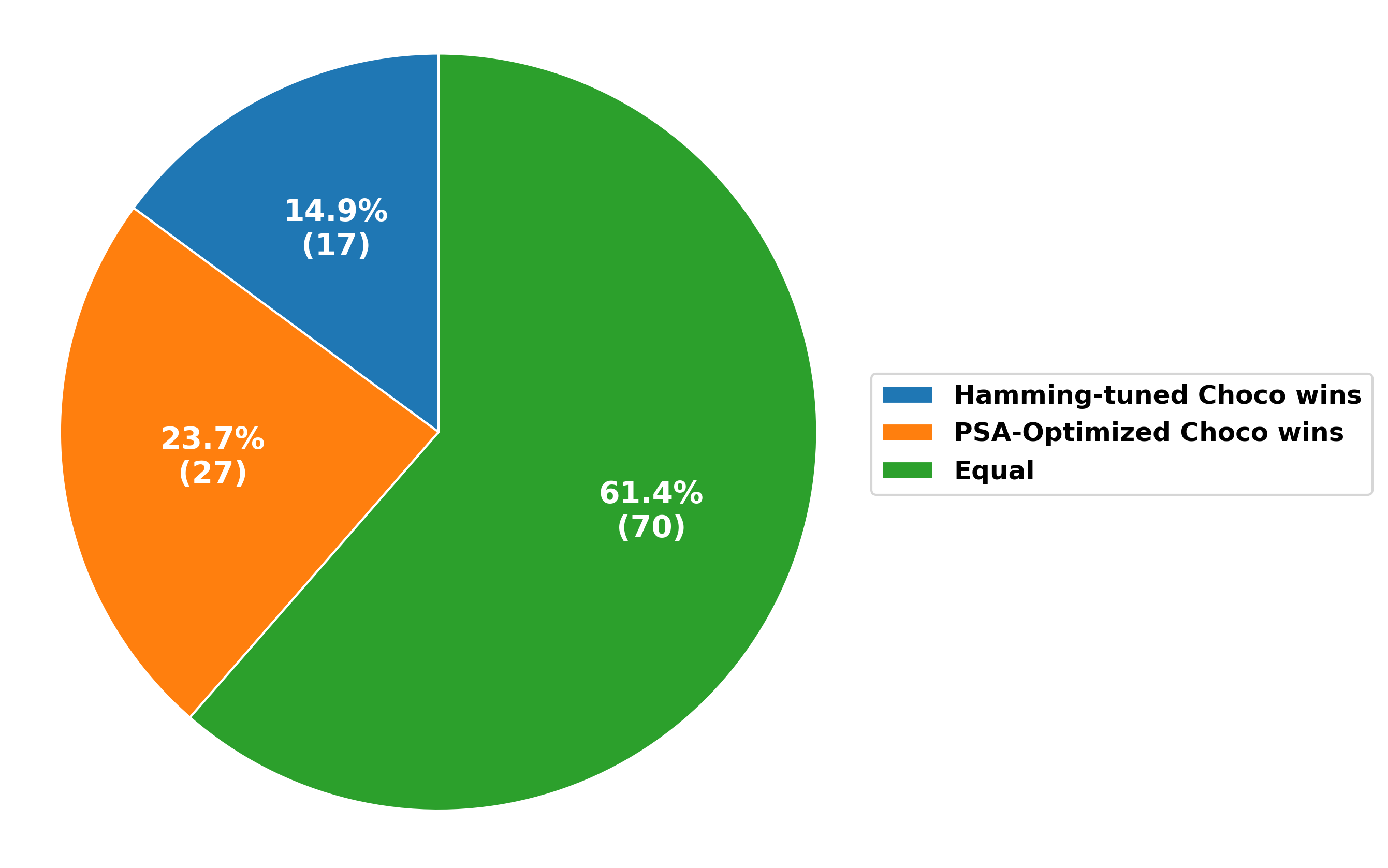

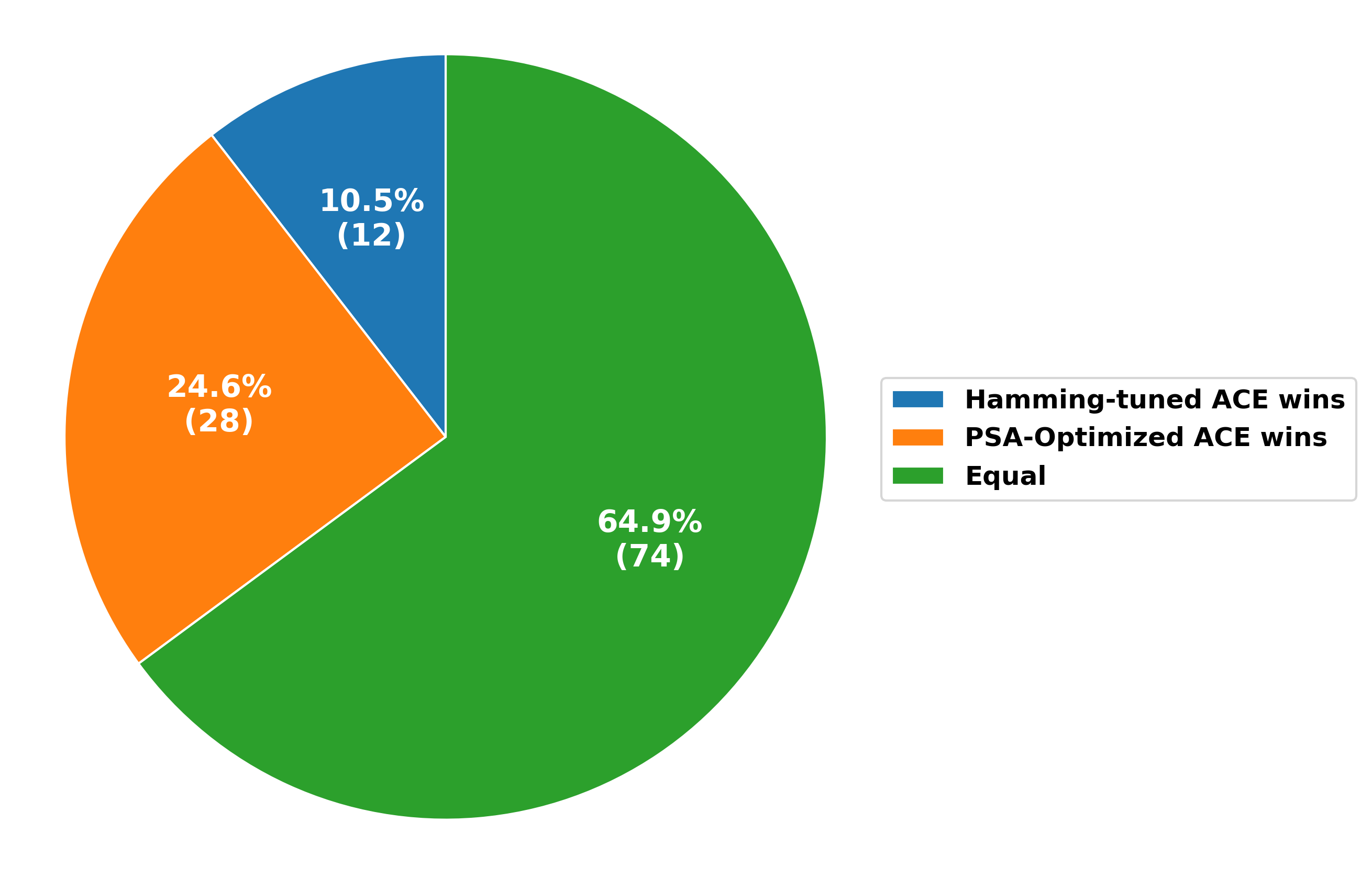

Проведенные испытания алгоритма «Probe and Solve» на стандартном наборе тестов XCSP3 продемонстрировали существенное повышение качества решений. В частности, при использовании решателя ACE наблюдалось улучшение результатов в 25,4% случаев, а при использовании решателя Choco — в 38,6% случаев по сравнению с настройками по умолчанию. Данные результаты указывают на эффективность предложенного подхода в оптимизации поиска решений для широкого спектра задач комбинаторной оптимизации и подтверждают его потенциал для повышения производительности существующих систем решения ограничений.

Эффективность разработанного алгоритма значительно возрастает при использовании библиотеки CPMpy совместно с решателем ACE. Интеграция CPMpy обеспечивает более удобное и гибкое моделирование задач комбинаторной оптимизации, позволяя алгоритму эффективно исследовать пространство решений. Данное сочетание не только упрощает процесс разработки, но и способствует повышению производительности, обеспечивая более быстрый поиск оптимальных или близких к оптимальным решений для широкого спектра задач, что подтверждается результатами проведенных тестов и сравнений с другими подходами.

В ходе сравнительного анализа алгоритма Probe and Solve (PSA) в различных конфигурациях было установлено, что версия PSA-BO демонстрирует превосходство над PSA-Hamming в значительной доле случаев. В частности, при использовании решателя ACE, PSA-BO превзошел PSA-Hamming на 24,6% протестированных экземпляров задач, а при работе с решателем Choco — на 23,7%. Данный результат указывает на повышенную эффективность алгоритма PSA-BO в процессе поиска решений, что делает его перспективным инструментом для решения широкого спектра задач комбинаторной оптимизации и задач, основанных на методе ограничений.

Полученные результаты подтверждают универсальность предложенного подхода к решению задач ограничения. Исследования, проведенные на широко известном наборе тестов XCSP3, демонстрируют, что алгоритм Probe and Solve эффективно работает с различными типами задач, используя как ACE Solver, так и Choco Solver. Улучшение качества решений, наблюдаемое в значительной части протестированных экземпляров, указывает на способность алгоритма адаптироваться к сложным условиям и находить оптимальные или близкие к оптимальным решения. Данная гибкость делает его ценным инструментом для решения широкого спектра задач в области искусственного интеллекта, планирования, логистики и других областях, где используются методы ограничения.

Наблюдения за автоматической настройкой гиперпараметров решателей задач ограничений неизбежно приводят к мысли о хрупкости любой «самовосстанавливающейся» системы. Авторы предлагают алгоритм PSA, основанный на байесовской оптимизации, как способ эффективной конфигурации решателей в условиях ограниченного времени. Однако, стоит помнить, что любое улучшение производительности — это лишь отсрочка неизбежного появления новых узких мест. Как говорил Джон фон Нейман: «В науке не бывает абсолютной истины, только приближения». И эти приближения, какими бы элегантными они ни казались, всегда найдут способ сломаться под давлением реальных данных и производственных нагрузок. Особенно когда речь идет о попытках автоматизировать то, что требует интуиции и понимания предметной области.

Что дальше?

Представленный здесь «Probe and Solve Algorithm» — лишь ещё один способ отсрочить неизбежное. Автоматическая настройка гиперпараметров — это бесконечная гонка, где каждое улучшение производительности — временное. Производство всегда найдёт способ нагрузить решатель экземплярами, для которых даже самая оптимальная конфигурация окажется недостаточной. Багтрекер, вне всякого сомнения, скоро пополнится новыми записями.

Вместо того чтобы стремиться к идеальной конфигурации, возможно, стоит переключиться на более устойчивые методы. Вместо того, чтобы «деплоить» — скорее «отпускать» решатель в дикую среду, надеясь на лучшее. Изучение динамической адаптации гиперпараметров, основанной на характеристиках текущего экземпляра, представляется более перспективным направлением. В конце концов, все эти «революционные» алгоритмы завтра превратятся в технический долг.

Очевидно, что увеличение вычислительных ресурсов не решит проблему. Более того, оно лишь усугубит её, создавая иллюзию управляемого хаоса. Скрам, как и всегда, лишь убедит людей в обратном. Поэтому, прежде чем бросаться в новые исследования, стоит задуматься: действительно ли мы решаем проблему, или просто усложняем её?

Оригинал статьи: https://arxiv.org/pdf/2601.11389.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Виртуальная примерка без границ: EVTAR учится у образов

- Квантовые эксперименты: новый подход к воспроизводимости

- Восполняя пробелы в знаниях: Как языковые модели учатся делать выводы

- Разгадывая тайны квантового мира: переработка кубитов и шум как тайная приправа?

- Точность фазовой оценки: адаптивный подход превосходит стандартный

- Квантовые прорывы: Хорошее, плохое и шумное

- Автономный поисковик научных статей: новый подход

- Квантовый скачок: от лаборатории к рынку

- Визуальное мышление нового поколения: V-Thinker

2026-01-21 03:09