Автор: Денис Аветисян

Исследователи представили инновационную систему, объединяющую обучение с подкреплением и методы предсказания-коррекции для повышения эффективности и стабильности в различных областях оптимизации и дискретизации.

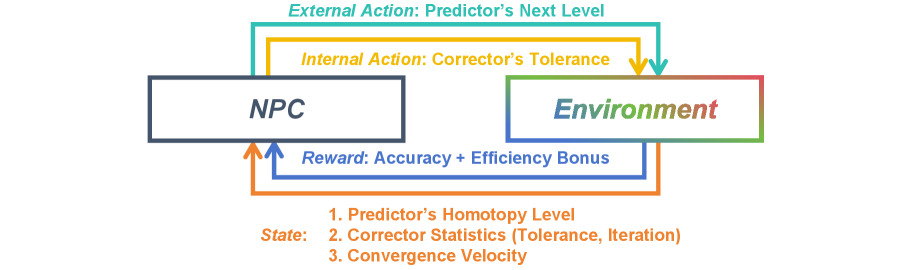

В статье представлена нейронная сеть «Предсказатель-Корректор» (NPC) — фреймворк обучения с подкреплением, объединяющий и улучшающий существующие методы решения гомотопических задач.

Несмотря на широкое применение гомотопических методов в различных областях оптимизации и дискретизации, их эффективность часто сдерживается использованием ручных эвристик для выбора шага и критериев остановки. В данной работе, ‘Neural Predictor-Corrector: Solving Homotopy Problems with Reinforcement Learning’, предложен новый подход, основанный на обучении с подкреплением, для унификации и улучшения этих методов. Разработанный Neural Predictor-Corrector (NPC) заменяет эвристики на автоматически изучаемые стратегии, повышая эффективность и стабильность решения гомотопических задач. Сможет ли предложенный подход стать основой для создания универсального решателя, способного адаптироваться к широкому спектру сложных задач оптимизации и дискретизации?

Сложность Поиска: Когда Теория Разлетается в Практике

Многие вычислительные задачи сталкиваются с трудностями из-за сложности и многомерности пространства поиска решений. Представьте себе ландшафт, испещренный глубокими впадинами и высокими пиками — найти оптимальную точку в такой местности крайне проблематично. В подобных пространствах даже незначительные изменения в исходных данных могут привести к кардинальным изменениям в итоговом результате, делая процесс поиска крайне нестабильным и непредсказуемым. Такая «шероховатость» вычислительного ландшафта особенно остро проявляется в задачах оптимизации, машинного обучения и моделировании сложных систем, где количество переменных и взаимосвязей между ними может быть огромным. Именно поэтому требуется разработка методов, способных эффективно преодолевать эти препятствия и находить надежные решения даже в самых сложных условиях.

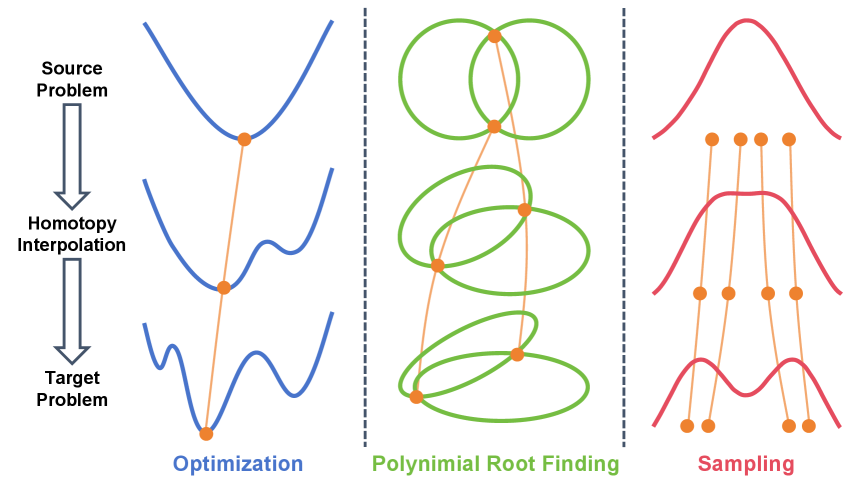

Парадигма гомотопии представляет собой мощный подход к решению сложных вычислительных задач, основанный на плавной деформации исходной проблемы в более простую, легко разрешимую форму. Вместо непосредственного решения сложного уравнения, этот метод предполагает постепенное изменение его структуры, связывая его с тривиальной отправной точкой посредством непрерывного пути. Такая деформация позволяет обойти локальные минимумы и максимумы, характерные для многомерных пространств решений, и гарантирует более надежный и устойчивый процесс поиска оптимального решения. f(x) = x^2 В сущности, парадигма гомотопии преобразует задачу, делая ее более доступной для стандартных алгоритмов, сохраняя при этом точность и надежность результата.

В основе парадигмы гомотопии лежит идея плавной деформации сложной задачи в более простую, разрешимую форму. Этот процесс осуществляется посредством построения непрерывного пути, связывающего тривиальную начальную точку с целевой проблемой. Ключевым аспектом является обеспечение непрерывности этого пути, что гарантирует устойчивость процесса поиска решения. Представьте себе, что задача — это ландшафт с множеством локальных минимумов и максимумов; гомотопический подход позволяет плавно «деформировать» этот ландшафт, создавая единый, глобальный минимум, к которому можно надежно прийти. Такой подход позволяет избежать застревания в локальных оптимумах и обеспечивает более надежное и предсказуемое решение даже для задач с высокой размерностью и сложной структурой. По сути, непрерывный путь выступает в роли «моста» между известным и неизвестным, обеспечивая плавный переход от простого к сложному и гарантируя устойчивость всего процесса.

Поиск Пути: Схема «Предиктор-Корректор» в Действии

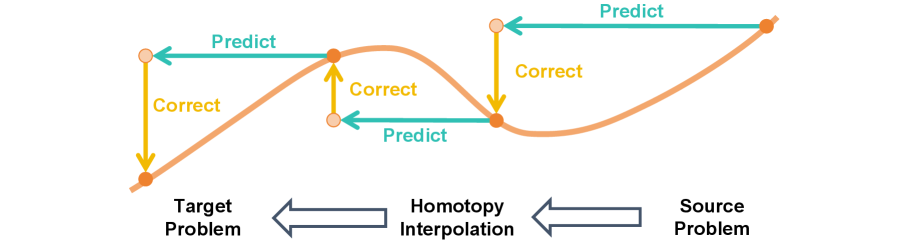

Схемы «предиктор-корректор» представляют собой итеративные методы решения задач, основанные на последовательном уточнении приближенного решения. На каждом шаге алгоритма сначала выполняется предсказание следующего приближения (prediction step), использующее информацию о предыдущих итерациях для оценки нового решения. Затем, предсказанное решение корректируется (correction step) с использованием информации о целевой функции или уравнениях, описывающих задачу, для уменьшения ошибки и повышения точности. Повторение этих шагов позволяет постепенно приближаться к точному решению, сочетая эффективность грубого предсказания с точностью локальной коррекции. Такой подход позволяет эффективно решать сложные задачи, требующие высокой точности, особенно в случаях, когда прямой анализ затруднен или невозможен.

Методы Гауссовой гомотопии и продолжения гомотопии используют схемы «предиктор-корректор» для прослеживания путей решений, переходя от простых задач к более сложным. В основе этого подхода лежит идея последовательного приближения к решению, где стадия «предиктора» делает первоначальную оценку, а стадия «корректора» уточняет эту оценку, минимизируя ошибку. Этот итеративный процесс позволяет эффективно исследовать пространство решений, начиная с тривиальных случаев и постепенно усложняя задачу, что особенно полезно при решении нелинейных систем уравнений и оптимизационных задач. Такая стратегия обеспечивает стабильное отслеживание путей решений даже при значительных изменениях в параметрах задачи.

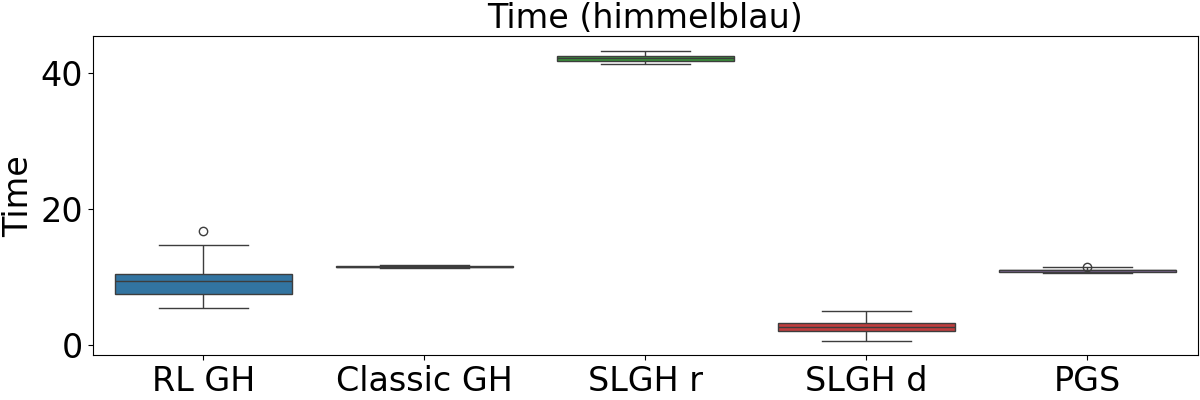

Нейронная схема «Predictor-Corrector» (NPC) демонстрирует значительное улучшение по сравнению с классическими методами за счет обучения адаптивным стратегиям для шагов предсказания и коррекции. В задачах регистрации облаков точек, NPC обеспечивает снижение количества итераций коррекции на 70-80% и сокращение времени выполнения на 80-90% по сравнению с классическим методом Gaussian Nearest Neighbor Correspondence (GNC). Это достигается за счет способности NPC динамически настраивать параметры шагов предсказания и коррекции, оптимизируя процесс сходимости к решению.

В рамках оптимизации с использованием метода Гауссовой Гомотопии, разработанная нами нейронная схема Predictor-Corrector (NPC) демонстрирует приблизительное сокращение числа итераций корректора и времени выполнения на 30% по сравнению с существующими методами. Данное улучшение достигается за счет адаптивного обучения стратегий предсказания и коррекции, что позволяет более эффективно приближаться к оптимальному решению и снижает вычислительные затраты. Сравнение проводилось на стандартных тестовых задачах оптимизации, демонстрирующих превосходство NPC в скорости сходимости и общей эффективности.

Статистическая Проверка: Как Убедиться, Что Расчеты Верны?

Метод обусловленного отжига Лагранжевой динамики (Annealed Langevin Dynamics) представляет собой эффективный способ генерации репрезентативных выборок из сложных вероятностных распределений. В отличие от стандартных методов Монте-Карло, которые могут застревать в локальных минимумах, обусловленный отжиг использует постепенно уменьшающийся параметр «температуры», позволяя алгоритму исследовать пространство состояний более эффективно. Это достигается путем добавления к стандартному уравнению Лагранжевой динамики члена, пропорционального градиенту логарифма целевого распределения, а также случайного шума, масштабируемого параметром температуры. По мере уменьшения температуры, распределение выборок сходится к целевому распределению p(x), обеспечивая точное приближение сложной вероятностной модели и позволяя проводить статистический вывод на ее основе.

Метод использует динамику Ланжевена для восстановления равновесия сгенерированных выборок, что позволяет проводить точные статистические выводы. Динамика Ланжевена представляет собой стохастический процесс, включающий уравнение движения, модифицированное случайным шумом и силой трения, пропорциональной скорости. Данный процесс эффективно «сглаживает» выборки, перемещая их к областям высокой вероятности в целевом распределении. Это особенно важно при работе со сложными распределениями, где прямая выборка может быть затруднена или невозможна. Восстановление равновесия гарантирует, что полученные выборки адекватно представляют целевое распределение, что критически необходимо для получения достоверных статистических оценок и проведения точного статистического вывода.

Для оценки качества сгенерированных выборок и сравнения распределений используются метрики, такие как расстояние Вассерштейна-2 (Wasserstein-2 Distance) и расхождение Штайна, ядром которого является Kernelized Stein Discrepancy (KSD). Расстояние Вассерштейна-2, также известное как расстояние Землеустройства, измеряет минимальную «стоимость» перемещения массы из одного распределения в другое. KSD, в свою очередь, является непараметрическим тестом, оценивающим разницу между двумя распределениями посредством оценки интеграла максимальной разницы между их функциями плотности, используя ядро для аппроксимации. W_2(P, Q) = \in f_{\gamma \in \Pi(P, Q)} \in t ||x - y||_2 d\gamma(x, y), где \Pi(P, Q) — множество всех совместных распределений, чьи маргиналы равны P и Q соответственно. Выбор между этими метриками зависит от конкретной задачи и характеристик сравниваемых распределений.

Работа демонстрирует, как очередная «революционная» парадигма — обучение с подкреплением в структуре «предиктор-корректор» — пытается примирить теорию и практику. Авторы предлагают систему, которая, судя по описанию, должна динамически адаптироваться к сложным задачам оптимизации и дискретизации. Однако, как показывает опыт многочисленных миграций, любая адаптивная система рано или поздно обнаруживает «неучтенные краевые случаи». В связи с этим вспоминается высказывание Блеза Паскаля: «Все великие вещи начинаются с малого и незаметного». Полагаться на самовосстановление системы преждевременно, ведь, как известно, документация — лишь форма коллективного самообмана, а стабильность системы определяется не отсутствием ошибок, а способностью их воспроизводить.

Что дальше?

Представленный подход, объединяющий обучение с подкреплением и парадигму предсказатель-корректор, несомненно, элегантен. Однако, как показывает опыт, любая абстракция рано или поздно столкнется с суровой реальностью продакшена. Неизбежно возникнут вопросы масштабируемости — как эта архитектура поведет себя в задачах, где размер пространства состояний экспоненциально растет? И, конечно, всегда найдется способ сломать даже самую тщательно продуманную стратегию адаптивного управления.

Вероятно, следующие шаги лежат в плоскости повышения робастности к шуму и неопределенности. Эффективность алгоритма сильно зависит от качества обучающих данных и точности модели предсказателя. Следует ожидать исследований, направленных на разработку методов, позволяющих NPC адаптироваться к меняющимся условиям и непредсказуемым возмущениям. В конце концов, всё, что можно задеплоить — однажды упадёт, но иногда это происходит красиво.

Интересно будет наблюдать, как эта технология будет интегрироваться с другими оптимизационными алгоритмами и подходами к выборочным методам. Пока же, представляется вероятным, что Neural Predictor-Corrector станет очередным кирпичиком в постоянно растущей стене технических долгов, но кирпичиком, созданным с изрядной долей инженерной мысли.

Оригинал статьи: https://arxiv.org/pdf/2602.03086.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Искусственный интеллект: расшифровка паттернов инноваций

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Квантовые игры: поиск равновесия на нейтральных атомах

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Сердце музыки: открытые модели для создания композиций

- Ищем закономерности: Новый пакет TSQCA для R

- Нейросети на грани: как перевести ИИ в логику для умных устройств

2026-02-04 18:51