Автор: Денис Аветисян

Новая работа предлагает автоматизированный метод выявления ключевых схем в нейронных сетях с математически строгими гарантиями их надежности и минимальности.

Представлен фреймворк для автоматического обнаружения и верификации нейронных схем с доказанными гарантиями устойчивости к возмущениям и минимальности.

Несмотря на значительный прогресс в области интерпретируемости нейронных сетей, автоматическое обнаружение внутренних схем, ответственных за конкретное поведение, зачастую опирается на эвристики без строгих гарантий. В данной работе, озаглавленной ‘Formal Mechanistic Interpretability: Automated Circuit Discovery with Provable Guarantees’, предложен набор алгоритмов, использующих методы верификации нейронных сетей для получения схем с формальными гарантиями надежности и минимальности. Мы демонстрируем возможность сертификации устойчивости схем к непрерывным возмущениям входных данных, а также формализации различных понятий краткости и компактности. Какие теоретические и практические перспективы открывает разработка принципиально новых методов верификации и анализа внутренних механизмов сложных нейронных сетей?

Неизбежные компромиссы: хрупкость нейронных сетей

Несмотря на впечатляющие успехи в различных областях, нейронные сети демонстрируют уязвимость к незначительным, намеренно внесенным изменениям во входных данных — так называемым «атакам возмущений». Эти возмущения, зачастую незаметные для человеческого глаза, способны кардинально изменить выход сети, приводя к ошибочным результатам. Данная особенность вызывает серьезные опасения в контексте критически важных приложений, таких как автономное вождение или медицинская диагностика, где даже небольшая ошибка может иметь катастрофические последствия. Исследования показывают, что уязвимость к таким атакам обусловлена нелинейностью и высокой размерностью пространства признаков, что делает задачу обеспечения надежности и безопасности нейронных сетей крайне сложной и актуальной.

Традиционные методы верификации, разработанные для более простых нейронных сетей, сталкиваются с серьезными трудностями при анализе современных, масштабных архитектур. Проблема заключается в экспоненциальном росте вычислительной сложности: количество возможных входных данных и внутренних состояний сети быстро увеличивается с добавлением каждого нового слоя и параметра. Это приводит к тому, что полная проверка, гарантирующая корректное поведение во всех сценариях, становится практически невозможной даже при использовании мощных вычислительных ресурсов. Существующие подходы, такие как символьное выполнение и абстрактная интерпретация, часто оказываются неэффективными или требуют неприемлемых упрощений, что снижает надежность полученных результатов и ограничивает их применимость к реальным задачам. В связи с этим, активно разрабатываются новые методы верификации, направленные на преодоление этих ограничений и обеспечение надежности сложных нейронных сетей.

Обеспечение адекватного поведения нейронных сетей — соответствия их выходных данных предполагаемой функции — является критически важным для надежного развертывания в реальных приложениях. Несоответствие между намерением разработчика и фактическим поведением сети может привести к непредсказуемым и даже опасным последствиям, особенно в таких областях, как автономное вождение или медицинская диагностика. Достижение этой «верности» требует не просто высокой точности на тренировочных данных, но и устойчивости к незначительным изменениям во входных данных, а также способности сети к обобщению и интерпретации информации в соответствии с заданными правилами. Гарантия адекватности поведения становится, таким образом, ключевой задачей при внедрении нейронных сетей в критически важные системы, требуя разработки новых методов верификации и контроля.

Поиск гарантий: обнаружение достоверно устойчивых схем

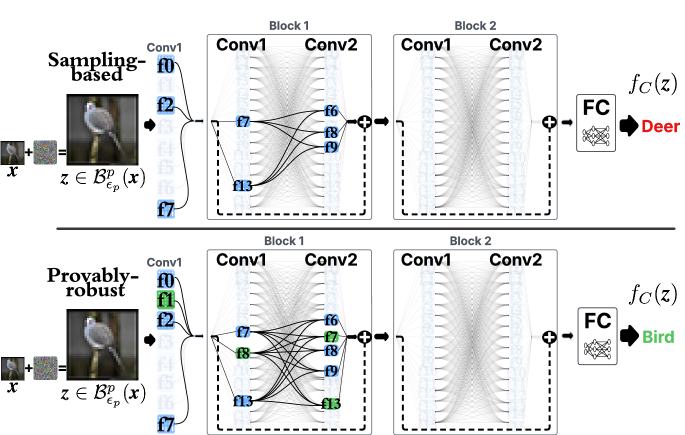

Метод обнаружения достоверно устойчивых схем представляет собой формальный подход к верификации поведения нейронных сетей. Он заключается в поиске эквивалентных схем, для которых предоставляются доказуемые гарантии соответствия оригинальной сети. В отличие от эмпирических методов тестирования, данный подход позволяет математически подтвердить, что найденная схема ведет себя идентично исходной сети в заданных условиях, обеспечивая высокий уровень надежности и предсказуемости. Это достигается путем формальной проверки свойств эквивалентности, а не статистической оценки.

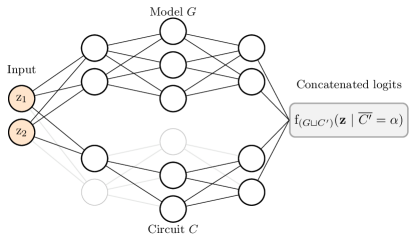

Метод обнаружения устойчивых схем использует технику, известную как Siamese Encoding, для сопоставления исходной нейронной сети и кандидатской схемы в общее, сравнимое пространство признаков. Siamese Encoding предполагает использование двух идентичных нейронных сетей с общими весами. Обе сети получают на вход исходную сеть и кандидатскую схему соответственно, преобразуя их в векторные представления. Сравнивая эти векторные представления с использованием метрики расстояния, можно определить, насколько близко кандидатская схема соответствует исходной сети по функциональности. Этот процесс позволяет формально оценить эквивалентность сетей, обеспечивая основу для верификации их поведения.

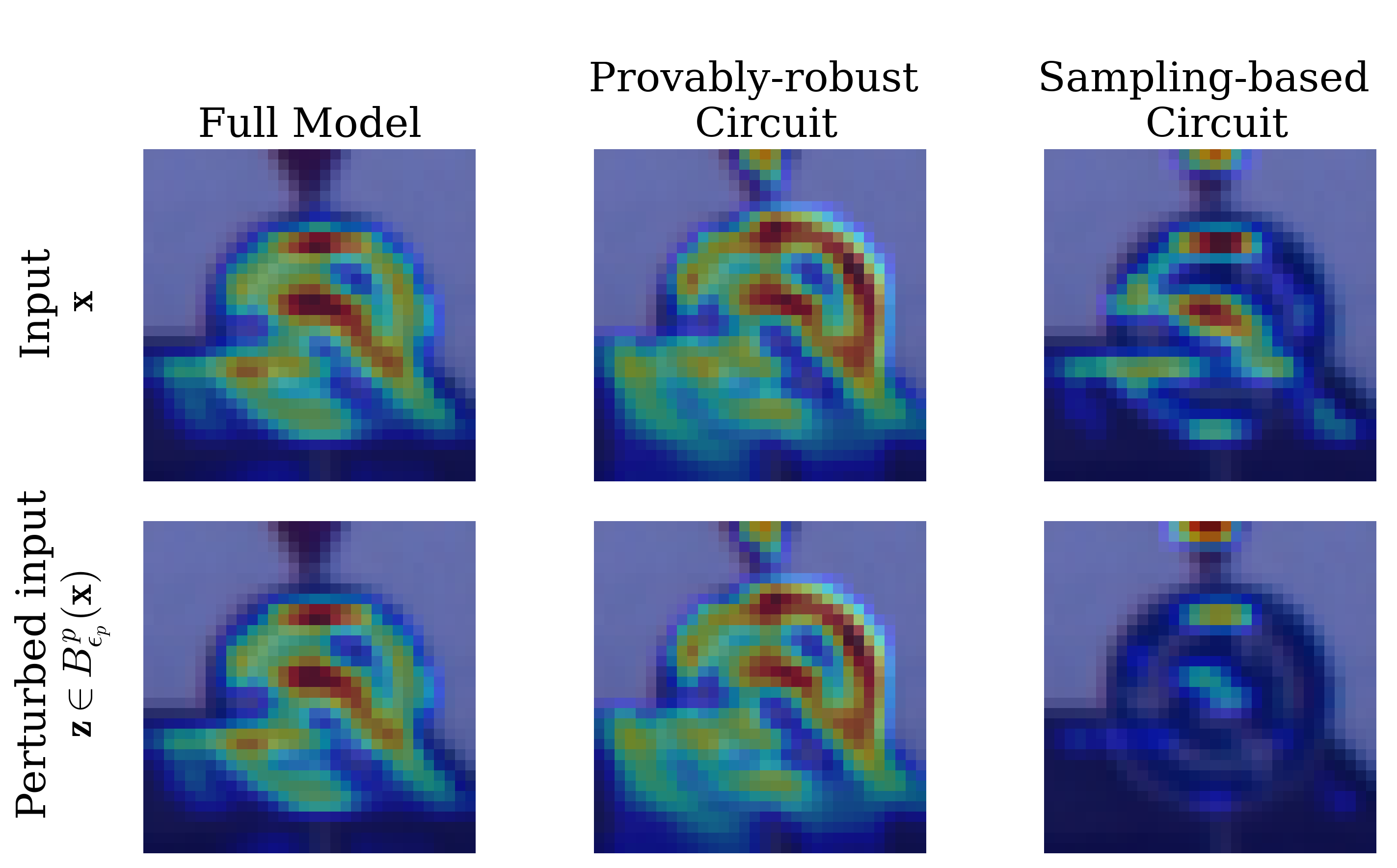

Процесс обнаружения достоверно устойчивых схем обеспечивает 100%-ную устойчивость к изменениям входных данных и внесению патчей, сохраняя при этом соответствие при непрерывных вариациях входных сигналов. Это означает, что схема, полученная методом, гарантированно будет функционировать корректно при любых допустимых входных данных и любых незначительных изменениях в структуре, не приводя к отклонению от ожидаемого поведения даже при небольших колебаниях входных параметров. Гарантия 100%-ной устойчивости подразумевает формальную верификацию, подтверждающую отсутствие ошибок или непредсказуемого поведения в заданных условиях.

Минимизация издержек: определение и достижение минимальности схемы

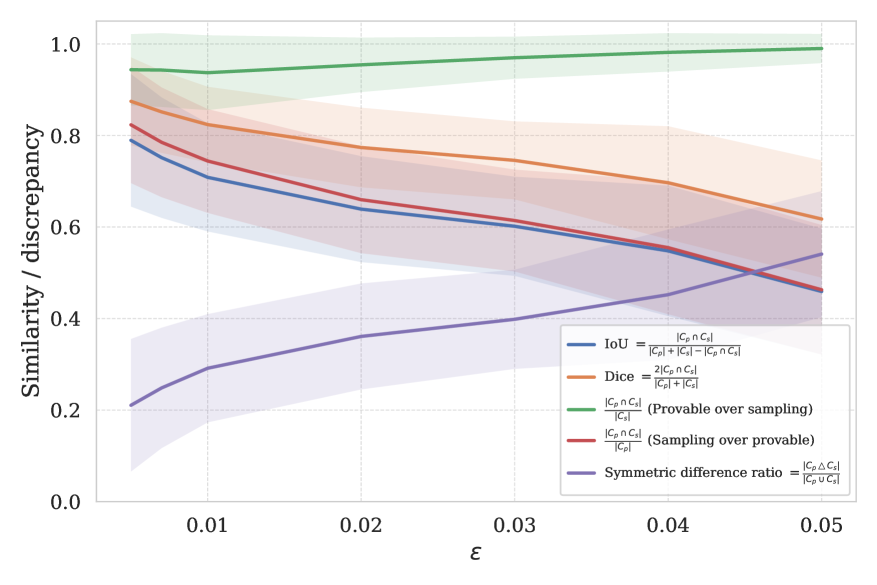

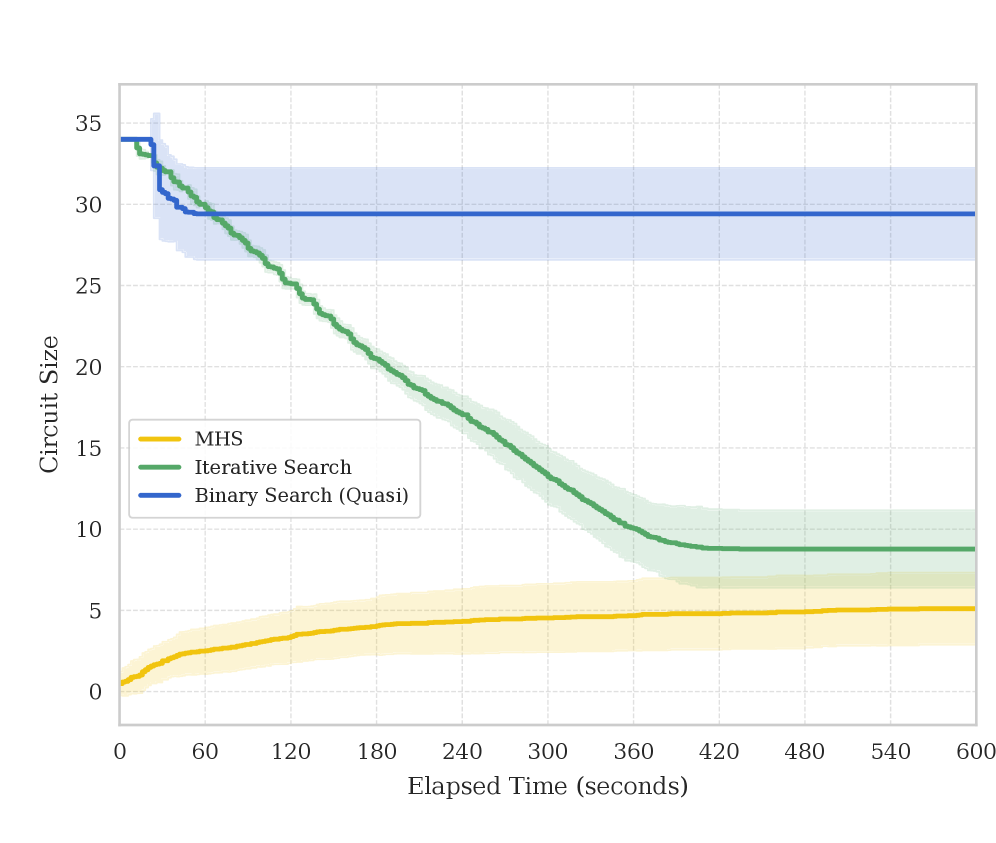

Исследователи изучают различные уровни минимальности схем, варьирующиеся от кардинально минимальных схем, характеризующихся наименьшим возможным количеством компонентов, до локально минимальных схем, в которых каждый компонент является необходимым для функционирования. Кардинальная минимальность представляет собой абсолютный предел сокращения схемы, в то время как локальная минимальность описывает состояние, когда дальнейшее удаление компонентов приведёт к нарушению работоспособности. Различие между этими подходами важно для анализа сложности схем и разработки алгоритмов оптимизации, поскольку стремление к кардинальной минимальности может быть вычислительно сложным, а локальная минимальность обеспечивает практический критерий для оценки эффективности схемы.

Метод минимального покрывающего множества позволяет идентифицировать компоненты, критичные для поддержания достоверности схемы. Покрытие, или блокирующий набор, представляет собой подмножество компонентов, удаление которого нарушает достоверность. Итеративный процесс MHS последовательно уменьшает размер схемы, приближаясь к кардинально минимальному состоянию, и обеспечивает нижнюю границу сложности схемы. Каждая итерация MHS удаляет избыточные компоненты, не влияющие на достоверность, тем самым снижая общую сложность и потенциально приближая схему к оптимальной реализации.

Схема, демонстрирующая монотонность, обеспечивает повышенную устойчивость к ошибкам и упрощает процесс верификации. Это связано с тем, что добавление элементов не требует повторной проверки всей схемы на предмет сохранения её функциональности, а лишь локальной оценки влияния нового компонента. В результате, верификация становится более эффективной и требует меньше вычислительных ресурсов, а схема демонстрирует повышенную надёжность при изменении условий эксплуатации или аппаратной реализации.

Расширение инструментария: альтернативные подходы к обнаружению схемы

В то время как формальная верификация обеспечивает надёжные гарантии корректности, метод обнаружения схем на основе выборочного анализа предлагает дополнительный, эмпирический подход к решению этой задачи. В отличие от строгих математических доказательств, выборочное тестирование оценивает поведение схемы на репрезентативном наборе входных данных, позволяя быстро идентифицировать потенциальные уязвимости или нежелательное поведение. Этот метод особенно полезен для анализа сложных нейронных сетей, где формальная верификация может оказаться вычислительно непосильной. Хотя выборочный анализ не предоставляет абсолютных гарантий, он позволяет оперативно выявлять и устранять недостатки, обеспечивая практическую применимость и дополняя преимущества формальных методов, что способствует созданию более надёжных и безопасных систем искусственного интеллекта.

Исследование взаимосвязи между схемой и её соответствием исходной функции, а также концепция “восстановленной устойчивости”, играет ключевую роль в усовершенствовании алгоритмов обнаружения схем. Суть заключается в том, что анализ степени, в которой схема точно отражает логику решаемой задачи, позволяет выявлять и устранять потенциальные уязвимости и неточности. “Восстановленная устойчивость” предполагает намеренное внесение небольших изменений в схему с целью повышения её надежности и устойчивости к возмущениям, при этом сохраняя функциональную эквивалентность. Этот процесс позволяет создавать схемы, которые не только корректно выполняют поставленную задачу, но и демонстрируют повышенную устойчивость к различным типам атак и искажений входных данных, что особенно важно для построения надежных и безопасных систем искусственного интеллекта.

Исследования направлены на создание нейронных сетей, представленных в виде схем, которые не только устойчивы к изменениям входных данных, но и легко поддаются проверке и интерпретации. Такой подход позволяет повысить доверие к системам искусственного интеллекта, обеспечивая возможность понимания логики их работы и подтверждения корректности принимаемых решений. Примечательно, что разработанные схемы демонстрируют сопоставимые размеры с менее сертифицированными методами, что делает их практичным решением для широкого спектра приложений, где важна как надежность, так и эффективность.

Исследование представляет собой очередное доказательство того, что элегантные теоретические построения часто разбиваются о суровую реальность продакшена. Авторы стремятся к “гарантированному” обнаружению нейронных цепей, что звучит почти как утопия. Однако, как показывает практика, даже формальные гарантии не способны предотвратить внезапное падение системы по понедельникам. Ведь всегда найдётся способ, которым продакшен сумеет обойти самые строгие проверки. Как точно подметил Анри Пуанкаре: «Математика не учит нас тому, что мы уже знаем, она учит нас думать». В данном случае, это означает, что поиск минимальных и устойчивых цепей — это не столько задача формальной верификации, сколько постоянная борьба с энтропией и непредсказуемостью реального мира.

Что дальше?

Представленный подход к автоматическому обнаружению нейронных цепей с «доказуемыми» гарантиями, безусловно, интересен. Однако, стоит помнить, что каждая «самовосстанавливающаяся» система рано или поздно ломается, а «доказуемость» — это лишь временное облегчение от неизбежной энтропии. Утверждения о минимальности и устойчивости, несомненно, привлекательны, но продукшен всегда найдет способ обойти даже самую элегантную теорию. Следующим шагом, вероятно, станет попытка масштабирования этих методов на сети, которые действительно используются где-то за пределами исследовательских лабораторий — и вот тогда-то и начнется самое интересное.

Неизбежно возникнет вопрос о применимости этих «формальных гарантий» к динамическим системам, которые постоянно меняются в процессе обучения. Ведь если баг воспроизводится, это означает, что у нас стабильная система — а стабильность в машинном обучении — это, скорее, исключение, чем правило. Очевидно, что документация по этим системам будет представлять собой форму коллективного самообмана, но кто обращает внимание на документацию, когда нужно срочно запустить продакшн?

В конечном итоге, настоящая проверка ждет впереди — когда эти методы столкнутся с реальными данными и непредсказуемыми сценариями использования. Можно предположить, что следующим этапом станет поиск способов автоматической «заплатки» устойчивости — то есть, создания алгоритмов, которые будут компенсировать неизбежные уязвимости, обнаруженные в процессе эксплуатации. И цикл повторится.

Оригинал статьи: https://arxiv.org/pdf/2602.16823.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Предел возможностей: где большие языковые модели теряют разум?

- Улучшение точности квантовых сенсоров: новый подход к подавлению шумов

- Резонансы в тандеме: Управление светом в микрорезонаторах

- Виртуальная примерка без границ: EVTAR учится у образов

- Искусственный разум и квантовые данные: новый подход к синтезу табличных данных

- Моделирование спектроскопии электронного пучка: новый подход

- Квантовое программирование: Карта развивающегося мира

- За пределами стандартной точности: новая структура эффективной теории

- Сердце музыки: открытые модели для создания композиций

- Тандем топ-кварков и бозона Хиггса: новые горизонты точности

2026-02-21 23:31