Автор: Денис Аветисян

В статье представлен обзор методов обучения с подкреплением, от классических алгоритмов до их применения в задачах квантового управления.

Рассмотрены основы обучения с подкреплением, включая процессы принятия решений Маркова, динамическое программирование, градиентные методы и алгоритмы «актер-критик».

Несмотря на успехи классического обучения с подкреплением, применение его методов к сложным задачам управления квантовыми системами требует адаптации и развития новых подходов. Данная работа, озаглавленная ‘From Classical to Quantum Reinforcement Learning and Its Applications in Quantum Control: A Beginner’s Tutorial’, представляет собой всестороннее введение в теорию и практику обучения с подкреплением, начиная с основ динамического программирования и заканчивая продвинутыми алгоритмами, такими как градиентные методы и актор-критик, с акцентом на их применение в задачах квантового управления. В результате представлен целостный обзор ключевых методов и их практической реализации. Какие перспективы открываются для дальнейшего развития гибридных квантово-классических алгоритмов обучения с подкреплением и их применения в различных областях науки и техники?

Последовательное принятие решений: взгляд в систему

Многие задачи, с которыми сталкивается современный мир — от управления роботами и финансами до разработки стратегий в играх и оптимизации логистики — требуют принятия последовательных решений, где каждое действие оказывает влияние на будущие состояния системы и получаемое вознаграждение. В отличие от задач, где решение принимается единожды, здесь необходимо учитывать долгосрочные последствия, предвидеть изменения и адаптироваться к ним. Например, при управлении автономным автомобилем, каждое решение о скорости, направлении движения и смене полосы влияет на дальнейшую траекторию, безопасность пассажиров и конечное время прибытия. Подобные задачи характеризуются динамической сложностью, где оптимальный выбор на текущем шаге зависит от предвидения будущих состояний и максимизации суммарного вознаграждения, что делает их особенно интересными для изучения в контексте искусственного интеллекта и теории управления.

Марковские процессы принятия решений (МППР) представляют собой мощный математический аппарат, позволяющий формализовать задачи, где последовательность действий влияет на будущее состояние системы и получаемое вознаграждение. В рамках МППР, каждое возможное состояние системы четко определено, и для каждого состояния известен набор доступных действий. Вероятность перехода из одного состояния в другое после выполнения определенного действия задается функцией вероятности перехода, а величина вознаграждения, получаемого за это действие, определяется функцией вознаграждения. Таким образом, МППР позволяет представить сложную динамическую систему в виде набора взаимосвязанных состояний, действий, вероятностей и вознаграждений, что делает возможным разработку алгоритмов для оптимального принятия решений в различных областях, от робототехники до экономики и искусственного интеллекта. P(s'|s,a) обозначает вероятность перехода в состояние s' из состояния s при выполнении действия a.

Фундаментальное значение в моделировании процессов принятия последовательных решений, таких как Марковские процессы принятия решений (МППР), имеют функция вознаграждения и вероятности перехода. Функция вознаграждения R(s, a) определяет, насколько выгодным является выполнение определенного действия a в конкретном состоянии s, напрямую формируя мотивацию агента. Вероятности перехода P(s'|s, a), в свою очередь, описывают вероятность перехода из состояния s в состояние s' после выполнения действия a, определяя динамику окружающей среды и предсказуемость последствий действий. Именно эти два компонента, тесно взаимосвязанные, формируют опыт агента и, как следствие, его способность находить оптимальную стратегию для достижения поставленных целей в рамках МППР.

Оценка ценности: от состояний к оптимальным стратегиям

Функция ценности состояния V_{\pi}(s) представляет собой оценку суммарной ожидаемой награды, которую агент получит, начиная с определенного состояния s и далее следуя заданной политике π. По сути, это математическое ожидание дисконтированной суммы будущих наград, полученных при следовании политике π из состояния s. Формально, V_{\pi}(s) = E_{\pi}[G_t | S_t = s], где G_t — суммарная дисконтированная награда, а S_t — состояние в момент времени t. Таким образом, функция ценности состояния позволяет оценить «качество» конкретного состояния с точки зрения долгосрочного вознаграждения при заданной стратегии поведения агента.

Динамическое программирование позволяет вычислить оптимальные значения состояний, последовательно оценивая ожидаемую суммарную награду для каждого состояния, исходя из оптимальной политики. Однако, сложность алгоритмов динамического программирования растет экспоненциально с увеличением размерности пространства состояний. Это связано с необходимостью итеративного вычисления значений для каждого возможного состояния, что делает применение данного подхода непрактичным для задач с большим числом состояний, таких как сложные игры или системы управления с высокой степенью детализации. В таких случаях требуются альтернативные методы, такие как методы Монте-Карло или временных различий, которые позволяют аппроксимировать оптимальные значения состояний, не требуя полного перебора пространства состояний.

Методы Монте-Карло оценивают значения состояний путем усреднения полученных суммарных наград (return) по множеству сгенерированных траекторий (последовательностей состояний и действий). В отличие от них, методы временных различий (Temporal Difference, TD) используют процедуру бутстрэппинга, то есть обучаются, используя оценки значений других состояний, что позволяет им обновлять оценки на основе неполных эпизодов и, таким образом, обучаться более эффективно, чем методы Монте-Карло, которым требуется завершение всей траектории для обновления оценки.

Оптимизация стратегий и передовые алгоритмы

Методы оптимизации стратегий (Policy Gradient Methods) представляют собой класс алгоритмов обучения с подкреплением, которые напрямую оптимизируют параметризованную стратегию (Policy) посредством максимизации целевой функции. В отличие от традиционных методов, основанных на оценке ценности (value-based methods), методы оптимизации стратегий не требуют явного вычисления функции ценности состояния или действия. Вместо этого, они используют градиент целевой функции для корректировки параметров стратегии, что позволяет напрямую влиять на вероятность выбора действий. Это достигается путем вычисления градиента, пропорционального ожидаемой суммарной награде, полученной при следовании данной стратегии, и последующим обновлением параметров стратегии в направлении этого градиента. \nabla J(\theta) = E_{\tau \sim \pi_{\theta}}[\sum_{t=0}^{T} \nabla_{\theta} \log \pi_{\theta}(a_t|s_t)R_t], где J(\theta) — целевая функция, \pi_{\theta} — параметризованная стратегия, a_t — действие в момент времени t, s_t — состояние в момент времени t, а R_t — суммарная награда, полученная начиная с момента времени t.

Функция преимущества (A(s,a) = Q(s,a) - V(s)) в методах градиента политики служит для оценки относительной полезности выполнения конкретного действия a в состоянии s по сравнению со средним значением, ожидаемым в этом состоянии. Вместо оценки абсолютного значения полезности действия, функция преимущества измеряет, насколько действие превосходит или уступает ожидаемой полезности состояния. Это позволяет снизить дисперсию оценок градиента политики, что приводит к более стабильному и эффективному обучению. Положительное значение A(s,a) указывает на то, что действие лучше ожидаемого, а отрицательное — хуже. Использование функции преимущества является ключевым элементом в алгоритмах, таких как A2C и A3C.

Методы «актер-критик» объединяют преимущества подходов, основанных на ценности и политике. В данной архитектуре, «актер» отвечает за обучение политике, то есть стратегии выбора действий, в то время как «критик» оценивает эффективность этой политики. Критик использует функцию ценности для оценки действий, предпринятых актером, предоставляя сигнал обратной связи, который используется для улучшения политики. В результате, алгоритм одновременно учится выбирать оптимальные действия и оценивать их эффективность, что позволяет добиться более стабильного и быстрого обучения по сравнению с использованием только методов, основанных на ценности или политике.

Квантовое обучение с подкреплением: новый рубеж

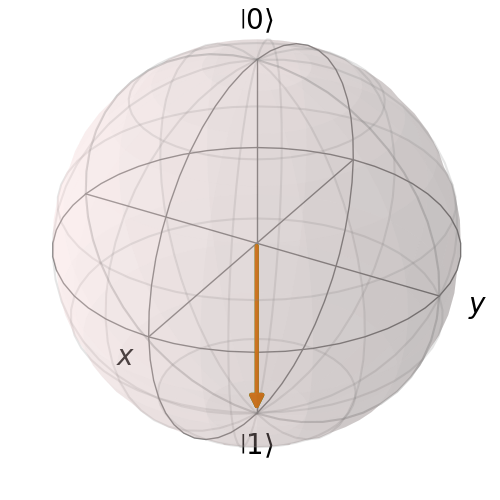

Квантовое обучение с подкреплением представляет собой инновационный подход, объединяющий принципы квантовой механики и алгоритмы обучения с подкреплением. Данное направление исследований направлено на использование квантовых явлений, таких как суперпозиция и запутанность, для повышения эффективности и скорости обучения агентов, решающих сложные задачи принятия решений. В отличие от классических алгоритмов, которые ограничены вычислительными возможностями бинарных систем, квантовое обучение с подкреплением открывает возможности для обработки информации в экспоненциально большем пространстве состояний, потенциально приводя к значительному улучшению производительности в различных областях, включая робототехнику, финансы и искусственный интеллект. Этот подход позволяет решать задачи, недоступные для традиционных методов, благодаря способности квантовых систем эффективно исследовать и оптимизировать сложные ландшафты решений.

В рамках квантового обучения с подкреплением, вариационные квантовые схемы выступают в роли обучаемых моделей, предлагая перспективные возможности для ускорения вычислений и повышения эффективности. Эти схемы, состоящие из последовательности квантовых вентилей с настраиваемыми параметрами, позволяют приближенно решать сложные задачи оптимизации, которые недоступны классическим алгоритмам. Использование вариационных схем позволяет эффективно отображать параметры задачи на квантовые состояния, а затем оптимизировать эти параметры посредством итеративного процесса, сочетающего квантовые вычисления и классическую оптимизацию. Такой подход позволяет исследовать пространство решений, недоступное для традиционных методов, и потенциально достигать более высоких уровней производительности в задачах, требующих принятия сложных решений, например, в области робототехники, финансов и искусственного интеллекта.

В ходе экспериментов с применением квантовых методов была достигнута точность контроля над одним кубитом в 0.99999998596, что демонстрирует значительный прогресс в области квантового обучения с подкреплением. Этот результат указывает на возможность преодоления ограничений, присущих классическим алгоритмам, и открывает перспективы для решения сложных задач принятия решений, недоступных традиционным методам. Достигнутая высокая степень точности позволяет надеяться на разработку более эффективных и мощных систем искусственного интеллекта, способных к обучению и адаптации в сложных и динамичных средах. Подобные достижения подчеркивают потенциал квантовых технологий для революционного изменения подходов к обучению машин и созданию принципиально новых алгоритмов.

Данная работа демонстрирует эволюцию методов обучения с подкреплением, начиная с классических подходов, таких как динамическое программирование и марковские процессы принятия решений, и заканчивая современными алгоритмами, вроде градиентных методов и актор-критик. Этот переход отражает стремление к более эффективным решениям в сложных системах. Как отмечал Марвин Минский: «Лучший способ понять — это построить». Именно построение и анализ моделей обучения с подкреплением, от базовых принципов до применения в квантовом управлении, позволяет глубже понять механизмы принятия решений и оптимизации, лежащие в основе интеллекта, как искусственного, так и естественного. Исследование, представленное в работе, подтверждает эту идею, демонстрируя, как последовательное построение и анализ алгоритмов ведет к новым возможностям управления сложными квантовыми системами.

Куда же дальше?

Представленный обзор, тщательно разбирая арсенал обучения с подкреплением — от классической динамики программирования до изящных градиентов политики — неизбежно наталкивает на вопрос: где заканчивается ремесло и начинается алхимия? Успешное применение этих методов к задачам квантового управления — лишь первый проблеск. Очевидно, что настоящий вызов заключается не в имитации существующих протоколов, а в создании принципиально новых, невозможных в рамках классического мышления. Ведь, в конце концов, что такое управление, как не поиск оптимального пути в лабиринте состояний?

Однако, не стоит забывать о тех самых «шероховатостях» этой прекрасной модели. Большинство алгоритмов, даже самые продвинутые, по-прежнему страдают от проклятия размерности, особенно применительно к сложным квантовым системам. Необходимы методы, способные эффективно работать с экспоненциально растущим пространством состояний, возможно, за счет отказа от представления полной картины и перехода к локальным, эмерджентным стратегиям. Или, что еще более радикально, к алгоритмам, которые сами генерируют упрощенные модели реальности.

В конечном счете, перспектива выглядит как постоянный цикл реверс-инжиниринга: разбор существующих решений, выявление их ограничений и создание новых, способных обойти эти ограничения. Это не просто оптимизация, а постоянное переписывание правил игры, чтобы в ней можно было играть по-новому. Ибо истина, как известно, скрывается не в ответе, а в самом процессе поиска.

Оригинал статьи: https://arxiv.org/pdf/2601.08662.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Укрощение шума: как оптимизировать квантовые алгоритмы

- Квантовый Борьба: Китай и США на Передовой

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

2026-01-14 07:48