Автор: Денис Аветисян

Исследователи предлагают усовершенствованные алгоритмы, позволяющие повысить эффективность поиска оптимальных решений в задачах комбинаторной оптимизации.

В статье представлены алгоритмы TApSA и SpSA, направленные на снижение колебаний в процессе имитации отжига на основе вероятностных битов (p-bit).

Несмотря на широкое применение алгоритма имитации отжига (SA) в решении комбинаторных задач оптимизации, его эффективность на больших масштабах зачастую ограничена. В настоящей работе, посвященной исследованию ‘Enhanced Convergence in p-bit Based Simulated Annealing with Partial Deactivation for Large-Scale Combinatorial Optimization Problems’, выявлена ключевая проблема, заключающаяся в нежелательных колебаниях вероятностных битов (p-bit) и приводящая к стагнации энергии в процессе оптимизации. Предложены два новых алгоритма — TApSA и SpSA — основанные на частичной деактивации p-bit, позволяющие существенно улучшить сходимость SA и добиться повышения качества решения на задачах MAX-CUT. Возможно ли дальнейшее развитие предложенного подхода и его адаптация к другим классам комбинаторных задач?

Пределы Классической Оптимизации

Многие задачи из реального мира, такие как оптимизация сетевых структур и машинное обучение, требуют поиска оптимального решения среди огромного числа возможных вариантов, что представляет собой серьезные вычислительные трудности. Представьте себе поиск единственного верного пути в лабиринте с миллиардами развилок — чем больше вариантов, тем сложнее и дольше процесс. Такой взрывной рост сложности, возникающий при увеличении масштаба задачи, делает традиционные методы оптимизации неэффективными, поскольку время вычислений растет экспоненциально. В результате, даже современные вычислительные мощности могут оказаться недостаточными для решения таких задач в разумные сроки, что стимулирует поиск новых, более эффективных алгоритмов и подходов к оптимизации.

Традиционные методы оптимизации, демонстрирующие эффективность при решении относительно простых задач, зачастую сталкиваются с серьезными трудностями при работе с современными, масштабными проблемами. Это связано с экспоненциальным ростом вычислительной сложности по мере увеличения числа переменных и ограничений. В результате, алгоритмы могут сходиться к решению крайне медленно, либо находить лишь субоптимальные решения, далекие от наилучшего возможного. Неспособность эффективно обрабатывать большие объемы данных и сложные взаимосвязи между переменными ограничивает применимость классических подходов в таких областях, как машинное обучение, логистика и сетевое планирование, что стимулирует поиск альтернативных стратегий оптимизации.

Неэффективность классических методов оптимизации при решении современных задач, таких как оптимизация сетей и машинное обучение, стимулирует поиск инновационных алгоритмов. В качестве альтернативы исследователи обращаются к вдохновленным физическими системами и вероятностными подходами решениям. Эти новые методы используют принципы, наблюдаемые в природе — от поведения магнитных материалов до процессов случайного поиска — чтобы преодолеть ограничения традиционных алгоритмов. Например, имитация отжига, вдохновленная процессом охлаждения металлов, позволяет алгоритмам избегать застревания в локальных оптимумах, а генетические алгоритмы, основанные на принципах эволюции, эффективно исследуют пространство решений. Такой подход позволяет находить более качественные решения за разумное время, открывая новые возможности для решения сложных оптимизационных задач.

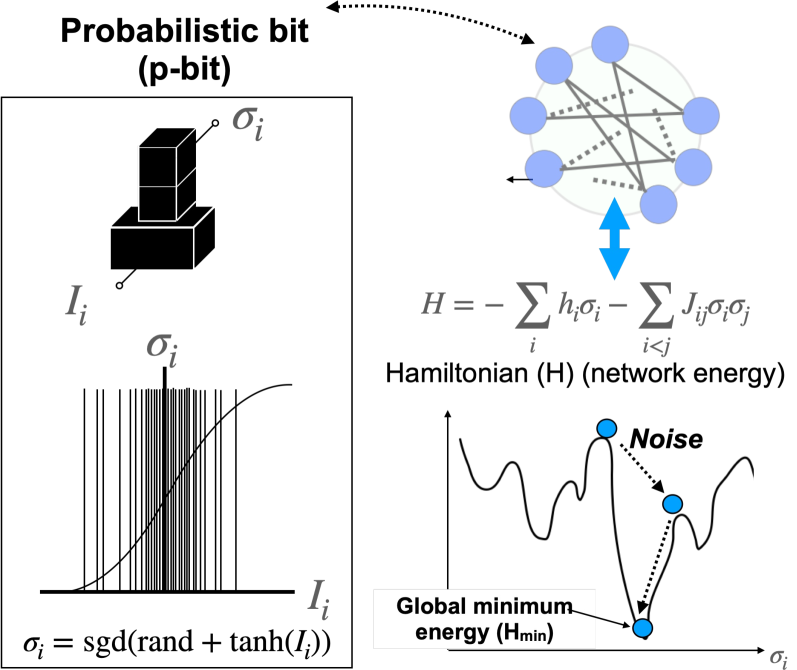

Модель Изинга представляет собой мощный инструмент для формализации сложных комбинаторных задач, устанавливая непосредственную связь с физическими системами. В её основе лежит представление задачи в виде спинов, способных принимать одно из двух состояний, взаимодействующих друг с другом и внешним магнитным полем. Такой подход позволяет перевести задачу оптимизации в эквивалентную задачу поиска основного состояния физической системы, где энергия соответствует стоимости решения. Использование принципов статистической физики, таких как kT\ln Z, позволяет оценивать вероятности различных конфигураций и находить оптимальное решение, даже в условиях высокой размерности и сложности. Благодаря своей способности моделировать фазовые переходы и критическое поведение, модель Изинга обеспечивает интуитивное понимание поведения сложных систем и открывает возможности для разработки новых алгоритмов оптимизации, вдохновленных природой.

Вероятностные Биты и Имитация Отжига: Новый Взгляд на Оптимизацию

Алгоритм имитации отжига (Simulated Annealing) представляет собой метод оптимизации, предназначенный для преодоления локальных оптимумов в процессе поиска решения. В основе метода лежит аналогия с процессом отжига металлов, где постепенное снижение температуры позволяет материалу достичь состояния с минимальной энергией. В алгоритме, вводится контролируемая случайность: на каждом шаге поиска, решение может быть изменено случайным образом, и принятие этого изменения определяется вероятностью, зависящей от «температуры» и разницы в значениях целевой функции. Высокая «температура» позволяет принимать даже ухудшающие решение изменения, что способствует исследованию более широкой области поиска и избежанию застревания в локальных оптимумах. Постепенное снижение «температуры» уменьшает вероятность принятия ухудшающих изменений, что позволяет алгоритму сходиться к глобальному оптимуму.

В отличие от традиционных бинарных представлений, использующих значения 0 или 1 для обозначения состояния переменной, вероятностные биты (Probabilistic Bits) оперируют значениями в диапазоне от 0 до 1. Это позволяет представлять неопределенность и частичную истинность, обеспечивая более гибкий и детальный способ исследования пространства решений. Вместо жесткого выбора между двумя состояниями, вероятностный бит определяет вероятность нахождения переменной в каждом из состояний. Такой подход особенно полезен в задачах оптимизации, где точное определение оптимального значения может быть затруднено, и необходимо исследовать различные компромиссы. Использование вероятностных битов позволяет алгоритму с большей вероятностью избегать застревания в локальных оптимумах, поскольку он способен «пробовать» решения, находящиеся за пределами жестких бинарных ограничений, и постепенно корректировать вероятности в зависимости от полученных результатов.

Машины Больцмана используют симметричные связи между нейронами в своих вероятностных битовых представлениях для обучения сложным закономерностям в данных. Симметричность связей означает, что вес между двумя нейронами одинаков в обоих направлениях, что позволяет алгоритму эффективно моделировать вероятностные зависимости. Это отличает их от традиционных нейронных сетей и позволяет более эффективно выполнять задачи, такие как обучение представлений и генерация данных. Использование вероятностных битов, представляющих значения между 0 и 1, позволяет сети учитывать неопределенность и находить более устойчивые решения, повышая ее адаптивность к различным типам данных и задачам.

Вычислительная сложность методов, использующих вероятностные биты и отжиг, значительно снижается при использовании параллельных алгоритмов, реализованных на графических процессорах (GPU). GPU позволяют распараллелить множество независимых вычислений, таких как оценка функций стоимости и обновление вероятностных битов, что приводит к экспоненциальному увеличению скорости обработки данных. Благодаря этому, задачи, требующие огромного количества итераций для достижения приемлемого решения, становятся практически реализуемыми для крупномасштабных проблем, например, в области машинного обучения и оптимизации комбинаторных задач. Эффективность GPU-ускорения возрастает с увеличением размерности пространства поиска и сложности целевой функции.

Уточнение Поиска: pSA и Его Вариации

pSA (вероятностный отжиг) реализует алгоритм отжига, используя вероятностные биты для представления параметров решения и ландшафта поиска. Вместо традиционного представления значений числами с плавающей точкой, pSA кодирует их как частоту единиц в битовом потоке. Такой подход позволяет компактно представлять пространство решений и эффективно выполнять вероятностные вычисления, необходимые для алгоритма отжига, снижая требования к вычислительным ресурсам и памяти. Использование вероятностных битов позволяет реализовать ключевые операции отжига — генерацию новых решений и оценку их качества — с использованием простых логических операций над битовыми потоками.

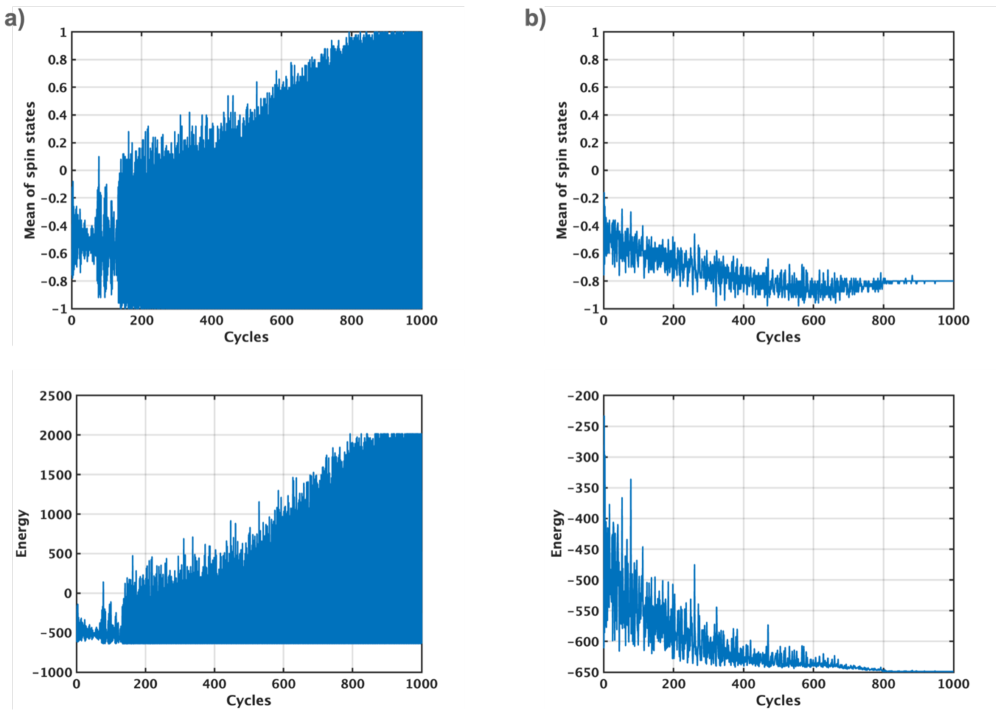

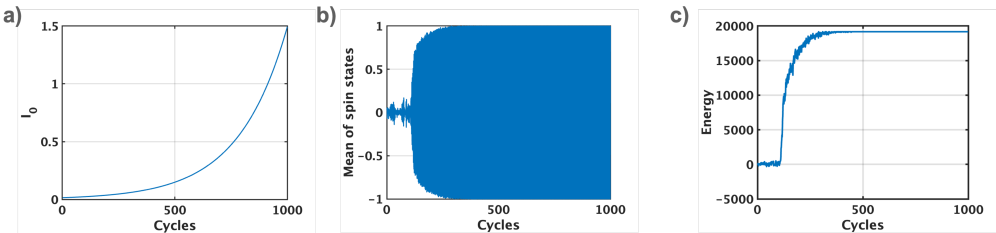

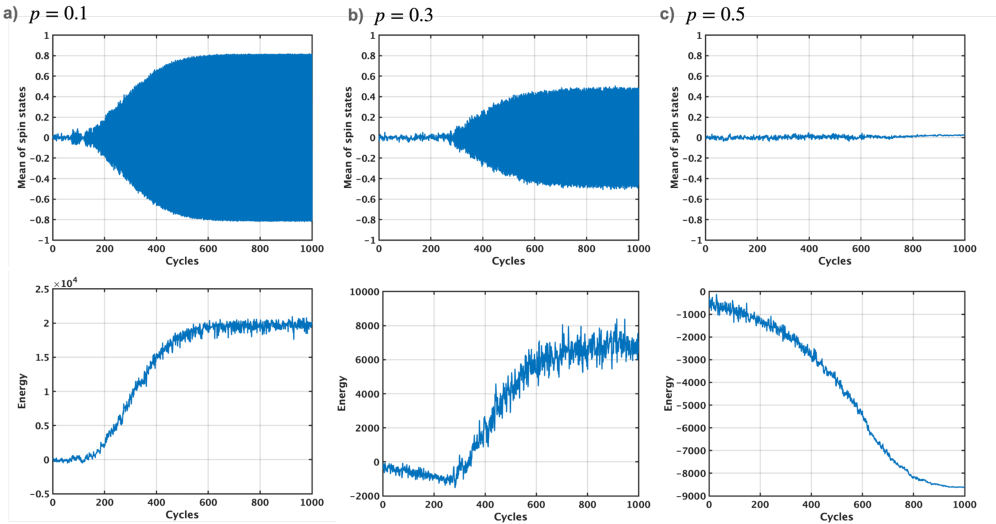

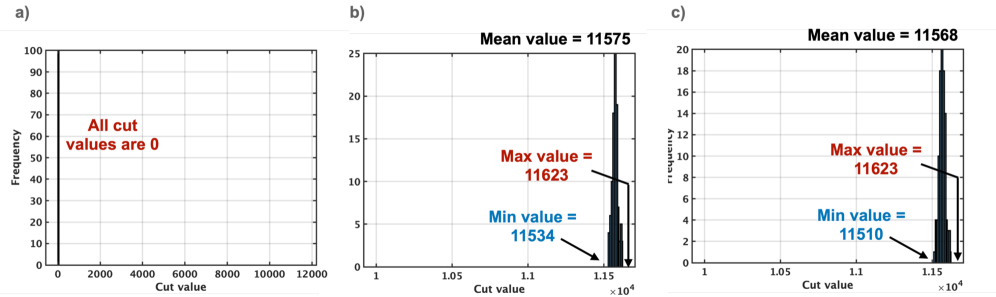

Алгоритм pSA, реализующий имитацию отжига с использованием вероятностных битов, может демонстрировать колебания в процессе поиска, что негативно сказывается на скорости сходимости и стабильности. Для решения этой проблемы были разработаны алгоритмы SpSA и TApSA. SpSA использует вероятностную задержку обновления параметров, а TApSA — усреднение входных данных, представленных в виде вероятностных битов. Данные подходы позволяют снизить влияние колебаний и повысить эффективность поиска оптимального решения, что подтверждается результатами тестов на задаче MAX-CUT и других задачах комбинаторной оптимизации.

В основе усовершенствованных алгоритмов pSA, SpSA и TApSA лежат принципы стохастических вычислений. В данном подходе, значения представляются в виде частоты единиц в битовых потоках. Это позволяет эффективно выполнять вероятностные вычисления, используя операции над битами вместо традиционных арифметических операций с числами с плавающей точкой. Вместо хранения точного значения переменной, алгоритм оперирует вероятностью её состояния, кодируемой частотой единиц в битовом потоке. Такое представление позволяет существенно снизить энергопотребление и сложность аппаратной реализации, сохраняя при этом высокую точность и эффективность вычислений в задачах оптимизации.

В ходе тестирования на задаче MAX-CUT и других задачах комбинаторной оптимизации, модифицированные алгоритмы SpSA и TApSA продемонстрировали значительное превосходство над традиционными методами. SpSA и TApSA достигли нормализованных средних значений разреза в 98.4% и 98.3% соответственно. В то же время, стандартный алгоритм pSA показал результат всего в 0.8%, а классический Simulated Annealing — 44.4%. Эти данные свидетельствуют о существенном повышении эффективности предложенных усовершенствований в решении сложных оптимизационных задач.

За Пределами Отжига: Расширение Инструментария Оптимизации

Для решения задач оптимизации, выходящих за рамки возможностей стандартного отжига, были разработаны передовые методы, расширяющие его базовые принципы. Параллельный отжиг, например, использует несколько «копий» системы при различных температурах, позволяя ей исследовать пространство решений более эффективно и избегать застревания в локальных минимумах. Симулированная бифуркация, в свою очередь, вводит управляемые изменения в ландшафт энергии, стимулируя систему к выходу из неоптимальных состояний. Сети связанных осцилляторов предлагают альтернативный подход, используя взаимодействие между элементами для поиска глобального минимума энергии. Эти методы, сохраняя общую идею постепенного снижения «температуры» и принятия как улучшающих, так и ухудшающих решений, позволяют успешно решать значительно более сложные и многомерные задачи оптимизации, находя применение в различных областях, от машинного обучения до моделирования физических систем.

Модель Изинга продолжает оставаться краеугольным камнем в области оптимизации, выступая в качестве универсального фреймворка для представления задач из самых разных областей. Её способность моделировать взаимодействие между элементами, находящимися в дискретных состояниях, позволяет эффективно описывать сложные системы — от спиновых стекол в физике до социальных сетей и алгоритмов машинного обучения. В частности, в сетевом анализе, узлы сети могут быть представлены как спины в модели Изинга, а связи между ними — как взаимодействия между этими спинами. В машинном обучении, модель Изинга находит применение в задачах обучения с учителем и без учителя, позволяя находить оптимальные параметры моделей и решать задачи кластеризации. Гибкость и универсальность модели Изинга обеспечивают её непреходящую актуальность и широкое применение в различных научных дисциплинах, несмотря на появление новых и более сложных методов оптимизации.

В рамках подхода, основанного на модели Изинга, методы Гиббса и когерентные машины Изинга представляют собой альтернативные стратегии исследования пространства решений, дополняя возможности друг друга. Метод Гиббса, основанный на последовательном обновлении переменных с учетом вероятностных зависимостей, позволяет эффективно исследовать конфигурации, близкие к оптимальным. Когерентные машины Изинга, напротив, используют динамику спиновых стекол для поиска глобального минимума энергии, что особенно полезно в задачах, характеризующихся сложным ландшафтом энергии. Сочетание этих подходов позволяет преодолеть ограничения, присущие каждому из них по отдельности, и добиться более надежных и быстрых результатов в оптимизации сложных систем, применяемых в различных областях, от машинного обучения до анализа сетей.

Квантовый отжиг представляет собой принципиально новый подход к оптимизации, использующий квантово-механические явления для поиска оптимальных решений. В отличие от классических алгоритмов, которые исследуют пространство решений последовательно, квантовый отжиг использует квантовую суперпозицию и туннелирование для одновременного исследования множества возможных решений. Это позволяет потенциально достичь экспоненциального ускорения в решении определенных типов задач оптимизации, особенно тех, которые сформулированы как задачи минимизации энергии, например, задача о коммивояжере или задача о максимальном потоке. Вместо постепенного снижения температуры, как в обычном отжиге, квантовый отжиг использует квантовые флуктуации для преодоления энергетических барьеров и поиска глобального минимума. Хотя практическая реализация и масштабирование квантовых отжигов сталкиваются с серьезными техническими трудностями, они представляют собой перспективное направление в разработке алгоритмов оптимизации для широкого спектра приложений, включая машинное обучение, финансы и материаловедение.

Представленное исследование демонстрирует стремление к математической чистоте в алгоритмах оптимизации. Авторы выявляют колебания как ключевое препятствие в методе Simulated Annealing на основе вероятностных битов (p-bit), и предлагают решения, направленные на их смягчение. Это напоминает о важности доказательства корректности алгоритма, а не просто достижения хороших результатов на тестовых данных. Бертранд Рассел однажды сказал: «Всякая истина и всякое знание должны быть доказаны». Подобный подход к оптимизации, где стремятся к устранению колебаний и повышению сходимости, отражает эту же логику — поиск надежного и доказуемого решения, а не временного компромисса.

Куда Далее?

Представленная работа, хотя и демонстрирует снижение осцилляций в алгоритмах Simulated Annealing на основе вероятностных битов (p-bit), лишь приоткрывает завесу над сложной природой оптимизации комбинаторных задач. Устранение осцилляций — необходимое, но недостаточное условие достижения истинной элегантности. Проблема графового изоморфизма, например, продолжает оставаться вызовом, требующим не просто улучшения скорости сходимости, а принципиально новых подходов к представлению и манипулированию данными.

Перспективы дальнейших исследований лежат, вероятно, в области адаптивного управления вероятностью активации p-bit, основанного на анализе локальной кривизны целевой функции. Вместо слепого уменьшения осцилляций, алгоритм должен «чувствовать» ландшафт оптимизации и соответствующим образом корректировать стратегию поиска. Иначе говоря, алгоритм должен быть доказуемо эффективным, а не просто «работать на тестах».

В конечном итоге, в хаосе данных спасает только математическая дисциплина. Разработка формальных методов верификации алгоритмов оптимизации, гарантирующих их корректность и сходимость, представляется задачей не меньшей важности, чем поиск новых эвристик. Истинная красота алгоритма — в его математической чистоте, а не в эмпирической производительности.

Оригинал статьи: https://arxiv.org/pdf/2601.15561.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

2026-01-23 14:01