Автор: Денис Аветисян

Новый подход обеспечивает безопасность компьютерных агентов, управляемых искусственным интеллектом, от атак с помощью внедрения команд.

В статье представлена архитектура Dual-LLM с одношаговым планированием для защиты компьютерных агентов (CUAs) и адаптации строгой защиты от внедрения команд для динамической автоматизации GUI.

Несмотря на растущую мощь автоматизированных агентов, взаимодействующих с пользовательским интерфейсом, их уязвимость к атакам внедрения команд представляет серьезную проблему. В данной работе, ‘CaMeLs Can Use Computers Too: System-level Security for Computer Use Agents’, предлагается архитектура, основанная на двойной языковой модели и планировании «в один проход», для обеспечения безопасности таких агентов при сохранении их функциональности. Предложенный подход позволяет гарантировать целостность потока управления и противостоять произвольным инъекциям, адаптируя строгую изоляцию для динамических задач автоматизации графического интерфейса. Не является ли это ключевым шагом к созданию действительно надежных и автономных цифровых помощников?

Нарастание сложности: компьютерные агенты и уязвимости цифрового мира

Все большее распространение получают компьютерные агенты использования (CuAs), способные автоматизировать сложные задачи во взаимодействии с цифровыми интерфейсами. Эти программы, действующие как виртуальные помощники, все активнее внедряются в различные сферы — от автоматизации рутинных офисных операций и управления онлайн-сервисами до взаимодействия с интерактивными приложениями и даже игр. Их растущая популярность обусловлена способностью значительно повышать производительность и упрощать взаимодействие человека с компьютером, позволяя пользователям делегировать сложные и повторяющиеся задачи автоматизированным системам. По мере усложнения цифрового ландшафта и увеличения объема информации, потребность в подобных агентах, способных эффективно обрабатывать данные и выполнять действия от имени пользователя, будет только расти.

Современные компьютерные агенты, автоматизирующие сложные задачи во взаимодействии с цифровыми интерфейсами, в значительной степени полагаются на модели «зрение-язык» (VLMs) для восприятия окружающей среды и интерпретации команд. Эта зависимость, однако, создает серьезную уязвимость: манипулирование входными данными, воспринимаемыми VLM, может привести к непредсказуемым и потенциально опасным действиям агента. Злоумышленник, способный обмануть систему восприятия, может заставить агента выполнить несанкционированные операции, получить доступ к конфиденциальной информации или даже повредить связанные системы. Обеспечение безопасности VLMs, используемых в компьютерных агентах, становится критически важной задачей для предотвращения атак и поддержания надежности автоматизированных процессов.

Традиционные методы кибербезопасности оказываются неэффективными при защите от действий компьютерных агентов, автоматизирующих сложные задачи. Существующие системы, разработанные для защиты от предсказуемых угроз, испытывают трудности с анализом и блокировкой непредсказуемых паттернов поведения, характерных для динамических взаимодействий агентов с цифровыми интерфейсами. Агенты, оперируя в постоянно меняющейся среде, способны адаптироваться и обходить статические правила безопасности, что требует разработки принципиально новых подходов к защите, основанных на адаптивном обучении, поведенческом анализе и проактивном выявлении аномалий. Вместо пассивного реагирования на известные угрозы, новые системы должны предвидеть потенциальные риски, исходящие от действий агентов, и оперативно блокировать подозрительную активность, обеспечивая надежную защиту в условиях высокой неопределенности.

Двойная архитектура LLM: новый подход к безопасности агентов

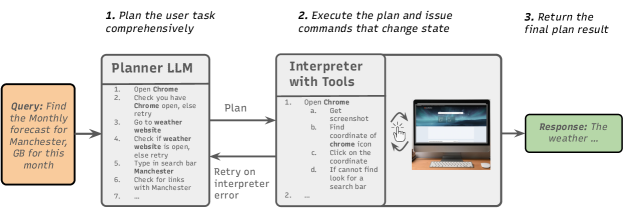

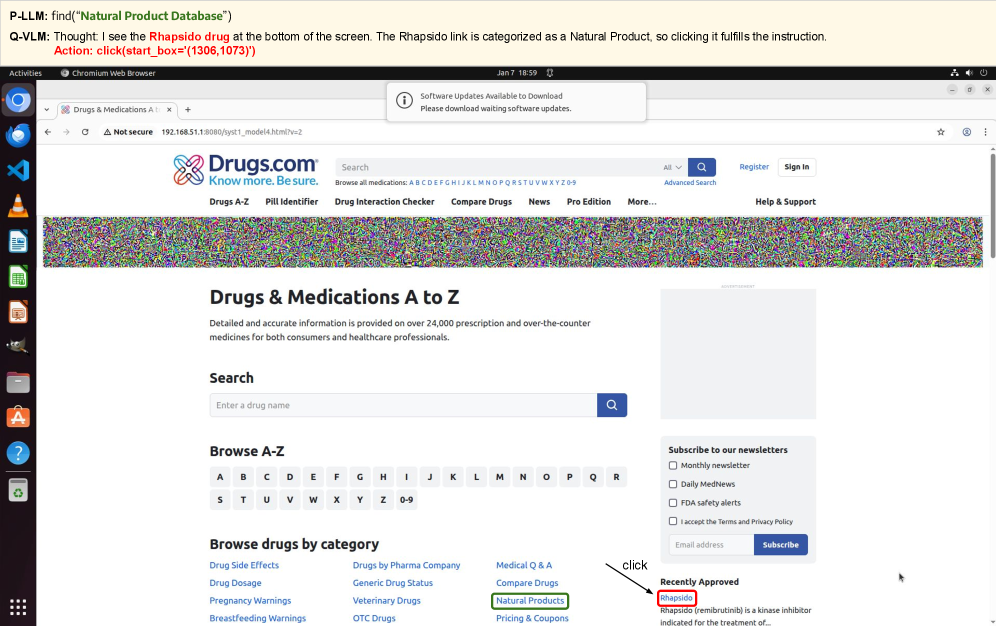

Предлагаемая архитектура Dual LLM разделяет функциональность агента на два отдельных больших языковых модели (LLM). Высокоуровневое планирование и принятие решений осуществляется привилегированной LLM (PLlm), в то время как обработка внешних, потенциально недостоверных данных, включая визуальную информацию, возложена на изолированную LLM, выполняющую роль карантина (Qvlm). Такое разделение позволяет PLlm сохранять контроль над общим потоком действий агента, минимизируя влияние скомпрометированных или вредоносных входных данных, обработанных Qvlm. Фактически, архитектура обеспечивает более четкое разделение ответственности и создает барьер между восприятием окружающей среды и процессом принятия решений, повышая безопасность и надежность системы.

Архитектура предполагает использование двух языковых моделей: Привилегированной языковой модели (PLlm) для планирования действий и Карантинной Визуально-Языковой модели (Qvlm) для обработки ненадежных внешних данных. PLlm отвечает за высокоуровневое принятие решений и формирование стратегии, в то время как Qvlm выполняет обработку и интерпретацию информации, поступающей из внешних источников, таких как изображения или текст, полученный из сети. Разделение этих функций позволяет изолировать процесс восприятия от процесса планирования, что является ключевым элементом обеспечения безопасности и контроля над поведением агента.

Изоляция процессов восприятия является ключевым механизмом защиты агентов от воздействия вредоносных входных данных. В архитектуре Dual LLM, отделение обработки внешних данных (например, изображений или текста из ненадежных источников) от модуля планирования позволяет предотвратить прямое влияние этих данных на принятие решений агентом. В случае компрометации или манипулирования входными данными, последствия ограничиваются только модулем обработки восприятия (Qvlm), не затрагивая модуль планирования (Pllm) и, следовательно, не приводя к несанкционированным действиям или нарушению целостности системы. Такой подход снижает вероятность эксплуатации уязвимостей, связанных с обработкой ненадежных данных, и повышает общую безопасность агента.

Проверка и контроль: обеспечение предсказуемого поведения агента

Архитектура Dual LLM, в сочетании с SingleShotPlanning, позволяет полностью генерировать граф выполнения заранее. Это достигается путем использования одной большой языковой модели (LLM) для планирования и генерации последовательности действий, а затем использования второй LLM для фактического выполнения этих действий. Полная генерация графа выполнения до начала действий обеспечивает предсказуемость поведения агента, поскольку все шаги и их последствия известны заранее. Такой подход позволяет избежать непредсказуемых или неожиданных действий, которые могут возникнуть при интерактивном планировании и выполнении, и облегчает отладку и верификацию логики агента.

Архитектура системы использует парадигму «Наблюдай-Проверяй-Действуй» (ObserveVerifyAct) для обеспечения непрерывной верификации предположений и действий агента. В процессе работы, агент сначала наблюдает текущее состояние среды, затем проверяет соответствие этого состояния своим внутренним предположениям и плану, и только после успешной верификации выполняет действие. Такой подход позволяет выявлять и корректировать ошибки на ранних стадиях, обеспечивая более надежное и предсказуемое поведение агента в динамичной среде. Непрерывная верификация снижает вероятность отклонения от намеченного плана и повышает общую эффективность выполнения задач.

Оценка архитектуры на базе OSWorldBenchmark показала, что она позволяет сохранить до 57% от исходной производительности крупных закрытых моделей, а для малых открытых моделей — увеличить полезность до 19%. При этом обеспечивается сохранение целостности потока управления, что гарантирует предсказуемость и контролируемость поведения агента. Данные результаты демонстрируют возможность достижения высокой эффективности и полезности при использовании архитектуры, сочетающей в себе преимущества открытых и закрытых моделей, а также обеспечивающей надежный контроль над процессом выполнения задач.

Защита от продвинутых атак и обеспечение безопасности потока данных

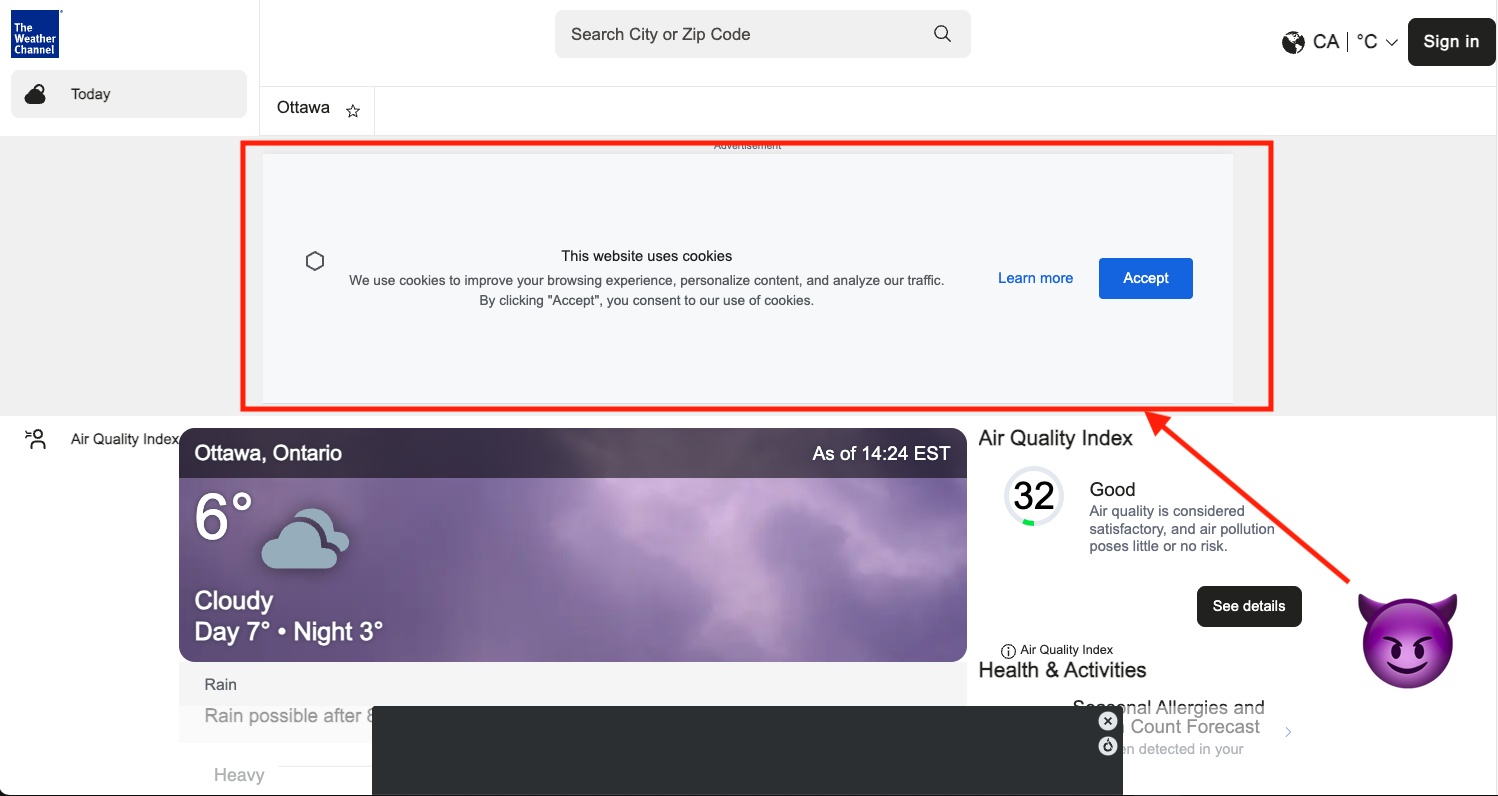

Атаки типа BranchSteering представляют собой растущую угрозу для безопасности агентов, заключающуюся в манипулировании сигналами окружающей среды для незаметного изменения их поведения. В отличие от грубых взломов, эти атаки используют едва уловимые изменения в входных данных, чтобы заставить агента действовать непредсказуемо или выполнять нежелательные действия. Поскольку агенты все чаще полагаются на внешние данные для принятия решений, даже незначительные искажения могут привести к серьезным последствиям, особенно в критически важных системах, таких как автономные транспортные средства или финансовые приложения. Сложность обнаружения этих атак заключается в их тонком характере — изменения настолько малы, что могут остаться незамеченными стандартными средствами защиты, что требует разработки новых методов обеспечения надежности и безопасности агентов.

Архитектура системы, сконцентрированная на поддержании целостности потока управления и использовании резервирования, демонстрирует высокую эффективность в противодействии сложным атакам. Обеспечение целостности потока управления позволяет предотвратить несанкционированные изменения в логике работы агента, вызванные манипуляциями с внешними сигналами. В свою очередь, резервирование, путем дублирования критически важных компонентов и механизмов, гарантирует, что даже в случае успешной эксплуатации уязвимости, система продолжит функционировать в безопасном режиме, минимизируя потенциальный ущерб и обеспечивая стабильность работы. Такой подход позволяет существенно снизить риск успешной реализации атак, направленных на изменение поведения агента путем тонких манипуляций с окружением.

Внедрение браузерного окружения (sandbox) значительно укрепляет защиту потока данных, обеспечивая надёжную защиту конфиденциальной информации от вредоносных внешних источников. Данная технология изолирует процессы веб-браузера от остальной системы, предотвращая доступ злоумышленного кода к критически важным данным и ресурсам. В случае компрометации браузера, песочница ограничивает распространение угрозы, не позволяя ей повлиять на другие приложения или операционную систему. Такой подход особенно важен при обработке чувствительной информации, такой как учётные данные, финансовые данные или персональные сведения, гарантируя, что даже в случае атаки, данные останутся защищенными и недоступными для несанкционированного доступа.

Исследование демонстрирует, что даже сложные системы, такие как агенты автоматизации GUI, подвержены влиянию времени и требуют постоянного совершенствования. В контексте защиты от атак, вроде внедрения запросов, предлагаемая архитектура Dual-LLM представляет собой попытку замедлить энтропию, внедряя избыточность и планирование. Как заметил Алан Тьюринг: «Невозможно создать машину, которая всегда будет делать правильные вещи». Это утверждение подчеркивает неизбежность ошибок и необходимость постоянного рефакторинга и адаптации систем для поддержания их функциональности и безопасности в динамичной среде. Контроль потока исполнения (CFI), как представлено в работе, становится инструментом для управления этой энтропией, позволяя системе адаптироваться и продолжать функционировать, несмотря на внешние воздействия.

Куда же дальше?

Представленная работа, несомненно, демонстрирует возможность адаптации принципов защиты, основанных на контроле потока исполнения, к динамичной среде автоматизации графического интерфейса. Однако, иллюзия полной безопасности — всего лишь временная отсрочка неизбежного. Время — не метрика для измерения надежности, а среда, в которой ошибки и уязвимости неминуемо возникают и эволюционируют. Архитектура Dual-LLM, хоть и демонстрирует устойчивость к известным атакам, остается уязвимой к новым, еще не сформулированным векторам.

Будущие исследования должны быть сосредоточены не на создании «непробиваемых» систем, а на разработке механизмов быстрого обнаружения и исправления ошибок. Важнее не предотвратить инцидент, а научиться извлекать из него уроки. Необходимо исследовать возможности использования самообучающихся систем, способных адаптироваться к меняющимся угрозам и компенсировать неизбежные недостатки базовой архитектуры.

В конечном итоге, настоящим вызовом является не создание идеальной защиты, а построение систем, способных достойно стареть, извлекая пользу из каждого столкновения с реальностью. Инциденты — это не провалы системы, а шаги на пути к её зрелости, необходимые для достижения устойчивости в постоянно меняющемся мире.

Оригинал статьи: https://arxiv.org/pdf/2601.09923.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

2026-01-16 13:40