Автор: Денис Аветисян

В статье описывается усовершенствование системы высокоуровневых триггеров детектора CMS для более эффективной идентификации адронно распадающихся тау-лептонов.

В работе представлены результаты внедрения алгоритмов машинного обучения для повышения эффективности триггеров и улучшения возможностей анализа физических данных.

Идентификация адронных распада тау-лептонов в условиях высокой загруженности экспериментов становится все более сложной задачей. В работе, посвященной разработке высокоуровневых триггеров для идентификации адронных тау-лептонов в эксперименте CMS при столкновениях протонов на энергии \sqrt{s} = 13.6 ТэВ, представлены усовершенствованные алгоритмы машинного обучения, интегрированные в систему триггеров. Разработанные решения обеспечивают повышение эффективности выделения тау-лептонов и, как следствие, улучшение возможностей физического анализа полученных данных. Каковы перспективы дальнейшего повышения точности и скорости идентификации тау-лептонов с использованием новейших методов машинного обучения?

Поиск за Пределами Стандартной Модели: Столкновение Данных и Теории

Несмотря на впечатляющие успехи, Стандартная модель физики элементарных частиц не способна объяснить все наблюдаемые явления во Вселенной. Например, она не дает ответа на вопрос о природе темной материи и темной энергии, составляющих большую часть массы-энергии Вселенной, а также не объясняет дисбаланс между материей и антиматерией. Более того, масса нейтрино, согласно Стандартной модели, должна быть нулевой, что противоречит экспериментальным данным. Эти фундаментальные нерешенные вопросы стимулируют активные поиски “физики за пределами Стандартной модели”, направленные на открытие новых частиц и взаимодействий, которые могли бы дополнить или заменить существующую теорию. Исследователи предполагают, что ответы могут скрываться в изучении экстремальных условий, возникающих при столкновениях частиц на Большом адронном коллайдере, где возможно проявление новых физических явлений, недоступных в обычных лабораторных условиях.

В Большом адронном коллайдере (БАК) фундаментальные частицы, протоны, разгоняются до скоростей, близких к световой, и сталкиваются друг с другом. Эти высокоэнергетические столкновения создают каскад новых частиц, которые затем регистрируются сложными детекторами. Полученный объем данных огромен и требует применения передовых методов анализа, включая машинное обучение и статистическое моделирование, для выделения редких событий, которые могут указывать на проявления новой физики, выходящей за рамки Стандартной модели. Именно в этих экспериментах, требующих колоссальных вычислительных ресурсов и сложных алгоритмов, ученые надеются обнаружить свидетельства новых частиц и взаимодействий, расширяющих наше понимание фундаментальных законов природы.

Реконструкция Реальности: Детектор CMS и Система Триггеров

Детектор CMS предназначен для регистрации продуктов распада протонов при столкновениях в Большом адронном коллайдере (LHC). Он состоит из нескольких слоев различных детекторов, каждый из которых оптимизирован для измерения определенных характеристик частиц. Внутренний трековый детектор, состоящий из кремниевых датчиков, обеспечивает высокую точность измерения траекторий заряженных частиц. Электромагнитный и адронный калориметры измеряют энергию электронов, фотонов и адронов. Мюонные камеры позволяют идентифицировать мюоны, проникающие сквозь другие слои детектора. Комбинация измерений энергии и импульса каждой зарегистрированной частицы позволяет реконструировать события столкновений и исследовать фундаментальные законы физики.

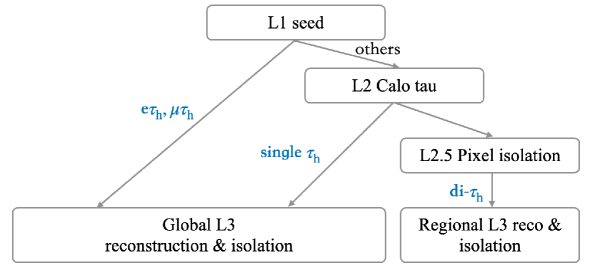

Двухуровневая система триггеров предназначена для быстрой фильтрации данных, генерируемых при столкновениях в Большом адронном коллайдере, с целью отбора событий, представляющих интерес для дальнейшего анализа. Первый уровень, аппаратный триггер (L1), основан на быстрых, специализированных электронных схемах и принимает решения в режиме реального времени, опираясь на грубые измерения энергии и импульса частиц. Второй уровень, программный триггер высокой точности (HLT), использует более сложные алгоритмы, работающие на вычислительных ресурсах, для проведения детального анализа данных, прошедших предварительный отбор на уровне L1. Комбинация этих двух уровней позволяет значительно сократить объем записываемых данных, сохраняя при этом важные физические события.

Система Высокоуровневых Триггеров (HLT) в CMS использует сложные алгоритмы, такие как Particle Flow, для точной реконструкции частиц, образующихся в результате столкновений. В основе Particle Flow лежит алгоритм Anti-kt, который позволяет идентифицировать и измерять импульс частиц, комбинируя информацию от различных поддетекторов. Алгоритм Anti-kt эффективно разрешает близко расположенные частицы и минимизирует влияние шумов, обеспечивая высокую точность измерения энергии и импульса конечных частиц, необходимых для физического анализа. Этот подход позволяет выделить интересные события и снизить объем данных, записываемых для дальнейшей обработки, сохраняя при этом важную физическую информацию.

Идентификация Тау-Лептона: Продвинутые Методы Идентификации

Лεπтон тау играет ключевую роль в поисках новой физики, особенно в контексте распада бозона Хиггса и явлений, выходящих за рамки Стандартной модели. Его уникальные свойства распада, включающие возможность распада на адроны и лептоны, позволяют исследовать взаимодействия, которые могут указывать на существование частиц и сил, не описанных в рамках текущей теоретической модели. Высокая масса тау-лептона, а также его короткое время жизни, обуславливают специфические характеристики его распада, которые необходимо учитывать при анализе данных, полученных на Большом адронном коллайдере. Идентификация тау-лептонов позволяет проводить точные измерения параметров бозона Хиггса и искать отклонения от предсказаний Стандартной модели, что может указывать на новые физические процессы.

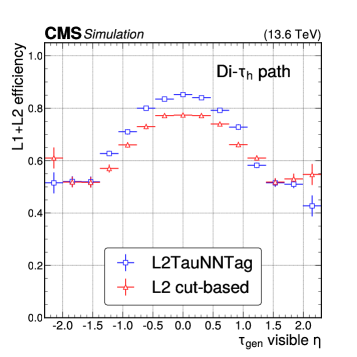

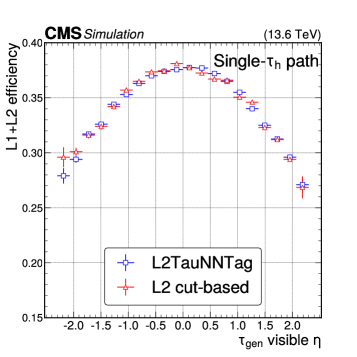

Идентификация тау-лептонов на фоне шума требует применения критериев изоляции и использования продвинутых алгоритмов, таких как DeepTau и L2TauNNTag, в рамках системы HLT (High Level Trigger). Критерии изоляции направлены на подавление событий, в которых тау-лептон порождается не из интересующего распада, путем оценки энергии, импульса и идентификации частиц вблизи кандидата на тау-лептон. Алгоритмы DeepTau и L2TauNNTag используют сверточные нейронные сети, обученные на данных Монте-Карло, для эффективного различения кандидатов на тау-лептон и подавления фоновых событий, что позволяет повысить точность реконструкции тау-лептонов и чувствительность к новым физическим явлениям.

Для эффективной идентификации кандидатов на тау-лептоны используются сверточные нейронные сети, обученные на данных, полученных в ходе моделирования методом Монте-Карло. Специализированные алгоритмы, такие как HPS (Hadronic Particle Selection), применяются для реконструкции адронных распадов тау-лептонов. Данный анализ основан на интегрированной светимости в 62 fb⁻¹, накопленной в период с 2022 по 2023 год при энергии столкновения пучков 13.6 ТэВ.

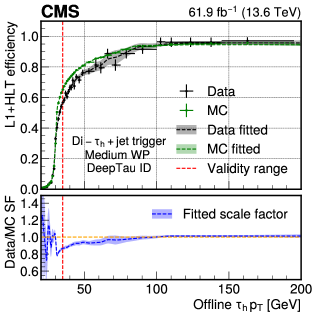

Валидация Анализа: Калибровка и Контроль Систематических Погрешностей

Расхождения между экспериментальными данными и результатами моделирования неизбежно вносят систематические неопределенности, которые требуют тщательной коррекции для обеспечения точности анализа. Для этой цели активно используются методы, такие как регрессия Гаусса (Gaussian Process Regression), позволяющие оценивать масштабные коэффициенты, корректирующие расхождения. Данный подход позволяет построить непрерывную функцию, описывающую отклонения между данными и симуляцией, что особенно важно при анализе сложных процессов, где точное соответствие между теорией и экспериментом критично. Применение регрессии Гаусса обеспечивает более надежную калибровку и позволяет минимизировать влияние систематических погрешностей на конечные результаты, что является ключевым фактором при поиске новых физических явлений и проверке существующих теорий.

Для повышения точности идентификации тау-лептонов применяется метод регрессии Гаусса, позволяющий определить поправочные коэффициенты, корректирующие расхождения между данными и результатами моделирования. Данная регрессия выявляет систематические отклонения, возникающие из-за несоответствий между смоделированными и реальными процессами, и позволяет масштабировать результаты моделирования таким образом, чтобы они лучше соответствовали экспериментальным данным. Определение этих коэффициентов — важный этап, гарантирующий надежность анализа и позволяющий минимизировать влияние систематических неопределенностей на конечные результаты, что особенно критично при поиске новых физических явлений.

Точность определения ключевых параметров, таких как разрешение по энергии струй и эффективность реконструкции мюонов, имеет первостепенное значение для интерпретации результатов поиска новой физики. Измерения показали, что разрешение по энергии струй составляет 15-20% при 30 ГэВ, снижается до 10% при 100 ГэВ и достигает 5% при 1 ТэВ. При этом эффективность реконструкции мюонов превышает 96%. Эти показатели напрямую влияют на способность экспериментов обнаруживать редкие события и отличать их от фоновых процессов, что делает точные измерения и калибровку приборов критически важными для получения надежных научных выводов и подтверждения или опровержения существующих теоретических моделей.

Представленная работа демонстрирует, как сложные алгоритмы машинного обучения внедряются в систему высокоуровневых триггеров CMS для повышения эффективности идентификации адронно распадающихся тау-лептонов. Этот процесс, казалось бы, технический, на самом деле отражает стремление человека к предсказуемости в хаосе данных. Как отмечал Ричард Фейнман: «Если вы не можете объяснить что-то простыми словами, значит, вы сами этого не понимаете». Подобно тому, как алгоритмы стремятся выделить сигнал из шума, так и научное понимание требует ясности и простоты. Успешная реализация этих алгоритмов подтверждает, что даже в сложных экспериментах, вроде CMS, можно добиться повышения точности и эффективности, опираясь на глубокое понимание принципов работы системы и тщательный анализ данных.

Что дальше?

В этой работе, как и во многих других, предпринята попытка заставить алгоритмы видеть то, что человеческий глаз упустил бы в хаосе столкновений протонов. Улучшение идентификации адронно распадающихся тау-лептонов — задача, безусловно, важная для тех, кто ищет новые физические явления. Однако, за всеми этими оптимизациями, градиентными спусками и матрицами смежности скрывается неизбежная истина: любое “поведение инвестора”, в данном случае — алгоритма, — это просто эмоциональная реакция с хорошим обоснованием. Мы уверены, что найдём новые параметры, которые ещё больше повысят эффективность триггера, но стоит помнить, что за любым улучшением кроется новая область систематической ошибки, которую предстоит обнаружить.

Следующим шагом, вероятно, станет усложнение моделей, добавление ещё большего количества признаков и, возможно, применение тех самых трансформеров, которые уже захватили мир обработки естественного языка. Но стоит задаться вопросом: действительно ли нам нужна ещё большая чёрная коробка, или лучше потратить усилия на более глубокое понимание физики процессов, происходящих в детекторе? Все говорят, что рынки рациональны, пока не теряют свои деньги — и в данном случае “деньги” — это время и ресурсы, потраченные на погоню за иллюзорной точностью.

В конечном итоге, задача состоит не в том, чтобы создать идеальный алгоритм, а в том, чтобы понять его ограничения и научиться жить с ними. Ведь, как известно, идеальных решений не существует — только компромиссы, которые позволяют нам хоть как-то ориентироваться в этом сложном и непредсказуемом мире элементарных частиц.

Оригинал статьи: https://arxiv.org/pdf/2602.11359.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Временная запутанность: от хаоса к порядку

- Улучшение точности квантовых сенсоров: новый подход к подавлению шумов

- Квантовое программирование: Карта развивающегося мира

- Предел возможностей: где большие языковые модели теряют разум?

- ЭКГ-анализ будущего: От данных к цифровым биомаркерам

- Квантовый скачок: от лаборатории к рынку

- Резонансы в тандеме: Управление светом в микрорезонаторах

- Квантовая геометрия управления: плавные траектории в пространстве состояний

- Квантовые кольца: новые горизонты спиновых токов

- Сердце музыки: открытые модели для создания композиций

2026-02-15 20:49