Автор: Денис Аветисян

Новое исследование предлагает систематизированный подход к оценке того, насколько объяснения в системах искусственного интеллекта позволяют пользователям эффективно принимать решения и действовать.

В статье представлен каталог действий и информационных категорий для оценки и улучшения применимости объяснений в системах искусственного интеллекта, ориентированный на потребности пользователей.

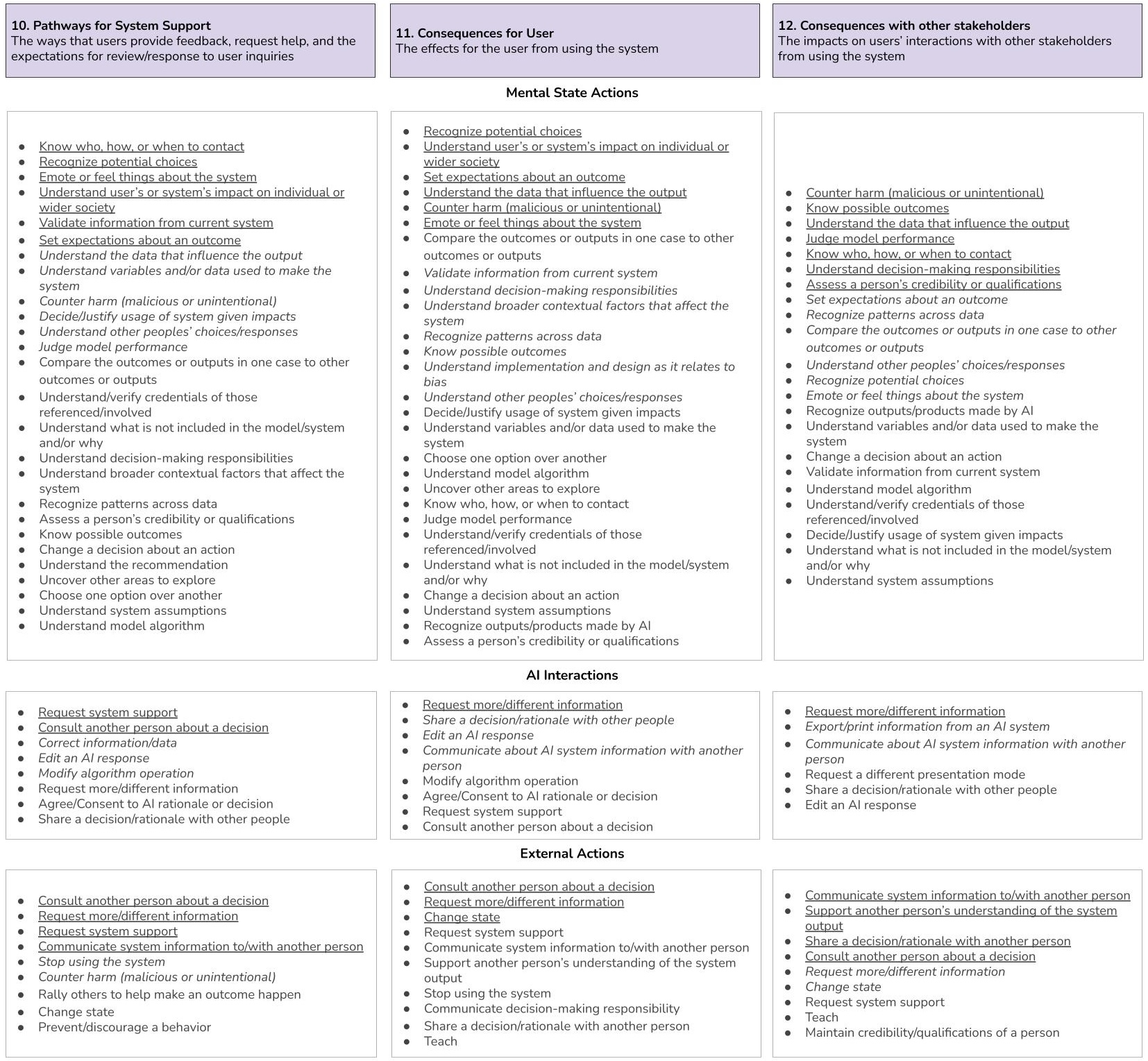

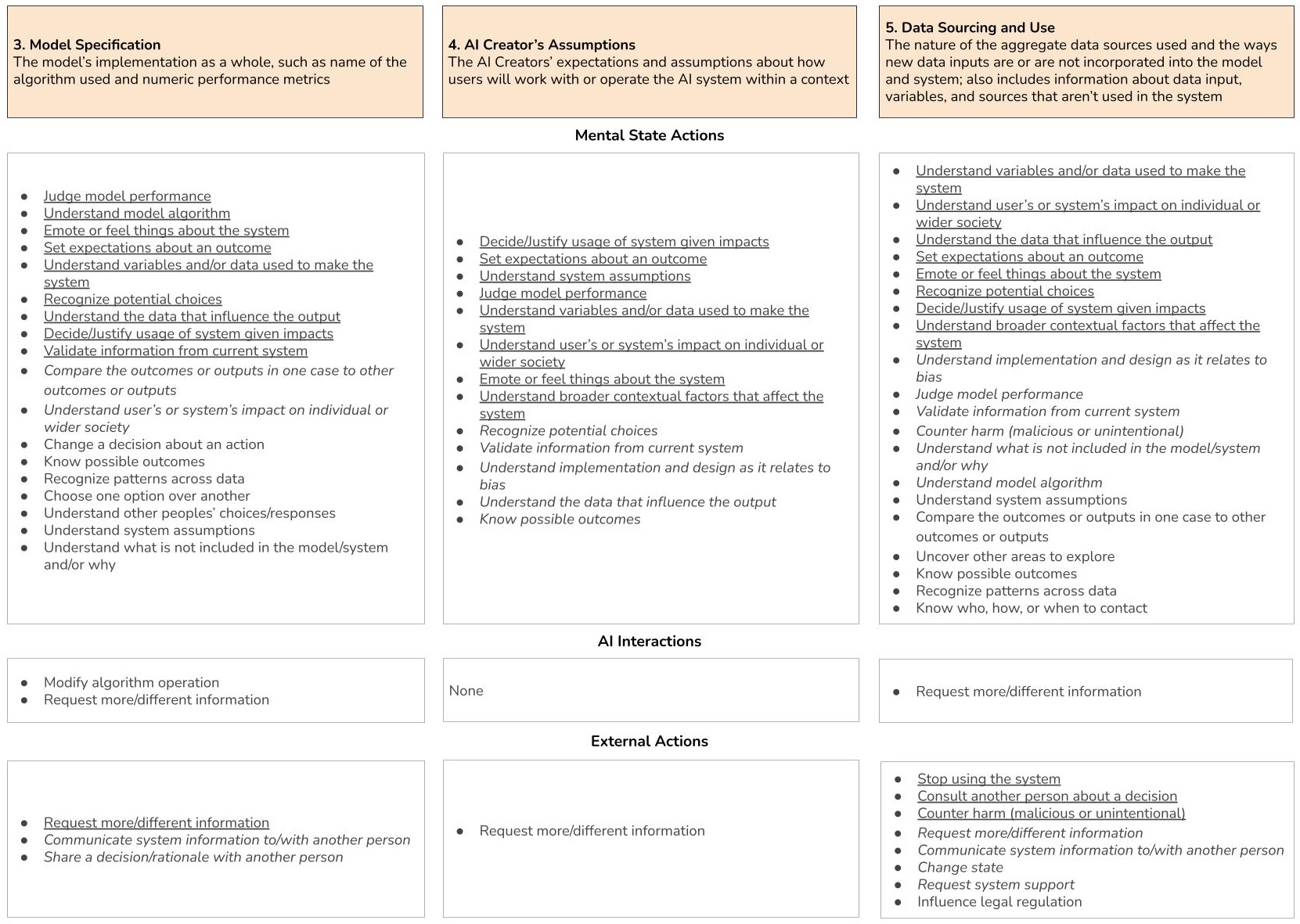

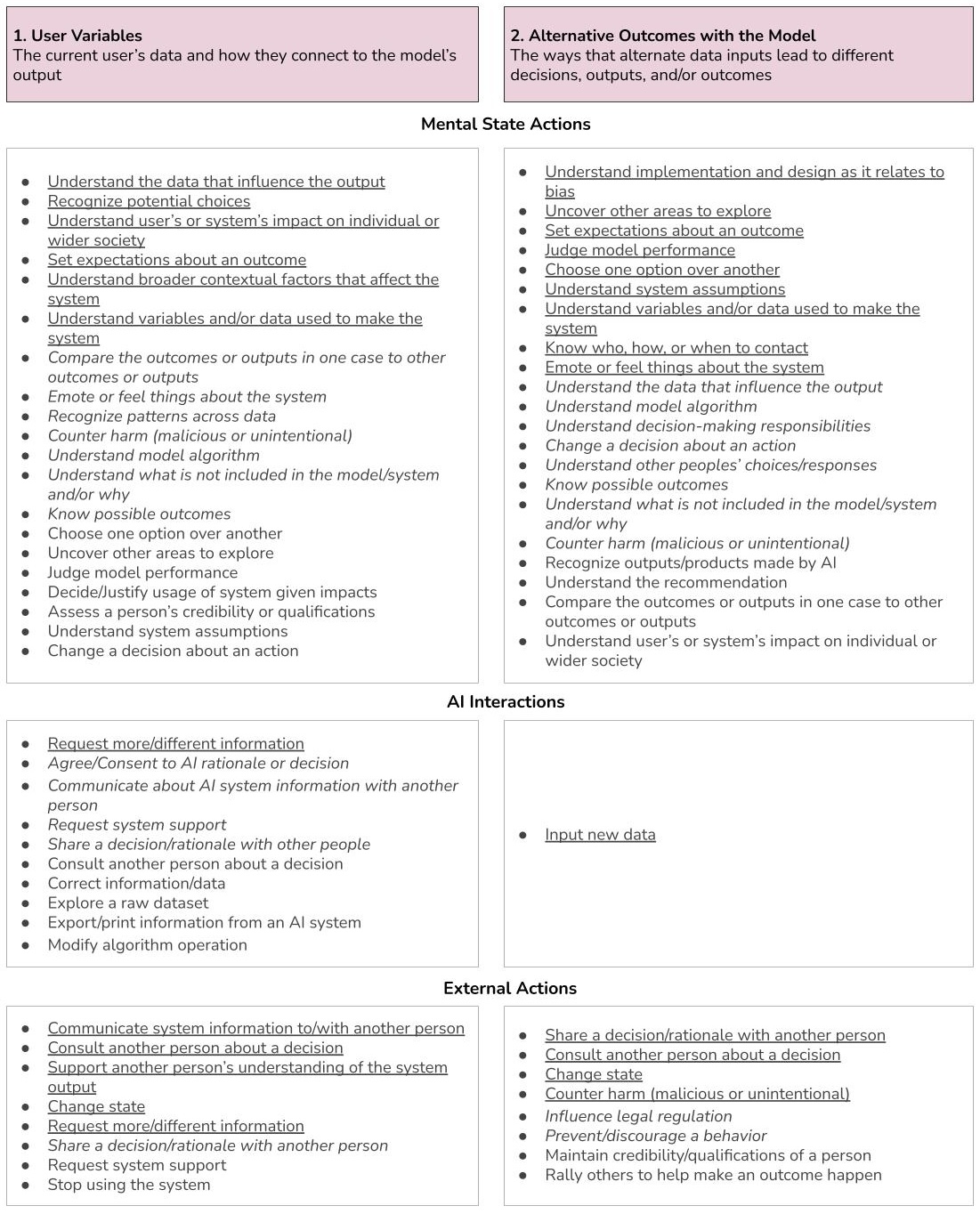

Несмотря на растущий интерес к объяснимому искусственному интеллекту (XAI), связь между предоставляемыми объяснениями и конкретными действиями пользователей часто остается неопределенной. В работе ‘Evaluating Actionability in Explainable AI‘ представлен каталог информации и связанных с ней действий, полученный в результате изучения потребностей пользователей в сфере образования и медицины. Этот каталог отображает 12 категорий информации, которые участники исследования использовали для совершения 60 различных действий, позволяя разработчикам XAI систем более осознанно проектировать объяснения, ориентированные на практическое применение. Как можно использовать этот каталог для создания XAI систем, которые не только объясняют решения, но и эффективно поддерживают пользователей в принятии обоснованных действий?

Временные Издержки: Вызовы Систем Поддержки Принятия Решений

Традиционные системы поддержки принятия решений зачастую сталкиваются с трудностями при анализе сложных, реальных сценариев, поскольку они полагаются на статические данные и упрощенные модели. Это означает, что системы не всегда способны учитывать динамично меняющиеся обстоятельства и множество взаимосвязанных факторов, влияющих на результат. Вместо того чтобы адаптироваться к контексту, они предлагают решения, основанные на устаревшей или неполной информации, что снижает их эффективность и ограничивает возможности для оптимального выбора. Такой подход особенно проблематичен в ситуациях, требующих учета субъективных оценок, нечетких данных или непредсказуемых событий, где статичные модели оказываются неадекватными для адекватного анализа и формирования обоснованных рекомендаций.

Неадекватные или неоптимальные решения, предлагаемые системами поддержки принятия решений, часто являются следствием упрощенных моделей реальности и недостаточного учета контекста. Это, в свою очередь, приводит к снижению доверия со стороны пользователя к рекомендациям системы. Если предложенные варианты не соответствуют ожиданиям или кажутся нелогичными, пользователь склонен игнорировать советы системы и полагаться на собственный опыт, что нивелирует ценность инструмента. Потеря доверия особенно критична в областях, где решения имеют серьезные последствия, и может привести к отказу от использования системы поддержки принятия решений в целом, несмотря на потенциальные выгоды.

Эффективная поддержка принятия решений требует от системы понимания глубинных факторов, определяющих выбор, а не простого представления данных. Современные системы часто фокусируются на обработке информации и выдаче статистических сводок, упуская из виду контекст, мотивации и скрытые взаимосвязи, влияющие на процесс принятия решений. Истинная поддержка заключается в способности системы моделировать причинно-следственные связи, учитывать неявные знания и прогнозировать последствия различных вариантов, позволяя пользователю оценивать риски и возможности с учетом всей сложности ситуации. Такой подход позволяет перейти от простого предоставления информации к активному участию системы в процессе анализа и формировании обоснованных решений, что существенно повышает их качество и надежность.

Интеллектуальная Система: Прозрачность и Объяснимость Искусственного Интеллекта

Наша интеллектуальная система объединяет модель искусственного интеллекта (ИИ) с продвинутой системой объяснимого ИИ (XAI) для обеспечения прозрачности и предоставления действенных выводов. Интеграция позволяет не просто получать результаты работы ИИ, но и понимать логику, лежащую в основе этих результатов, что достигается за счет использования специализированных алгоритмов XAI, анализирующих и визуализирующих факторы, влияющие на принятие решений моделью. Это обеспечивает возможность проверки корректности работы ИИ, выявления потенциальных ошибок и, как следствие, повышения доверия к системе и качества принимаемых на ее основе решений.

Система не ограничивается простой выдачей прогнозов, а предоставляет объяснения к результатам своей работы (AI Output). Это достигается за счет встроенных механизмов интерпретации, позволяющих пользователю понять логику, лежащую в основе каждого предсказания. Предоставление объяснений способствует повышению доверия к системе и позволяет пользователю принимать обоснованные решения (User Decision) на основе не только предсказаний, но и понимания факторов, которые на них повлияли. Повышенная прозрачность обеспечивает возможность проверки корректности работы системы и выявления потенциальных ошибок или предвзятостей.

Достижение баланса между интерпретируемостью и предсказательной силой в данной системе обеспечивается за счет применения специализированных архитектурных решений и алгоритмов. В частности, используются методы, позволяющие выявлять наиболее значимые признаки, влияющие на результаты работы модели, и представлять их в понятной форме. Это достигается без применения «черных ящиков» и сложных, неинтерпретируемых преобразований данных, что позволяет сохранять высокую точность прогнозов при одновременном обеспечении возможности анализа логики принятия решений искусственным интеллектом. Приоритет отдавался выбору моделей, допускающих анализ весов и структур, а также техникам постобработки результатов, направленным на повышение прозрачности и объяснимости.

Проверка Действенности: От Объяснений к Конкретным Действиям

Система объяснимого ИИ (XAI) не ограничивается генерацией объяснений, но и оказывает поддержку в изменении ментальных действий пользователя (Mental State Action), а также позволяет выполнять внешние действия (External Action). Это означает, что система предназначена для того, чтобы не просто предоставить информацию, но и инициировать или изменить поведение пользователя в реальном мире на основе полученных объяснений. Данный подход предполагает, что объяснения являются инструментом, стимулирующим конкретные действия, а не только повышающим уровень понимания.

Оценка действенности (Actionability Evaluation) является ключевым компонентом валидации систем объяснимого искусственного интеллекта (XAI). Она направлена на подтверждение того, что предоставляемые объяснения не просто понятны пользователю, но и позволяют ему совершать осмысленные действия или вносить коррективы в свою деятельность. В отличие от оценки только понятности, оценка действенности фокусируется на практической ценности объяснений и их способности стимулировать конкретные вмешательства или изменения в поведении пользователя. Это подразумевает анализ того, насколько объяснения позволяют пользователю предпринять шаги для решения проблемы, улучшения процесса принятия решений или достижения желаемого результата.

В ходе исследования была систематизирована оценка применимости объяснений, генерируемых системами XAI, посредством каталогизации 60 типов действий, определяемых пользователями, и 12 категорий информации. Данные были получены в результате интервью с 14 участниками, что позволило создать структурированную основу для оценки того, насколько эффективно объяснения способствуют конкретным действиям и изменениям в поведении пользователя. Полученный каталог предназначен для последовательной оценки и улучшения систем XAI, направленных на поддержку принятия решений и взаимодействия с пользователем.

Фундамент: Целостность Данных и Модели

Основой функционирования любой модели искусственного интеллекта является всеобъемлющий ввод данных, состоящий из множества переменных компонентов. Эти переменные, охватывающие широкий спектр параметров и характеристик, формируют информационную базу, на которой строится процесс обучения и принятия решений. Качество и полнота этих данных напрямую влияют на способность модели к точной обработке информации и генерации релевантных результатов. Более того, разнообразие переменных позволяет модели учитывать сложные взаимосвязи и нюансы, что критически важно для решения задач в различных областях — от прогнозирования тенденций до автоматизации сложных процессов. Таким образом, тщательный отбор, обработка и анализ входящих данных представляют собой фундаментальный этап в создании эффективной и надежной системы искусственного интеллекта.

Процесс создания модели искусственного интеллекта требует пристального внимания, поскольку любые предположения и предвзятости, заложенные в ее структуру, оказывают непосредственное влияние на качество получаемых результатов. Неявные предубеждения в алгоритмах, обусловленные, например, особенностями выборки данных или выбранными параметрами, могут приводить к систематическим ошибкам и искажениям в прогнозах и решениях, генерируемых моделью. Тщательный анализ и проверка модели на предмет предвзятости, а также использование разнообразных и репрезентативных данных для обучения, являются ключевыми факторами для обеспечения надежности и объективности ее работы. Игнорирование этих аспектов может привести к формированию необъективных или даже дискриминационных результатов, что снижает доверие к системе и ограничивает возможности ее применения.

Эффективность любой системы искусственного интеллекта напрямую зависит от качества и репрезентативности исходных данных, формирующих её основу. Неполные, искаженные или необъективные данные неизбежно приводят к ошибочным выводам и предсказаниям, оказывая влияние на все заинтересованные стороны — от разработчиков и исследователей до конечных пользователей и лиц, принимающих решения на основе результатов работы модели. Обеспечение целостности данных, их соответствия реальному положению дел и достаточной представленности различных групп и сценариев является критически важным фактором для создания надежных и справедливых систем, способных приносить пользу обществу и избегать непреднамеренных негативных последствий.

Перспективы: Расширение Области Интеллектуальной Поддержки

Разработанный подход открывает возможности для создания систем искусственного интеллекта, способных адаптироваться к индивидуальным потребностям пользователя. Вместо универсальных ответов, такие системы смогут предоставлять персонализированные объяснения, учитывающие уровень знаний и предпочтения конкретного человека. Более того, алгоритмы смогут формировать индивидуальные рекомендации, основанные на истории взаимодействия и текущем контексте, что значительно повышает эффективность и удобство использования. Эта адаптивность не только улучшает понимание и доверие к системе, но и позволяет ей стать действительно полезным инструментом для решения сложных задач в различных областях, от образования до здравоохранения.

Дальнейшие исследования направлены на совершенствование системы ‘XAI’ с целью проактивного выявления потенциальных предвзятостей и смягчения их влияния на процесс принятия решений. Разработчики планируют внедрить алгоритмы, способные анализировать данные и логику работы системы, обнаруживая скрытые предубеждения, которые могут привести к несправедливым или неточным результатам. Особое внимание будет уделено созданию механизмов самокоррекции, позволяющих системе автоматически адаптироваться и устранять обнаруженные искажения. Такой подход позволит значительно повысить надежность и справедливость интеллектуальных систем поддержки, обеспечивая более объективные и обоснованные решения в различных областях применения.

Предвидится будущее, в котором искусственный интеллект станет надежным помощником, расширяющим возможности человека в принятии обоснованных решений. Системы искусственного интеллекта будут не просто инструментами для обработки данных, но и партнерами, способными предоставить пользователю необходимую поддержку и уверенность в правильности выбора. Это предполагает развитие ИИ, способного не только анализировать информацию, но и учитывать индивидуальные потребности и предпочтения, предоставляя персонализированные рекомендации и объяснения. В конечном итоге, подобный подход позволит человеку использовать потенциал искусственного интеллекта для решения сложных задач и достижения лучших результатов, сохраняя при этом полный контроль над процессом принятия решений и уверенность в их обоснованности.

Исследование, представленное в статье, акцентирует внимание на необходимости оценивать объяснимый искусственный интеллект (XAI) не только с точки зрения понятности, но и с точки зрения способности пользователя предпринимать конкретные действия на основе этих объяснений. Этот подход созвучен идеям Дональда Кнута: «Прежде чем оптимизировать, убедитесь, что вы оптимизируете правильную вещь». В контексте XAI, успешность системы определяется не просто объемом предоставленной информации, а тем, насколько эффективно она помогает пользователю в принятии решений и реализации поставленных задач. Каталог действий и информационных категорий, предложенный авторами, является попыткой структурировать этот процесс, обеспечивая основу для оценки и улучшения практической ценности объяснений, что согласуется с принципом долговечности и устойчивости систем, которые не устаревают, если постоянно адаптируются к меняющимся потребностям.

Что дальше?

Представленная работа, подобно любому инструменту, лишь обозначает границы текущего понимания. Каталогизация действий и информационных категорий — это не конечная цель, а скорее, диагностика. Диагностика того, насколько системы объяснимого ИИ (XAI) действительно позволяют пользователям не просто понимать, но и действовать. Время покажет, насколько эти каталоги окажутся устойчивыми к изменениям в задачах и контекстах, ведь любая система, даже самая тщательно спроектированная, неизбежно стареет.

Очевидным направлением дальнейших исследований представляется изучение динамики этих каталогов. Как меняются необходимые действия и типы информации по мере развития системы и накопления опыта её использования? Какова роль ошибок и неверных действий в формировании более эффективных стратегий объяснения? Ведь инциденты — это не отклонения от нормы, а шаги системы на пути к зрелости.

В конечном счете, вопрос не в том, чтобы создать «идеальное» объяснение, а в том, чтобы построить систему, способную адаптироваться к неизбежной неопределенности. Время — не метрика, а среда, в которой системы XAI должны учиться и эволюционировать, и признание этого — первый шаг к созданию действительно полезных и устойчивых решений.

Оригинал статьи: https://arxiv.org/pdf/2601.20086.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Квантовый прорыв в планировании ресурсов 5G

- Квантовая статистика без границ: новый подход к моделированию

- Проверка научных статей: новый эталон для автоматического рецензирования

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Хаос и порядок в квантовых флуктуациях: неожиданная классическая типичность

- Динамическая теория поля в реальном времени: путь к квантовым вычислениям

- Разгадывая тайны рождения джетов: машинное обучение на службе физики высоких энергий

2026-01-29 16:20